人工智能基础_机器学习014_BGD批量梯度下降公式更新_进一步推导_SGD随机梯度下降和MBGD小批量梯度下降公式进一步推导---人工智能工作笔记0054

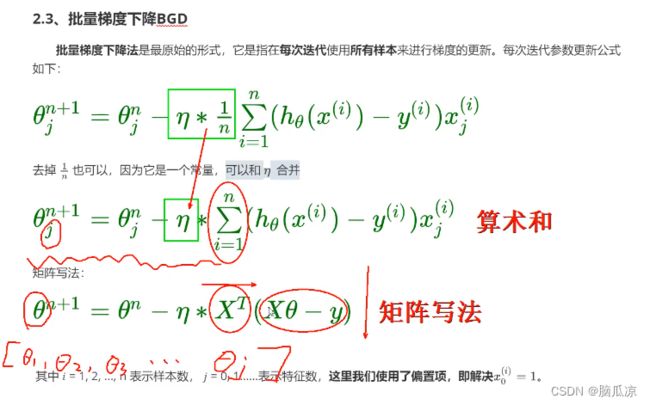

然后我们先来看BGD批量梯度下降,可以看到这里,其实这个公式来源于

梯度下降的公式对吧,其实就是对原始梯度下降公式求偏导以后的梯度下降公式,然后

使用所有样本进行梯度下降得来的,可以看到* 1/n 其实就是求了一个平均数对吧.所有样本的平均数.

然后我们看,我们这里* 1/n那么前面还有一个eta ,对吧,那么这个1/n是个常量对吧,我们下面

就和eta进行了合并,可以看到,这里的eta * 1/n进行合并以后,就只剩一个eta了,然后

我们再去看,因为是连加的,可以看到有个算术和Ei =1 到n对吧,然后

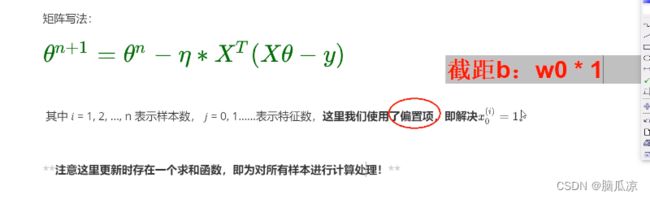

换成矩阵的写法就简洁多了,可以看到是seta n+1 = seta n - ..

然后这里的seta要注意值得是seta1,seta2...setaj对吧,然后

后面的XT转置,其实就是上面xi -yi 和xi的相乘的,矩阵写法,具体这块,要想详细了解,必须要去

学习矩阵了 那块的数学知识了,我们先知道公式,知道结果就可以了,后面有时间再去学吧,要学的东西太多了.

可以看到这里的使用了一个偏置项,那么这个偏置项其实就是截距,b 对吧 b=w0*1

其实就是让x0 =1了对吧,跟之前我们给所有的数据,后面添加了一列1一样

然后,