性能卓越 全栈自主 HashData与华为金融数仓一体机联合方案全面解读

金融业作为数据覆盖广泛、服务社会主体众多、应用场景丰富的关键行业,一直以对数据基础设施的高要求而著称,也是检验产品与方案成熟度的试金石。经过长期的服务与实践,HashData已形成面向金融核心业务的成熟数仓产品。

凭借对金融场景的深度洞悉和丰富实践经验,HashData联合华为存储共同推出了金融数仓一体机联合解决方案(以下简称“联合解决方案”),为金融机构提供安全稳定、⾼效灵活、软硬结合的全栈国产化的云数仓服务,助⼒金融企业构建⼀体化、全视角数据分析平台,降低⼤数据分析⻔槛。

在先前的直播中,HashData技术专家从金融行业数字化发展趋势和数据仓库技术变革的角度对联合解决方案进行了详细解读。以下内容根据直播文字实录整理而成。

变革:大数据时代,金融行业加速云原生化改造

一直以来,金融行业都是数字化转型的“先锋军”。据统计,金融行业营收每增长100万,数据就增长150GB。随着信息技术的快速发展,以银行为代表的金融业务呈现数字化、智能化、敏捷化的趋势。以某大型银行为例,在线征信由过去3天缩短至≤1秒;反欺诈响应要求由过去的T+1提升至≤50毫秒。

随之而来的是,金融机构对底层数据平台数据分析的实时性要求越来越高,从而能够更及时、更全面、立体地服务于业务营销。同时,面对不断增长的数据规模,金融机构亟需构建更高效、更灵活、更智能的数据分析平台,支撑业务的可持续发展。

云计算凭借灵活性、低成本、高弹性的优势,成为众多金融机构IT设施升级的“必选项”。与此同时,随着金融行业IT架构加速云转型,数仓建设也同步走向云原生,可以面向多样化负载提供高性能、稳定可靠的数据访问服务。

相关统计数据显示,金融行业对数据基础设施的投入呈持续增长之势,预计2024年我国大数据分析市场规模将达到273.3亿美元,金融行业市场占比13.4%。

在旺盛的市场需求和政策推动下,业界预测,金融行业IT系统有望率先实现全面国产化。为满足金融行业客户数据基础设施升级的需求,HashData联合华为存储共同推出了金融数仓一体机联合解决方案,采用计算、存储分离的设计,充分发挥云计算的弹性优势,秒级扩缩容,支持万级计算机节点,并发访问任意扩展;统一存储资源池,实现PB级数据随心共享。

创新:开箱即用,国芯国魂

当前,金融行业数仓普遍使用传统MPP架构数据库,由于存算紧耦合,存在建设成本高,扩缩容不灵活、故障恢复时间长、运维复杂等诸多不足,无法适应快速响应业务的需求。

针对这一现状,联合解决方案采用领先的架构设计,大幅降低系统建设成本,提升业务时效性,实现运维自动化。

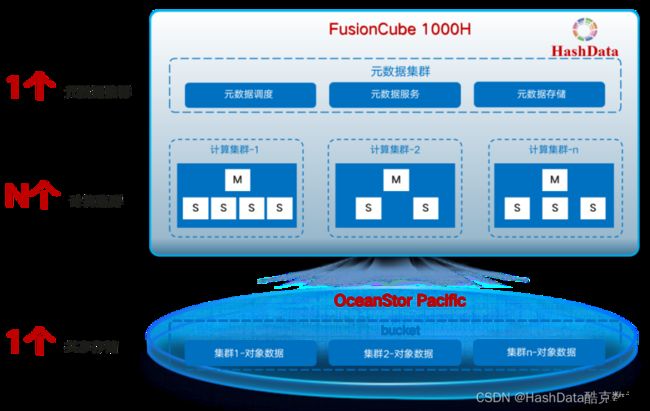

图1:HashData 与华为存储联合解决⽅案架构图

联合解决方案底层依托 OceanStor Pacific 分布式存储,上层的HashData云数仓运行在FusionCube虚拟化平台上,整体系统实现了软硬全栈国产化,帮助金融客户一站式实现国产化目标,大幅降低各个模块选型、对比、适配的工作量。同时,联合解决方案采用一站式、交钥匙模式,降低了系统建设难度。

图2:HashData 与华为存储联合解决⽅案全栈国产化配置示意图

特性:完美适配云生态,高性能低成本

与传统MPP架构数据库相比,联合解决方案具有以下特性优势:

- 存算分离,有效降低成本,TCO节省达到25%

HashData云数仓采用存储、计算、元数据三层分离架构,针对金融行业不同业务场景,存储和计算资源可独立扩缩容。例如历史数据查询,需要占用大量存储,可单独扩大存储资源;而针对反洗钱、非现场审计等业务,可单独增加CPU、内存等计算资源。经过实际测试,在可靠性不降低的情况下,联合解决方案可以帮助金融企业减少50%数据冗余,TCO节省达到 25%,有效降低系统建设和维护成本。

- 灵活调配云资源,分钟级增加计算集群,并发能力无上限

传统MPP架构数据库,对于并发需求和响应能力是有限制的(一般单集群规模<200节点),对于复杂SQL高并发的需求,往往只能采用建设多个重复相同集群的模式,导致数据冗余和加工链路变长。HashData云数仓基于存算分离的架构设计,元数据集群为多个计算集群提供元数据管理服务,多个计算集群间共享同一份元数据信息,支持数据互通访问,同时用户可以通过云管平台快速增加计算集群,有效提高集群并发能力。数据库集群共享一份元数据、一份业务数据,减少了数据冗余,进一步降低后期数据库运维成本。

- 存算集群Scale-out架构,支撑业务按需扩容,性能线性增长

HashData利用云存储作为数据持久存储层,并与计算资源物理上分离、逻辑上集成。由于自身的高可用性和近乎无限的可扩展性,大大简化了数据仓库系统错误恢复、多维度扩缩容、备份恢复等流程。根据实际测试,随着计算和存储资源的增加,系统性能可以实现线性增长。

- 单桶1000亿对象存储,满足海量数仓分片高效存取需求

传统的数仓产品,在单桶数据量超过百万个小文件时,会出现系统性能下降的情况。在联合解决方案中,依托华为OceanStor Pacific分布式存储,单桶小文件可以达到千亿级别,支持业务无限扩展,满足多计算集群单桶读写诉求,解决分桶导致数据分散管理的问题。

- 计算节点故障快速倒换,性能爬坡时间从3小时降至10分钟

随着业务量增大,计算集群节点数量越来越多,单位时间内虚拟机故障概率也随之增大。传统MPP数据库存算分离架构中,数据缓存和元数据都存在计算节点本地,当计算节点故障后,业务转移到新节点,新节点需要重建缓存,因此自愈后的节点有性能爬坡的过程,可能会耗时达3小时之久。联合解决方案中,增加了分布式块存储来作为数据缓存,当故障发生,业务转移到新节点后,计算节点不需要重建缓存,性能爬坡时长显著降低,10分钟内即可恢复。

- 自动故障检测和恢复,业务接管无需同步数据,分钟级完成故障自愈

传统MPP架构数据库当发生节点故障时,任务会临时调度到Mirror节点,导致集群性能大幅度下降;故障解决后,需要从Mirror节点复制大量数据,业务恢复窗口期长。在联合解决方案中,能够自动监控故障节点,并申请资源替换故障节点;集群节点负载均衡,性能近乎无影响;由于统一元数据管理的优势,业务无需数据复制,分钟级完成故障自愈。

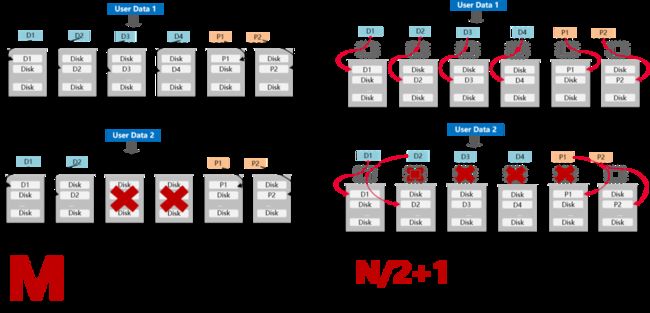

图3:联合解决方案EC算法优化示意图

同时,联合解决方案采用EC算法优化+硬件背板互联架构,带来集群数据极高的可靠性。如图4所示,当节点故障时能自动缩列,新写的数据会将N缩列,M不变;图上4+2的EC,在故障两节点后写数据会变成2+2,以此保证IO不中断同时可靠性级别不变;控制器故障时,同框控制器背板全互联,硬盘由正常控制器接管,支持超过半数控制器故障,保障业务不中断。

- 多集群共享数据,避免无效数据复制,提升业务时效性

传统数仓采用多集群数据拷贝以满足高并发需求,跨集群之间存在大量数据复制,增加了数据处理时间。联合解决方案建立在华为Pacific对象存储的能力与HashData云原生架构的优势上,实现了多集群数据全共享,统一了全局的数据视图,数据无需跨集群多次拷贝,ELT全过程都在数仓中完成,作业完成时间显著提前,提升业务的时效性。

HashData和华为存储作为各自领域的领军企业,在产品及技术上均有着深厚积累。双方产品在金融行业服务了众多客户,并且稳定运行多年。目前,HashData与华为金融数仓一体机联合解决方案已上线华为存储蓝鲸应用商城,用户可以在线轻松实现开箱即⽤、⼀键部署和⽇常运维,欢迎大家应用体验!