02 Apache Airflow 2.0+官方文档导读 Quick Start (快速上手)

Quick Start

快速开始指南,这里分为两个小的部分,分别是本地运行及以Docker方式运行Airflow。

值得注意的是,这两种方式都只是快速体验airflow的方式,不能够用于生产部署。

A.本地运行指南 (单机版)

主要内容包括

a.Airflow的安装方式(使用pip 执行命令)

b.Airflow 启动环境配置(AIRFLOW_HOME, PYTHON_VERSION,CONSTRAINT_URL)

c.Airflow 启动命令(airflow db init / airflow users create / airflow webserver/ airflow scheduler)

d.Airflow 任务运行命令 (airflow tasks run / airflow dags backfill)。

按照单机版指南执行相关命令即可体验Airflow的基本操作,且通过WebUI(默认 localhost:8080)可以直观的感受Airflow运行dag的过程。

B.Docker方式运行指南 (分布式多节点)

主要内容包括:

a.前提

在实验环境安装好DockerCE及Docker-Compose

b.下载 docker-compose.yaml 文件

curl -LfO 'https://airflow.apache.org/docs/apache-airflow/2.0.1/docker-compose.yaml'docker-compose.yaml中包含了如下角色的定义:

-

airflow-scheduler - The scheduler monitors all tasks and DAGs, then triggers the task instances once their dependencies are complete.

-

airflow-webserver - The webserver available at http://localhost:8080.

-

airflow-worker - The worker that executes the tasks given by the scheduler.

-

airflow-init - The initialization service.

-

flower - The flower app for monitoring the environment. It is available at http://localhost:8080.

-

postgres - The database.

-

redis - The redis - broker that forwards messages from scheduler to worker.

这个文件中airflow的整体架构与下图类似,只不过Executors使用了CeleryExecutor(使用redis作为broker)。

docker-compose.yaml中所定义的挂载目录的作用:

-

./dags - you can put your DAG files here.

-

./logs - contains logs from task execution and scheduler.

-

./plugins - you can put your custom plugins here.

c. 初始化

(运行docker命令时不能使用root用户,否则会出现权限的问题。)

创建docker-compose的挂载目录,添加运行docker的当前用户的 uid/gid 到.env文件

mkdir ./dags ./logs ./plugins echo -e "AIRFLOW_UID=$(id -u)\nAIRFLOW_GID=0" > .envairflow初始化命令,下面命令的任务是下载 相关组件的镜像,并初始化airflow的元数据库

docker-compose up airflow-init运行完命令后,可以看到以下的信息

airflow-init_1 | Upgrades done airflow-init_1 | Admin user airflow created airflow-init_1 | 2.0.1 start_airflow-init_1 exited with code 0

从日志中可以看到, docker-compose.yaml 中所定义的服务都已经拉取到了本地,postgres/redis服务已经启动, airflow的元数据已经初始化完成。

创建好了Airflow 的用户 airflow,其密码为airflow。

d. 运行airflow服务

下面,我们再启动airflow相关的服务:

docker-compose up -d ## 加入-d参数,让程序后台运行启动OK的话,我们可以使用docker的命令查看各个服务的状态

docker pse. 访问airflow服务

当airflow成功启动后,我们可以通过以下3种方式进行访问

-

by running CLI commands.

-

via a browser using the web interface.

-

using the REST API.

通过CLI Commands访问

通过docker-compose使用airflow命令时,需要指定特定的服务,如 airflow-worker

docker-compose run airflow-worker airflow info可以下载如下的包装脚本来简化操作

curl -LfO 'https://airflow.apache.org/docs/apache-airflow/2.0.1/airflow.sh' chmod +x airflow.sh这样,上面的查看airflow信息的命令可以简化为:

./airflow.sh info我们也可以使用 bash 或者 python的方式进入到airflow容器中

./airflow.sh bash ./airflow.sh python通过Web UI 访问

使用localhost:8080即可访问airflow web ui, 其默认用户名密码为 airflow/airflow

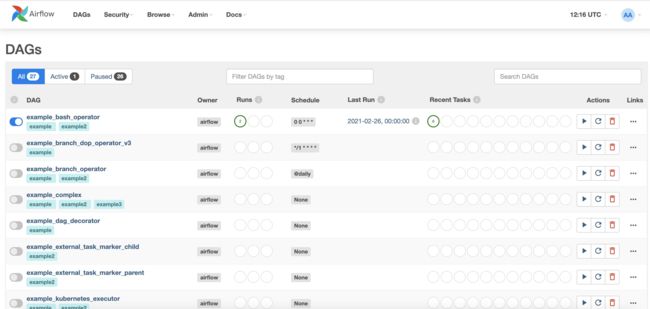

登录后即可看到如下页面:

通过REST API 访问

airflow rest api已经支持基本的用户名及密码的权限校验, 故可以使用常用的工具去发送api请求,示例如下:

ENDPOINT_URL="http://localhost:8080/"

curl -X GET \ --user "airflow:airflow" \ "${ENDPOINT_URL}/api/v1/pools"f. Cleaning up

在做完试验后,我们若不在使用Airflow相关的镜像的话,则可以通过如下的命令进行清理:

docker-compose down --volumes --rmi all总结

本文基于Docker快速的搭建了Apache Airflow的Demo环境,使得用户很快的得到关于Airflow的感性认知,是快速学习感受Airflow的很好的开始。

更多关于Apache Airflow的文章,请查看 Apache Airflow系列文章。

若在实践中遇到什么问题的话,欢迎大家加入Apache Airflow 技术交流群进行讨论.

或者加入QQ群 704721809。

参考资料:

[1] Apache Airflow Quick Start Page

https://airflow.apache.org/docs/apache-airflow/stable/start/index.html