深度学习-VGG19网络识别手写汉字(基于HWDB1.1trn_gnt)

摘要:今天的文章需要你有一定的卷积理论基础,这里不再重复卷积的知识点,并不理解的小伙伴可以自己去补全这块知识点。

深度神经网络有许多值得学习的网络结构,今天就给大家带来一个经典网络:VGG19。介绍VGG19之前呢,我们先来了解下什么是VGG,VGG是一个深度卷积神经网络模型,由牛津大学计算机视觉组(Visual Geometry Group)于2014年提出,同时在ImageNet的分类、检测和定位三个任务上取得了第一名的好成绩。在VGG模型中,所有卷积层都使用了3×3大小的卷积核,并且池化层也都使用了2×2大小的池化核。VGG模型架构相对简单、规整,易于实现和复现,因此被广泛应用于自然图像识别、物体检测和语义分割等领域。那么,VGG19就是包括16层卷积层和3层全连接层。VGG模型提出的深度卷积网络思想,对后续深度学习算法的发展产生了重要的影响。与此同时,VGG模型的成功也启发了研究者使用更深、更复杂的网络架构来解决计算机视觉领域的问题。

VGG19模型的总参数量为143,667,240个。这个数字是通过对每一层的参数数量进行计算,并将它们相加得到的。具体来说,VGG19模型一共由19层组成,其中包括16个卷积层、5个最大池化层和3个全连接层。每个卷积层都使用同样数量的 3×33×3 卷积核,并且每个滤波器有一个偏置项。

今天,我们来使用VGG19+(HWDB1.1trn_gnt、HWDB1.1tst_gnt),进行手写汉字的识别训练过程。

第一步:

准备样本数据

训练集地址:http://www.nlpr.ia.ac.cn/databases/download/feature_data/HWDB1.1trn_gnt.zip

测试集地址:http://www.nlpr.ia.ac.cn/databases/download/feature_data/HWDB1.1tst_gnt.zip这里的手写样本接近90万的数据量(具体的信息在这里:http://www.nlpr.ia.ac.cn/databases/handwriting/Download.html),非常地丰富。解压zip文件,我们得到了很多的gnt文件,我们的训练数据和测试数据都在里面了。【有人会有疑问,为什么解压下来不是图片,试想一下,如果都是图片你根本没法加载这些图片。】那么,我们怎么获取图片呢?那就看第二步。

第二步:

解析图片数据,直接贴一下代码,都是根据协议解析出来的。

def read_from_gnt_dir(gnt_dir):

def one_file(f):

header_size = 10

while True:

header = np.fromfile(f, dtype='uint8', count=header_size)

if not header.size: break

sample_size = header[0] + (header[1] << 8) + (header[2] << 16) + (header[3] << 24)

tagcode = header[5] + (header[4] << 8)

width = header[6] + (header[7] << 8)

height = header[8] + (header[9] << 8)

if header_size + width * height != sample_size:

break

image = np.fromfile(f, dtype='uint8', count=width * height).reshape((height, width))

yield image, tagcode

f_list=os.listdir(gnt_dir)

np.random.shuffle(f_list)

for file_name in f_list:

if file_name.endswith('.gnt'):

file_path = os.path.join(gnt_dir, file_name)

with open(file_path, 'rb') as f:

for image, tagcode in one_file(f):

skip = np.random.randint(0, 2)

if skip == 0:

continue

yield image, tagcode这段代码呢,使用了迭代器,能够减少内存的使用,不会一下次吃掉所有内存(不明白迭代器的小伙伴,自行百度学习)。这段代码主要就是返回图像和标签的元组。加载出来的图片是什么样子的呢,我们来看下。

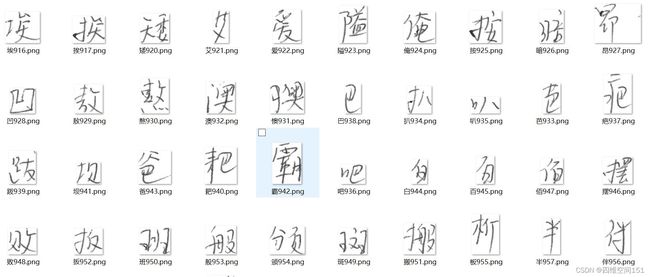

差不多就是类似这样的首页样本,看得出来还是不错的。那么,接下来我们就要处理这些图片了,我们看第三步是怎么做的。

第三步:

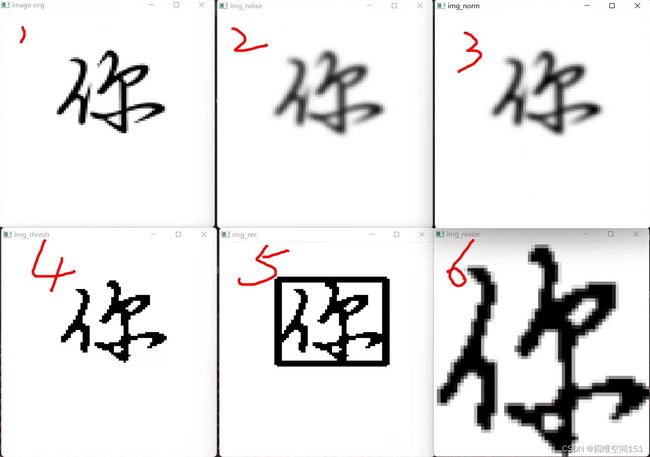

这一步很重要,图片容易受到外在因素的干扰,比如有噪点,有色彩,有缺失等等一系列的问题。这些问题如果不处理的话,会大大影响我们的训练分类结果。那要怎么处理呢?我罗列了一下我的处理过程。

灰度化==降噪==归一化==二值化==边缘检测裁剪==缩放

图片按照上面六个顺序,进行处理,当然了,我这里还不够全面,比如还可以添加,检测图片是否摆正,是否需要翻转等等。感兴趣的小伙伴可以自行补充完整。下图是以你这个图片举例,大家可以看下效果。

好的,做完这些之后,我们接下来就到正餐了,训练需要的样本都准备好了,接下来,我们要把我们的人工网络搭建起来。看下第四步吧。

第四步:

搭建VGG19神经网络,是不是很兴奋,很激动,终于要到这一步了。我这里选用了tensorflow-gpu+keras框架来搭建网络,当然,大家也可以使用tensorflow、pytorch,这些都不是什么问题,就是个实现工具而已。这里建议大家使用gpu渲染,这样速度会快很多。以下是一个VGG19的代码示例,其中具体的优化,需要大家自己去优化,下面的代码仅供参考。

from keras.models import Model

from keras.layers import Input, Conv2D, MaxPooling2D, Flatten, Dense

from keras.layers import Dropout

def VGG19(input_shape=(224, 224, 3), num_classes=1000, dropout_rate=0.5):

# 定义输入层

inputs = Input(shape=input_shape)

# 第1段卷积-池化层

x = Conv2D(filters=64, kernel_size=(3, 3), padding="same", activation="relu")(inputs)

x = Conv2D(filters=64, kernel_size=(3, 3), padding="same", activation="relu")(x)

x = MaxPooling2D(pool_size=(2, 2), strides=(2, 2))(x)

# 第2段卷积-池化层

x = Conv2D(filters=128, kernel_size=(3, 3), padding="same", activation="relu")(x)

x = Conv2D(filters=128, kernel_size=(3, 3), padding="same", activation="relu")(x)

x = MaxPooling2D(pool_size=(2, 2), strides=(2, 2))(x)

# 第3段卷积-池化层

x = Conv2D(filters=256, kernel_size=(3, 3), padding="same", activation="relu")(x)

x = Conv2D(filters=256, kernel_size=(3, 3), padding="same", activation="relu")(x)

x = Conv2D(filters=256, kernel_size=(3, 3), padding="same", activation="relu")(x)

x = Conv2D(filters=256, kernel_size=(3, 3), padding="same", activation="relu")(x)

x = MaxPooling2D(pool_size=(2, 2), strides=(2, 2))(x)

# 第4段卷积-池化层

x = Conv2D(filters=512, kernel_size=(3, 3), padding="same", activation="relu")(x)

x = Conv2D(filters=512, kernel_size=(3, 3), padding="same", activation="relu")(x)

x = Conv2D(filters=512, kernel_size=(3, 3), padding="same", activation="relu")(x)

x = Conv2D(filters=512, kernel_size=(3, 3), padding="same", activation="relu")(x)

x = MaxPooling2D(pool_size=(2, 2), strides=(2, 2))(x)

# 第5段卷积-池化层

x = Conv2D(filters=512, kernel_size=(3, 3), padding="same", activation="relu")(x)

x = Conv2D(filters=512, kernel_size=(3, 3), padding="same", activation="relu")(x)

x = Conv2D(filters=512, kernel_size=(3, 3), padding="same", activation="relu")(x)

x = Conv2D(filters=512, kernel_size=(3, 3), padding="same", activation="relu")(x)

x = MaxPooling2D(pool_size=(2, 2), strides=(2, 2))(x)

# 全连接层

x = Flatten()(x)

x = Dense(units=4096, activation="relu")(x)

x = Dropout(rate=dropout_rate)(x)

x = Dense(units=4096, activation="relu")(x)

x = Dropout(rate=dropout_rate)(x)

outputs = Dense(units=num_classes, activation="softmax")(x)

# 定义模型

model = Model(inputs=inputs, outputs=outputs, name="VGG19")

return model常用汉字:啊阿埃挨哎唉哀皑癌蔼矮艾碍爱隘鞍氨安俺按暗岸胺案肮昂盎凹敖熬翱袄傲奥懊澳芭捌扒叭吧笆八疤巴拔跋靶把耙坝霸罢爸白柏百摆佰败拜稗斑班搬扳般颁板版扮拌伴瓣半办绊邦帮梆榜膀绑棒磅蚌镑傍谤苞胞包褒剥薄雹保堡饱宝抱报暴豹鲍爆杯碑悲卑北辈背贝钡倍狈备惫焙被奔苯本笨崩绷甭泵蹦迸逼鼻比鄙笔彼碧蓖蔽毕毙毖币庇痹闭敝弊必辟壁臂避陛鞭边编贬扁便变卞辨辩辫遍标彪膘表鳖憋别瘪彬斌濒滨宾摈兵冰柄丙秉饼炳病并玻菠播拨钵波博勃搏铂箔伯帛舶脖膊渤泊驳捕卜哺补埠不布步簿部怖擦猜裁材才财睬踩采彩菜蔡餐参蚕残惭惨灿苍舱仓沧藏操糙槽曹草厕策侧册测层蹭插叉茬茶查碴搽察岔差诧拆柴豺搀掺蝉馋谗缠铲产阐颤昌猖场尝常长偿肠厂敞畅唱倡超抄钞朝嘲潮巢吵炒车扯撤掣彻澈郴臣辰尘晨忱沉陈趁衬撑称城橙成呈乘程惩澄诚承逞骋秤吃痴持匙池迟弛驰耻齿侈尺赤翅斥炽充冲虫崇宠抽酬畴踌稠愁筹仇绸瞅丑臭初出橱厨躇锄雏滁除楚础储矗搐触处揣川穿椽传船喘串疮窗幢床闯创吹炊捶锤垂春椿醇唇淳纯蠢戳绰疵茨磁雌辞慈瓷词此刺赐次聪葱囱匆从丛凑粗醋簇促蹿篡窜摧崔催脆瘁粹淬翠村存寸磋撮搓措挫错搭达答瘩打大呆歹傣戴带殆代贷袋待逮怠耽担丹单郸掸胆旦氮但惮淡诞弹蛋当挡党荡档刀捣蹈倒岛祷导到稻悼道盗德得的蹬灯登等瞪凳邓堤低滴迪敌笛狄涤翟嫡抵底地蒂第帝弟递缔颠掂滇碘点典靛垫电佃甸店惦奠淀殿碉叼雕凋刁掉吊钓调跌爹碟蝶迭谍叠丁盯叮钉顶鼎锭定订丢东冬董懂动栋侗恫冻洞兜抖斗陡豆逗痘都督毒犊独读堵睹赌杜镀肚度渡妒端短锻段断缎堆兑队对墩吨蹲敦顿囤钝盾遁掇哆多夺垛躲朵跺舵剁惰堕蛾峨鹅俄额讹娥恶厄扼遏鄂饿恩而儿耳尔饵洱二贰发罚筏伐乏阀法珐藩帆番翻樊矾钒繁凡烦反返范贩犯饭泛坊芳方肪房防妨仿访纺放菲非啡飞肥匪诽吠肺废沸费芬酚吩氛分纷坟焚汾粉奋份忿愤粪丰封枫蜂峰锋风疯烽逢冯缝讽奉凤佛否夫敷肤孵扶拂辐幅氟符伏俘服浮涪福袱弗甫抚辅俯釜斧脯腑府腐赴副覆赋复傅付阜父腹负富讣附妇缚咐噶嘎该改概钙盖溉干甘杆柑竿肝赶感秆敢赣冈刚钢缸肛纲岗港杠篙皋高膏羔糕搞镐稿告哥歌搁戈鸽胳疙割革葛格蛤阁隔铬个各给根跟耕更庚羹埂耿梗工攻功恭龚供躬公宫弓巩汞拱贡共钩勾沟苟狗垢构购够辜菇咕箍估沽孤姑鼓古蛊骨谷股故顾固雇刮瓜剐寡挂褂乖拐怪棺关官冠观管馆罐惯灌贯光广逛瑰规圭硅归龟闺轨鬼诡癸桂柜跪贵刽辊滚棍锅郭国果裹过哈骸孩海氦亥害骇酣憨邯韩含涵寒函喊罕翰撼捍旱憾悍焊汗汉夯杭航壕嚎豪毫郝好耗号浩呵喝荷菏核禾和何合盒貉阂河涸赫褐鹤贺嘿黑痕很狠恨哼亨横衡恒轰哄烘虹鸿洪宏弘红喉侯猴吼厚候后呼乎忽瑚壶葫胡蝴狐糊湖弧虎唬护互沪户花哗华猾滑画划化话槐徊怀淮坏欢环桓还缓换患唤痪豢焕涣宦幻荒慌黄磺蝗簧皇凰惶煌晃幌恍谎灰挥辉徽恢蛔回毁悔慧卉惠晦贿秽会烩汇讳诲绘荤昏婚魂浑混豁活伙火获或惑霍货祸击圾基机畸稽积箕肌饥迹激讥鸡姬绩缉吉极棘辑籍集及急疾汲即嫉级挤几脊己蓟技冀季伎祭剂悸济寄寂计记既忌际妓继纪嘉枷夹佳家加荚颊贾甲钾假稼价架驾嫁歼监坚尖笺间煎兼肩艰奸缄茧检柬碱碱拣捡简俭剪减荐槛鉴践贱见键箭件健舰剑饯渐溅涧建僵姜将浆江疆蒋桨奖讲匠酱降蕉椒礁焦胶交郊浇骄娇嚼搅铰矫侥脚狡角饺缴绞剿教酵轿较叫窖揭接皆秸街阶截劫节桔杰捷睫竭洁结解姐戒藉芥界借介疥诫届巾筋斤金今津襟紧锦仅谨进靳晋禁近烬浸尽劲荆兢茎睛晶鲸京惊精粳经井警景颈静境敬镜径痉靖竟竞净炯窘揪究纠玖韭久灸九酒厩救旧臼舅咎就疚鞠拘狙疽居驹菊局咀矩举沮聚拒据巨具距踞锯俱句惧炬剧捐鹃娟倦眷卷绢撅攫抉掘倔爵觉决诀绝均菌钧军君峻俊竣浚郡骏喀咖卡咯开揩楷凯慨刊堪勘坎砍看康慷糠扛抗亢炕考拷烤靠坷苛柯棵磕颗科壳咳可渴克刻客课肯啃垦恳坑吭空恐孔控抠口扣寇枯哭窟苦酷库裤夸垮挎跨胯块筷侩快宽款匡筐狂框矿眶旷况亏盔岿窥葵奎魁傀馈愧溃坤昆捆困括扩廓阔垃拉喇蜡腊辣啦莱来赖蓝婪栏拦篮阑兰澜谰揽览懒缆烂滥琅榔狼廊郎朗浪捞劳牢老佬姥酪烙涝勒乐雷镭蕾磊累儡垒擂肋类泪棱楞冷厘梨犁黎篱狸离漓理李里鲤礼莉荔吏栗丽厉励砾历利僳例俐痢立粒沥隶力璃哩俩联莲连镰廉怜涟帘敛脸链恋炼练粮凉梁粱良两辆量晾亮谅撩聊僚疗燎寥辽潦了撂镣廖料列裂烈劣猎琳林磷霖临邻鳞淋凛赁吝拎玲菱零龄铃伶羚凌灵陵岭领另令溜琉榴硫馏留刘瘤流柳六龙聋咙笼窿隆垄拢陇楼娄搂篓漏陋芦卢颅庐炉掳卤虏鲁麓碌露路赂鹿潞禄录陆戮驴吕铝侣旅履屡缕虑氯律率滤绿峦挛孪滦卵乱掠略抡轮伦仑沦纶论萝螺罗逻锣箩骡裸落洛骆络妈麻玛码蚂马骂嘛吗埋买麦卖迈脉瞒馒蛮满蔓曼慢漫谩芒茫盲氓忙莽猫茅锚毛矛铆卯茂冒帽貌贸么玫枚梅酶霉煤没眉媒镁每美昧寐妹媚门闷们萌蒙檬盟锰猛梦孟眯醚靡糜迷谜弥米秘觅泌蜜密幂棉眠绵冕免勉娩缅面苗描瞄藐秒渺庙妙蔑灭民抿皿敏悯闽明螟鸣铭名命谬摸摹蘑模膜磨摩魔抹末莫墨默沫漠寞陌谋牟某拇牡亩姆母墓暮幕募慕木目睦牧穆拿哪呐钠那娜纳氖乃奶耐奈南男难囊挠脑恼闹淖呢馁内嫩能妮霓倪泥尼拟你匿腻逆溺蔫拈年碾撵捻念娘酿鸟尿捏聂孽啮镊镍涅您柠狞凝宁拧泞牛扭钮纽脓浓农弄奴努怒女暖虐疟挪懦糯诺哦欧鸥殴藕呕偶沤啪趴爬帕怕琶拍排牌徘湃派攀潘盘磐盼畔判叛乓庞旁耪胖抛咆刨炮袍跑泡呸胚培裴赔陪配佩沛喷盆砰抨烹澎彭蓬棚硼篷膨朋鹏捧碰坯砒霹批披劈琵毗啤脾疲皮匹痞僻屁譬篇偏片骗飘漂瓢票撇瞥拼频贫品聘乒坪苹萍平凭瓶评屏坡泼颇婆破魄迫粕剖扑铺仆莆葡菩蒲埔朴圃普浦谱曝瀑期欺栖戚妻七凄漆柒沏其棋奇歧畦崎脐齐旗祈祁骑起岂乞企启契砌器气迄弃汽泣讫掐洽牵扦钎铅千迁签仟谦乾黔钱钳前潜遣浅谴堑嵌欠歉枪呛腔羌墙蔷强抢橇锹敲悄桥瞧乔侨巧鞘撬翘峭俏窍切茄且怯窃钦侵亲秦琴勤芹擒禽寝沁青轻氢倾卿清擎晴氰情顷请庆琼穷秋丘邱球求囚酋泅趋区蛆曲躯屈驱渠取娶龋趣去圈颧权醛泉全痊拳犬券劝缺炔瘸却鹊榷确雀裙群然燃冉染瓤壤攘嚷让饶扰绕惹热壬仁人忍韧任认刃妊纫扔仍日戎茸蓉荣融熔溶容绒冗揉柔肉茹蠕儒孺如辱乳汝入褥软阮蕊瑞锐闰润若弱撒洒萨腮鳃塞赛三叁伞散桑嗓丧搔骚扫嫂瑟色涩森僧莎砂杀刹沙纱傻啥煞筛晒珊苫杉山删煽衫闪陕擅赡膳善汕扇缮墒伤商赏晌上尚裳梢捎稍烧芍勺韶少哨邵绍奢赊蛇舌舍赦摄射慑涉社设砷申呻伸身深娠绅神沈审婶甚肾慎渗声生甥牲升绳省盛剩胜圣师失狮施湿诗尸虱十石拾时什食蚀实识史矢使屎驶始式示士世柿事拭誓逝势是嗜噬适仕侍释饰氏市恃室视试收手首守寿授售受瘦兽蔬枢梳殊抒输叔舒淑疏书赎孰熟薯暑曙署蜀黍鼠属术述树束戍竖墅庶数漱恕刷耍摔衰甩帅栓拴霜双爽谁水睡税吮瞬顺舜说硕朔烁斯撕嘶思私司丝死肆寺嗣四伺似饲巳松耸怂颂送宋讼诵搜艘擞嗽苏酥俗素速粟僳塑溯宿诉肃酸蒜算虽隋随绥髓碎岁穗遂隧祟孙损笋蓑梭唆缩琐索锁所塌他它她塔獭挞蹋踏胎苔抬台泰酞太态汰坍摊贪瘫滩坛檀痰潭谭谈坦毯袒碳探叹炭汤塘搪堂棠膛唐糖倘躺淌趟烫掏涛滔绦萄桃逃淘陶讨套特藤腾疼誊梯剔踢锑提题蹄啼体替嚏惕涕剃屉天添填田甜恬舔腆挑条迢眺跳贴铁帖厅听烃汀廷停亭庭艇通桐酮瞳同铜彤童桶捅筒统痛偷投头透凸秃突图徒途涂屠土吐兔湍团推颓腿蜕褪退吞屯臀拖托脱鸵陀驮驼椭妥拓唾挖哇蛙洼娃瓦袜歪外豌弯湾玩顽丸烷完碗挽晚皖惋宛婉万腕汪王亡枉网往旺望忘妄威巍微危韦违桅围唯惟为潍维苇萎委伟伪尾纬未蔚味畏胃喂魏位渭谓尉慰卫瘟温蚊文闻纹吻稳紊问嗡翁瓮挝蜗涡窝我斡卧握沃巫呜钨乌污诬屋无芜梧吾吴毋武五捂午舞伍侮坞戊雾晤物勿务悟误昔熙析西硒矽晰嘻吸锡牺稀息希悉膝夕惜熄烯溪汐犀檄袭席习媳喜铣洗系隙戏细瞎虾匣霞辖暇峡侠狭下厦夏吓掀锨先仙鲜纤咸贤衔舷闲涎弦嫌显险现献县腺馅羡宪陷限线相厢镶香箱襄湘乡翔祥详想响享项巷橡像向象萧硝霄削哮嚣销消宵淆晓小孝校肖啸笑效楔些歇蝎鞋协挟携邪斜胁谐写械卸蟹懈泄泻谢屑薪芯锌欣辛新忻心信衅星腥猩惺兴刑型形邢行醒幸杏性姓兄凶胸匈汹雄熊休修羞朽嗅锈秀袖绣墟戌需虚嘘须徐许蓄酗叙旭序畜恤絮婿绪续轩喧宣悬旋玄选癣眩绚靴薛学穴雪血勋熏循旬询寻驯巡殉汛训讯逊迅压押鸦鸭呀丫芽牙蚜崖衙涯雅哑亚讶焉咽阉烟淹盐严研蜒岩延言颜阎炎沿奄掩眼衍演艳堰燕厌砚雁唁彦焰宴谚验殃央鸯秧杨扬佯疡羊洋阳氧仰痒养样漾邀腰妖瑶摇尧遥窑谣姚咬舀药要耀椰噎耶爷野冶也页掖业叶曳腋夜液一壹医揖铱依伊衣颐夷遗移仪胰疑沂宜姨彝椅蚁倚已乙矣以艺抑易邑屹亿役臆逸肄疫亦裔意毅忆义益溢诣议谊译异翼翌绎茵荫因殷音阴姻吟银淫寅饮尹引隐印英樱婴鹰应缨莹萤营荧蝇迎赢盈影颖硬映哟拥佣臃痈庸雍踊蛹咏泳涌永恿勇用幽优悠忧尤由邮铀犹油游酉有友右佑釉诱又幼迂淤于盂榆虞愚舆余俞逾鱼愉渝渔隅予娱雨与屿禹宇语羽玉域芋郁吁遇喻峪御愈欲狱育誉浴寓裕预豫驭鸳渊冤元垣袁原援辕园员圆猿源缘远苑愿怨院曰约越跃钥岳粤月悦阅耘云郧匀陨允运蕴酝晕韵孕匝砸杂栽哉灾宰载再在咱攒暂赞赃脏葬遭糟凿藻枣早澡蚤躁噪造皂灶燥责择则泽贼怎增憎曾赠扎喳渣札轧铡闸眨栅榨咋乍炸诈摘斋宅窄债寨瞻毡詹粘沾盏斩辗崭展蘸栈占战站湛绽樟章彰漳张掌涨杖丈帐账仗胀瘴障招昭找沼赵照罩兆肇召遮折哲蛰辙者锗蔗这浙珍斟真甄砧臻贞针侦枕疹诊震振镇阵蒸挣睁征狰争怔整拯正政帧症郑证芝枝支吱蜘知肢脂汁之织职直植殖执值侄址指止趾只旨纸志挚掷至致置帜峙制智秩稚质炙痔滞治窒中盅忠钟衷终种肿重仲众舟周州洲诌粥轴肘帚咒皱宙昼骤珠株蛛朱猪诸诛逐竹烛煮拄瞩嘱主著柱助蛀贮铸筑住注祝驻抓爪拽专砖转撰赚篆桩庄装妆撞壮状椎锥追赘坠缀谆准捉拙卓桌琢茁酌啄着灼浊兹咨资姿滋淄孜紫仔籽滓子自渍字鬃棕踪宗综总纵邹走奏揍租足卒族祖诅阻组钻纂嘴醉最罪尊遵昨左佐柞做作坐座我这里使用了常用汉字3754个,所以我的分类数量就是3754,如果不在这些汉字中的话,就分类就为0,识别不出来。接下来,我们使用小批量样本训练。

def trainning():

set = test_generator_64(test_data_dir)

print('loading model。。。')

model=cnn_model(len(char_set))

print('end loading')

global batch_size

model.fit_generator(generator=generator_data(),

steps_per_epoch=math.ceil(897758/batch_size)+1,

epochs=2,

validation_data=set,

callbacks=[generatorCallback()])

print('训练完成')这样的方式可以减少内存和显存的消耗,降低出现OOM的概率。

OK,是不是觉得已经结束了?还不是哦,接下来就是漫长的优化模型的过程,看第五步吧。

第五步:

这一步需要根据实际的经验来处理了,不停地重复第四步,调整模型。我可以列一下遇到的问题,大家对照问题可以找一下解决方案:

梯度消失==识别率低==验证集识别率低==训练时间长==CUDA利用率不高

不停地去解决这些问题,最后,在10个小时的训练之后,我得到了一个识别率在96%左右,验证集在95%左右的模型。我觉得这样的识别率已经可以了。

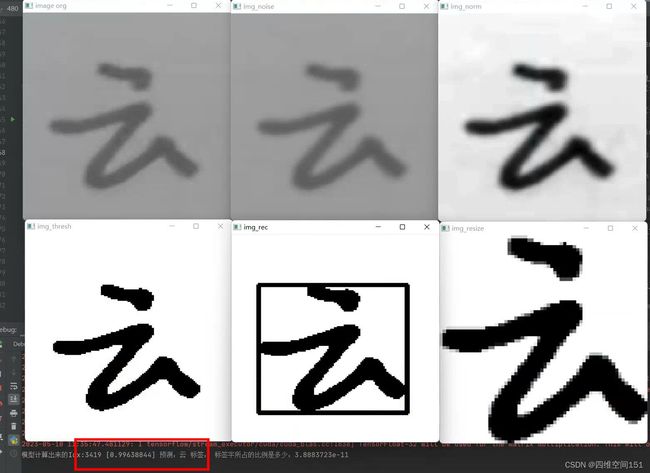

第六步:

试下,手写两个“云”字,看下效果吧。说明下,这两个字不是测试集和训练集当中的,是找两个人写的,识别的精准度还是很高的。

好了,是不是非常简单,总结一下,重点在调整模型这块。88

如有疑问请添加群:195889612