直线检测——对比M-LSD直线检测(基于深度学习)与霍夫曼直线检测

前言

1.直线检测在好多实现应用中能用到到,比如文档扫描,辅助驾驶中的车道线检测,传统的算法用的最多应该属于霍夫曼直线检测,但传统算法都有一个痛苦的调参过程和只能对优化过的使用场景有较好的结果,换个场景可能就要重新调参。

2.MLSD是一种面向实时和轻量级的线段检测深度学习算法,论文地址:https://arxiv.org/abs/2106.00186,相对于传统算法,MLSD只是在训练模型的层面上会比较麻烦,在实现检测并不用去关心各种参数就能达到很好的效果。

3.这里的对比环境是Win 10, vs2019,OpenCV4.5, MLSD会用到NCNN加速库,使用的语言是C++。

一、霍夫曼变换直线检测

1.霍夫曼直线检测的原理

(1)对于直角坐标系中的任意一点A(x0,y0),经过点A的直线满足Y0=kX0+b.(k是斜率,b是截距)。

(2)那么在X-Y平面过点A(x0,y0)的直线簇可以用Y0=kX0+b表示,但对于垂直于X轴的直线斜率是无穷大的则无法表示。因此将直角坐标系转换到极坐标系就能解决该特殊情况。

(3)在极坐标系中表示直线的方程为ρ=xCosθ+ySinθ(ρ为原点到直线的距离)。

![]()

![]()

(4)对于任意一条直线上的所有点来说,变换到极坐标中,从[0~360]空间,可以得到r的大小,属于同一条直线上点在极坐标空(r, theta)必然在一个点上有最强的信号出现,根据此反算到平面坐标中就可以得到直线上各点的像素坐标。从而得到直线。

![]()

2.OpenCV封装有直线检测的函数,HoughLines()和HoughLinesP(),它们都能实现直线检测,差别是:HoughLines()函数使用标准的Hough变换HoughLinesP()函数使用概率Hough变换,即只通过分析点的子集并估计这些点都属于一条直线的概率,这在计算速度上更快。

3.基于OpenCV的霍夫曼直线检测代码,这个代码我之前用于拍照文档扫描时调过参数,觉得相对于拍照的文档扫描,已是不错的一个效果。

void getCanny(cv::Mat &gray, cv::Mat& canny)

{

cv::Mat thres;

double high_thres = threshold(gray, thres, 0, 255, cv::THRESH_BINARY | cv::THRESH_OTSU), low_thres = high_thres * 0.5;

cv::Canny(gray, canny, low_thres, high_thres);

}

void lineDetection(cv::Mat &cv_src, cv::Mat &cv_dst)

{

float w = cv_src.cols >= cv_src.rows ? 960.00 : 640.00;

float h = cv_src.rows > cv_src.cols ? 960.00 : 640.00;

float x_s = cv_src.cols / w;

float y_s = cv_src.rows / h;

cv::Mat cv_resize;

cv::resize(cv_src, cv_resize, cv::Size(w, h));

cv::Mat cv_gray, cv_canny;

cv::cvtColor(cv_resize, cv_gray, cv::COLOR_BGR2GRAY);

getCanny(cv_gray, cv_canny);

// extract lines from the edge image

std::vector<cv::Vec4i> lines;

std::vector<Line> horizontals, verticals;

HoughLinesP(cv_canny, lines, 1, CV_PI / 180,80, 60, 8);

for (size_t i = 0; i < lines.size(); i++)

{

cv::Vec4i v = lines[i];

double delta_x = v[0] - v[2], delta_y = v[1] - v[3];

line(cv_resize, cv::Point(v[0], v[1]), cv::Point(v[2], v[3]), cv::Scalar(0, 0, 255), 1, cv::LINE_AA);

}

cv::resize(cv_resize, cv_dst, cv_src.size());

}

4.检测效果:

二、MLSD直线检测

1.LSD (M-LSD)一种用于资源受限环境的实时轻量线段检测器。它利用了极其高效的 LSD 架构和新颖的训练方案,包括 SoL 增强和几何学习方案。模型可以在GPU、CPU甚至移动设备上实时运行。算法已开源:https://github.com/navervision/mlsd。如果想更详细的理解算法原理,可以直接看论文。

2.为了更好转到ncnn模型,可以使用Pytorch版本进行训练,是于如果转ncnn模型,参考之前的博客或者ncnn官方文档,有很详细的步骤。

3.M-LSD ncnn C++ 模型推理代码:

#ifndef MLSD_H

#define MLSD_H

#include

#include "MLSD.h"

#include 4.检测结果:

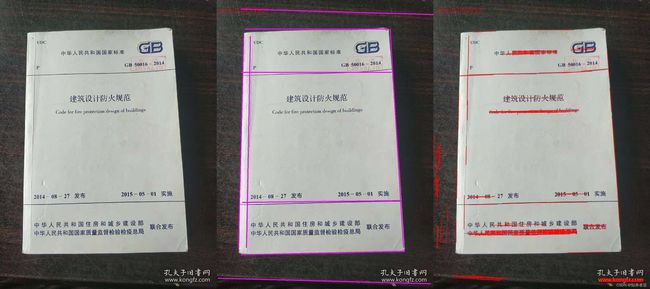

三、检测结果对比

1.调用和对比代码:

#include "MLSD.h"

#include 2.检测结果对比,红色线条为传统霍夫曼直线检测的结果,在CPU上的检测时间,M-LSD也比传统的检测方法快。

四、工程源码

1.源码工程地址:https://download.csdn.net/download/matt45m/85212591。

2.下载工程后,用vs2019打开,设置include和lib路径,然后添加依赖的lib库名就可以运行了。

2.1把源码目录下的include和lib加到vs的属性配置里面。