logback的使用和logback.xml详解

Java 的简单日志外观 (SLF4J) 用作各种日志框架(例如 java.util.logging、logback、log4j)的简单外观或抽象,允许最终用户在部署时插入所需的日志框架。就是Java设计模式当中的门面模式。SLF4J只是个门面,并不是他来完成日志记录。

就好比去医院看病,前台他只是负责挂号的,并不是看病的,而真正挂哪个科室,完全取决于自己。SLF4J可以看做是前台,而我们所说的logback、log4j1.x、log4j2.x等…可以当做科室。最终完成看病的是科室,肯定不是前台。

目录

-

- 一、Logback简介

- 二、Logback模块划分

- 三、Logback缓冲区

- 四、框架性能对比

- 五、logback默认的配置

- 六、查看logback中的配置

- 七、xml常用配置详解

-

- 1、configuration

- 2、contextName

- 3、property

- 4、timestamp

- 5、appender

-

- 5.1、appender类型

-

- 5.1.1、ConsoleAppender-输出控制台

- 5.1.2、FileAppender-输出文件

- 5.1.3、RollingFileAppender-滚动记录文件

- 5.1.4、AsyncAppender-滚动记录文件

- 5.1.5、其他

- 5.2、filter类型

-

- 5.2.1、LevelFilter-级别过滤器

- 5.2.2、ThresholdFilter-临界值过滤器

- 5.2.3、EvaluatorFilter-求值过滤器

- 5.3、encoder格式

- 6、logger

- 7、root

- 八、常用loger配置

- 九、Demo

- 十、总结

一、Logback简介

logback 在概念上与 log4j 1.x 非常相似,因为这两个项目都是由同一个开发人员创建的。Logback 在 log4j 1.x 上带来了大量的改进,改进的地方太多了,无法一一列举。

基于之前在 log4j 1.x 上的工作,logback 内部已经被重写,在某些关键执行路径上的执行速度提高了大约十倍。logback 组件不仅速度更快,而且内存占用更小。

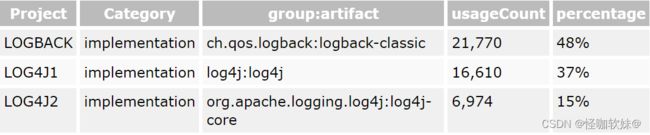

下图是官网当中给提供的目前框架使用率:

前段时间大家应该都听说了log4j2.x出现重大漏洞,而Logback尽管其总体流行率为 48%(实施),但据我们所知,尚未报告针对 logback 的攻击。

二、Logback模块划分

Logback 的架构非常通用,可以在不同的情况下应用。目前,logback 分为三个模块,logback-core、logback-classic 和 logback-access。

logback-core 模块为其他两个模块奠定了基础。

logback-classic 模块是 log4j 1.x 的显着改进版本。此外,logback-classic 原生实现了SLF4J API,因此可以轻松地在 logback 和其他日志框架(例如 log4j 1.x 或 java.util.logging (JUL))之间来回切换。

logback-access 模块与 Tomcat 和 Jetty 等 Servlet 容器集成,以提供 HTTP 访问日志功能。

请注意,您可以轻松地在 logback-core 之上构建自己的模块。

截止目前:最新的稳定 logback 版本是 1.2.10。

三、Logback缓冲区

Log4j 1.2 以及 logback 多年来一直以 异步记录日志,本质上将应用程序生成的新创建的日志记录事件收集到循环缓冲区中。然后,此循环缓冲区中的事件由专用工作线程处理,该工作线程将事件写入其目的地,无论是文件、远程服务器还是数据库。

从应用程序的角度来看,日志记录的成本降低到将日志记录事件放置在 JVM 本地的缓冲区中。

如果日志事件的到达率始终高于事件写入目的地的速率(事件写入目的地速率取决于服务器硬件),则其中的循环缓冲区 最终将变满。

在Logback当中默认的是缓冲区80%已满,则会丢弃TRACT、DEBUG、INFO级别的日志。

默认情况下,log4j 1.2 使用 128 的循环缓冲区大小,log4j2 环形缓冲区默认设置为 262'144,logback 设置为 256 的缓冲区大小。原则上,更大的环形缓冲区应该有利于 log4j2。当然缓冲区大小在配置文件当中是可以修改的。

四、框架性能对比

我们选择与FileAppender结合使用AsyncAppender。FileAppender是最常用的附加程序,而且速度足够快,因此异步日志记录开销的差异可以很明显。如果我们使用DBAppender,所有异步实现都将具有相同的性能,几乎没有或没有明显差异。

性能比较: log4j 版本 1.2.17、log4j 2.14.1 和 logback 1.3.0-alpha10 的性能。

上述结果表明,同步日志的吞吐量实际上高于异步日志的吞吐量。跨框架都是如此。异步他实际上是多了一步,需要先将日志放到缓冲区,然后再通过专用线程,从缓冲区取出日志写到文件,假如是同步,直接将日志写到日志文件。

logback 版本 1.3-alpha10 在同步日志记录的情况下比 log4j 快约 3 倍,比 log4j2 快约 1.6 倍。对于异步日志记录,logback 1.3 的执行速度比 log4j 快 2.5,比 log4j2 快 2.3 倍。

从上图看出Logback每秒有 2’200’000 个事件,每个事件写入 209 个字节,logbackFileAppender以 474 MB/秒的速度生成输出,硬盘驱动器 800 MB/秒吞吐量,logback可占用硬盘最高吞吐量上限的 59%。这也是对 JVM 性能的充分证明。

五、logback默认的配置

Logback 可以通过编程方式进行配置,也可以使用以 XML 或 Groovy 格式表示的配置脚本进行配置。

现有的 log4j1.x 用户可以使用官方的 https://logback.qos.ch/translator/ 应用程序 将log4j.properties文件转换为logback.xml 。然后再切换一下jar包依赖,就可以轻松完成框架切换。

logback配置初始化步骤:

- Logback 尝试在 classpath中找到一个名为

logback-test.xml的文件。 - 如果没有找到这样的文件,它会检查 类路径中的文件

logback.xml。 - 看看是否存在编程方式(也就是Java代码形式)配置的Logback。

- 如果以上都没有成功,logback 会自动配置自己,

BasicConfigurator类是logback提供的默认配置日志,也就是编程方式配置日志。

使用 Maven, logback-test.xml放在src/test/resources 文件夹下,Maven 打包不会打到工程当中。因此,您可以在测试期间使用不同的配置文件,即logback-test.xml,而在生产中使用另一个文件,即logback.xml。

默认的日志格式是:

%d{HH:mm:ss.SSS} [%thread] %-5level %logger{36} - %msg%n

默认情况下,日志记录器被分配了DEBUG 级别。

BasicConfigurator 类 等效于以下配置(logback默认配置):

<configuration>

<appender name="STDOUT" class="ch.qos.logback.core.ConsoleAppender">

<encoder>

<pattern>%d{HH:mm:ss.SSS} [%thread] %-5level %logger{36} - %msg%npattern>

encoder>

appender>

<root level="debug">

<appender-ref ref="STDOUT" />

root>

configuration>

配置文件我们也可以自己指定,不是非得放在resources下,当然一般很少有人指定,自定义路径方式:

import ch.qos.logback.classic.util.ContextInitializer;

public class ServerMain {

public static void main(String args[]) throws IOException, InterruptedException {

// must be set before the first call to LoggerFactory.getLogger();

// ContextInitializer.CONFIG_FILE_PROPERTY is set to "logback.configurationFile"

System.setProperty(ContextInitializer.CONFIG_FILE_PROPERTY, "/path/to/config.xml");

...

}

}

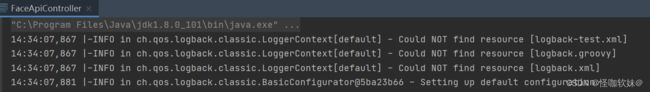

六、查看logback中的配置

这个是logback给我们提供的方法。

public static void main(String[] args) {

LoggerContext lc = (LoggerContext) LoggerFactory.getILoggerFactory();

StatusPrinter.print(lc);

}

我这个项目是没有配置logback的,如果配置了,可以查看到配置相关信息,从下面可以看出,目前是用的logback提供的默认配置。

七、xml常用配置详解

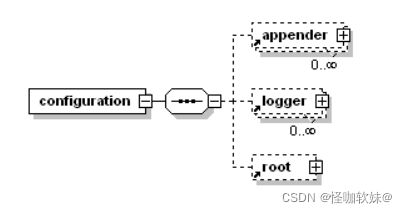

配置文件的基本结构可以描述为

从 logback 版本 0.9.17 开始,与显式规则相关的标记名称不区分大小写。例如

1、configuration

根节点

- scan: 当此属性设置为true时,配置文件如果发生改变,将会被重新加载,默认值为true(官方就是这么写的,我简单用了一下,没发现作用,可能是指的程序运行期间配置文件发生改变,立即生效)。

- scanPeriod: 设置监测配置文件是否有修改的时间间隔,如果没有给出时间单位,默认单位是毫秒。当scan为true时,此属性生效。默认的时间间隔为1分钟。

- debug: 当此属性设置为true时,将打印出logback内部日志信息,实时查看logback运行状态。默认值为false。

例如:

<configuration scan="true" scanPeriod="60 seconds" debug="false">

configuration>

2、contextName

子节点

默认上下文名称为default。但可以使用设置成其他名字,多个程序日志写到一个日志文件的情况,可以使用这个来进行区分,

一旦设置,不能修改。之所以说不能改,是因为一旦定下来再修改,那么历史日志就会对应不上。

设置完contextName,就可以通过pattern标签当中的格式加入%contextName,这样打印出来的日志就会带上你设置的名字。

例如:

<contextName>myAppNamecontextName>

<appender name="STDOUT" class="ch.qos.logback.core.ConsoleAppender">

<encoder>

<pattern>%d %contextName [%t] %level %logger{36} - %msg%npattern>

encoder>

appender>

3、property

子节点

它有两个属性name和value,通过定义的值会被插入到logger上下文中,可以使“${}”来使用变量。

- name: 变量的名称

- value: 的值时变量定义的值

- resource:可以引入properties文件

示例一:

<configuration scan="true" scanPeriod="60 seconds" debug="false">

<property name="APP_Name" value="myAppName" />

<contextName>${APP_Name}contextName>

configuration>

示例二:

这种也是可以的,引入properties,然后properties是key=value形式,然后在xml当中就可以引用了。

<configuration>

<property resource="resource1.properties" />

<contextName>${APP_Name}contextName>

configuration>

在resources添加resource1.properties

APP_Name=face-api22

4、timestamp

子节点

- key: 标识此 的名字;

- datePattern:设置将当前时间(解析配置文件的时间)转换为字符串的模式,遵循java.txt.SimpleDateFormat的格式。

例如:

<configuration scan="true" scanPeriod="60 seconds" debug="false">

<timestamp key="bySecond" datePattern="yyyyMMdd'T'HHmmss"/>

<contextName>${bySecond}contextName>

configuration>

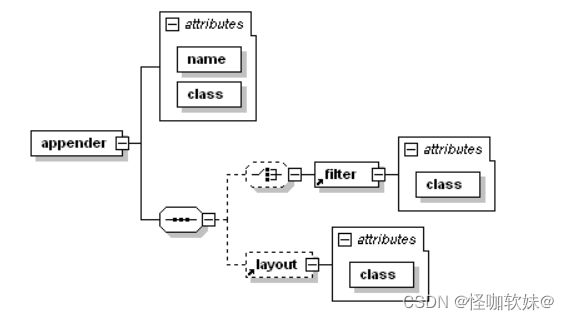

5、appender

子节点

- name指定appender名称

- class指定appender的全限定名

5.1、appender类型

5.1.1、ConsoleAppender-输出控制台

ConsoleAppender 把日志输出到控制台,有以下子节点:

<configuration>

<appender name="STDOUT" class="ch.qos.logback.core.ConsoleAppender">

<encoder>

<pattern>%-4relative [%thread] %-5level %logger{35} - %msg %npattern>

encoder>

appender>

<root level="DEBUG">

<appender-ref ref="STDOUT" />

root>

configuration>

上述配置表示把>=DEBUG级别的日志都输出到控制台

5.1.2、FileAppender-输出文件

把日志添加到文件,有以下子节点:

例如:

<configuration>

<appender name="FILE" class="ch.qos.logback.core.FileAppender">

<file>testFile.logfile>

<append>trueappend>

<immediateFlush>trueimmediateFlush>

<encoder>

<pattern>%-4relative [%thread] %-5level %logger{35} - %msg%npattern>

encoder>

appender>

<root level="DEBUG">

<appender-ref ref="FILE"/>

root>

configuration>

上述配置表示把>=DEBUG级别的日志都输出到testFile.log

5.1.3、RollingFileAppender-滚动记录文件

滚动记录文件, 先将日志记录到指定文件,当符合某个条件时,将日志记录到其他文件。这里需要注意的是,需要配置什么时候触发滚动,滚动文件的格式是什么。有以下子节点:

1、class="ch.qos.logback.core.rolling.TimeBasedRollingPolicy": 最常用的滚动策略,它根据时间来制定滚动策略,既负责滚动也负责触发滚动。TimeBasedRollingPolicy支持自动文件压缩。如果fileNamePattern选项的值以.gz 或.zip结尾,则启用此功能。

TimeBasedRollingPolicy有以下子节点:

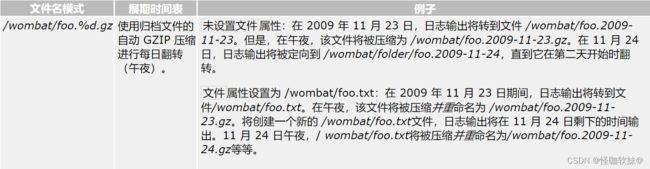

:必要节点,设置文件格式,一般是文件名及“%d”转换符,“%d”可以包含一个java.text.SimpleDateFormat指定的时间格式,如:%d{yyyy-MM}。如果直接使用 %d,默认格式是 yyyy-MM-dd。通过文件格式的设置,决定了文件归档。

格式:/wombat/foo.%d.gz

由于各种技术原因,翻转不是时钟驱动的,而是取决于日志事件的到来。例如,在 2002 年 3 月 8 日,假设fileNamePattern设置为yyyy-MM-dd (每日翻转),午夜后第一个事件的到来将触发翻转。如果在午夜后 23 分 47 秒期间没有记录事件,则翻转实际上将发生在 3 月 9 日凌晨 00:23’47,而不是凌晨 0:00。因此,根据事件的到达率,翻转可能会以一定的延迟触发。但是,无论延迟如何,翻转算法都是正确的,因为在某个时间段内生成的所有日志记录事件都将在分隔该时间段的正确文件中输出。

:可选节点,控制保留的归档文件的最大数量,超出数量就删除旧文件。假设设置每个月滚动,且是6,则只保存最近6个月的文件,删除之前的旧文件。注意,删除旧文件是,那些为了归档而创建的目录也会被删除。

:这是活动文件的大小,默认值是10MB。maxFileSize选项可以以字节、千字节、兆字节或千兆字节为单位指定,方法是在数值后缀KB、MB和 GB。例如,5000000、5000KB、 5MB和2GB都是有效值,前三个是等效的。

:控制所有存档文件的总大小。当超过总大小上限时,最旧的档案将被异步删除。totalSizeCap属性也需要设置maxHistory属性。此外,始终首先应用“最大历史记录”限制,然后应用“总大小上限”限制。

:如果设置为 true,归档删除将在 appender 启动时执行。默认情况下,此属性设置为 false。档案删除通常在翻转期间执行。但是,某些应用程序的生存时间可能不足以触发翻转。因此,对于此类短暂的应用程序,归档删除可能永远不会有机会执行。通过将cleanHistoryOnStart设置为 true,在 appender 启动时执行归档删除。

示例:

<configuration>

<appender name="ROLLING" class="ch.qos.logback.core.rolling.RollingFileAppender">

<file>mylog.txtfile>

<rollingPolicy class="ch.qos.logback.core.rolling.SizeAndTimeBasedRollingPolicy">

<fileNamePattern>mylog-%d{yyyy-MM-dd}.%i.txtfileNamePattern>

<maxFileSize>100MBmaxFileSize>

<maxHistory>60maxHistory>

<totalSizeCap>20GBtotalSizeCap>

rollingPolicy>

<encoder>

<pattern>%msg%npattern>

encoder>

appender>

<root level="DEBUG">

<appender-ref ref="ROLLING" />

root>

configuration>

2、ch.qos.logback.core.rolling.SizeAndTimeBasedRollingPolicy:有时您可能希望按日期归档文件,但同时限制每个日志文件的大小,特别是对日志文件施加大小限制。

请注意,这TimeBasedRollingPolicy已经允许限制归档日志文件的组合大小。如果您只希望限制日志档案的组合大小,那么 TimeBasedRollingPolicy如上所述并设置totalSizeCap属性就足够了。

示例:

请注意设置fileNamePattern的%i 和 %d 标记都是强制性的。每次当前日志文件在当前时间段结束前达到maxFileSize时,都会以递增的索引归档,从 0 开始。(这也正是和RollingFileAppender的区别,RollingFileAppender他是文件达到maxFileSize最大值之后并不会新建文件,相当于文件已经存储满了,而SizeAndTimeBasedRollingPolicy会再次创建新的文件)主要区别于fileNamePattern。

<configuration>

<appender name="ROLLING" class="ch.qos.logback.core.rolling.RollingFileAppender">

<file>mylog.txtfile>

<rollingPolicy class="ch.qos.logback.core.rolling.SizeAndTimeBasedRollingPolicy">

<fileNamePattern>mylog-%d{yyyy-MM-dd}.%i.txtfileNamePattern>

<maxFileSize>100MBmaxFileSize>

<maxHistory>60maxHistory>

<totalSizeCap>20GBtotalSizeCap>

rollingPolicy>

<encoder>

<pattern>%msg%npattern>

encoder>

appender>

<root level="DEBUG">

<appender-ref ref="ROLLING" />

root>

configuration>

3、class="ch.qos.logback.core.rolling.FixedWindowRollingPolicy": 翻转时,根据如下所述的固定窗口算法重命名文件。(一般情况下很少用)

fileNamePattern选项表示归档(翻转)日志文件的文件名模式。此选项是必需的,并且必须 在模式中的某处 包含整数标记%i 。

有以下子节点:

示例:

注意这时候就需要使用triggeringPolicy标签了,这里用的是SizeBasedTriggeringPolicy按照文件大小的翻滚策略,他代表了滚动条件,也可以叫归档条件。下面例子也就是当test.log大于5MB的时候会进行重命名为test1.log,然后再创建一个test.log,当test.log又大于5MB的时候,重命名为test2.log,再次创建test.log,以此类推。

<configuration>

<appender name="FILE" class="ch.qos.logback.core.rolling.RollingFileAppender">

<file>test.logfile>

<rollingPolicy class="ch.qos.logback.core.rolling.FixedWindowRollingPolicy">

<fileNamePattern>tests.%i.log.zipfileNamePattern>

<minIndex>1minIndex>

<maxIndex>3maxIndex>

rollingPolicy>

<triggeringPolicy class="ch.qos.logback.core.rolling.SizeBasedTriggeringPolicy">

<maxFileSize>5MBmaxFileSize>

triggeringPolicy>

<encoder>

<pattern>%-4relative [%thread] %-5level %logger{35} - %msg%npattern>

encoder>

appender>

<root level="DEBUG">

<appender-ref ref="FILE" />

root>

configuration>

5.1.4、AsyncAppender-滚动记录文件

AsyncAppender 异步记录,AsyncAppender如果队列已满 80%,则会丢弃 TRACE、DEBUG 和 INFO 级别的事件。这种策略以事件损失为代价对性能产生了惊人的有利影响。

有以下子节点:

无法在此窗口内处理的事件将被丢弃。该值的语义与Thread.join(long)相同。

默认情况下,事件队列配置的最大容量为 256 个事件。如果队列已满,则应用程序线程将被阻止记录新事件,直到工作线程有机会分派一个或多个事件。当队列不再处于其最大容量时,应用程序线程能够再次开始记录事件。因此,当 appender 在其事件缓冲区的容量或其附近运行时,异步日志记录变为伪同步。

示例:

<configuration>

<appender name="FILE" class="ch.qos.logback.core.FileAppender">

<file>myapp.logfile>

<encoder>

<pattern>%logger{35} - %msg%npattern>

encoder>

appender>

<appender name="ASYNC" class="ch.qos.logback.classic.AsyncAppender">

<appender-ref ref="FILE" />

appender>

<root level="DEBUG">

<appender-ref ref="ASYNC" />

root>

configuration>

5.1.5、其他

还有SocketAppender、SSLSocketAppender、ServerSocketAppender、SSLServerSocketAppender、SMTPAppender、DBAppender、SyslogAppender、SiftingAppender,并不常用,这里就不详解了。

5.2、filter类型

regular filters,另一种是turbo filter。regular filters 是与appender 绑定的, 而turbo filter是与与logger context(logger 上下文)绑定的,区别就是,turbo filter过滤所有logging request ,而regular filter只过滤某个appender的logging request。- Regular filters:在 logback-classic中,filters 继承 Filter 抽象类,Filter抽象类有一个 decide()抽象方法,接收一个 ILoggingEvent 对象参数,而在 logback-access 中 则是AccessEvent 对象。该方法返回一个enum类型 FilterReply。

值可以是以下几个:

DENY:如果方法返回DENY(拒绝),则跳出过滤链,而该 logging event 也会被抛弃。

NRUTRAL:如果返回NRUTRAL(中立),则继续过滤链中的下一个过滤器。

ACCEPT:如果返回ACCEPT(通过),则跳出过滤链

下面是几个常用的过滤器:

5.2.1、LevelFilter-级别过滤器

级别过滤器,根据日志级别进行过滤。如果日志级别等于配置级别,过滤器会根据onMath 和 onMismatch接收或拒绝日志。有以下子节点:

例如:将过滤器的日志级别配置为INFO,所有INFO级别的日志交给appender处理,非INFO级别的日志,被过滤掉。

<configuration>

<appender name="CONSOLE" class="ch.qos.logback.core.ConsoleAppender">

<filter class="ch.qos.logback.classic.filter.LevelFilter">

<level>INFOlevel>

<onMatch>ACCEPTonMatch>

<onMismatch>DENYonMismatch>

filter>

<encoder>

<pattern>

%-4relative [%thread] %-5level %logger{30} - %msg%n

pattern>

encoder>

appender>

<root level="DEBUG">

<appender-ref ref="CONSOLE" />

root>

configuration>

5.2.2、ThresholdFilter-临界值过滤器

临界值过滤器,过滤掉低于指定临界值的日志。当日志级别等于或高于临界值时,过滤器返回NEUTRAL;当日志级别低于临界值时,日志会被拒绝。

日志级别由低到高:

trace<debug<info<warn<error

例如:过滤掉所有低于INFO级别的日志。

<configuration>

<appender name="CONSOLE"

class="ch.qos.logback.core.ConsoleAppender">

<filter class="ch.qos.logback.classic.filter.ThresholdFilter">

<level>INFOlevel>

filter>

<encoder>

<pattern>

%-4relative [%thread] %-5level %logger{30} - %msg%n

pattern>

encoder>

appender>

<root level="DEBUG">

<appender-ref ref="CONSOLE" />

root>

configuration>

5.2.3、EvaluatorFilter-求值过滤器

求值过滤器,评估、鉴别日志是否符合指定条件。有以下子节点:

注意:这个过滤器依赖了一个包,假如要使用这个过滤器需要引入以下,否则运行报错。

<dependency>

<groupId>org.codehaus.janinogroupId>

<artifactId>janinoartifactId>

<version>3.0.7version>

dependency>

例如:过滤掉所有日志消息中不包含“billing”字符串的日志。

<configuration>

<appender name="STDOUT" class="ch.qos.logback.core.ConsoleAppender">

<filter class="ch.qos.logback.core.filter.EvaluatorFilter">

<evaluator>

<expression>return message.contains("billing");expression>

evaluator>

<OnMatch>DENYOnMatch>

<OnMismatch>ACCEPTOnMismatch>

filter>

<encoder>

<pattern>

%-4relative [%thread] %-5level %logger - %msg%n

pattern>

encoder>

appender>

<root level="INFO">

<appender-ref ref="STDOUT" />

root>

configuration>

5.3、encoder格式

6、logger

用来设置某一个包或具体的某一个类的日志打印级别、以及指定。仅有一个name属性,一个可选的level和一个可选的addtivity属性。

可以包含零个或多个元素,标识这个appender将会添加到这个loger。

name: 用来指定受此loger约束的某一个包或者具体的某一个类。level: 用来设置打印级别,大小写无关:TRACE, DEBUG, INFO, WARN, ERROR,

ALL和OFF,还有一个特殊值INHERITED或者同义词NULL,代表强制执行上级的级别。

如果未设置此属性,那么当前loger将会继承上级的级别。addtivity:

是否向上级loger传递打印信息。默认是true。同一样,可以包含零个或多个元素,标识这个appender将会添加到这个loger。

示例:

<logger name="com.mmall" additivity="false" level="INFO" >

<appender-ref ref="mmall" />

<appender-ref ref="console"/>

logger>

7、root

它也是元素,但是它是根logger,是所有的上级。只有一个level属性,因为name已经被命名为"root",且已经是最上级了。

- level: 用来设置打印级别,大小写无关:TRACE, DEBUG, INFO, WARN, ERROR,

ALL和OFF,不能设置为INHERITED或者同义词NULL。 默认是DEBUG。

注意:假如root和logger当中都设置了level,root当中设置的level并不会影响logger设置的level。logger设置的是多少,还是多少。假如没设置logger的,会以root的为主。

<configuration>

<appender name="STDOUT"

class="ch.qos.logback.core.ConsoleAppender">

<encoder>

<pattern>

%d{HH:mm:ss.SSS} [%thread] %-5level %logger{36} - %msg%n

pattern>

encoder>

appender>

<logger name="chapters.configuration" level="INFO" />

<logger name="chapters.configuration.Foo" level="DEBUG" />

<root level="DEBUG">

<appender-ref ref="STDOUT" />

root>

configuration>

八、常用loger配置

在resources当中创建logback.xml。

<configuration>

<property name="LOG_DIRECTOR" value="./logs"/>

<property name="LOG_PREFIX" value="iot-equipment"/>

<property name="MAX_FILE_SIZE" value="500MB"/>

<property name="MAX_HISTORY" value="15"/>

<property name="TOTAL_SIZE_CAP" value="20GB"/>

<property name="LOG_LEVER" value="DEBUG"/>

<appender name="FILE" class="ch.qos.logback.core.rolling.RollingFileAppender">

<file>${LOG_DIRECTOR}/${LOG_PREFIX}.logfile>

<append>trueappend>

<rollingPolicy class="ch.qos.logback.core.rolling.SizeAndTimeBasedRollingPolicy">

<fileNamePattern>${LOG_DIRECTOR}/archive/${LOG_PREFIX}-%d.%i.zipfileNamePattern>

<maxFileSize>${MAX_FILE_SIZE}maxFileSize>

<maxHistory>${MAX_HISTORY}maxHistory>

<totalSizeCap>${TOTAL_SIZE_CAP}totalSizeCap>

rollingPolicy>

<encoder>

<pattern>%date %level [%thread] %logger{10} %msg%npattern>

<charset>UTF-8charset>

encoder>

appender>

<appender name="FILE_ERROR" class="ch.qos.logback.core.rolling.RollingFileAppender">

<file>${LOG_DIRECTOR}/${LOG_PREFIX}-error.logfile>

<append>trueappend>

<rollingPolicy class="ch.qos.logback.core.rolling.SizeAndTimeBasedRollingPolicy">

<fileNamePattern>${LOG_DIRECTOR}/archive/${LOG_PREFIX}-error-%d.%i.zipfileNamePattern>

<maxFileSize>${MAX_FILE_SIZE}maxFileSize>

<maxHistory>${MAX_HISTORY}maxHistory>

<totalSizeCap>${TOTAL_SIZE_CAP}totalSizeCap>

rollingPolicy>

<filter class="ch.qos.logback.classic.filter.LevelFilter">

<level>ERRORlevel>

<onMatch>ACCEPTonMatch>

<onMismatch>DENYonMismatch>

filter>

<encoder>

<pattern>%date %level [%thread] %logger{10} %msg%npattern>

<charset>UTF-8charset>

encoder>

appender>

<appender name="STDOUT" class="ch.qos.logback.core.ConsoleAppender">

<encoder>

<pattern>%date %level [%thread] %logger{10} [%file:%line] %msg%npattern>

<charset>UTF-8charset>

encoder>

appender>

<appender name="ASYNC_FILE" class="ch.qos.logback.classic.AsyncAppender">

<queueSize>512queueSize>

<appender-ref ref="FILE"/>

appender>

<appender name="ASYNC_FILE_ERROR" class="ch.qos.logback.classic.AsyncAppender">

<queueSize>512queueSize>

<appender-ref ref="FILE_ERROR"/>

appender>

<appender name="ASYNC_STDOUT" class="ch.qos.logback.classic.AsyncAppender">

<queueSize>512queueSize>

<appender-ref ref="STDOUT"/>

appender>

<logger name="java.sql" level="${LOG_LEVER}"/>

<logger name="org.apache.ibatis" level="${LOG_LEVER}"/>

<logger name="org.springframework" level="${LOG_LEVER}"/>

<root level="${LOG_LEVER}">

<appender-ref ref="ASYNC_STDOUT"/>

<appender-ref ref="ASYNC_FILE"/>

<appender-ref ref="ASYNC_FILE_ERROR"/>

root>

configuration>

九、Demo

1、添加依赖包logback使用需要和slf4j一起使用,所以总共需要添加依赖的包有slf4j-api

logback使用需要和slf4j一起使用,所以总共需要添加依赖的包有slf4j-api.jar,logback-core.jar,logback-classic.jar,logback-access.jar这个暂时用不到所以不添加依赖了,maven配置

<properties>

<project.build.sourceEncoding>UTF-8project.build.sourceEncoding>

<logback.version>1.1.7logback.version>

<slf4j.version>1.7.21slf4j.version>

properties>

<dependencies>

<dependency>

<groupId>org.slf4jgroupId>

<artifactId>slf4j-apiartifactId>

<version>${slf4j.version}version>

<scope>compilescope>

dependency>

<dependency>

<groupId>ch.qos.logbackgroupId>

<artifactId>logback-coreartifactId>

<version>${logback.version}version>

dependency>

<dependency>

<groupId>ch.qos.logbackgroupId>

<artifactId>logback-classicartifactId>

<version>${logback.version}version>

dependency>

dependencies>

2、logback.xml配置

<configuration debug="false">

<property name="LOG_HOME" value="/home" />

<appender name="STDOUT" class="ch.qos.logback.core.ConsoleAppender">

<encoder class="ch.qos.logback.classic.encoder.PatternLayoutEncoder">

<pattern>%d{yyyy-MM-dd HH:mm:ss.SSS} [%thread] %-5level %logger{50} - %msg%npattern>

encoder>

appender>

<appender name="FILE" class="ch.qos.logback.core.rolling.RollingFileAppender">

<rollingPolicy class="ch.qos.logback.core.rolling.TimeBasedRollingPolicy">

<FileNamePattern>${LOG_HOME}/TestWeb.log.%d{yyyy-MM-dd}.logFileNamePattern>

<MaxHistory>30MaxHistory>

rollingPolicy>

<encoder class="ch.qos.logback.classic.encoder.PatternLayoutEncoder">

<pattern>%d{yyyy-MM-dd HH:mm:ss.SSS} [%thread] %-5level %logger{50} - %msg%npattern>

encoder>

<triggeringPolicy class="ch.qos.logback.core.rolling.SizeBasedTriggeringPolicy">

<MaxFileSize>10MBMaxFileSize>

triggeringPolicy>

appender>

<root level="INFO">

<appender-ref ref="STDOUT" />

root>

configuration>

3、java代码

这里有一点需要注意,引入包的时候一定要引入SL4j的LoggerFactory,这样可以方便以后切换日志框架。

/**

* Hello world!

*/

public class App {

private final static Logger logger = LoggerFactory.getLogger(App.class);

public static void main(String[] args) {

logger.info("logback 成功了");

logger.error("logback 成功了");

logger.debug("logback 成功了");

}

}

十、总结

logback的配置,需要配置输出源appender,打日志的loger(子节点)和root(根节点),实际上,它输出日志是从子节点开始,子节点如果有输出源直接输入,如果无,判断配置的addtivity,是否向上级传递,即是否向root传递,传递则采用root的输出源,否则不输出日志。