Spark Worker 启动流程及源码详解

环境:

spark 2.3.3

scala 2.11.8

Java 1.8.0_141

可以参考【Spark Master启动流程及源码详解】

${SPARK_HOME}/sbin/start-slaves.sh

# Launch the slaves

"${SPARK_HOME}/sbin/slaves.sh" cd "${SPARK_HOME}" \; "${SPARK_HOME}/sbin/start-slave.sh" "spark://$SPARK_MASTER_HOST:$SPARK_MASTER_P

ORT${SPARK_HOME}/sbin/start-slave.sh

…

CLASS=“org.apache.spark.deploy.worker.Worker"

…

"${SPARK_HOME}/sbin"/spark-daemon.sh start $CLASS $WORKER_NUM \

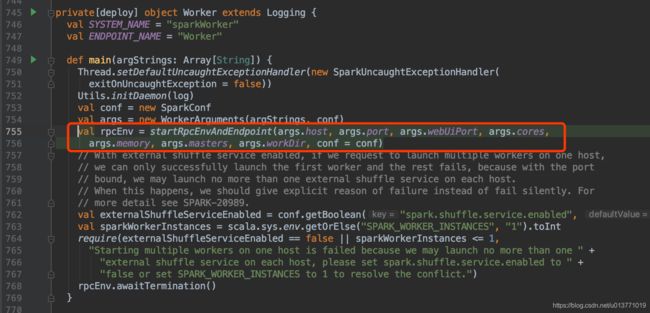

--webui-port "$WEBUI_PORT" $PORT_FLAG $PORT_NUM $MASTER "$@"调用org.apache.spark.deploy.worker.Worker$main方法

会调用startRpcEnvAndEndpoint方法启动Worker服务。

在startRpcEnvAndEndpoint方法中

首先,通过RpcEnv.create方法创建RpcEnv。

val rpcEnv = RpcEnv.create(systemName, host, port, conf, securityMgr)然后注册Endpoint(Worker)

rpcEnv.setupEndpoint(ENDPOINT_NAME, new Worker(rpcEnv, webUiPort, cores, memory,

masterAddresses, ENDPOINT_NAME, workDir, conf, securityMgr))在注册Worker Endpoint的最后,会将OnStart事件放入Worker对应的EndpointData数据结构的inbox中。

RpcEnv的Dispatcher后台线程池会处理这个onStart事件

(ps:这个onStart事件放入的具体流程可以参考【Spark Master 启动流程及源码详解】)

此时,我们来看下Worker的onStart方法:

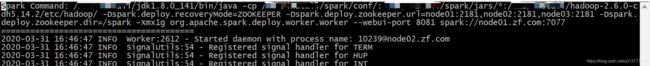

在worker节点上查看spark worker的启动日志

spark-hadoop-org.apache.spark.deploy.worker.Worker-1-node02.zf.com.out

会看到onStart方法打印的log

在该日志的最开始,可以看到worker的启动命令

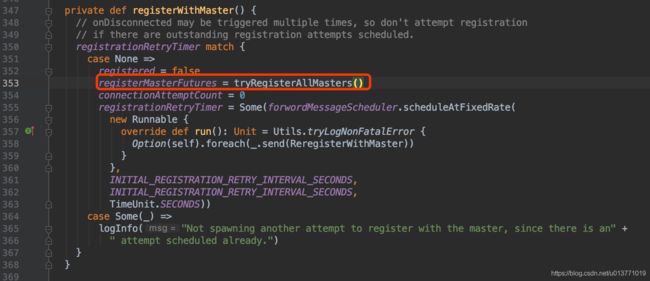

在onStart方法中,通过registerWithMaster方法worker进行master注册

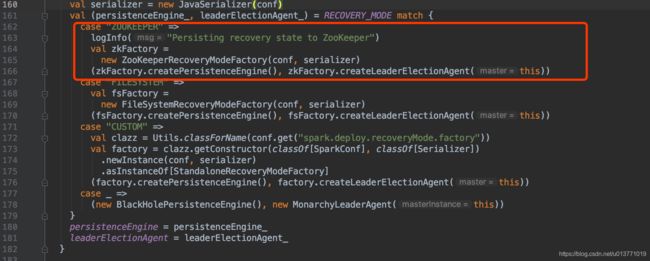

在tryRegisterAllMasters方法中会向所有的master注册(多个master主备情景)

在worker启动时,向所有的master注册,而不是只向active状态的master注册,因为此时worker并不知道哪个master是active,哪个master是standby。

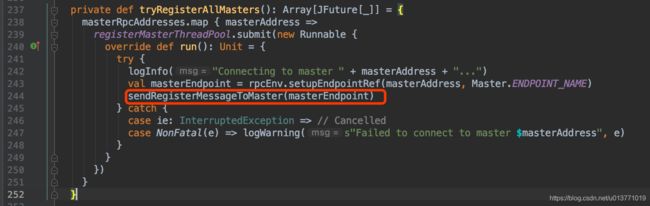

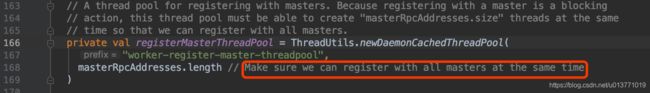

在tryRegisterAllMasters方法中,会使用线程池,通过RpcEndpointRef同时向所有的master

而该线程池的大小就是master的数量

在sendRegisterMessageToMaster方法向master发送RegisterWorker事件

Master的receive方法接受到RegisterWorker时间后会进行处理

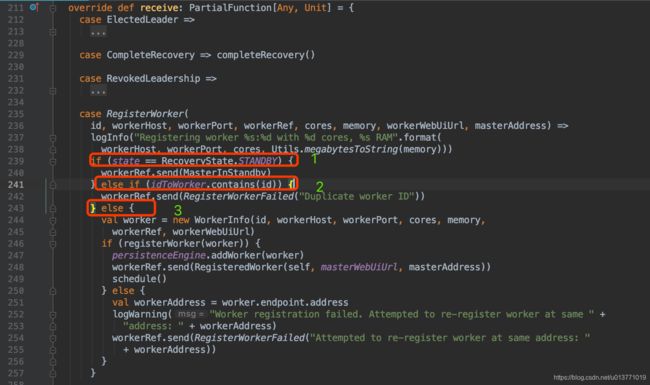

此时分为几种情况:

1.master处于standby状态

master会向worker发送消息MasterInStandby,worker在接受到MasterInStandby消息直接忽略。

2.worker已经在该master注册过

master直接向worker发送注册失败事件RegisterWorkerFailed("Duplicate worker ID”),worker在接受到RegisterWorkerFailed后,会根据worker当前的注册状态判断,是否退出。

3.master处理active状态,且该worker没有注册过

master调用registerWorker方法进行注册

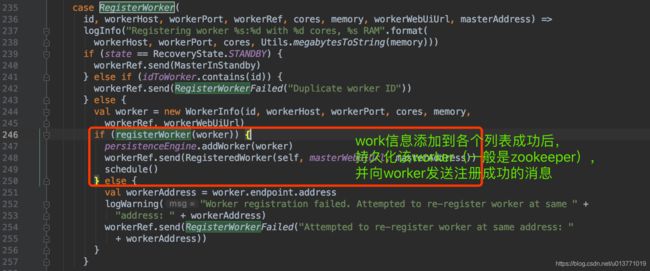

如果该worker在master的worker信息列表中过不存在,直接向三个集合中添加该work信息;

如果在workers列表中已经存在,且workers列表中的worker是Dead状态,先从workers列表中移除这个要注册的worker向;接着判断addressToWorker map中是否存有该worker的地址,如果有,并且map中worker的状态是unkown,表示该map中worker是重启的,把map中的worker删掉,然后向三个集合中添加该work信息;

如果map中worker的状态不是unkown,直接返回false。

Worker在接收到RegisteredWorker消息后,会调用changeMaster方法,更新master信息,并且取消worker向其他master的注册消息

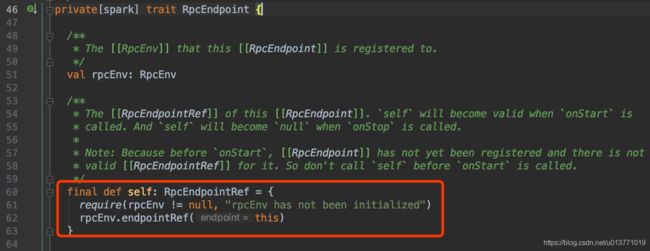

然后调用一个线程池,在该线程池中定期调用worker endpint ref向worker自己发送心跳SendHeartbeat。worker endpint ref是通过worker endpoint的self方法获取的

worker自己在收到SendHeartbeat事件后,向master发送心跳

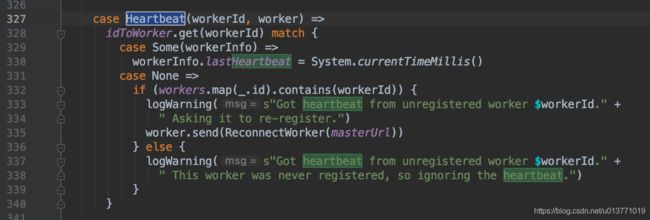

master收到worker心跳后,会更新该worker的心跳时间