- 目标跟踪领域经典论文解析

♢.*

目标跟踪人工智能计算机视觉

亲爱的小伙伴们,在求知的漫漫旅途中,若你对深度学习的奥秘、JAVA、PYTHON与SAP的奇妙世界,亦或是读研论文的撰写攻略有所探寻,那不妨给我一个小小的关注吧。我会精心筹备,在未来的日子里不定期地为大家呈上这些领域的知识宝藏与实用经验分享。每一个点赞,都如同春日里的一缕阳光,给予我满满的动力与温暖,让我们在学习成长的道路上相伴而行,共同进步✨。期待你的关注与点赞哟!目标跟踪是计算机视觉领域的一个

- SpringBoot生态全景图:从SpringCloud到云原生技术栈演进

fanxbl957

Webspringbootspringcloud云原生

博主介绍:Java、Python、js全栈开发“多面手”,精通多种编程语言和技术,痴迷于人工智能领域。秉持着对技术的热爱与执着,持续探索创新,愿在此分享交流和学习,与大家共进步。DeepSeek-行业融合之万象视界(附实战案例详解100+)全栈开发环境搭建运行攻略:多语言一站式指南(环境搭建+运行+调试+发布+保姆级详解)感兴趣的可以先收藏起来,希望帮助更多的人SpringBoot生态全景图:从S

- 【图像处理入门】12. 综合项目与进阶:超分辨率、医学分割与工业检测

小米玄戒Andrew

图像处理:从入门到专家图像处理人工智能深度学习算法python计算机视觉CV

摘要本周将聚焦三个高价值的综合项目,打通传统算法与深度学习的技术壁垒。通过图像超分辨率重建对比传统方法与深度学习方案,掌握医学图像分割的U-Net实现,设计工业缺陷检测的完整流水线。每个项目均包含原理解析、代码实现与性能优化,帮助读者从“技术应用”迈向“系统设计”。一、项目1:图像超分辨率重建(从模糊到清晰的跨越)1.技术背景与核心指标超分辨率(SR)是通过算法将低分辨率(LR)图像恢复为高分辨率

- Densenet模型花卉图像分类

深度学习乐园

分类数据挖掘人工智能

项目源码获取方式见文章末尾!600多个深度学习项目资料,快来加入社群一起学习吧。《------往期经典推荐------》项目名称1.【基于CNN-RNN的影像报告生成】2.【卫星图像道路检测DeepLabV3Plus模型】3.【GAN模型实现二次元头像生成】4.【CNN模型实现mnist手写数字识别】5.【fasterRCNN模型实现飞机类目标检测】6.【CNN-LSTM住宅用电量预测】7.【VG

- 基于AFM注意因子分解机的推荐算法

深度学习乐园

深度学习实战项目深度学习科研项目推荐算法算法机器学习

关于深度实战社区我们是一个深度学习领域的独立工作室。团队成员有:中科大硕士、纽约大学硕士、浙江大学硕士、华东理工博士等,曾在腾讯、百度、德勤等担任算法工程师/产品经理。全网20多万+粉丝,拥有2篇国家级人工智能发明专利。社区特色:深度实战算法创新获取全部完整项目数据集、代码、视频教程,请进入官网:zzgcz.com。竞赛/论文/毕设项目辅导答疑,v:zzgcz_com1.项目简介项目A033基于A

- Tair向量数据库:阿里云原生内存数据库服务的高性能向量检索解决方案

mmlihaio

数据库云原生python

Tair向量数据库:阿里云原生内存数据库服务的高性能向量检索解决方案1.引言在当今的人工智能和大数据时代,高效的向量检索已成为许多应用场景的关键需求。Tair作为阿里云开发的云原生内存数据库服务,不仅提供了丰富的数据模型和企业级能力,还引入了基于非易失性内存(NVM)存储介质的持久内存优化实例。本文将深入探讨如何利用Tair向量数据库功能,实现高性能的向量存储和检索。2.Tair向量数据库概述Ta

- 阿里云魔搭社区AIGC专区:中国AI创作的革命性平台

Liudef06小白

阿里云AIGC人工智能

在生成式人工智能重塑全球数字创作版图的浪潮中,中国首个一站式AIGC开发平台——阿里云魔搭社区AIGC专区于2024年9月杭州云栖大会正式亮相。这一突破性进展不仅填补了国内全流程AI创作工具的空白,更以157款多模态开源模型和全免费GPU算力的开放姿态,为超过690万开发者提供了从模型调用到应用落地的完整生态支持。一、魔搭社区:中国AI模型生态的奠基者魔搭社区(ModelScope)作为阿里云在2

- 探秘阿里云Tair KVCache:大模型推理的加速引擎

云资源服务商

阿里云云计算人工智能

一、引言近年来,人工智能领域发展迅猛,大语言模型(LLM)不断取得突破,其应用场景也日益广泛。从智能客服到内容生成,从智能写作到智能翻译,大语言模型正在深刻地改变着我们的生活和工作方式。随着模型规模的不断扩大和推理需求的日益增长,大模型推理过程中的显存瓶颈问题逐渐凸显,成为制约其发展和应用的关键因素。在大模型推理中,KVCache技术作为一种优化手段,通过缓存历史Token的Key/Value向量

- AI正在偷偷取代这10种职业,你的工作安全吗?

近年来,人工智能(AI)的飞速发展正在悄然改变我们的工作方式。从自动化客服到AI生成内容,许多传统职业正面临被取代的风险。虽然AI带来了更高的效率和便利,但也让不少人开始担忧:我的工作会被AI抢走吗?今天,我们就来盘点10种最容易被AI取代的职业,并探讨如何在这个AI时代保持竞争力。1.客服代表取代指数:★★★★★AI驱动的聊天机器人(如ChatGPT、GoogleBard)已经能够处理大部分基础

- 直播预告!探讨生成模型中的极简概念擦除

青稞社区.

青稞Talk人工智能图像处理

主页:http://qingkeai.online/原文:https://mp.weixin.qq.com/s/yc4whKbnVY8ho1w7rgFVGg6月16日20:00,青稞Talk第55期,新加坡国立大学博士生张扬,将直播分享《生成模型中的极简概念擦除》。分享嘉宾张扬,慕尼黑工业大学计算机专业硕士,新加坡国立大学人工智能专业博士。曾于牛津大学进行学术访问,并在微软亚洲研究院及美国运通新加

- 【DeepSeek实战】3、Ollama实战指南:LobeChat+多网关架构打造高可用大模型集群

无心水

Ollama实战指南LobeChat实战DeepSeek实战DeepSeek全栈应用开发AI入门大模型CSDN技术干货

一、企业级大模型集群架构全景解析在人工智能落地应用的过程中,大模型服务的高可用性、成本控制和灵活扩展能力成为企业关注的核心痛点。本方案通过LobeChat前端、AI网关层和Ollama模型集群的三层架构设计,实现了无需复杂运维即可部署的生产级大模型服务体系。该架构不仅支持负载均衡、故障转移和模型热切换等企业级特性。还通过量化技术将硬件成本降低60%以上,为中小企业提供了与商业云服务相当的性能体验。

- 生成式人工智能实战 | 深度卷积生成对抗网络(Deep Convolutional Generative Adversarial Network, DCGAN)

盼小辉丶

生成式人工智能实战150讲人工智能生成对抗网络神经网络

生成式人工智能实战|深度卷积生成对抗网络0.前言1.模型与数据集分析1.1模型分析1.2数据集介绍2.构建DCGAN生成人脸图像2.1数据处理2.2模型构建2.3模型训练0.前言深度卷积生成对抗网络(DeepConvolutionalGenerativeAdversarialNetworks,DCGAN)是基于生成对抗网络(ConvolutionalGenerativeAdversarialNet

- 深度学习实战:基于嵌入模型的AI应用开发

AIGC应用创新大全

AI人工智能与大数据应用开发MCP&Agent云算力网络人工智能深度学习ai

深度学习实战:基于嵌入模型的AI应用开发关键词:嵌入模型(EmbeddingModel)、深度学习、向量空间、语义表示、AI应用开发、相似性搜索、迁移学习摘要:本文将带你从0到1掌握基于嵌入模型的AI应用开发全流程。我们会用“翻译机”“数字身份证”等生活比喻拆解嵌入模型的核心原理,结合Python代码实战(BERT/CLIP模型)演示如何将文本、图像转化为可计算的语义向量,并通过“智能客服问答”“

- 2024年AI 智能助手(大模型)产品市场分析|商派

徐礼昭|商派软件市场负责人

人工智能

一、引言人工智能的浪潮不断向前推进,智能助手作为其中的重要应用,已经逐渐渗透到我们生活的各个方面。它们以其便捷性和个性化的特点,改变了我们与世界的互动方式。本报告将对AI智能助手进行全面的行业分析,包括行业概况、主要玩家、用户数据、发展要素以及未来趋势等方面,并通过具体案例分享,帮助读者深入了解这一领域的现状和未来发展潜力。二、行业概览(一)智能助手的定义和发展阶段智能助手是利用人工智能技术为用户

- 高通 QCS8550 大模型性能深度解析:从算力基准到场景实测的全维度 Benchmark

伊利丹~怒风

Qualcomm人工智能AI编程pythonarm自然语言处理

前言在人工智能技术狂飙突进的时代,大模型正以前所未有的速度重塑各行业生态,从智能客服到多模态交互,从边缘推理到端侧部署,其应用场景不断拓展。而这一切革新的背后,离不开底层硬件的强力支撑。高通QCS8550作为面向下一代智能设备的旗舰级计算平台,凭借高达48TOPS的AI算力与先进的第七代高通AI引擎,在大模型性能表现上极具竞争力。其异构多核架构不仅能高效处理复杂的神经网络计算,还通过软硬件协同优化

- 从零开始理解零样本学习:AI人工智能必学技术

AI天才研究院

AgenticAI实战AI人工智能与大数据AI大模型企业级应用开发实战ai

从零开始理解零样本学习:AI人工智能必学技术关键词:零样本学习、人工智能、机器学习、知识迁移、语义嵌入摘要:本文旨在全面深入地介绍零样本学习这一在人工智能领域具有重要意义的技术。首先阐述零样本学习的背景和基本概念,通过详细的解释和直观的示意图让读者建立起对零样本学习的初步认识。接着深入剖析其核心算法原理,结合Python代码进行详细说明,同时引入相关数学模型和公式并举例阐释。通过项目实战部分,带领

- 卷积神经网络(Convolutional Neural Network, CNN)

不想秃头的程序

神经网络语音识别人工智能深度学习网络卷积神经网络

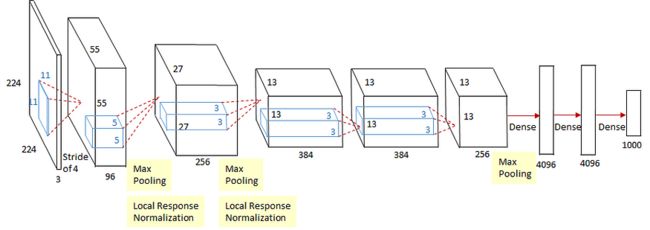

卷积神经网络(ConvolutionalNeuralNetwork,CNN)是一种专门用于处理图像、视频等网格数据的深度学习模型。它通过卷积层自动提取数据的特征,并利用空间共享权重和池化层减少参数量和计算复杂度,成为计算机视觉领域的核心技术。以下是CNN的详细介绍:一、核心思想CNN的核心目标是从图像中自动学习层次化特征,并通过空间共享权重和平移不变性减少参数量和计算成本。其关键组件包括:卷积层(

- ResNet(Residual Network)

不想秃头的程序

神经网络语音识别人工智能深度学习网络残差网络神经网络

ResNet(ResidualNetwork)是深度学习中一种经典的卷积神经网络(CNN)架构,由微软研究院的KaimingHe等人在2015年提出。它通过引入残差连接(SkipConnection)解决了深度神经网络中的梯度消失问题,使得网络可以训练极深的模型(如上百层),并在图像分类、目标检测、语义分割等任务中取得了突破性成果。以下是ResNet的详细介绍:一、核心思想ResNet的核心创新是

- P25:LSTM实现糖尿病探索与预测

?Agony

lstm人工智能rnn

本文为365天深度学习训练营中的学习记录博客原作者:K同学啊一、相关技术1.LSTM基本概念LSTM(长短期记忆网络)是RNN(循环神经网络)的一种变体,它通过引入特殊的结构来解决传统RNN中的梯度消失和梯度爆炸问题,特别适合处理序列数据。结构组成:遗忘门:决定丢弃哪些信息,通过sigmoid函数输出0-1之间的值,表示保留或遗忘的程度。输入门:决定更新哪些信息,同样通过sigmoid函数控制更新

- Python训练营打卡——DAY16(2025.5.5)

cosine2025

Python训练营打卡python开发语言机器学习

目录一、NumPy数组基础笔记1.理解数组的维度(Dimensions)2.NumPy数组与深度学习Tensor的关系3.一维数组(1DArray)4.二维数组(2DArray)5.数组的创建5.1数组的简单创建5.2数组的随机化创建5.3数组的遍历5.4数组的运算6.数组的索引6.1一维数组索引6.2二维数组索引6.3三维数组索引二、SHAP值的深入理解三、总结1.NumPy数组基础总结2.SH

- [Python]-基础篇1- 从零开始的Python入门指南

踏雪无痕老爷子

Pythonpython开发语言

无论你是尚未接触编程的新手,还是想从其他语言转向Python的开发者,这篇文章都是你的入门课。一、Python是什么?Python是一种解释型、高级、通用型编程语言,以简洁明了、简单易用着称。它可以应用于网站开发、自动化脚本、数据分析、人工智能、系统操作等多种场景。二、如何安装Python步骤:访问Python官方网站选择目前最新的Python3.x版本下载Windows用户请务必勾选“AddPy

- 【机器学习&深度学习】反向传播机制

目录一、一句话定义二、类比理解三、为什重要?四、用生活例子解释:神经网络=烹饪机器人4.1第一步:尝一口(前向传播)4.2第二步:倒着推原因(反向传播)五、换成人工智能流程说一遍六、图示类比:找山顶(最优参数)七、总结一句人话八、PyTorch代码示例:亲眼看到每一层的梯度九、梯度=损失函数对参数的偏导数十、类比总结反向传播(Backpropagation)是神经网络中训练过程的核心机制,它就像“

- 人脸识别算法赋能园区无人超市安防升级

智驱力人工智能

算法人工智能边缘计算人脸识别智慧园区智慧工地智慧煤矿

人脸识别算法赋能园区无人超市安防升级正文在园区无人超市的运营管理中,传统安防手段依赖人工巡检或基础监控设备,存在响应滞后、误报率高、环境适应性差等问题。本文从技术背景、实现路径、功能优势及应用场景四个维度,阐述如何通过人脸识别检测、人员入侵算法及疲劳检测算法的协同应用,构建高效、精准的智能安防体系。一、技术背景:视觉分析算法的核心支撑人脸识别算法基于深度学习的卷积神经网络(CNN)模型,通过提取面

- 潜入思维的海洋:SoftCoT++如何让语言模型更聪明

步子哥

智能涌现语言模型人工智能自然语言处理

在人工智能的浩瀚星空下,大型语言模型(LLMs)如同一颗颗璀璨的恒星,照亮了从文本生成到复杂推理的广阔领域。然而,这些模型在推理任务中往往像是在迷雾中航行——尽管它们能抵达目的地,却常常因为固定的思维路径而错过更优的航线。2025年5月,一篇题为《SoftCoT++:Test-TimeScalingwithSoftChain-of-ThoughtReasoning》的论文如同一盏明灯,照亮了如何让

- BI+AI实战:我们如何用3秒完成车企供应链推演

qq_43696218

人工智能

一、BI+AI引领财务分析新纪元在财务数据分析领域,奥威BI+AI正以革命性的姿态颠覆传统。当金蝶、用友等工具仍深陷报表泥潭时,奥威BI+AI通过深度融合商业智能(BI)与人工智能(AI),实现了从滞后报表到实时洞察的飞跃。这不仅极大地提升了财务分析的效率,更为企业的战略决策提供了前所未有的精准支持。二、BI+AI的核心技术优势实时动态分析o奥威BI+AI摒弃了静态数据集,依托原始科目余额表实

- DeepSeek-V3 通俗详解:从诞生到优势,以及与 GPT-4o 的对比

码事漫谈

AIai

前些天发现了一个巨牛的人工智能学习网站,通俗易懂,风趣幽默,忍不住分享一下给大家。点击跳转到网站1.DeepSeek的前世今生1.1什么是DeepSeek?DeepSeek是一家专注于人工智能技术研发的公司,致力于打造高性能、低成本的AI模型。它的目标是让AI技术更加普惠,让更多人能够用上强大的AI工具。1.2DeepSeek-V3的诞生DeepSeek-V3是DeepSeek公司推出的最新一代A

- 企业级AI开发利器:Spring AI框架深度解析与实战_spring ai实战

AI大模型-海文

人工智能springpython算法开发语言java机器学习

企业级AI开发利器:SpringAI框架深度解析与实战一、前言:Java生态的AI新纪元在人工智能技术爆发式发展的今天,Java开发者面临着一个新的挑战:如何将大语言模型(LLMs)和生成式AI(GenAI)无缝融入企业级应用。传统的Java生态缺乏统一的AI集成方案,开发者往往需要为不同AI供应商(如OpenAI、阿里云、HuggingFace)编写大量重复的接口适配代码,这不仅增加了开发成本,

- 图扑软件智慧云展厅,开启数字化展馆新模式

智慧园区

可视化5g人工智能大数据安全云计算

随着疫情的影响以及新兴技术的不断发展,展会的发展形式也逐渐从线下转向线上。通过“云”上启动、云端互动、双线共频的形式开展。通过应用大数据、人工智能、沉浸式交互等多重技术手段,构建数据共享、信息互通、精准匹配的高精度“云展厅”,突破时空壁垒限制。图扑软件运用HT强大的渲染功能,数字孪生“云展位”,1:1复现实际展厅内部独特的结构造型和建筑特色。也可以第一人称视角漫游,模拟用户在展厅内的参观场景,在保

- 转行要趁早!网络安全行业人才缺口大,企业招聘需求正旺!

网络安全行业具有人才缺口大、岗位选择多、薪资待遇好、学历要求不高等优势,对于想要转行的人员来说,是一个非常不错的选择。人才缺口大网络安全攻防技术手段日新月异,特别是现在人工智能技术飞速发展,网络安全形势复杂严峻,人才重要性凸显。教育部《网络安全人才实战能力白皮书》数据显示,到2027年,我国网络安全人员缺口将达327万。近期发布的《2024年网络安全产业人才发展报告》中提到,沿用ISC2的人才缺口

- 【机器学习与数据挖掘实战 | 医疗】案例18:基于Apriori算法的中医证型关联规则分析

Francek Chen

机器学习与数据挖掘实战机器学习数据挖掘Aprioripython关联规则人工智能

【作者主页】FrancekChen【专栏介绍】⌈⌈⌈机器学习与数据挖掘实战⌋⌋⌋机器学习是人工智能的一个分支,专注于让计算机系统通过数据学习和改进。它利用统计和计算方法,使模型能够从数据中自动提取特征并做出预测或决策。数据挖掘则是从大型数据集中发现模式、关联和异常的过程,旨在提取有价值的信息和知识。机器学习为数据挖掘提供了强大的分析工具,而数据挖掘则是机器学习应用的重要领域,两者相辅相成,共同推动

- ios内付费

374016526

ios内付费

近年来写了很多IOS的程序,内付费也用到不少,使用IOS的内付费实现起来比较麻烦,这里我写了一个简单的内付费包,希望对大家有帮助。

具体使用如下:

这里的sender其实就是调用者,这里主要是为了回调使用。

[KuroStoreApi kuroStoreProductId:@"产品ID" storeSender:self storeFinishCallBa

- 20 款优秀的 Linux 终端仿真器

brotherlamp

linuxlinux视频linux资料linux自学linux教程

终端仿真器是一款用其它显示架构重现可视终端的计算机程序。换句话说就是终端仿真器能使哑终端看似像一台连接上了服务器的客户机。终端仿真器允许最终用户用文本用户界面和命令行来访问控制台和应用程序。(LCTT 译注:终端仿真器原意指对大型机-哑终端方式的模拟,不过在当今的 Linux 环境中,常指通过远程或本地方式连接的伪终端,俗称“终端”。)

你能从开源世界中找到大量的终端仿真器,它们

- Solr Deep Paging(solr 深分页)

eksliang

solr深分页solr分页性能问题

转载请出自出处:http://eksliang.iteye.com/blog/2148370

作者:eksliang(ickes) blg:http://eksliang.iteye.com/ 概述

长期以来,我们一直有一个深分页问题。如果直接跳到很靠后的页数,查询速度会比较慢。这是因为Solr的需要为查询从开始遍历所有数据。直到Solr的4.7这个问题一直没有一个很好的解决方案。直到solr

- 数据库面试题

18289753290

面试题 数据库

1.union ,union all

网络搜索出的最佳答案:

union和union all的区别是,union会自动压缩多个结果集合中的重复结果,而union all则将所有的结果全部显示出来,不管是不是重复。

Union:对两个结果集进行并集操作,不包括重复行,同时进行默认规则的排序;

Union All:对两个结果集进行并集操作,包括重复行,不进行排序;

2.索引有哪些分类?作用是

- Android TV屏幕适配

酷的飞上天空

android

先说下现在市面上TV分辨率的大概情况

两种分辨率为主

1.720标清,分辨率为1280x720.

屏幕尺寸以32寸为主,部分电视为42寸

2.1080p全高清,分辨率为1920x1080

屏幕尺寸以42寸为主,此分辨率电视屏幕从32寸到50寸都有

适配遇到问题,已1080p尺寸为例:

分辨率固定不变,屏幕尺寸变化较大。

如:效果图尺寸为1920x1080,如果使用d

- Timer定时器与ActionListener联合应用

永夜-极光

java

功能:在控制台每秒输出一次

代码:

package Main;

import javax.swing.Timer;

import java.awt.event.*;

public class T {

private static int count = 0;

public static void main(String[] args){

- Ubuntu14.04系统Tab键不能自动补全问题解决

随便小屋

Ubuntu 14.04

Unbuntu 14.4安装之后就在终端中使用Tab键不能自动补全,解决办法如下:

1、利用vi编辑器打开/etc/bash.bashrc文件(需要root权限)

sudo vi /etc/bash.bashrc

接下来会提示输入密码

2、找到文件中的下列代码

#enable bash completion in interactive shells

#if

- 学会人际关系三招 轻松走职场

aijuans

职场

要想成功,仅有专业能力是不够的,处理好与老板、同事及下属的人际关系也是门大学问。如何才能在职场如鱼得水、游刃有余呢?在此,教您简单实用的三个窍门。

第一,多汇报

最近,管理学又提出了一个新名词“追随力”。它告诉我们,做下属最关键的就是要多请示汇报,让上司随时了解你的工作进度,有了新想法也要及时建议。不知不觉,你就有了“追随力”,上司会越来越了解和信任你。

第二,勤沟通

团队的力

- 《O2O:移动互联网时代的商业革命》读书笔记

aoyouzi

读书笔记

移动互联网的未来:碎片化内容+碎片化渠道=各式精准、互动的新型社会化营销。

O2O:Online to OffLine 线上线下活动

O2O就是在移动互联网时代,生活消费领域通过线上和线下互动的一种新型商业模式。

手机二维码本质:O2O商务行为从线下现实世界到线上虚拟世界的入口。

线上虚拟世界创造的本意是打破信息鸿沟,让不同地域、不同需求的人

- js实现图片随鼠标滚动的效果

百合不是茶

JavaScript滚动属性的获取图片滚动属性获取页面加载

1,获取样式属性值

top 与顶部的距离

left 与左边的距离

right 与右边的距离

bottom 与下边的距离

zIndex 层叠层次

例子:获取左边的宽度,当css写在body标签中时

<div id="adver" style="position:absolute;top:50px;left:1000p

- ajax同步异步参数async

bijian1013

jqueryAjaxasync

开发项目开发过程中,需要将ajax的返回值赋到全局变量中,然后在该页面其他地方引用,因为ajax异步的原因一直无法成功,需将async:false,使其变成同步的。

格式:

$.ajax({ type: 'POST', ur

- Webx3框架(1)

Bill_chen

eclipsespringmaven框架ibatis

Webx是淘宝开发的一套Web开发框架,Webx3是其第三个升级版本;采用Eclipse的开发环境,现在支持java开发;

采用turbine原型的MVC框架,扩展了Spring容器,利用Maven进行项目的构建管理,灵活的ibatis持久层支持,总的来说,还是一套很不错的Web框架。

Webx3遵循turbine风格,velocity的模板被分为layout/screen/control三部

- 【MongoDB学习笔记五】MongoDB概述

bit1129

mongodb

MongoDB是面向文档的NoSQL数据库,尽量业界还对MongoDB存在一些质疑的声音,比如性能尤其是查询性能、数据一致性的支持没有想象的那么好,但是MongoDB用户群确实已经够多。MongoDB的亮点不在于它的性能,而是它处理非结构化数据的能力以及内置对分布式的支持(复制、分片达到的高可用、高可伸缩),同时它提供的近似于SQL的查询能力,也是在做NoSQL技术选型时,考虑的一个重要因素。Mo

- spring/hibernate/struts2常见异常总结

白糖_

Hibernate

Spring

①ClassNotFoundException: org.aspectj.weaver.reflect.ReflectionWorld$ReflectionWorldException

缺少aspectjweaver.jar,该jar包常用于spring aop中

②java.lang.ClassNotFoundException: org.sprin

- jquery easyui表单重置(reset)扩展思路

bozch

formjquery easyuireset

在jquery easyui表单中 尚未提供表单重置的功能,这就需要自己对其进行扩展。

扩展的时候要考虑的控件有:

combo,combobox,combogrid,combotree,datebox,datetimebox

需要对其添加reset方法,reset方法就是把初始化的值赋值给当前的组件,这就需要在组件的初始化时将值保存下来。

在所有的reset方法添加完毕之后,就需要对fo

- 编程之美-烙饼排序

bylijinnan

编程之美

package beautyOfCoding;

import java.util.Arrays;

/*

*《编程之美》的思路是:搜索+剪枝。有点像是写下棋程序:当前情况下,把所有可能的下一步都做一遍;在这每一遍操作里面,计算出如果按这一步走的话,能不能赢(得出最优结果)。

*《编程之美》上代码有很多错误,且每个变量的含义令人费解。因此我按我的理解写了以下代码:

*/

- Struts1.X 源码分析之ActionForm赋值原理

chenbowen00

struts

struts1在处理请求参数之前,首先会根据配置文件action节点的name属性创建对应的ActionForm。如果配置了name属性,却找不到对应的ActionForm类也不会报错,只是不会处理本次请求的请求参数。

如果找到了对应的ActionForm类,则先判断是否已经存在ActionForm的实例,如果不存在则创建实例,并将其存放在对应的作用域中。作用域由配置文件action节点的s

- [空天防御与经济]在获得充足的外部资源之前,太空投资需有限度

comsci

资源

这里有一个常识性的问题:

地球的资源,人类的资金是有限的,而太空是无限的.....

就算全人类联合起来,要在太空中修建大型空间站,也不一定能够成功,因为资源和资金,技术有客观的限制....

&

- ORACLE临时表—ON COMMIT PRESERVE ROWS

daizj

oracle临时表

ORACLE临时表 转

临时表:像普通表一样,有结构,但是对数据的管理上不一样,临时表存储事务或会话的中间结果集,临时表中保存的数据只对当前

会话可见,所有会话都看不到其他会话的数据,即使其他会话提交了,也看不到。临时表不存在并发行为,因为他们对于当前会话都是独立的。

创建临时表时,ORACLE只创建了表的结构(在数据字典中定义),并没有初始化内存空间,当某一会话使用临时表时,ORALCE会

- 基于Nginx XSendfile+SpringMVC进行文件下载

denger

应用服务器Webnginx网络应用lighttpd

在平常我们实现文件下载通常是通过普通 read-write方式,如下代码所示。

@RequestMapping("/courseware/{id}")

public void download(@PathVariable("id") String courseID, HttpServletResp

- scanf接受char类型的字符

dcj3sjt126com

c

/*

2013年3月11日22:35:54

目的:学习char只接受一个字符

*/

# include <stdio.h>

int main(void)

{

int i;

char ch;

scanf("%d", &i);

printf("i = %d\n", i);

scanf("%

- 学编程的价值

dcj3sjt126com

编程

发一个人会编程, 想想以后可以教儿女, 是多么美好的事啊, 不管儿女将来从事什么样的职业, 教一教, 对他思维的开拓大有帮助

像这位朋友学习:

http://blog.sina.com.cn/s/articlelist_2584320772_0_1.html

VirtualGS教程 (By @林泰前): 几十年的老程序员,资深的

- 二维数组(矩阵)对角线输出

飞天奔月

二维数组

今天在BBS里面看到这样的面试题目,

1,二维数组(N*N),沿对角线方向,从右上角打印到左下角如N=4: 4*4二维数组

{ 1 2 3 4 }

{ 5 6 7 8 }

{ 9 10 11 12 }

{13 14 15 16 }

打印顺序

4

3 8

2 7 12

1 6 11 16

5 10 15

9 14

13

要

- Ehcache(08)——可阻塞的Cache——BlockingCache

234390216

并发ehcacheBlockingCache阻塞

可阻塞的Cache—BlockingCache

在上一节我们提到了显示使用Ehcache锁的问题,其实我们还可以隐式的来使用Ehcache的锁,那就是通过BlockingCache。BlockingCache是Ehcache的一个封装类,可以让我们对Ehcache进行并发操作。其内部的锁机制是使用的net.

- mysqldiff对数据库间进行差异比较

jackyrong

mysqld

mysqldiff该工具是官方mysql-utilities工具集的一个脚本,可以用来对比不同数据库之间的表结构,或者同个数据库间的表结构

如果在windows下,直接下载mysql-utilities安装就可以了,然后运行后,会跑到命令行下:

1) 基本用法

mysqldiff --server1=admin:12345

- spring data jpa 方法中可用的关键字

lawrence.li

javaspring

spring data jpa 支持以方法名进行查询/删除/统计。

查询的关键字为find

删除的关键字为delete/remove (>=1.7.x)

统计的关键字为count (>=1.7.x)

修改需要使用@Modifying注解

@Modifying

@Query("update User u set u.firstna

- Spring的ModelAndView类

nicegege

spring

项目中controller的方法跳转的到ModelAndView类,一直很好奇spring怎么实现的?

/*

* Copyright 2002-2010 the original author or authors.

*

* Licensed under the Apache License, Version 2.0 (the "License");

* yo

- 搭建 CentOS 6 服务器(13) - rsync、Amanda

rensanning

centos

(一)rsync

Server端

# yum install rsync

# vi /etc/xinetd.d/rsync

service rsync

{

disable = no

flags = IPv6

socket_type = stream

wait

- Learn Nodejs 02

toknowme

nodejs

(1)npm是什么

npm is the package manager for node

官方网站:https://www.npmjs.com/

npm上有很多优秀的nodejs包,来解决常见的一些问题,比如用node-mysql,就可以方便通过nodejs链接到mysql,进行数据库的操作

在开发过程往往会需要用到其他的包,使用npm就可以下载这些包来供程序调用

&nb

- Spring MVC 拦截器

xp9802

spring mvc

Controller层的拦截器继承于HandlerInterceptorAdapter

HandlerInterceptorAdapter.java 1 public abstract class HandlerInterceptorAdapter implements HandlerIntercep