MySQL集群高可用架构之MHA

一、概念:

MHA:masterhight availabulity:基于主库的高可用环境下,实现主从复制以及故障切换

主从的架构:最少一主两从

目的:解决mysql单点故障问题,一旦主库崩溃,MHA可以在0-30秒内自动完成故障切换。

1、MHA的工作流程:

MHA使用的是半同步复制,只要有一台从服务器写入数据,就会自动提交给客户端。

master崩溃,slave就会从主的二进制日志保存文件

slave识别最新更新的日志

差异部分同步到slave

提升一个新的slave作为master

其他的slave继续和新的master同步

2、MHA工作原理:

目前MHA主要支持一主多从的架构,要搭建MHA,要求一个复制集群必须最少有3台数据库服务器,一主二从,即一台充当Master,台充当备用Master,另一台充当从库。

MHA Node 运行在每台 MySQL 服务器上

MHAManager 会定时探测集群中的master 节点

当master 出现故障时,它可以自动将最新数据的slave 提升为新的master

然后将所有其他的slave 重新指向新的master,VIP自动漂移到新的master。

整个故障转移过程对应用程序完全透明。

二、MHA实验:

1、实验准备:

- MHA架构搭建

- 模拟故障

- 故障恢复

架构:共四台服务器

MHA manager 20.0.0.21

三台mysql:

master 20.0.0.31

slave1 20.0.0.32

slave2 20.0.0.33

node组件————>需要部署在所有服务器上。manager组件组件依赖node组件,node组件监控mysql状态

node组件靠ssh来进行通信。

先关闭防火墙和安全机制

将三台mysql主机改名

hostnamectl set-hostname master slave1 slave2

su刷新

ping主机名,检测

先实现主从复制

##Master 节点##

vim /etc/my.cnf

vim /etc/my.cnf

[mysqld]

server-id = 1

log_bin = master-bin

log-slave-updates = true

log_bin = master-bin:

用于记录主服务器上的更改操作的日志文件。

这个配置用于主服务器,将生成的二进制日志文件保存为"master-bin"(可以是其他自定义的名称)。

log-slave-updates = true:

从服务器是否要记录它自己执行的更改操作到自己的二进制日志文件中。

设置为"true"表示从服务器会记录自己执行的更改操作,将其写入从服务器的二进制日志文件中。

systemctl restart mysqld

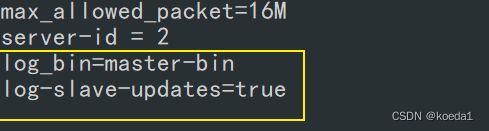

##Slave1 节点##

vim /etc/my.cnf

server-id = 2 #三台服务器的 server-id 不能一样

log_bin = master-bin

relay-log = relay-log-bin

relay-log-index = slave-relay-bin.index

log_bin = master-bin:

指定主服务器(master)的二进制日志文件名称,用于记录主服务器上的更改操作的日志文件。

relay-log = relay-log-bin:

指定从服务器的中继日志文件名称,即用于记录主服务器的二进制日志在从服务器上执行的中继日志。

从服务器会读取主服务器的二进制日志并将其记录到中继日志中。这个配置用于从服务器。

relay-log-index = slave-relay-bin.index:

指定从服务器的中继日志索引文件的名称,该索引文件用于跟踪中继日志文件的位置和顺序。

通过这个索引文件,从服务器知道哪个中继日志文件是下一个要读取和执行的。这个配置用于从服务器。

systemctl restart mysqld

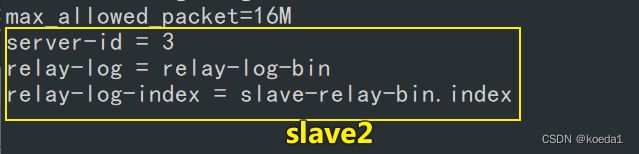

###Slave2 节点##

vim /etc/my.cnf #三台服务器的 server-id 不能一样

server-id = 3

relay-log = relay-log-bin

relay-log-index = slave-relay-bin.index

#slave2不用设置master,指定主的备服务器为slave1即可。

重启mysql

systemctl restart mysqld

在 Master、Slave1、Slave2 节点上都创建两个软链接

ln -s /usr/local/mysql/bin/mysql /usr/sbin/

ln -s /usr/local/mysql/bin/mysqlbinlog /usr/sbin/

配置 mysql 一主两从

(1)所有数据库节点进行 mysql 授权

mysql -uroot -p123456

#从数据库同步使用

grant replication slave on *.* to 'myslave'@'20.0.0.%' identified by '123456';

#manager 使用

grant all privileges on *.* to 'mha'@'20.0.0.%' identified by 'manager';

#防止从库通过主机名连接不上主库

grant all privileges on *.* to 'mha'@'master' identified by 'manager';

grant all privileges on *.* to 'mha'@'slave1' identified by 'manager';

grant all privileges on *.* to 'mha'@'slave2' identified by 'manager';

flush privileges;

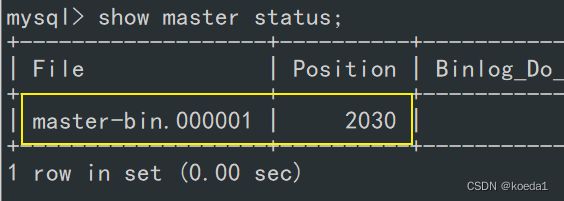

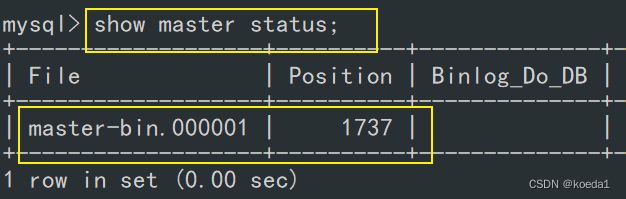

(2)在 Master 节点查看二进制文件和同步点

show master status;

(3)在 Slave1、Slave2 节点执行同步操作

change master to master_host='20.0.0.31',master_user='myslave',master_password='123456',master_log_file='master-bin.000001',master_log_pos=1747;

start slave;

(4)在 Slave1、Slave2 节点查看数据同步结果

show slave status\G;

//确保 IO 和 SQL 线程都是 Yes,代表同步正常。

Slave_IO_Running: Yes

Slave_SQL_Running: Yes

(5)两个从库必须设置为只读模式:

set global read_only=1;

(6)插入数据测试数据库同步

##在 Master 主库插入条数据,测试是否同步##

create database test_db;

use test_db;

create table test(id int);

insert into test(id) values (1);

安装 MHA 软件

(1)所有服务器上都安装 MHA 依赖的环境,首先安装 epel 源

yum install epel-release --nogpgcheck -y

yum install -y perl-DBD-MySQL \

perl-Config-Tiny \

perl-Log-Dispatch \

perl-Parallel-ForkManager \

perl-ExtUtils-CBuilder \

perl-ExtUtils-MakeMaker \

perl-CPAN

(2)安装 MHA 软件包,先在所有服务器上必须先安装 node 组件

对于每个操作系统版本不一样,这里 CentOS7.6选择 0.57 版本。

在所有服务器上必须先安装 node 组件,最后在 MHA-manager 节点上安装 manager 组件,因为 manager 依赖 node 组件。

cd /opt

tar zxvf mha4mysql-node-0.57.tar.gz

cd mha4mysql-node-0.57

perl Makefile.PL

make && make install

(3)在 MHA manager 节点上安装 manager 组件

cd /opt

tar zxvf mha4mysql-manager-0.57.tar.gz

cd mha4mysql-manager-0.57

perl Makefile.PL

make && make install

manager配置:

manager 组件安装后在/usr/local/bin 下面会生成几个工具,主要包括以下几个:

masterha_check_ssh 检查 MHA 的 SSH 配置状况

masterha_check_repl 检查 MySQL 复制状况

masterha_manger 启动 manager的脚本

masterha_check_status 检测当前 MHA 运行状态

masterha_master_monitor 检测 master 是否宕机

masterha_master_switch 控制故障转移(自动或者 手动)

masterha_conf_host 添加或删除配置的 server 信息

masterha_stop 关闭manager

#node 组件安装后也会在/usr/local/bin 下面会生成几个脚本

(这些工具通常由 MHAManager 的脚本触发,无需人为操作)主要如下:

save_binary_logs 保存和复制 master 的二进制日志

apply_diff_relay_logs 识别差异的中继日志事件并将其差异的事件应用于其他的 slave

filter_mysqlbinlog 去除不必要的 ROLLBACK 事件(MHA 已不再使用这个工具)

purge_relay_logs 清除中继日志(不会阻塞 SQL 线程)

masterha_stop:停止MAH脚本

在所有服务器上配置无密码认证

(1)在 manager 节点上配置到所有数据库节点的无密码认证

ssh-keygen -t rsa #一路按回车键

ssh-copy-id 20.0.0.31

ssh-copy-id 20.0.0.32

ssh-copy-id 20.0.0.33

(2)在 master 上配置到数据库节点 slave1 和 slave2 的无密码认证

ssh-keygen -t rsa

ssh-copy-id 20.0.0.32

ssh-copy-id 20.0.0.33

(3)在 slave1 上配置到数据库节点 master 和 slave2 的无密码认证

ssh-keygen -t rsa

ssh-copy-id 20.0.0.31

ssh-copy-id 20.0.0.33

(4)在 slave2 上配置到数据库节点 master 和 slave1 的无密码认证

ssh-keygen -t rsa

ssh-copy-id 20.0.0.31

ssh-copy-id 20.0.0.32

在 manager 节点上配置 MHA

(1)在 manager 节点上复制相关脚本到/usr/local/bin 目录

cp -rp /opt/mha4mysql-manager-0.57/samples/scripts /usr/local/bin

//拷贝后会有四个执行文件

ll /usr/local/bin/scripts/

----------------------------------------------------------------------------------------------------------

master_ip_failover #自动切换时 VIP 管理的脚本

master_ip_online_change #在线切换时 vip 的管理

power_manager #故障发生后关闭主机的脚本

send_report #因故障切换后发送报警的脚本

----------------------------------------------------------------------------------------------------------

(2)复制上述的自动切换时 VIP 管理的脚本到 /usr/local/bin 目录,

这里使用master_ip_failover脚本来管理 VIP 和故障切换

cp /usr/local/bin/scripts/master_ip_failover /usr/local/bin

(3)修改内容如下:(删除原有内容,直接复制并修改vip相关参数)

vim /usr/local/bin/master_ip_failover

第一行以下全部删除

use strict;

use warnings FATAL => 'all';

use Getopt::Long;

my (

$command, $ssh_user, $orig_master_host, $orig_master_ip,

$orig_master_port, $new_master_host, $new_master_ip, $new_master_port

);

my $vip = '192.168.233.100';

my $brdc = '192.168.233.255';

my $ifdev = 'ens33';

my $key = '1';

my $ssh_start_vip = "/sbin/ifconfig ens33:$key $vip";

my $ssh_stop_vip = "/sbin/ifconfig ens33:$key down";

my $exit_code = 0;

GetOptions(

'command=s' => \$command,

'ssh_user=s' => \$ssh_user,

'orig_master_host=s' => \$orig_master_host,

'orig_master_ip=s' => \$orig_master_ip,

'orig_master_port=i' => \$orig_master_port,

'new_master_host=s' => \$new_master_host,

'new_master_ip=s' => \$new_master_ip,

'new_master_port=i' => \$new_master_port,

);

exit &main();

sub main {

print "\n\nIN SCRIPT TEST====$ssh_stop_vip==$ssh_start_vip===\n\n";

if ( $command eq "stop" || $command eq "stopssh" ) {

my $exit_code = 1;

eval {

print "Disabling the VIP on old master: $orig_master_host \n";

&stop_vip();

$exit_code = 0;

};

if ($@) {

warn "Got Error: $@\n";

exit $exit_code;

}

exit $exit_code;

}

elsif ( $command eq "start" ) {

my $exit_code = 10;

eval {

print "Enabling the VIP - $vip on the new master - $new_master_host \n";

&start_vip();

$exit_code = 0;

};

if ($@) {

warn $@;

exit $exit_code;

}

exit $exit_code;

}

elsif ( $command eq "status" ) {

print "Checking the Status of the script.. OK \n";

exit 0;

}

else {

&usage();

exit 1;

}

}

sub start_vip() {

`ssh $ssh_user\@$new_master_host \" $ssh_start_vip \"`;

}

### A simple system call that disable the VIP on the old_master

sub stop_vip() {

`ssh $ssh_user\@$orig_master_host \" $ssh_stop_vip \"`;

}

sub usage {

"Usage: master_ip_failover --command=start|stop|stopssh|status --orig_master_host=host --orig_master_ip=ip --orig_master_port=port --new_master_host=host --new_master_ip=ip --new_master_port=port\n";

}

——————————————————————————————————————————————————————————————————————————————

use strict;

use warnings FATAL => 'all';

use Getopt::Long;

my (

$command, $ssh_user, $orig_master_host, $orig_master_ip,

$orig_master_port, $new_master_host, $new_master_ip, $new_master_port

);

my $vip = '20.0.0.100'; #设定vip地址

my $brdc = '20.0.0.255'; #设定vip的广播地址

my $ifdev = 'ens33'; #vip绑定网卡

my $key = '1'; #ifconfig ens33:1 若是1这里就是1

my $ssh_start_vip = "/sbin/ifconfig ens33:$key $vip";

my $ssh_stop_vip = "/sbin/ifconfig ens33:$key down";

my $exit_code = 0;

GetOptions(

'command=s' => \$command,

'ssh_user=s' => \$ssh_user,

'orig_master_host=s' => \$orig_master_host,

'orig_master_ip=s' => \$orig_master_ip,

'orig_master_port=i' => \$orig_master_port,

'new_master_host=s' => \$new_master_host,

'new_master_ip=s' => \$new_master_ip,

'new_master_port=i' => \$new_master_port,

);

exit &main();

sub main {

print "\n\nIN SCRIPT TEST====$ssh_stop_vip==$ssh_start_vip===\n\n";

if ( $command eq "stop" || $command eq "stopssh" ) {

my $exit_code = 1;

eval {

print "Disabling the VIP on old master: $orig_master_host \n";

&stop_vip();

$exit_code = 0;

};

if ($@) {

warn "Got Error: $@\n";

exit $exit_code;

}

exit $exit_code;

}

elsif ( $command eq "start" ) {

my $exit_code = 10;

eval {

print "Enabling the VIP - $vip on the new master - $new_master_host \n";

&start_vip();

$exit_code = 0;

};

if ($@) {

warn $@;

exit $exit_code;

}

exit $exit_code;

}

elsif ( $command eq "status" ) {

print "Checking the Status of the script.. OK \n";

exit 0;

}

else {

&usage();

exit 1;

}

}

sub start_vip() {

`ssh $ssh_user\@$new_master_host \" $ssh_start_vip \"`;

}

### A simple system call that disable the VIP on the old_master

sub stop_vip() {

`ssh $ssh_user\@$orig_master_host \" $ssh_stop_vip \"`;

}

sub usage {

"Usage: master_ip_failover --command=start|stop|stopssh|status --orig_master_host=host --orig_master_ip=ip --orig_master_port=port --new_master_host=host --new_master_ip=ip --new_master_port=port\n";

}

创建 MHA 软件目录并拷贝配置文件,这里使用app1.cnf配置文件来管理 mysql 节点服务器

mkdir /etc/masterha

cp /opt/mha4mysql-manager-0.57/samples/conf/app1.cnf /etc/masterha

vim /etc/masterha/app1.cnf #删除原有内容,直接复制并修改节点服务器的IP地址

[server default]

manager_log=/var/log/masterha/app1/manager.log

manager_workdir=/var/log/masterha/app1

master_binlog_dir=/usr/local/mysql/data

master_ip_failover_script=/usr/local/bin/master_ip_failover

master_ip_online_change_script=/usr/local/bin/master_ip_online_change

password=manager

ping_interval=1

remote_workdir=/tmp

repl_password=123456

repl_user=myslave

secondary_check_script=/usr/local/bin/masterha_secondary_check -s 192.168.233.22 -s 192.168.233.23

#从对主监听

shutdown_script=""

ssh_user=root

user=mha

[server1]

hostname=192.168.233.21

#主服务器

port=3306

[server2]

candidate_master=1

check_repl_delay=0

hostname=192.168.233.22

#备用主服务器

port=3306

[server3]

hostname=192.168.233.23

#从服务器2

port=3306

[server default]

manager_log=/var/log/masterha/app1/manager.log #manager的管理日志

manager_workdir=/var/log/masterha/app1 #manager的工作目录

master_binlog_dir=/usr/local/mysql/data #保存master的二进制日志的位置,必须要和master保存的路劲一致

master_ip_failover_script=/usr/local/bin/master_ip_failover #设置自行切换脚本

master_ip_online_change_script=/usr/local/bin/master_ip_online_change #手动切换脚本

password=manager #在上面脚本中指定的密码

ping_interval=1 #监控主库,发送ping包的时间间隔,会尝试3次之后切换到failover标本进行自动切换。工作中设置3-6秒

remote_workdir=/tmp #mysql在发生切换时,binlog的保存位置

repl_password=123456 #登录的用户密码

repl_user=myslave #用户名

secondary_check_script=/usr/local/bin/masterha_secondary_check -s 192.168.233.22 -s 192.168.233.23 #从对主监听,从和主之间互相监听,主无需声明,但是从服务器要在check之后声明

shutdown_script="" #设置切换时,告警的脚本

ssh_user=root #远程登录的用户名

user=mha

[server1]

hostname=192.168.233.21 #主服务器

port=3306

[server2]

candidate_master=1 #设置候选的master,如果主库崩溃就会切换到server2

check_repl_delay=0 #即使设置了权重,但是从服务器的relay_log如果落后了master100M,也不会切换。设置为0,会忽略延迟复制,直接升为主。强制切换到设定为候选master的服务器

hostname=192.168.233.22 #备用主服务器

port=3306

[server3]

hostname=192.168.233.23 #从服务器2

port=3306

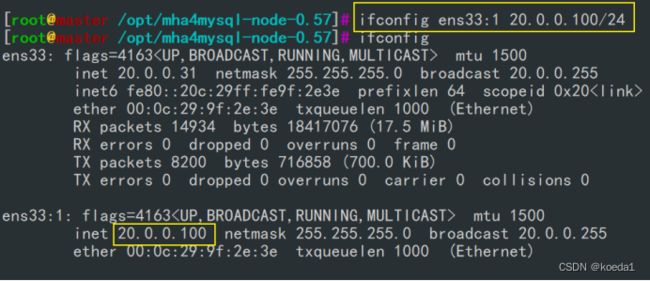

第一次配置需要在 Master 节点上手动开启虚拟IP

ifconfig ens33:1 20.0.0.100/24

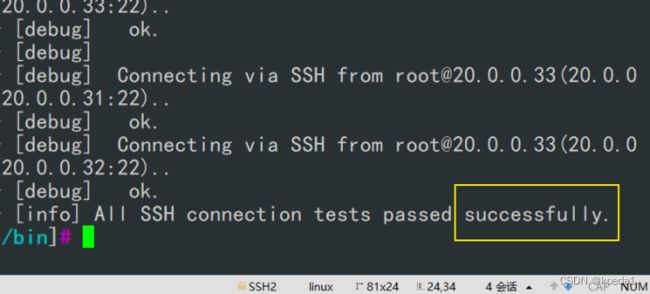

在 manager 节点上测试 ssh 无密码认证,如果正常最后会输出 successfully,如下所示。

masterha_check_ssh -conf=/etc/masterha/app1.cnf

在 manager 节点上测试 mysql 主从连接情况,最后出现 MySQL Replication Health is OK 字样说明正常。如下所示。

masterha_check_repl -conf=/etc/masterha/app1.cnf

在 manager 节点上启动 MHA

nohup masterha_manager --conf=/etc/masterha/app1.cnf --remove_dead_master_conf --ignore_last_failover < /dev/null > /var/log/masterha/app1/manager.log 2>&1 &

查看 MHA 状态,可以看到当前的 master 是 master 节点。

masterha_check_status --conf=/etc/masterha/app1.cnf

查看 MHA 日志,也以看到当前的 master 是 20.0.0.31,如下所示。

cat /var/log/masterha/app1/manager.log | grep "current master"

查看master 的 VIP 地址 192.168.233.100 是否存在,这个 VIP 地址不会因为 manager 节点停止 MHA 服务而消失。

ifconfig

//若要关闭 manager 服务,可以使用如下命令。

masterha_stop --conf=/etc/masterha/app1.cnf

或者可以直接采用 kill 进程 ID 的方式关闭。

检测主从复制:

--------------------------------------------------------- 故障模拟 ---------------------------------------------------

#在 manager 节点上监控观察日志记录

tail -f /var/log/masterha/app1/manager.log

#在 Master 节点 master 上停止mysql服务

systemctl stop mysqld

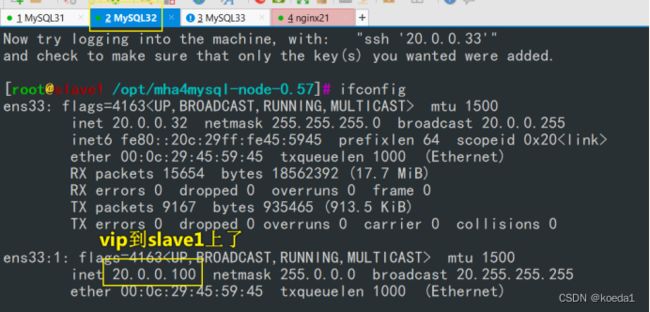

查看slave1ifconfig:

manager上看日志:

cat /var/log/masterha/app1/manager.log

#正常自动切换一次后,MHA 进程会退出。HMA 会自动修改 app1.cnf 文件内容,

将宕机的 master 节点删除。查看 slave1 是否接管 VIP

ifconfig

故障切换备选主库的算法:

1.一般判断从库的是从(position/GTID)判断优劣,数据有差异,最接近于master的slave,成为备选主。

2.数据一致的情况下,按照配置文件顺序,选择备选主库。

3.设定有权重(candidate_master=1),按照权重强制指定备选主。

(1)默认情况下如果一个slave落后master 100M的relay logs的话,即使有权重,也会失效。

(2)如果check_repl_delay=0的话,即使落后很多日志,也强制选择其为备选主。

---------------------------------------------- 模拟故障恢复 ---------------------------------------------------

1.修复mysql

systemctl restart mysqld

2.修复主从

#在现主库服务器 Mysql2 查看二进制文件和同步点

show master status;

#在原主库服务器 mysql1 执行同步操作

先stop slave;

同步命令:

change master to master_host='192.168.233.22',master_user='myslave',master_password='123456',master_log_file='master-bin.000001',master_log_pos=1747;

reset slave;

#一定要重置服务。

最后start slave;

修改原主的配置文件和新主的配置文件:

原主库mysq1修改:

server-id = 1

log_bin=master-bin

relay-log = relay-log_bin

relay-log-index = slave-relay_bin.index

新主库mysql2:

server-id = 2

log_bin=master-bin

log-slave-updates=true

systemctl restart mysqld

3.在 manager 节点上修改配置文件app1.cnf(再把这个记录添加进去,因为它检测掉失效时候会自动消失)

vim /etc/masterha/app1.cnf

......

secondary_check_script=/usr/local/bin/masterha_secondary_check -s 192.168.233.21 -s 192.168.233.23

......

[server1]

hostname=192.168.233.22

port=3306

[server2]

candidate_master=1

check_repl_delay=0

hostname=192.168.233.21

port=3306

[server3]

hostname=192.168.233.23

port=3306

4. 重启manager:

masterha_stop --conf=/etc/masterha/app1.cnf

nohup masterha_manager --conf=/etc/masterha/app1.cnf --remove_dead_master_conf --ignore_last_failover < /dev/null > /var/log/masterha/app1/manager.log 2>&1 &

验证主从复制:

成功,MHA高可用完成