论文浅尝 | 基于对多条思维链的元推理实现智能问答

笔记整理:屠铭尘,浙江大学硕士,研究方向为知识图谱

链接:https://arxiv.org/abs/2304.13007

1. 动机

1.1 Chain of Thought的诞生

尽管大语言模型在许多自然语言处理任务上表现出色,但由于其本质是token by token的类似“词语接龙”的生成方式,并不能理解词句的语义,就导致其在推理相关任务上有所限制,且有研究表明这种缺陷难以通过语言模型规模的扩大得到解决。

因此,Jason Wei等人在2022年发表了Chain-of-Thought Prompting Elicits Reasoning in Large Language Models这篇论文,首次提出了用“Chain of Thought(CoT)”(推理链)这种方法来对ChatGPT等模型进行提示,结果表明此方法可以显著提升模型应对推理任务的能力,这篇论文被称为Chain of Thought的开山之作。

1.2 Chain of Thought的发展

自从Chain of Thought这种推理链提示方法被提出,不断有研究者对这种方法进行了进一步改进。

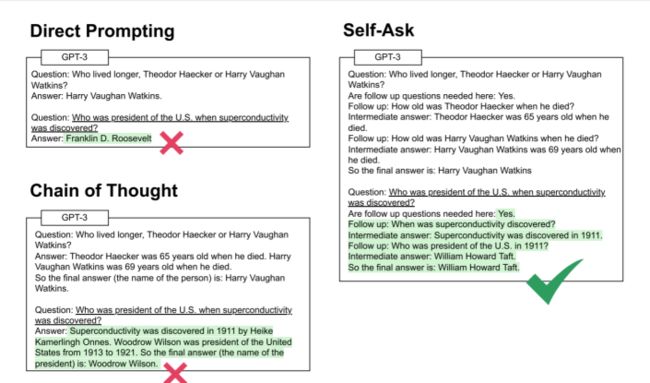

(1)Chain of Thought 推理链提示(Jason Wei, et.al 2022)

即在原先Prompting(输入首先给一个示例问题和对应答案,再给一个相似问题,如上图左)的基础上,在给出示例答案的时候同时给出得到答案的推理过程。

研究显示这种方法能提升大语言模型在推理问题上的正确率。

(2)推理链+在线信息检索 (Harsh Trivedi, et.al 2022)

允许大语言模型在推理过程中加入对在线信息的检索,研究显示此方法也会提升大语言模型的正确率。

(3)Self-Ask(SA) (Harsh Trivedi, et.al 2023)

引导大语言模型将原问题分解成许多小问题,通过逐步解决小问题最终解决原问题。

(4)Self-Consistency(SC)

让语言模型多次对同一个问题进行回答,将出现次数最多的那个答案作为最终答案。

(5)本文提出的Multiple Chains Reasoning (MCR)方法

本篇作者认为,尽管Self-Consistency(SC)方法能显著提升大语言模型应对推理问题的能力,但仍具有以下局限性:

如果某个问题的产出空间很大,那么可能不会得到占多数的答案;

每一次大语言模型对问题进行推理时可能会抓住不同的关键要点,但并不是所有关键信息都会体现在答案中;

答案没有很好的可解释性。

与此同时,MCR具有这些相应的优势:

MCR能够结合每条推理链中的重要信息,因此有望实现答案的正确率提高;

答案具有更好的可解释性。

2. 方法

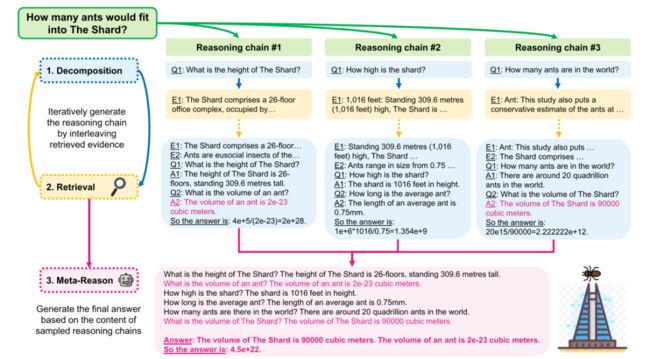

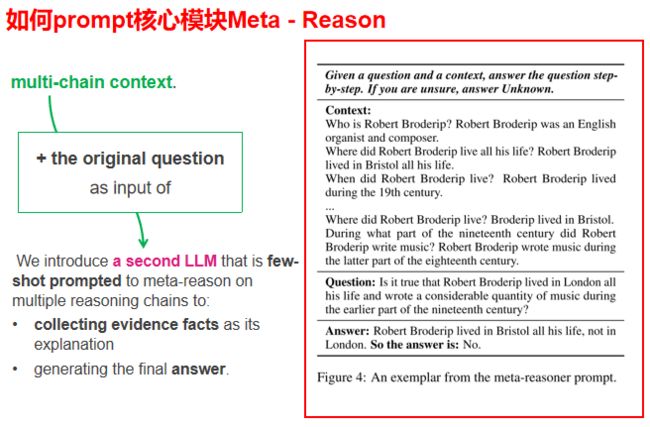

MCR方法主要由三大模块:Decomposition、Retrieval、Meta-Reason构成,其中,Decomposition和Retrieval方法类似于之前方法提出的的原问题进行分解、检索等,而本文提出方法的核心则在于第三个模块,也就是元推理模块。

如何实现元推理模块?本文引入了另一个LLM,预先对其进行few-shot prompting。即将多条链的上下文和原始问题给LLM,训练其从多条链上下文中获取有价值信息、产生最终答案的能力。

3. 实验

3.1 Setting

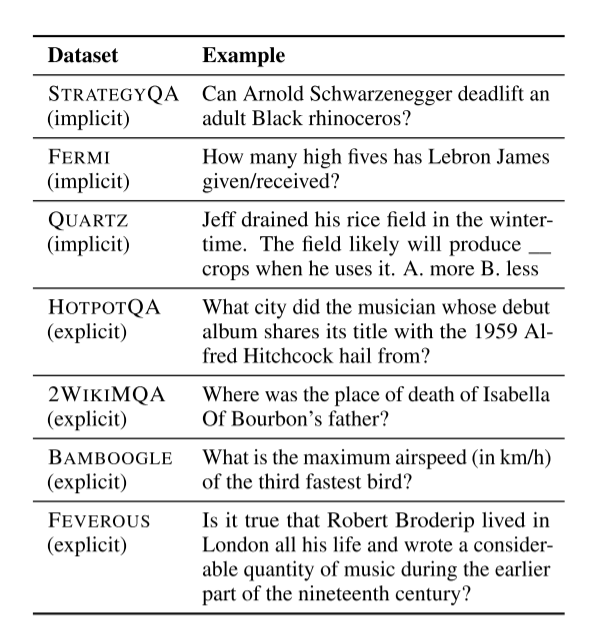

(1)数据集

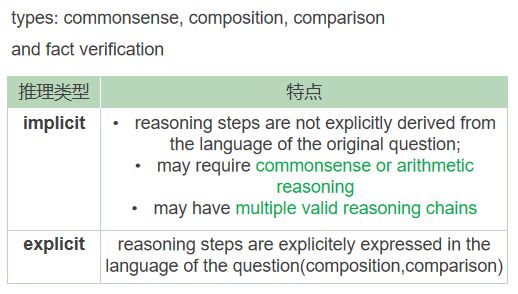

注:此实验将推理类型分为implicit和explicit两种类型

(2)语言模型

main: GPT-3, code-davinci-002

also: Vicuna-13B

(3)元推理模块 Meta-Reasoner

MCR

SCR

(4)基线Baselines

(5)检索器 Retrieval

Google-WIKIPEDIA

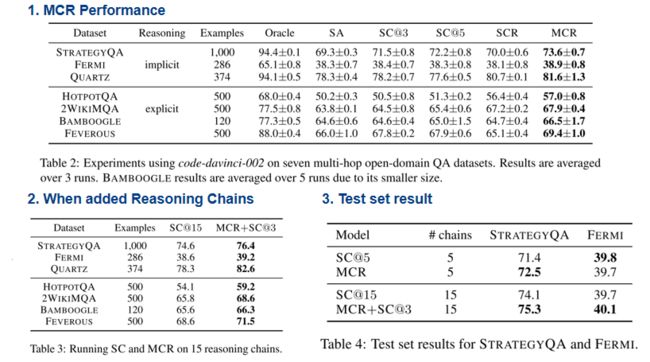

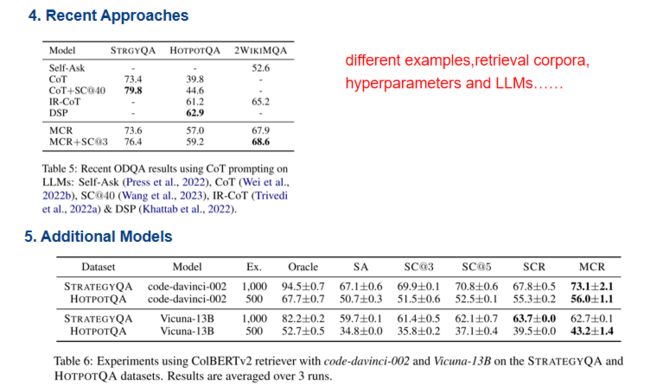

3.2 Results

3.3 Analysis

(1)MCR在什么情况下胜过SCR?

当MCR用到了除了greedy链之外的其他链提供的信息时。

(2)是否真的结合了多条链信息

判断产出的句子中是否有一句来自于某一条链,而另一句来自于另一条链(这可以证明元推理模块至少用到了两条链的信息)结果显示,结合链之间的信息可能至少平均对2%-2.5%的例子起到了积极作用。

(3)答案可解释性的质量

通过人工衡量explanation和答案是否相关,以及如果只给问题和语言模型的explanation,看语言模型是否会生成同样答案,来判断explanation的有效性、可重复性。

(4)错误分析

对不同类型的错误进行分类,并分析语言模型面对不同数据集(不同类型推理问题)时在不同类型错误上的正确率。分析得出在面对implicit类型的问题时,语言模型在解析问题(即问题拆分)上可能表现就相对不佳。

4. 总结

(1)结论

introduce the MCR method for metareasoning on multiple chains-of-thought. 引入MCR模型对多条链进行元推理。

show that MCR outperforms all baselines, including self-consistency, on all 7 multi-hop open-domain QA benchmarks. 证实MCR在所有多跳开放问题标准测试上,表现得比包括SC在内的所有基线方法都要好。

analyze MCR for its explanation quality and its multi-chain reasoning capabilities.对MCR的解释能力和多链推理能力进行了分析。

(2)不足

opt for a prompted LLM as our meta-reasoner, we do not experiment with a fine-tuned meta-reasoning model. 没有用微调的元推理模型,而只是进行了prompting。

For the meta-reasoner context, we experiment with variants which include either generated QA pairs of retrieved evidence sentences. We leave further improvements to the meta-reasoner context as future work.只是给元推理模块QA pairs,未来或许有更好的信息组织形式。

extend the open-source model results to include additional datasets besides STRATEGYQA and HOTPOTQA.以后的实验应在更多测试集上进行。

OpenKG

OpenKG(中文开放知识图谱)旨在推动以中文为核心的知识图谱数据的开放、互联及众包,并促进知识图谱算法、工具及平台的开源开放。

点击阅读原文,进入 OpenKG 网站。