大模型在数据分析场景下的能力评测|进阶篇

做数据分析,什么大模型比较合适?

如何调优大模型,来更好地做数据计算和洞察分析?

如何降低整体成本,同时保障分析体验?10月25日,我们发布了数据分析场景下的大模型能力评测框架(点击查看:Kyligence LLM Benchmark for Data & Analytics)

该评测发出后,我们陆续收到多家客户、大模型厂商等对于评测大模型的询问。在过去的近一个月,我们又陆续新增了一批大模型作为评测对象,如 GPT-4、文心一言 Ernie-Bot-turbo、通义千问 Qwen-14B、Minimax 等,初步得出以下结论,并在下文第 4 章节给出相应的优化建议。

- GPT-4 综合成绩最强,国产大模型表现已经基本不弱于 GPT-3.5

- 不同大模型在“数据计算”方面的差异较大,且参数越高,表现越好

- 多数大模型在“数据洞察”方面的表现接近,一些低参数大模型的表现依然强劲,这意味着可以通过“大数据+大模型”结合来实现低成本的 AI 数据分析场景

图 1 大模型在数据分析场景下的能力评测结果,2023-11

#01 评测坐标系

从普遍意义上来讲,“数据分析”的定义为:数据分析是为了提取有用信息和形成结论而对数据加以详细研究和概括总结的过程。我们从这个定义出发,把数据分析拆解为如下两个关键过程:数据计算和数据洞察。

1.1 数据计算

数据计算过程指在用户给定分析指令的前提下,由大模型进行指令解读,并识别用户的分析意图、匹配业务指标,并从数据库或其他数据源获取指标数值的过程。

值得说明的是,从外部获取数据一般有两种方式:一种是传统的 Text-to-SQL 即大模型生成 SQL 语句访问原始数据库,并完成取数、计算等工作,另一种是大模型生成 API 请求来访问指标平台,以直接获取指标结果。我们在 Kyligence Copilot 使用第二种方式,因为在这种方式下,所有的指标结果是由指标平台提供的,而不是大模型计算,从而确保指标数据准确性,避免“幻觉”的出现,同时保障企业内的指标口径一致性和治理合规。

对于大模型而言,这个过程重点考察两个方面:一是对业务问题的理解和意图识别能力,二是生成代码以访问外部系统的能力。

1.2 数据洞察

数据洞察过程指在用户拿到指标数据之后,开展一系列分析、洞察动作,并获得洞察结论。在传统数据分析的模式下,很多数据分析师会以 Excel 或 CSV 格式的文件形式获取指标数据,并由此开始进行可视化作图、归因分析等操作。

对于大模型而言,这个过程重点考察两个方面:一是以专业的语言表达和润色能力来解读所发现的洞察信息,二是通过可视化、文字总结等形式对统计数据进行可视化展现,向用户证明和支撑自己所发现的洞察。

#02 评测方案

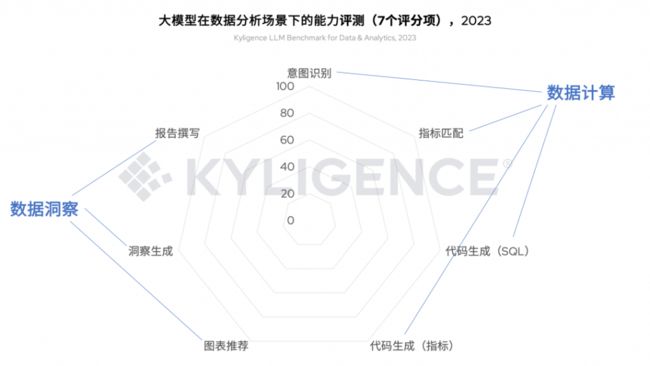

在上个月发布的《大模型在数据分析场景下的能力评测》中,我们提供了 7 个评测维度。在本文中,我们将从数据计算、数据洞察这两个方面对这 7 个评分维度进行归类,并通过这 7 个维度的评分来反映各个大模型在这两方面的能力表现。

关于这 7 个维度的介绍,本文不再重复介绍,如需了解详情,请查阅《大模型在数据分析场景下的能力评测》文章。

图 2 评测坐标系的 7 个评分维度

在本轮评测工作中,我们新增了以下大模型进行评测:Azure OpenAI GPT-4、通义千问 Qwen-14B、文心一言 Ernie-Bot-turbo、MiniMax 等。另外,由于测试数据集更新迭代,我们也对上一轮评测的大模型进行重跑,包括 Azure OpenAI GPT-3.5-Turbo、智谱 AI 的 ChatGLM-Pro 和 ChatGLM-Std、百川智能 Baichuan2-53B 和 Baichuan2-13B、开源 Falcon-40B 和 LLaMA2-13B 等大模型。

#03 评测结果

根据《大模型在数据分析场景下的能力评测》提到的 7 个评分维度,我们对上述所有的受测大模型进行评测,并整理分数如下:

图 3 大模型在数据分析场景下的能力评分

我们根据图 2 所示的分类关系,把这 7 个评分维度投射到由数据计算、数据洞察两个角度组成的评测坐标系中,可以很直观的看到不同大模型的能力分布情况(X/Y 坐标代表该分类各维度评分的平均值,气泡大小代表综合能力评分):

图 4 大模型在数据分析场景下的能力评测结果,2023-11根据以上测试结果,我们初步得出以下结论:

- GPT-4 综合成绩最强,国产大模型表现已经基本不弱于 GPT-3.5

- 从数据计算的角度看,不同大模型表现差异很大;参数越高,表现越好

- 从数据洞察的角度看,多数大模型表现接近,一些低参数大模型的表现依然强劲,这意味着可以通过“大数据+大模型”结合来实现低成本的 AI 数据分析场景

#04 结果分析和优化建议

4.1 从“数据计算”角度

首先,我们从数据计算方面对评测结果进行分析。如结论中提到,不同大模型表现差异很大,尤其是参数较高时表现较好。但参数越高的模型往往需要较高的算力成本,在企业实际落地时往往需要综合考虑收益和成本比例(ROI)。

图 5 优化大模型在“数据计算”方面的表现

因数据计算过程主要是自然语言理解以及代码生成过程,是比较通用的大模型能力,对专业的数据分析能力涉及不多。如图 5 所示,如希望在优化模型表现的同时兼顾算力成本,可以通过集成第三方数据服务平台的方式,如与指标平台实现更紧密的集成。即企业通过指标平台定义并管理所有业务指标的名称、计算逻辑等,并通过 API 方式供应用端获取指标定义和指标数据。在这种方式下,大模型进行指标匹配、代码生成等的难度将降低,有助于保障整体准确度。除此之外,所有的指标数据将由指标平台计算得出,而不是大模型自行计算,这也将在数据计算准确度和指标口径统一管理方面带来显著增强。

4.2 从“数据洞察”角度

其次,我们从数据洞察角度对评测结果进行分析。如结论中提到,多数大模型表现接近,个别模型表现欠佳。因为数据洞察过程是分析数据并产生结论的核心过程,有较强的专业性。我们猜测这和模型训练时使用的语料有关,因为数据洞察场景的 Prompt 输入和输出要求较为专业,且和相应的业务分析场景有关,而大模型训练时的语料库主要来自互联网,和数据分析场景的语料类型可能有较大差异。

图 6 优化大模型在“数据洞察”方面的表现

如图 6 所示,如希望提升模型在数据洞察方面的表现,可以通过增加更多数据分析场景的语料输入对模型进行微调,从而优化大模型在该场景下的效果。

#05 已知限制和情况说明

- 本次评测数据集基于 Kyligence Copilot 使用场景总结,可能不适用于企业所有数据分析场景

- 本次评测基于各大模型服务的默认配置,未进行任何调参;值得说明的一点是,对大模型服务进行调优可能进一步优化评测结果

- 本次评测针对不同大模型所使用的算力情况如下:

- GPT-4 / GPT-3.5-Turbo / ChatGLM / Baichuan2-53B / MiniMax / 文心一言均基于厂商提供的 SaaS 服务,算力资源不详

- Falcon-40B / Baichuan2-13B / LLaMa2-13B / 通义千问 Qwen-14B 是基于对应的开源模型在实验室私有化部署了本地服务,算力为 4 块 NVIDIA RTX 4090 24GB 显卡

- 因算力有限等因素,我们尚未对 LLaMa2-70B 完成评测;同时,我们期待在开源大模型有更好中文支持的情况下再次进行评测

#06 结语

在本轮评测中,我们从数据计算、数据洞察两个方面对大模型评测结果进行了归类,并提出不同方向的优化建议。如果您正在对大模型进行技术选型,或正在探索大模型在数据分析场景的应用落地与优化方案,欢迎与我们联系沟通。

11月21日,Kyligence 将举办线上数智论坛暨产品发布会,我们特邀了来自德勤、智谱 AI、百川智能、阿斯利康等嘉宾分享大模型 + 大数据的最新探索与实践,届时我们将发布 AI 数智助理 Kyligence Copilot 支持国产化大模型以及智能一站式指标平台的企业级能力与实践。欢迎大家点击「链接」查看完整议程并报名参会

关于 Kyligence

跬智信息(Kyligence)由 Apache Kylin 创始团队于 2016 年创办,是领先的大数据分析和指标平台供应商,提供企业级 OLAP(多维分析)产品 Kyligence Enterprise 和一站式指标平台 Kyligence Zen,为用户提供企业级的经营分析能力、决策支持系统及各种基于数据驱动的行业解决方案。

Kyligence 已服务中国、美国、欧洲及亚太的多个银行、证券、保险、制造、零售、医疗等行业客户,包括建设银行、平安银行、浦发银行、北京银行、宁波银行、太平洋保险、中国银联、上汽、长安汽车、星巴克、安踏、李宁、阿斯利康、UBS、MetLife 等全球知名企业,并和微软、亚马逊云科技、华为、安永、德勤等达成全球合作伙伴关系。Kyligence 获得来自红点、宽带资本、顺为资本、斯道资本、Coatue、浦银国际、中金资本、歌斐资产、国方资本等机构多次投资。