申明式管理方式与配置清单文件

目录

申明式管理方式

1、使用申明式管理方式相关操作

1)获取资源配置清单

2)更改获取的yaml配置清单,并进行修改然后创建或更新资源

3)在线修改或编辑资源配置

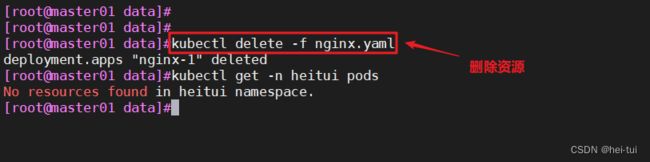

4)删除资源

2、如何获取资源配置清单文件模板(yaml配置文件

配置清单文件

1、deployment.yaml文件详解

2、Pod.yaml详解

3、service.yaml详解

申明式管理方式

申明式管理方式,主要式通过资源配置清单文件实现对资源进行管理

资源配hi清单文件有两种格式,分别是yaml和json格式,yaml格式更人性化,更容易让人理解,json格式易于api接口解析

1、使用申明式管理方式相关操作

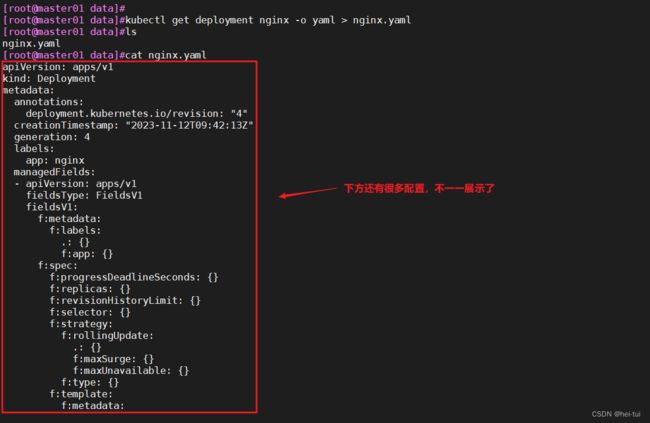

1)获取资源配置清单

格式://针对已存在的资源进行获取

kubectl get [-n <命名空间>] <资源类型> <资源名称> -o yaml > XXX.yaml

例子:

kubectl get deployment nginx -o yaml > nginx.yaml2)更改获取的yaml配置清单,并进行修改然后创建或更新资源

格式:

kubectl create|apply -f XXX.yaml #创建/更新资源

例子:

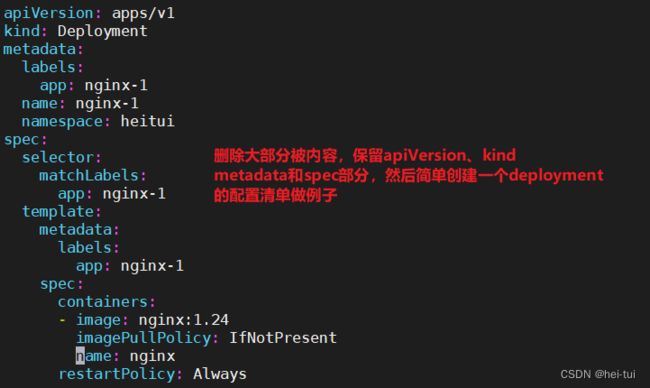

#对已获取的yaml配置清单进行修改

//保留一些部分,做一个简单的配置清单文件

vim nginx.yaml

apiVersion: apps/v1 #接口版本

kind: Deployment #接口类型

metadata: #元数据

labels: #指定标签为"app:nginx-1"

app: nginx-1

name: nginx-1 #指定Deployment的名称

namespace: heitui #指定命名空间

spec:

selector: #指定标签选择器

matchLabels: #通过app:nginx-1标签与service进行绑定

app: nginx-1

template: #容器的模板

metadata: #元数据

labels: #指定模板标签为"app:nginx-1"

app: nginx-1

spec:

containers: #创建容器

- image: nginx:1.24 #指定容器的镜像

imagePullPolicy: IfNotPresent #设置镜像拉取策略

name: nginx #指定容器的名称

restartPolicy: Always #设置容器重启策略

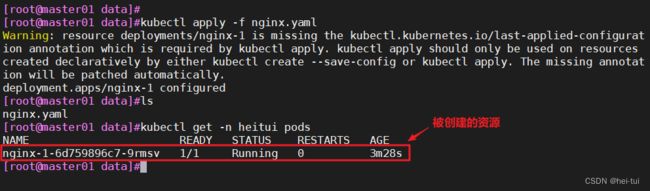

//然后使用以下命令创建新的资源

kubectl apply -f nginx.yaml #这里可以使用create和apply,个人建议使用applykubectl create与kubectl apply的区别

kubectl create与kubectl apply都是使用 Kubernetes 集群中的 YAML配置清单文件创建和管理 Kubernetes 资源对象。

kubectl create用于创建 Kubernetes 对象。如果对应的资源已经存在,则会返回错误,此时需要先删除原有的资源对象,然后再执行创建操作。

如果资源对象不存在,则会自动创建对应的资源对象。

kubectl apply用于创建或更新一个 Kubernetes 对象。如果该资源对象已经存在,则会首先尝试更新对应的字段值和配置。

如果不存在则会自动创建资源对象。

同时

kubectl apply还提供了许多可选的参数,例如 --force、–validate、–record 等,可以使更新操作更加精确和可控。

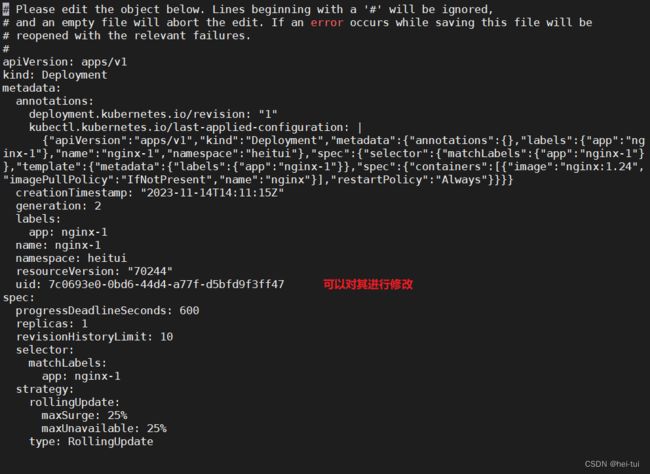

3)在线修改或编辑资源配置

格式:

kubectl edit [-n <命名空间>] <资源类型> <资源名称> #在线修改/编辑资源配置

对于不支持在线修改的字段只能通过离线修改的方式更新资源:

kubectl delete -f XXX.yaml && kubectl apply -f XXX.yaml

例子:

kubectl edit -n heitui deployment nginx-1

//可以对下面内容进行修改,然后保存退出即可

# Please edit the object below. Lines beginning with a '#' will be ignored,

# and an empty file will abort the edit. If an error occurs while saving this file will be

# reopened with the relevant failures.

#

apiVersion: apps/v1

kind: Deployment

metadata:

annotations:

deployment.kubernetes.io/revision: "1"

kubectl.kubernetes.io/last-applied-configuration: |

{"apiVersion":"apps/v1","kind":"Deployment","metadata":{"annotations":{},"labels":{"app":"nginx-1"},"name":"nginx-1","namespace":"heitui"},"spec":{"selector":{"matchLabels":{"app":"nginx-1"}},"template":{"metadata":{"labels":{"app":"nginx-1"}},"spec":{"containers":[{"image":"nginx:1.24","imagePullPolicy":"IfNotPresent","name":"nginx"}],"restartPolicy":"Always"}}}}

creationTimestamp: "2023-11-14T14:11:15Z"

generation: 2

labels:

app: nginx-1

name: nginx-1

namespace: heitui

resourceVersion: "70244"

uid: 7c0693e0-0bd6-44d4-a77f-d5bfd9f3ff47

spec:

progressDeadlineSeconds: 600

replicas: 1

revisionHistoryLimit: 10

selector:

matchLabels:

app: nginx-1

strategy:

rollingUpdate:

maxSurge: 25%

maxUnavailable: 25%

type: RollingUpdate

template:

metadata:

creationTimestamp: null

labels:

app: nginx-1

spec:

containers:

- image: nginx:1.24

imagePullPolicy: IfNotPresent

name: nginx

resources: {}

terminationMessagePath: /dev/termination-log

terminationMessagePolicy: File

dnsPolicy: ClusterFirst

restartPolicy: Always

schedulerName: default-scheduler

securityContext: {}

terminationGracePeriodSeconds: 30

status:

availableReplicas: 1

conditions:

- lastTransitionTime: "2023-11-14T14:12:21Z"

lastUpdateTime: "2023-11-14T14:12:21Z"

message: Deployment has minimum availability.

reason: MinimumReplicasAvailable

status: "True"

type: Available

- lastTransitionTime: "2023-11-14T14:11:15Z"

lastUpdateTime: "2023-11-14T14:12:21Z"

message: ReplicaSet "nginx-1-6d759896c7" has successfully progressed.

reason: NewReplicaSetAvailable

status: "True"

type: Progressing

observedGeneration: 2

readyReplicas: 1

replicas: 1

updatedReplicas: 14)删除资源

格式:

kubectl delete -f XXX.yaml

例子:

kubectl delete -f nginx.yaml2、如何获取资源配置清单文件模板(yaml配置文件

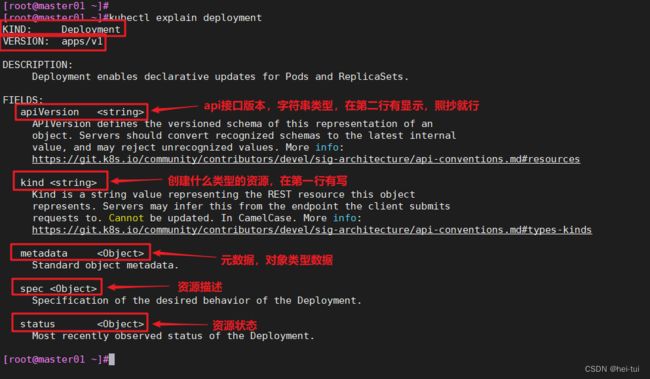

1)手撕yaml配置文件,可根据kubectl explain 命令获取字段信息

2)通过kubectl create | run | expose ... --dry-run=client -o yaml > XXX.yaml

3)通过已存在的资源,查看已存在的资源配置方式,导出并作修改

kubectl get [-n <命名空间>] <资源类型> <资源名称> -o yaml > XXX.yaml

kubectl edit [-n <命名空间>] <资源类型> <资源名称>再手动复制资源配置,粘贴到yaml文件中

4)复制K8s官方文档的资源配置案例

配置清单文件

1、deployment.yaml文件详解

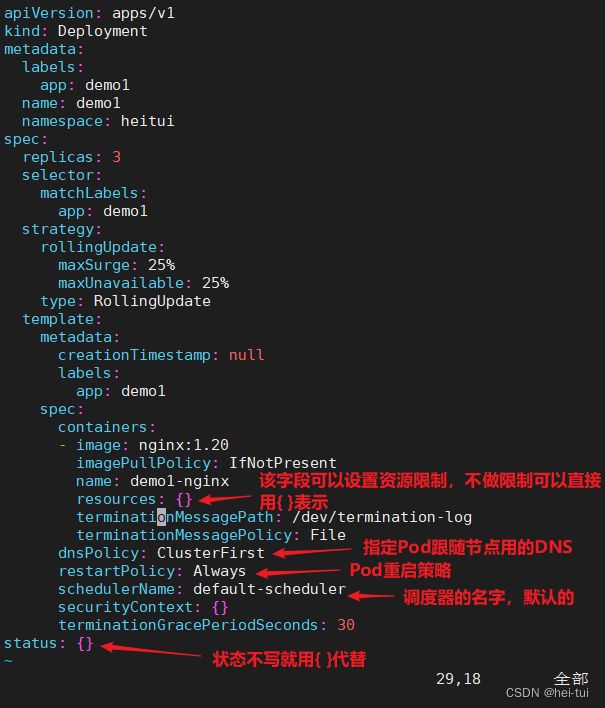

apiVersion: extensions/v1beta1 #接口版本

kind: Deployment #接口类型

metadata:

name: cango-demo #Deployment名称

namespace: cango-prd #命名空间

labels:

app: cango-demo #标签

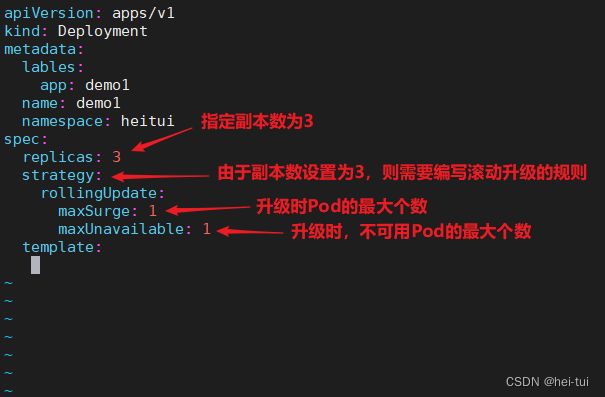

spec:

replicas: 3

strategy:

rollingUpdate: ##由于replicas为3,则整个升级,pod个数在2-4个之间

maxSurge: 1 #滚动升级时会先启动1个pod

maxUnavailable: 1 #滚动升级时允许的最大Unavailable的pod个数

template:

metadata:

labels:

app: cango-demo #模板名称必填

sepc: #定义容器模板,该模板可以包含多个容器

containers:

- name: cango-demo #镜像名称

image: swr.cn-east-2.myhuaweicloud.com/cango-prd/cango-demo:0.0.1-SNAPSHOT #镜像地址

command: [ "/bin/sh","-c","cat /etc/config/path/to/special-key" ] #启动命令

args: #启动参数

- '-storage.local.retention=$(STORAGE_RETENTION)'

- '-storage.local.memory-chunks=$(STORAGE_MEMORY_CHUNKS)'

- '-config.file=/etc/prometheus/prometheus.yml'

- '-alertmanager.url=http://alertmanager:9093/alertmanager'

- '-web.external-url=$(EXTERNAL_URL)'

#如果command和args均没有写,那么用Docker默认的配置。

#如果command写了,但args没有写,那么Docker默认的配置会被忽略而且仅仅执行.yaml文件的command(不带任何参数的)。

#如果command没写,但args写了,那么Docker默认配置的ENTRYPOINT的命令行会被执行,但是调用的参数是.yaml中的args。

#如果如果command和args都写了,那么Docker默认的配置被忽略,使用.yaml的配置。

imagePullPolicy: IfNotPresent #如果不存在则拉取

livenessProbe: #表示container是否处于live状态。如果LivenessProbe失败,LivenessProbe将会通知kubelet对应的container不健康了。随后kubelet将kill掉container,并根据RestarPolicy进行进一步的操作。默认情况下LivenessProbe在第一次检测之前初始化值为Success,如果container没有提供LivenessProbe,则也认为是Success;

httpGet:

path: /health #如果没有心跳检测接口就为/

port: 8080

scheme: HTTP

initialDelaySeconds: 60 ##启动后延时多久开始运行检测

timeoutSeconds: 5

successThreshold: 1

failureThreshold: 5

readinessProbe:

httpGet:

path: /health #如果没有心跳检测接口就为/

port: 8080

scheme: HTTP

initialDelaySeconds: 30 ##启动后延时多久开始运行检测

timeoutSeconds: 5

successThreshold: 1

failureThreshold: 5

resources: ##CPU内存限制

requests:

cpu: 2

memory: 2048Mi

limits:

cpu: 2

memory: 2048Mi

env: ##通过环境变量的方式,直接传递pod=自定义Linux OS环境变量

- name: LOCAL_KEY #本地Key

value: value

- name: CONFIG_MAP_KEY #局策略可使用configMap的配置Key,

valueFrom:

configMapKeyRef:

name: special-config #configmap中找到name为special-config

key: special.type #找到name为special-config里data下的key

ports:

- name: http

containerPort: 8080 #对service暴露端口

volumeMounts: #挂载volumes中定义的磁盘

- name: log-cache

mount: /tmp/log

- name: sdb #普通用法,该卷跟随容器销毁,挂载一个目录

mountPath: /data/media

- name: nfs-client-root #直接挂载硬盘方法,如挂载下面的nfs目录到/mnt/nfs

mountPath: /mnt/nfs

- name: example-volume-config #高级用法第1种,将ConfigMap的log-script,backup-script分别挂载到/etc/config目录下的一个相对路径path/to/...下,如果存在同名文件,直接覆盖。

mountPath: /etc/config

- name: rbd-pvc #高级用法第2中,挂载PVC(PresistentVolumeClaim)

#使用volume将ConfigMap作为文件或目录直接挂载,其中每一个key-value键值对都会生成一个文件,key为文件名,value为内容,

volumes: # 定义磁盘给上面volumeMounts挂载

- name: log-cache

emptyDir: {}

- name: sdb #挂载宿主机上面的目录

hostPath:

path: /any/path/it/will/be/replaced

- name: example-volume-config # 供ConfigMap文件内容到指定路径使用

configMap:

name: example-volume-config #ConfigMap中名称

items:

- key: log-script #ConfigMap中的Key

path: path/to/log-script #指定目录下的一个相对路径path/to/log-script

- key: backup-script #ConfigMap中的Key

path: path/to/backup-script #指定目录下的一个相对路径path/to/backup-script

- name: nfs-client-root #供挂载NFS存储类型

nfs:

server: 10.42.0.55 #NFS服务器地址

path: /opt/public #showmount -e 看一下路径

- name: rbd-pvc #挂载PVC磁盘

persistentVolumeClaim:

claimName: rbd-pvc1 #挂载已经申请的pvc磁盘手撕deployment类型资源的配置文件

1)查看需要哪些字段

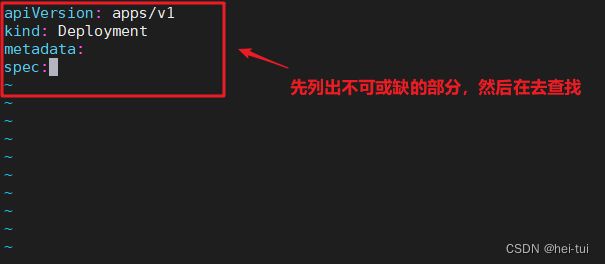

kubectl explain deployment2)紧接着就找一个空目录进行创建yaml文件

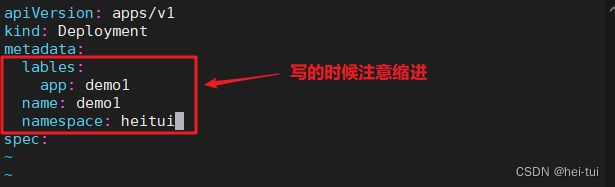

vim demo1.yaml

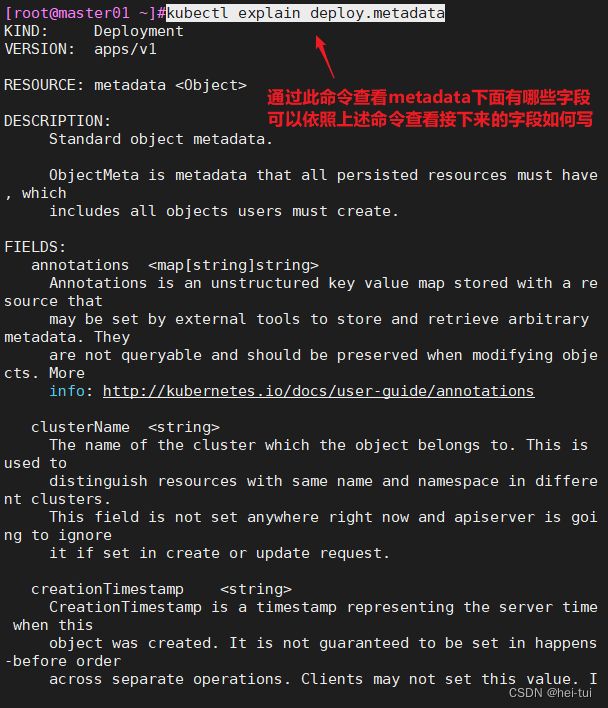

下面列举一些常用的metadata字段下的字段

KIND: Deployment

VERSION: apps/v1

RESOURCE: metadata 列举spec下常用的字段

KIND: Deployment #deployment资源是Pod控制器,管理无状态应用的Pod

VERSION: apps/v1

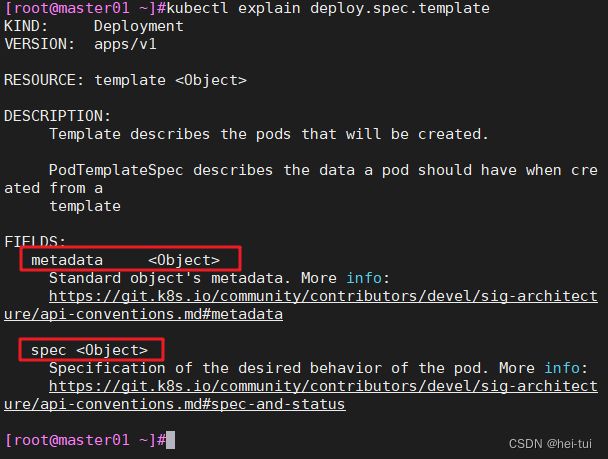

RESOURCE: spec 列举spec字段下的template字段的常用字段

ubectl explain deploy.spec.template

kubectl explain deploy.spec.template.spec

可以根据这个格式手撕下面的内容剩下的自己写,这里就不逐一介绍了

2、Pod.yaml详解

//Pod yaml文件详解

apiVersion: v1 #必选,版本号,例如v1

kind: Pod #必选,Pod

metadata: #必选,元数据

name: string #必选,Pod名称

namespace: string #必选,Pod所属的命名空间

labels: #自定义标签

- name: string #自定义标签名字

annotations: #自定义注释列表

- name: string

spec: #必选,Pod中容器的详细定义

containers: #必选,Pod中容器列表

- name: string #必选,容器名称

image: string #必选,容器的镜像名称

imagePullPolicy: [Always | Never | IfNotPresent] #获取镜像的策略:Alawys表示总是下载镜像,IfnotPresent表示优先使用本地镜像,否则下载镜像,Nerver表示仅使用本地镜像

command: [string] #容器的启动命令列表,如不指定,使用打包时使用的启动命令

args: [string] #容器的启动命令参数列表

workingDir: string #容器的工作目录

volumeMounts: #挂载到容器内部的存储卷配置

- name: string #引用pod定义的共享存储卷的名称,需用volumes[]部分定义的的卷名

mountPath: string #存储卷在容器内mount的绝对路径,应少于512字符

readOnly: boolean #是否为只读模式

ports: #需要暴露的端口库号列表

- name: string #端口号名称

containerPort: int #容器需要监听的端口号

hostPort: int #容器所在主机需要监听的端口号,默认与Container相同

protocol: string #端口协议,支持TCP和UDP,默认TCP

env: #容器运行前需设置的环境变量列表

- name: string #环境变量名称

value: string #环境变量的值

resources: #资源限制和请求的设置

limits: #资源限制的设置

cpu: string #Cpu的限制,单位为core数,将用于docker run --cpu-shares参数

memory: string #内存限制,单位可以为Mib/Gib,将用于docker run --memory参数

requests: #资源请求的设置

cpu: string #Cpu请求,容器启动的初始可用数量

memory: string #内存清楚,容器启动的初始可用数量

livenessProbe: #对Pod内个容器健康检查的设置,当探测无响应几次后将自动重启该容器,检查方法有exec、httpGet和tcpSocket,对一个容器只需设置其中一种方法即可

exec: #对Pod容器内检查方式设置为exec方式

command: [string] #exec方式需要制定的命令或脚本

httpGet: #对Pod内个容器健康检查方法设置为HttpGet,需要制定Path、port

path: string

port: number

host: string

scheme: string

HttpHeaders:

- name: string

value: string

tcpSocket: #对Pod内个容器健康检查方式设置为tcpSocket方式

port: number

initialDelaySeconds: 0 #容器启动完成后首次探测的时间,单位为秒

timeoutSeconds: 0 #对容器健康检查探测等待响应的超时时间,单位秒,默认1秒

periodSeconds: 0 #对容器监控检查的定期探测时间设置,单位秒,默认10秒一次

successThreshold: 0

failureThreshold: 0

securityContext:

privileged:false

restartPolicy: [Always | Never | OnFailure] #Pod的重启策略,Always表示一旦不管以何种方式终止运行,kubelet都将重启,OnFailure表示只有Pod以非0退出码退出才重启,Nerver表示不再重启该Pod

nodeSelector: obeject #设置NodeSelector表示将该Pod调度到包含这个label的node上,以key:value的格式指定

imagePullSecrets: #Pull镜像时使用的secret名称,以key:secretkey格式指定

- name: string

hostNetwork:false #是否使用主机网络模式,默认为false,如果设置为true,表示使用宿主机网络

volumes: #在该pod上定义共享存储卷列表

- name: string #共享存储卷名称 (volumes类型有很多种)

emptyDir: {} #类型为emtyDir的存储卷,与Pod同生命周期的一个临时目录。为空值

hostPath: string #类型为hostPath的存储卷,表示挂载Pod所在宿主机的目录

path: string #Pod所在宿主机的目录,将被用于同期中mount的目录

secret: #类型为secret的存储卷,挂载集群与定义的secre对象到容器内部

scretname: string

items:

- key: string

path: string

configMap: #类型为configMap的存储卷,挂载预定义的configMap对象到容器内部

name: string

items:

- key: string3、service.yaml详解

Service yaml文件详解

apiVersion: v1

kind: Service

matadata: #元数据

name: string #service的名称

namespace: string #命名空间

labels: #自定义标签属性列表

- name: string

annotations: #自定义注解属性列表

- name: string

spec: #详细描述

selector: [] #label selector配置,将选择具有label标签的Pod作为管理

#范围

type: string #service的类型,指定service的访问方式,默认为

#clusterIp

clusterIP: string #虚拟服务地址

sessionAffinity: string #是否支持session

ports: #service需要暴露的端口列表

- name: string #端口名称

protocol: string #端口协议,支持TCP和UDP,默认TCP

port: int #服务监听的端口号

targetPort: int #需要转发到后端Pod的端口号

nodePort: int #当type = NodePort时,指定映射到物理机的端口号

status: #当spce.type=LoadBalancer时,设置外部负载均衡器的地址

loadBalancer: #外部负载均衡器

ingress: #外部负载均衡器

ip: string #外部负载均衡器的Ip地址值

hostname: string #外部负载均衡器的主机名