汽车ISP的“去留”之谜

前段时间,网络上关于特斯拉要“拿掉”ISP(图像信号处理器)的讨论一石激起千层浪,实际上背后是多方角力的现状。

以手机行业为例,除了高通等SoC芯片自带ISP外,近年来,不少手机厂商也都在自研高性能ISP,目的是增加手机拍照的效果,从而树立品牌差异化。

不过,高通也表示,这种情况不会持续多久,很快都会被自家的新技术替代。比如,高通通过对最新一代骁龙8 Gen1芯片中的ISP进一步优化,单颗摄像头最高可支持2亿像素。

在汽车行业,同样存在摄像头和ECU/域控制器上的SoC两端内置ISP的状态。而不管是CMOS、独立ISP、AI芯片还是SoC厂商,都在争夺ISP的制高点。而CMOS+ISP是传统汽车级摄像头的主流配置。

但这种情况正在发生改变。

典型的案例,就是Mobileye从EyeQ4到EyeQ5的升级。传统智能摄像头前视一体机模式更多是仰仗摄像头侧的初始图像处理,而进入多摄像头的域控制器时代,ISP迁移至高算力SoC的趋势已经明确。

比如,Mobileye最新发布的三款芯片中,EyeQ6H和EyeQ Ultra都搭载了Arm最新一代ISP(Mali-C78AE),而单独用于前视摄像头的EyeQ4M升级版EyeQ6L则没有搭载ISP。

一、一场ISP主动权的争夺战

众所周知,ISP图像处理器主要使用硬件结构完成图像传感器输入的图像视频源RAW格式数据的前处理,可转换为多种格式,还可以完成图像缩放、自动曝光、自动白平衡、自动聚焦等工作。

这意味着,ISP承担了非常重要的任务并直接后端图像处理的性能“天花板”。过去,在智能驾驶领域,ISP的调优技术含量极高,除了一些第三方工具,ISP工程师起到关键的作用,涉及算法能力、硬件知识和编程能力。

而对于智能驾驶系统来说,基于摄像头的视觉感知准确性仍然是一个巨大的挑战。一些专业机构指出,目前,行业内视觉ADAS系统开发仍然依赖于对ISP的人工调教,这种方法可能需要几个月的时间,并且需要工程师有非常深厚的专业知识,很多时候依赖于主观判断。

实际上,特斯拉仍在大量招聘图像质量调教工程师,重要的职责就是调教图像信号处理器(ISP)和相机参数,保证在各种光照条件下获得最佳质量的图像。

按照Arm公司的说法,未来很长一段时间内,ISP需要同时为驾驶员和系统提供图像处理能力。比如,在低速环视/周视、电子后视镜等应用场景,人机交互仍是主要诉求。

这家公司是在2016年通过收购成像技术开发商Apical进入汽车ISP赛道,并在一年后推出针对汽车领域应用的首款ISP:Mali-C71,像素吞吐量1.2GPixels/秒,最多可同时支持四个4K分辨率的摄像头,并允许配置多个ISP来协同工作满足多摄像头需求。

背后的驱动力,来自于降低辅助驾驶系统的BoM成本。

比如,R-Car Gen3是瑞萨在2018年推出的汽车计算平台,其中,入门级的R-Car V3M就内置了图像信号处理 (ISP) ,支持前视及环视“卫星”(拿掉ISP)摄像头配置,并通过SoC对CAN-FD、Flexray 和以太网总线的支持,降低BoM成本。

而在摄像头侧,传统摄像头都是RAW方案,需要搭配独立的ISP使用,现在则越来越多集成为SoC方案,实际上背后是CMOS厂商对ISP的争夺战。

比如,豪威科技在2019年推出的OX01F10(集成CMOS和ISP的SoC),支持高达120dB,达到ASIL-B安全级别。今年初,该公司又推出全新OX03D SoC,从100万像素升级到300万像素分辨率。

OX03D4C搭载了一个全集成图像信号处理器(ISP),能够实现140dB的高动态范围(HDR),此外还采用了下一代色调映射算法,并拥有业界领先的LED闪烁抑制(LFM)功能,预计今年第四季度将实现量产。

类似的ISP二合一车规级CMOS图像传感器也正在成为市场的主流,比如,CMOS图像传感器国产供应商思特威科技,在去年也推出了片上ISP二合一图像传感器SC120AT,可对RAW图数据进行优化处理并输出优质的YUV 422格式视频影像。

与此同时,在大算力SoC方面,芯片厂商也在加紧提升ISP的性能。

由于基于域控制器的多感知数据(前)融合趋势明确,各家芯片厂商都在尝试如何帮助客户实现全面覆盖各类道路、交通场景,针对不同光线、天气等驾驶环境,在动态多变的复杂驾驶条件下,充分发挥摄像头性能,确保数据准确严谨,使成像达到最优效果。

比如,今年2月,自动驾驶主流算力平台供应商英伟达与诚迈科技正式签署合作协议,授权后者为智能驾驶相关客户提供基于NVIDIA DRIVE Orin及Xavier等系统级芯片产品的量产级别ISP(图像信号处理)服务。

而作为大算力SoC的主要IP核供应商,Arm还在全新一代Mali-C78AE ISP开发的性能指标上下足了功夫。除了可以处理四个实时摄像头或十六个虚拟摄像头的图像数据,还增加了硬件安全机制与软件诊断功能,可以防止或检测出单个摄像头中存在的传感器故障等问题。

二、ISP,从硬到软

实际上,ISP的另外一条发展路线,则是增加AI处理能力,同时也是提升SoC的ISP处理能力。这也是为什么此前在手机行业,很多厂商选择自研,就是因为高通的嵌入式ISP性能不足。

比如,安霸在今年初推出了全新AI图像信号处理器(AISP),使用神经网络技术来增强硬件ISP集成到SoC中的图像处理能力,可以在极低的照度和最小的噪声下实现低光下的彩色成像,比主流ISP性能提升10到100倍,并具有更自然的颜色再现和更高的动态范围处理能力。

从成本角度来说,AISP把全色夜视作为关键卖点,更好的低光性能和HDR可以减少系统对外部照明条件的依赖,同时可以使用更低成本的摄像头。

同时,整套系统可以实现在不同光照条件之间的无缝切换,包括白天、夜晚和高动态范围场景;此外,可以实现与安霸的CVflow引擎的其他AI算法并行运行,从而实现与SoC的完美集成。

目前,该公司最新推出的AI域控制器芯片CV3系列(等效算力高达500TOPS)就已经搭载AISP,可同时支持20路以上摄像头通过MIPI VC方式连接,只需单颗芯片即可处理全套传感器,并且可以满足高性能双目立体视觉引擎和稠密光流引擎的要求。

而作为国内最早推出自研架构的ISP芯片厂商,华为海思也在去年推出了提供AI处理能力的新一代ISP(越影®智能图像处理引擎),不过初期主要用于物联网智能终端。在该公司看来,ISP输出图像质量决定着“看得懂”的天花板。

比如,利用神经网络深度学习海量低照度场景图片的噪声和信号的分布特性,华为海思训练出一套智能降噪的算法模型,让越影®AI ISP能智能区分图像中的信号和噪声,实现低照度场景下的智能降噪。

从官方披露的信息来看,未来汽车智能驾驶领域的应用也将是这套全新AI ISP引擎的用武之地。尤其是车辆进出隧道口时,由于内外光强反差巨大,如何快速跟踪不断变化的光线,并准确对目标进行自适应曝光,是对自动和辅助驾驶安全非常重要的技术。

测试数据显示,越影®相比海思上一代ISP,在逆光场景下动态范围可提升12dB,并且对场景跟踪更迅速,能够有效避免图像画面瞬间过暗或过曝,在3帧以内即收敛至稳定状态。

这些做法的目的也很一致,就是在弱光、恶劣天气以及特殊条件下,解决目前摄像头感知能力的缺陷。而在传统ISP中引入AI概念,则可以通过不断训练提升ISP的性能,并将传统关键的硬件模块转化为软件定义模式。

这一策略,实际上也得到了英伟达的认同。

众所周知,传统图像信号处理(ISP)仍然面临性能问题,这是因为之前的性能“天花板”建立在传统硬件框架上。此外,不少用户并不能真正发挥SoC上的ISP能力,原本可以增加AI模型的性能表现。

此外,这些预先开发的硬ISP,无法有效的进行个性化调整(难度也不小),也永远无法升级。去年,一家名为Visionary.ai的以色列软件公司就推出了一套软件ISP工具,基于AI技术大幅提高图像和视频的质量,并检测每帧中的每个细节。

另一家名为Algolux的计算机视觉和图像优化解决方案提供商,也将计算成像技术(CIT)导入汽车ISP领域,也就是在传统成像技术中引入信息处理方法,改变传统光学成像单一依靠线性光学信息传递理论的瓶颈。

这也被称为,下一代软件ISP的“新”能力。

因为,硬ISP是由工程师撰写的代码,特斯拉称之为软件1.0。人工智能增强的ISP,也被称为软件2.0,不是由工程师决定,而是由AI技术进行不断迭代优化。事实上,这也是此前马斯克“怼”ISP的关键点之一。

三、协同提升

事实上,考虑到ISP硬件的迭代需要更加长期的技术投入,而软实力的提升,更加符合目前行业现状,尤其是视觉AI处理能力的“前置”。

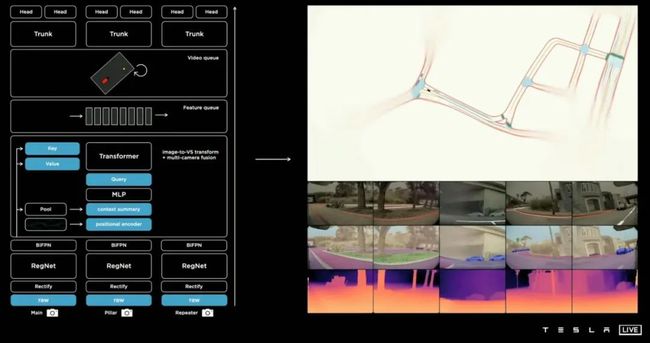

去年,特斯拉中国曾组织了一场线下技术交流活动,首次解读如何用纯视觉技术实现自动驾驶的整体架构,涉及对数据如何提取、归类和优化,以及向量空间构建等关键点。

这套方案包括几个处理步骤:

1、多机位相机拍摄到不同角度的图像RAW文件,然后直接经过RegNet网络(某种卷积神经网络)及BiFPN(加强特征提取)进行特征提取。

2、经过Transformer进行特征融合及MLP的特征修正,将特征数据重新表示到向量空间中,并在时间和空间上形成一个特征队列。

3、通过队列的方式获得Video的特征,加入IMU数据,形成4D影像;再经过Spatial RNN进行特征提取;最终再经过不同的检测头实现车辆、行人、车道线、深度图、速度/方向等检测。

而Algolux公司给出的解决方案,也非常类似。就是不采用传统的硬ISP图像处理器,而是采用RAW传感器数据作为输入,然后通过端到端深度神经网络融合和处理数据。

这家公司也给出了和此前特斯拉摄像头+雷达感知方案的效果对比。由于基于端到端架构+逐帧检测模型,这套解决方案提供了高达3倍(较传统方案)的精度感知,特别是在低光和恶劣天气条件下。

原因是,目前基于传统摄像头的视觉系统存在固有的鲁棒性限制,而这种端到端学习架构将图像生成与视觉任务相结合来解决这个问题,通过无监督和自监督学习,在短短几天内自动调整系统的图像处理能力。

这意味着,传统物理分隔的光学设计、图像处理和视觉感知处理可以实现端到端的模型训练,从而达到高效的实时处理性能。

“我们的软ISP现在提供的最好结果,是在0.1 lux(被拍摄主体表面单位面积上垂直照射到的光通量)以下,可以在几乎完全黑暗的情况下检测全色图像和视频。”在Visionary.ai公司看来,传统硬ISP架构则需要长时间曝光的图像检测,而我们可以实现视频级检测。

而最优的方式,或许是软硬件能力的协同提升。这是近几年全球范围内出现不少ISP硬件及软件方案厂商收购案的驱动因素之一。

实际上,我们从高通最新发布的应用于手机行业的Snapdragon 8 Gen 1的全新ISP(Snapdragon Sight品牌)看出一些端倪。这颗ISP每秒可以处理32亿像素(上一代是27亿像素),每秒捕捉240张1200万像素的照片,是上一代的两倍。

高通对ISP进行了重新的硬件设计,将每通道的位宽从14位提高到18位,大幅提升动态范围处理能力,同时可以输出未经压缩的18位RAW数据。此外,高通还提供AI软件引擎用于图像的自动曝光和自动对焦。

而目前已经进入上车阶段的高通骁龙Ride智能驾驶计算平台,搭载的则是上一代14位Spectra图像信号处理(ISP),提供三重并发和三重并行处理功能。接下来,随着车载摄像头像素继续提升(乃至从800万往千万级别发展),不排除更多用于手机的ISP升级至车规。

事实上,ISP的预处理不仅影响传统算法的有效性,也影响基于深度学习的计算机视觉算法的有效性。而且,随着SoC性能变得越来越强大,与继续依赖独立的图像信号处理器相比,将图像信号处理功能进行集成变得越来越可行。

此外,神经网络加速器也是一种极具吸引力的候选技术,可以用于额外执行图像信号处理功能,而这些功能以前通常是由独立的ISP处理。一些企业也提出,未来ISP和CNN的功能可以合并成一个统一的NNA。

上图是Imagination公司给出的一个示例。比如,NNA将首先提供RGB输出供驾驶员查看(比如,需要人工监控的功能),然后进一步处理(在相同或不同的NNA上)供计算机视觉系统使用。

实际上,正如马斯克对于传统ISP处理的“否定”,独立ISP和视觉处理SoC的传统组合应该重新评估。ISP的功能可以直接在NNA上实现,也可以训练成在NNA上执行的CNN。“这种重新设计的架构,最终的系统级成本都比传统架构要低得多。”

或许,这才是我们需要正视的ISP“变革”。