Super Yolo论文翻译

论文:SuperYOLO: Super Resolution Assisted Object Detection in Multimodal Remote Sensing Imagery【IEEE】

论文地址:

IEEE Xplore Full-Text PDF:![]() https://ieeexplore.ieee.org/stamp/stamp.jsp?tp=&arnumber=10075555项目地址:icey-zhang/SuperYOLO: SuperYOLO (github.com)

https://ieeexplore.ieee.org/stamp/stamp.jsp?tp=&arnumber=10075555项目地址:icey-zhang/SuperYOLO: SuperYOLO (github.com)![]() https://github.com/icey-zhang/SuperYOLO

https://github.com/icey-zhang/SuperYOLO

DOI:

10.1109/TGRS.2023.3258666![]() https://doi.org/10.1109/TGRS.2023.3258666

https://doi.org/10.1109/TGRS.2023.3258666

摘要

1、介绍

2、相关工作

A. 用多模态数据进行物体检测

B. 物体检测中的超分辨率

3、基线结构

4、SuperYOLO架构

A. 去除焦点

B. 多模态融合

C. 超分辨率

D. 损失函数

5、实验结果

A. 数据集

B. 实施细节

C. 准确度指标

D. 消融研究

1) 基准框架的验证

摘要

从遥感图像(RSI)中准确、及时地检测包含几十个像素的多尺度小物体仍然是一个挑战。大多数现有的解决方案主要是设计复杂的深度神经网络来学习与背景分离的物体的强大特征表示,这往往导致沉重的计算负担。

在这篇文章中,我们提出了一种准确而快速的RSI物体检测方法,名为SuperYOLO,它融合了多模态数据,通过利用辅助的超级分辨率(SR)学习并考虑检测精度和计算成本,对多尺度物体进行高分辨率(HR)检测。

- 首先,我们利用对称紧凑的多模态融合(MF),从各种数据中提取补充信息,以提高RSI中的小物体检测。

- 此外,我们设计了一个简单而灵活的SR分支来学习HR特征表征,该表征可以从低分辨率(LR)输入的广阔背景中区分出小物体,从而进一步提高检测精度。

- 此外,为了避免引入额外的计算,在推理阶段舍弃了SR分支,并且由于LR输入,网络模型的计算量减少。

实验结果表明,在广泛使用的VEDAI RS数据集上,SuperYOLO实现了75.09%的准确率(以mAP50计),比SOTA大型模型,如YOLOv5l、YOLOv5x和RS设计的YOLOrs高10%以上。同时,SuperYOLO的参数大小和GFLOPs比YOLOv5x少了约18倍和3.8倍。与最先进的模型相比,我们提出的模型显示了有利的精度-速度权衡。

1、介绍

物体检测在涉及计算机辅助诊断或自主驾驶的各个领域发挥着重要作用。在过去的几十年里,许多优秀的基于深度神经网络(DNN)的物体检测框架[1], [2], [3], [4], [5]已经在计算机视觉领域被提出、更新和优化。基于DNN的物体检测框架的显著准确性提升归功于具有准确注释的大规模自然数据集的应用[6], [7], [8]。

与自然场景相比,在遥感图像(RSI)中进行准确的物体检测存在几个重要的挑战。首先,标记样本的数量相对较少,这限制了DNNs的训练以达到高检测精度。其次,RSI中物体的大小要小得多,相对于复杂而宽广的背景,只占几十个像素[9], [10]。此外,这些物体的尺度是多种多样的,有多种类别[11]。如图1(a)所示,在一个广阔的区域内,物体汽车是相当小的。如图1(b)所示,物体有大规模的变化,其中汽车的规模比野营车的规模小。

图1.RGB图像、红外图像和地面真相(GT)的视觉比较。红外图像为解决RGB检测中的难题提供了重要的补充信息。(a)中的物体在广大区域内相当小。在(b)中,物体有大规模的变化,其中汽车的规模比野营车的规模小。RGB和红外模式的融合有效地提高了检测性能。

图1.RGB图像、红外图像和地面真相(GT)的视觉比较。红外图像为解决RGB检测中的难题提供了重要的补充信息。(a)中的物体在广大区域内相当小。在(b)中,物体有大规模的变化,其中汽车的规模比野营车的规模小。RGB和红外模式的融合有效地提高了检测性能。

目前,大多数物体检测技术都是针对单一模式设计和应用的,如红绿蓝(RGB)和红外(IR)[12], [13]。因此,在物体检测方面,由于不同模式之间缺乏互补信息,其识别地球表面物体的能力仍然不足[14]。随着成像技术的发展,从多模态收集的RSI变得可用,并提供了一个提高检测精度的机会。例如,如图1所示,两种不同的多模态(RGB和IR)的融合可以有效提高RSI的检测精度。有时,一种模式的分辨率较低,这就需要通过技术来提高分辨率以增强信息。最近,超级分辨率(SR)技术在遥感领域显示出巨大的潜力[15], [16], [17], [18]。受益于卷积神经元网络(CNN)的蓬勃发展,遥感图像的分辨率已经实现了高纹理信息的解读。然而,由于CNN网络的计算成本较高,SR网络在实时实际任务中的应用已成为当前研究的一个热门话题。

在这项研究中,我们的动机是为多模态RSI提出一个机载实时物体检测框架,以实现高检测精度和高推理速度,而不引入额外的计算开销。

- 受最近实时紧凑型神经网络模型进展的启发,我们选择小尺寸的YOLOv5s[19]结构作为我们的检测基准。它可以降低部署成本,促进模型的快速部署。

- 考虑到小物体的高分辨率(HR)保留要求,我们删除了基线YOLOv5s模型中的Focus模块,这不仅有利于定义小密集物体的位置,而且还能提高检测性能。

- 考虑到不同模式的互补特性,我们提出了一个多模式融合(MF)方案来提高RSI的检测性能。我们评估了不同的融合方案(像素级或特征级),并选择像素级融合以降低计算成本。

最后,也是最重要的一点,我们开发了一个SR保证模块,以指导网络产生能够识别广大背景中的小物体的HR特征,从而减少RSI中由背景污染的物体引起的误报。尽管如此,一个天真的SR解决方案会大大增加计算成本。因此,我们在训练过程中设置了辅助的SR分支,并在推理阶段将其删除,在不增加计算成本的情况下促进了HR中的空间信息提取。

综上所述,本文有以下贡献。

- 我们提出了一种便于计算的像素级融合方法,以对称和紧凑的方式双向结合内部信息。与特征级融合相比,它有效地降低了计算成本而不牺牲精度。

- 我们首次在多模态物体检测中引入了一个辅助的SR分支。我们的方法不仅在有限的检测性能上有所突破,而且为研究优秀的HR特征表征铺平了一条更灵活的道路,这些特征表征能够在低分辨率(LR)输入下将小物体从广阔的背景中区分出来。

- 考虑到对高质量结果和低计算成本的需求,作为辅助任务的SR模块在推理阶段被移除,而没有引入额外的计算。SR分支是通用的和可扩展的,可以插入到现有的全卷积网络(FCN)框架中。

- 所提出的SuperYOLO明显提高了物体检测的性能,在实时多模态物体检测中优于SOTA检测器。与最先进的模型相比,我们提出的模型显示了有利的精度-速度权衡。

2、相关工作

A. 用多模态数据进行物体检测

最近,多模态数据在许多实际应用场景中被广泛利用,包括视觉问题回答[20]、自动驾驶汽车[21]、显著性检测[22]和遥感分类[23]。人们发现,结合多模态数据的内部信息可以有效地传递互补的特征,避免单一模态的某些信息被遗漏。

在RSI处理领域,存在来自不同传感器的各种模式(例如,RGB、合成孔径雷达(SAR)、光探测和测距(LiDAR)、红外、全色(PAN)和多光谱(MS)图像),这些模式可以融合互补的特征,以提高各种任务的性能[24], [25], [26]。例如,额外的红外模式[27]捕获较长的热能波长,以改善困难天气条件下的检测。Manish等人[27]提出了一个用于多模态遥感成像中物体检测的实时框架,其中扩展版进行了中层融合并合并了来自多种模态的数据。尽管多传感器融合可以提高检测性能,如图1所示,但其低精度的检测性能和有待提高的计算速度很难满足实时检测任务的要求。

融合方法主要分为三种策略,即像素级融合、特征级融合和决策级融合方法[28]。决策级融合方法在最后阶段对探测结果进行融合,由于对不同的多模态分支进行重复计算,可能会消耗巨大的计算资源。在遥感领域,主要采用多分支的特征级融合方法。多模态图像将被输入到平行分支中,以提取不同模态各自独立的特征,然后通过一些操作,如关注模块或简单串联,将这些特征结合起来。并行分支会随着模态的增加而带来重复计算,这对遥感领域的实时任务来说是不友好的。

相比之下,采用像素级融合方法可以减少不必要的计算。在本文中,我们提出的SuperYOLO在像素级融合了各种模式,大大降低了计算成本,并在空间域和信道域设计操作,提取不同模式中的内在信息,这有助于提高检测精度。

B. 物体检测中的超分辨率

在最近的文献中,小物体检测的性能可以通过多尺度特征学习[29]、[30]和基于上下文的检测[31]来提高。这些方法总是增强网络在不同尺度上的信息表示能力,但却忽略了人力资源方面的信息保留。在预处理步骤中进行,SR已被证明在各种物体检测任务中是有效和高效的[32], [33]。

- Shermeyer和Van Etten[34]通过多种分辨率的RSI量化了其对卫星成像的检测性能的影响。

- 基于生成对抗网络(GANs),Courtrai等人[35]利用SR生成HR图像,这些图像被送入检测器以提高其检测性能。

- Rabbi等人[36]利用拉普拉斯算子从输入图像中提取边缘,以增强重建HR图像的能力,从而提高其在物体定位和分类中的性能。

- Ji等人[37]引入了一个周期一致的GAN结构作为SR网络,并修改了更快的R-CNN架构,以从SR网络产生的增强图像中检测车辆。

在这些工作中,采用SR结构有效地解决了有关小物体的挑战。然而,与单一检测模型相比,引入了额外的计算,这归因于HR设计的输入图像的放大比例。

最近,Wang等人[38]提出了一个SR模块,它可以用LR输入保持HR表示,同时减少分割任务中的模型计算。受Wang等人[38]的启发,我们设计了一个SR辅助的分支。与上述工作中的SR在开始阶段实现不同,辅助的SR模块指导检测器学习高质量的HR表征,这不仅加强了对小的密集物体的响应,也提高了空间中物体检测的性能。此外,在推理阶段,SR模块被移除,以避免额外的计算。

3、基线结构

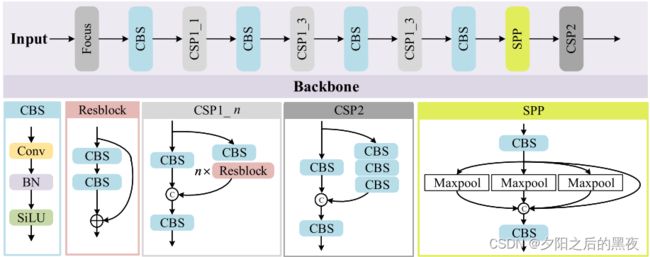

如图2所示,基线YOLOv5网络包括两个主要部分:主干和头部(包括颈部)。骨干网被设计用来提取低级纹理和高级语义特征。接下来,这些提示特征被馈送到头部,以构建增强的特征金字塔网络,从上到下传递稳健的语义特征,从下到上传播局部纹理和图案特征的强烈反应。这就解决了物体的各种尺度问题,产生了对不同尺度检测的增强。

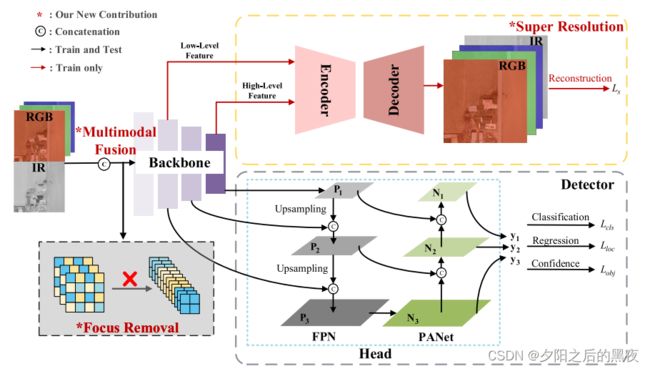

图2.拟议的SuperYOLO框架的概述。我们的新贡献包括: 1)去除Focus模块以保留HR;2)MF;以及3)辅助SR分支。该架构在SR分支的均方误差(mse)损失和物体检测的特定任务损失方面进行了优化。在训练阶段,SR分支指导空间维度的相关学习,以加强骨干的HR信息保存。在测试阶段,SR分支被移除,以加快推理速度,使之与基线持平。

图2.拟议的SuperYOLO框架的概述。我们的新贡献包括: 1)去除Focus模块以保留HR;2)MF;以及3)辅助SR分支。该架构在SR分支的均方误差(mse)损失和物体检测的特定任务损失方面进行了优化。在训练阶段,SR分支指导空间维度的相关学习,以加强骨干的HR信息保存。在测试阶段,SR分支被移除,以加快推理速度,使之与基线持平。

在图3中,CSPNet[39]被用作提取特征信息的骨干,由许多样本卷积-批量归一化-SiLu(CBS)组件和交叉阶段部分(CSP)模块组成。CBS由卷积、批量归一化和激活函数SiLu的操作组成[40]。CSP将上一层的特征图复制成两个分支,然后通过1×1卷积将通道数减半,因此计算量减少。对于特征图的两份副本,一份被连接到阶段的末端,另一份被送入ResNet块或CBS块作为输入。最后,这两份特征图被串联起来,以合并特征,之后是CBS块。空间金字塔池(SPP)模块[41]由不同内核大小的并行maxpool层组成,用来提取多尺度的深度特征。通过堆叠的CSP、CBS和SPP结构提取低级纹理和高级语义特征。

图3.YOLOv5s的骨干结构。通过堆叠的CSP、CBS和SPP结构来提取低级纹理和高级语义特征。

图3.YOLOv5s的骨干结构。通过堆叠的CSP、CBS和SPP结构来提取低级纹理和高级语义特征。

限制1:值得一提的是,引入Focus模块是为了减少计算的数量。如图2(左下角)所示,输入被分割成单个像素,每隔一段时间进行重建,最后在通道维度上进行连接。输入被调整到一个较小的规模,以减少计算成本,加快网络训练和推理速度。然而,这可能会在一定程度上牺牲物体检测的准确性,特别是对于容易受到分辨率影响的小物体。

限制2:众所周知,YOLO的骨干采用深度卷积神经网络来提取分层特征,其步长为2,通过它提取的特征大小减半。因此,为多尺度检测保留的特征尺寸远远小于原始输入图像的尺寸。例如,当输入图像大小为608时,最后一个检测层的输出特征大小分别为76、38和19。LR特征可能会导致一些小物体的丢失。

4、SuperYOLO架构

如图2所示,我们为SuperYOLO网络结构引入了三个新的贡献。

- 首先,我们删除了骨干网中的Focus模块,用MF模块代替,以避免分辨率下降,从而避免精度下降。

- 其次,我们探索了不同的融合方法,并选择了计算效率高的像素级融合方法来融合RGB和IR模式,以细化不同的互补信息。

- 最后,我们在训练阶段增加了一个辅助的SR模块,它重建了HR图像,以指导空间维度上的相关骨干学习,从而保持HR信息。

- 在推理阶段,SR分支被丢弃,以避免引入额外的计算开销。

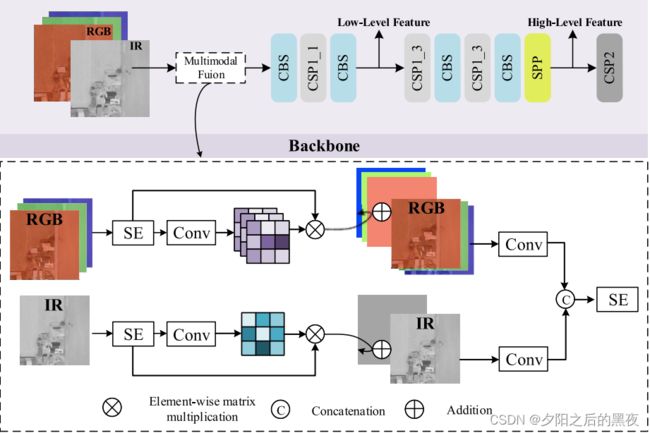

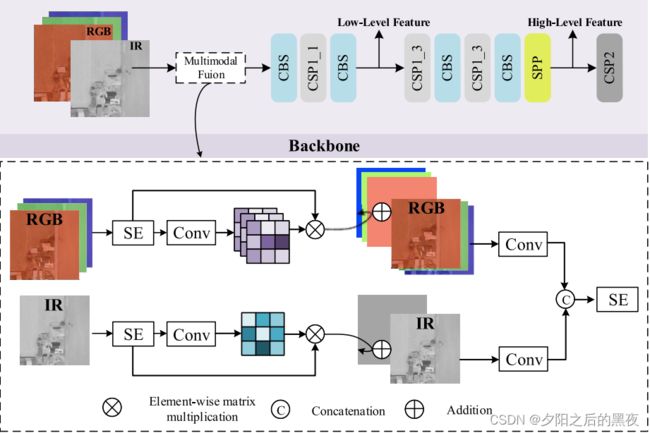

A. 去除焦点

如第三节和图2(左下)所示,YOLOv5骨干网中的Focus模块在空间域上以一定的间隔分割图像,然后重新组织新的图像,调整输入图像的大小。具体来说,这个操作是为图像中的每一组像素收集一个值,然后重建它,以获得更小的互补图像。重建的图像的大小随着通道数的增加而减少。因此,它对小目标造成了分辨率下降和空间信息损失。考虑到对小目标的探测更依赖于更高的分辨率,因此放弃了Focus模块,代之以MF模块(如图4所示)以防止分辨率下降。

图4.像素级的MF模块的结构。

图4.像素级的MF模块的结构。

元素间的矩阵相乘、连接、加法

B. 多模态融合

利用越多的信息来区分物体,物体检测的性能就越好。融合是合并来自各种传感器的不同信息的有效途径。决策级融合、特征级融合和像素级融合是三种主流的融合方法,可以部署在网络的不同深度。由于决策级融合需要巨大的计算量,所以在SuperYOLO中没有考虑它。

我们提出了一个像素级的MF,从不同的模态中提取共享和特殊的信息。MF可以以对称和紧凑的方式双向结合多模态的内部信息。如图4所示,对于像素级融合,我们首先将输入的RGB图像和输入的IR图像规范化为两个[0,1]的区间。输入模式![]() ,

,![]()

![]()

![]() 子采样为

子采样为![]() ,

,![]()

![]()

![]() ,它们被送入SE块,在通道域提取内部信息[42],生成

,它们被送入SE块,在通道域提取内部信息[42],生成![]() 、

、![]()

![]()

然后,揭示空间领域中不同模式的内在关系的注意图被定义为

![]()

其中![]() 和

和![]() 分别代表RGB和IR模式的1×1卷积。这里,⊗表示逐元矩阵乘法。不同模态之间的内部空间信息是通过以下方式产生的

分别代表RGB和IR模式的1×1卷积。这里,⊗表示逐元矩阵乘法。不同模态之间的内部空间信息是通过以下方式产生的

![]()

为了纳入内部的内视信息和空间纹理信息,特征是由原始输入模式添加的,然后送入1×1卷积。完整的特征是

![]()

其中![]() 和

和![]() 代表1×1卷积。最后,这些特征通过以下方式进行融合

代表1×1卷积。最后,这些特征通过以下方式进行融合

![]()

汇总一下:

其中Concat(⋅)表示沿通道轴的串联操作。然后将结果送入骨干网,产生多级特征。注意,![]() 被子采样为原始图像的1/n大小,以完成IV-C节中讨论的SR模块,并加速训练过程。

被子采样为原始图像的1/n大小,以完成IV-C节中讨论的SR模块,并加速训练过程。![]() 代表RGB或IR模式,采样的图像表示为

代表RGB或IR模式,采样的图像表示为![]() ,产生的结果是

,产生的结果是

![]()

其中D(⋅)表示使用双线性插值的n次下采样操作。

C. 超分辨率

如第三节所述,在骨干网中为多尺度检测保留的特征尺寸远远小于原始输入图像的尺寸。大多数现有的方法都是通过上采样操作来恢复特征大小。不幸的是,由于纹理和图案的信息损失,这种方法产生了有限的成功,这说明采用这种操作来检测RSI中需要保留HR的小目标是不合适的。

为了解决这个问题,如图2所示,我们引入了一个辅助的SR分支。首先,引入的分支应有利于提取骨干网中的HR信息,并达到令人满意的性能。其次,该分支不应增加更多的计算量以降低推理速度。它应该在推理阶段实现准确性和计算时间之间的权衡。受Wang等人[38]的研究启发,其中提出的SR成功地促进了分割任务,而没有额外的要求,我们在框架中引入了一个简单而有效的分支,名为SR。我们的建议可以提高检测精度,而不需要计算和内存过载,特别是在LR输入的情况下。

具体来说,SR结构可以被看作是一个简单的编码-解码模型。我们选择骨干的低级和高级特征,分别融合局部纹理和模式以及语义信息。如图4所示,我们分别选择第四和第九个模块的结果作为低级和高级特征。编码器将骨干网中产生的低级特征和高级特征进行整合。

图4.像素级的MF模块的结构。

图4.像素级的MF模块的结构。

元素间的矩阵相乘、连接、加法

如图5所示,在编码器中,第一个CR模块是针对低级特征进行的。对于高层次特征,我们使用上采样操作来匹配低层次特征的空间大小,然后,我们使用串联操作和两个CR模块来合并低层次和高层次特征。CR模块包括一个卷积和ReLU。对于解码器,LR特征被放大到HR空间,其中SR模块的输出尺寸比输入图像的尺寸大一倍。如图5所示,解码器是用三个去卷积层实现的。SR引导空间维度的相关学习并将其转移到主分支,从而提高物体检测的性能。此外,我们引入EDSR[43]作为我们的编码器结构,以探索SR的性能及其对检测性能的影响。

图5.SuperYOLO的SR结构。SR结构可以被看作是一个简单的编码-解码模型。主干的低级和高级特征被选择来分别融合局部纹理模式和语义信息。

图5.SuperYOLO的SR结构。SR结构可以被看作是一个简单的编码-解码模型。主干的低级和高级特征被选择来分别融合局部纹理模式和语义信息。

为了呈现一个更直观的可解释的描述,我们在图6中可视化了YOLOv5s、YOLOv5x和SuperYOLO的骨架特征。为便于比较,这些特征被放大到与输入图像相同的比例。通过比较图6中(c)、(f)和(i);(d)、(g)和(j);以及(e)、(h)和(k)的成对图像,可以看出SuperYOLO在SR的帮助下包含了更清晰的物体结构,分辨率更高。最终,我们在高质量的HR表示中得到了SR分支的丰收,并利用YOLOv5的头部来检测小物体。

图6.YOLOv5s、YOLOv5x和SuperYOLO在相同输入下的特征级可视化:(a)RGB输入,(b)IR输入,(c)-(e)YOLOv5s的特征,(f)-(h)YOLOv5x的特征,以及(i)-(k)SuperYOLO的特征。为便于比较,这些特征被放大到与输入图像相同的比例。(c), (f), and (i) 第一层的特征。(d), (g), and (j) 低层特征。(e), (h), and (k) 同一深度的各层的高层次特征。

图6.YOLOv5s、YOLOv5x和SuperYOLO在相同输入下的特征级可视化:(a)RGB输入,(b)IR输入,(c)-(e)YOLOv5s的特征,(f)-(h)YOLOv5x的特征,以及(i)-(k)SuperYOLO的特征。为便于比较,这些特征被放大到与输入图像相同的比例。(c), (f), and (i) 第一层的特征。(d), (g), and (j) 低层特征。(e), (h), and (k) 同一深度的各层的高层次特征。

D. 损失函数

我们网络的总体损失由两部分组成:检测损失![]() 和SR构建损失

和SR构建损失![]() ,可以表示为

,可以表示为

![]()

其中![]() 和

和![]() 是平衡两个训练任务的系数。L1损失(而不是L2损失)[44]被用来计算输入图像

是平衡两个训练任务的系数。L1损失(而不是L2损失)[44]被用来计算输入图像![]() 和SR结果之间的SR构造损失

和SR结果之间的SR构造损失![]() ,其表达式写为

,其表达式写为

![]()

检测损失包括三个部分[19]:判断是否有物体的损失![]() ,物体位置的损失

,物体位置的损失![]() ,以及物体分类的损失

,以及物体分类的损失![]() ,用来评估预测的损失为

,用来评估预测的损失为

![]()

其中,![]() 代表头部的输出层;

代表头部的输出层;![]() ,

, ![]() ,

, ![]() 是三个损失函数的不同层的权重;权重

是三个损失函数的不同层的权重;权重![]() ,

, ![]() ,

, ![]() 调节箱体坐标、箱体尺寸、物体性、无物体性和分类之间的误差重点。

调节箱体坐标、箱体尺寸、物体性、无物体性和分类之间的误差重点。

5、实验结果

A. 数据集

实验中使用了流行的航空图像中的车辆检测(VEDAI)数据集[45],它包含从更大的犹他州自动地理参考中心(AGRC)数据集中获得的裁剪过的图像。在AGRC中从同一高度采集的每张图像大约有16000×16000像素,每个像素的分辨率大约为12.5cm×12.5cm。在同一场景中,RGB和IR是每个图像的两种模式。VEDAI数据集由1246张较小的图像组成,主要是涉及草地、高速公路、山脉和城市地区的不同背景。所有图像的尺寸为1024×1024或512×512。任务是检测11类不同的车辆,如汽车、皮卡、野营车和卡车。

B. 实施细节

我们提出的框架是在PyTorch中实现的,并在一个装有NVIDIA 3090 GPU的工作站上运行。VEDAI数据集被用来训练我们的SuperYOLO。按照[27],VEDAI数据集被设计为十倍交叉验证。在每次分割中,1089张图像被用于训练,另外121张图像被用于测试。消融实验是在第一折数据上进行的,而与以前的方法的比较则是在十折数据上通过对其结果进行平均来进行。图像中每个物体的注释包含边界框中心的坐标、物体关于正X轴的方向、边界框的四个角、类别ID、一个识别物体是否被遮挡的二进制标志,以及另一个识别物体是否被裁剪的二进制标志。我们不考虑数据集中少于50个实例的类,如飞机、摩托车和公共汽车。因此,VEDAI数据集的注释被转换为YOLOv5格式,我们将感兴趣的类的ID转为0,1,...,7,即N=8。然后,界线盒的中心坐标被归一化,绝对坐标被转换为相对坐标。同样地,界线盒的长度和宽度也被归一化为[0,1]。为了实现SR辅助分支,在训练过程中,网络的输入图像从1024×1024大小降采样到512×512。在测试过程中,图像大小为512×512,这与其他算法的输入比较一致。此外,数据被增加了色相饱和度值(HSV)、多尺度、平移、左右翻转和镶嵌。增强策略在测试阶段被取消了。标准的随机梯度下降法(SGD)[46]被用来训练网络,动量为0.937,使用的Nesterov加速梯度的权重衰减为0.0005,批次大小为2。整个训练过程涉及300个epochs。

C. 准确度指标

准确度评估衡量检测结果与参考掩码之间的一致和差异。召回率、精度和平均值平均精度(mAP)被用作准确度指标,以评估要与之比较的方法的性能。精度和召回率指标的计算方法定义为

![]()

![]()

其中TP和TN表示正确的预测,FP和FN表示错误的结果。

指标含义:

TP (True Positive) : 可以理解为把框分对了,被分为正样本,本身也是正样本(本身是正样本还是负样本是通过IOU值与阈值比对来判定)。

TN(True Negative): 可以理解为把框分对了,被分为负样本,本身也是负样本。(该指标没有意义,一般不用)

FP(False Positive):可以理解为把框分错了,被分为正样本,但是本身是负样本。

FN(False Negative): 可以理解为把框分错了,被分为负样本,但是本身是正样本。(也就是说该真实目标没有被检测出来)。

精度和召回率分别与委托和遗漏错误相关。mAP是通过平均AP值得到的一个综合指标,它采用积分法计算所有类别的精确-召回曲线和坐标轴所包围的面积。因此,mAP的计算方法是

其中![]() 表示精度,

表示精度,![]() 表示召回率,

表示召回率,![]() 是类别的数量。

是类别的数量。

每秒千兆浮点运算(GFOLPs)和参数大小被用来衡量模型的复杂性和计算成本。此外,PSNR和SSIM被用于SR分支的图像质量评估。一般来说,较高的PSNR值和SSIM值代表了生成图像的质量较好。

D. 消融研究

首先,我们通过设计一系列的消融实验来验证我们所提出的方法的有效性,这些实验是在验证集的第一折上进行的。

1) 基准框架的验证

在表一中,不同基础框架的模型大小和推理能力是以层数、参数大小和GFLOPs来评价的。这些模型的检测性能是由mAP50来衡量的,即mAP在intersection over union(IOU)=0.5的检测指标。尽管YOLOv4实现了最好的检测性能,但它比YOLOv5s多了169层(393对224),其参数大小(params)是YOLOv5s的7.4倍(52.5M对7.1M),而且其GFLOPs是YOLOv5s的7.2倍(38.2对5.3)。就YOLOv5s而言,虽然其mAP略低于YOLOv4和YOLOv5m,但其层数、参数大小和GFLOPs都比其他模型小很多。因此,在实际应用中,更容易在船上部署YOLOv5s来实现实时性能。上述事实验证了YOLOv5s作为基线检测框架的合理性。

表一:不同基线YOLO框架在VEDAI验证集第一层的模型规模和推理能力的比较结果

表一:不同基线YOLO框架在VEDAI验证集第一层的模型规模和推理能力的比较结果