分布式计算、云计算与大数据 第十一章

分布式计算、云计算与大数据 第十一章

- 大数据技术

-

- 大数据技术概述

- 大数据存储平台

- HBash简介

-

- HBash的特性

- MongoDB

-

- MongoDB的功能

- MongoDB数据组织形式

- MapReduce

-

- 执行流程

- MapReduce的优缺点

大数据技术

大数据技术概述

大数据的“大”是相对而言的,是指所处理的数据规模巨大到无法通过目前主流数据库软件工具,在可以接受的时间内完成抓取、储存、管理和分析,并从中提取出人类可以理解的资讯。

业界普遍认同大数据具有4个 V特征(数据量大Volume、变化速度快Velocity、多类型Variety与高价值Value)。简而言之,大数据可以被认为是数据量巨大且结构复杂多变的数据集合。

第一个特征Volume是大数据的首要特征,数据体量巨大。当今世界需要进行及时处理以提取有用信息的数据数量级已经从TB级别,跃升到PB甚至EB级别。

第二个特征Variety:数据类型繁多。大数据的挑战不仅是数据量的大,也体现在数据类型的多样化。除了前文提到的网络日志、地理位置信息等具有固定结构的数据之外,还有视频、图片等非结构化数据。

第三个特征Velocity:处理速度快。信息的价值在于及时,超过特定时限的信息就失去了使用的价值。

最后一个特征是Value:商业价值高,但是价值密度低。单个数据的价值很低,只有大量数据聚合起来处理才能借助历史数据预测未来走势,体现出大数据计算的价值所在。

大数据存储平台

HDFS(全称Hadoop Distributed File System)原是Apache开源项目Nutch的组件,现在成为是Hadoop的重要组件,它是一款具有高容错性特点的分布式文件系统,它被设计为可以部署在造价低廉的主机集群上。它将一个大文件拆分成固定大小的小数据块,分别存储在集群的各个节点上。因此HDFS可以存储超大的数据集和单个巨大的文件。这样的分布式结构能够进行不同节点的并行读取,提高了系统的吞吐率。同一个数据块存储在不同的数据节点上,保证了HDFS在节点失败时还能继续提供服务,使其具有了容错性。

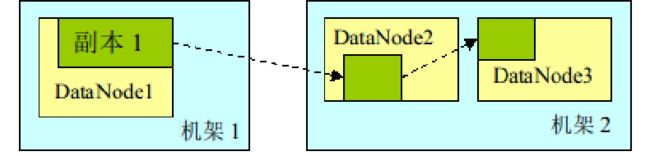

HDFS副本放置策略对于HDFS可靠性和性能至关重要。副本放置策略关系到数据的可靠性、可用性和网络带宽的利用率。对于副本放置策略的优化让HDFS在分布式文件系统中脱颖而出,这一调优是需要大量实践经验作为依托的。

HDFS采用基于机架感知的副本放置策略,将副本存放在不同的机架上,即第一个副本放在客户本地节点上,另外两个副本随机放置在远程机架上,这样可以防止当某个机架失效时数据的丢失,如图12-2所示。在一个数据中心中往往不只有一个机架,对于大部分数据中心来说,不同机架上节点之间的通信需要经过多个交换机,其带宽比相同机架节点之间的通信带宽要小。因此,基于机架感知的副本放置策略可以在网络带宽和数据可靠性之间取得平衡。

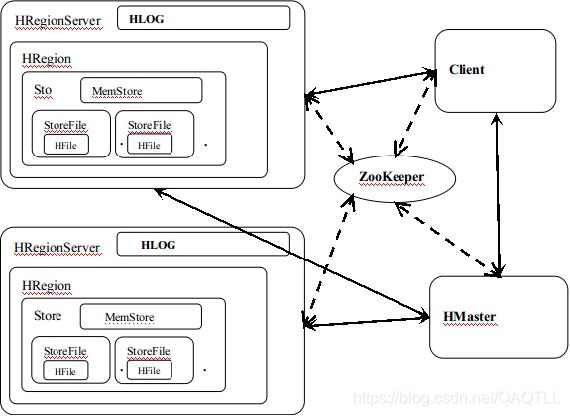

HBash简介

Apache HBase是运行于Hadoop平台上的数据库,它是可扩展的、分布式的大数据储存系统。HBase可以对大数据进行随机而实时的读取和写入操作。它的目标是在普通的机器集群中处理巨大的数据表,数据表的行数和列数都可以达到百万级别。受到Google Bigtable 思想启发,Apache开发出HBase, HBase是一个开源的、分布式的、数据多版本储存的、面向列的大数据储存平台。Google的Bigtable是运行于GFS(Google File System)上的,而HBase是运行与Apache开发的Hadoop平台上。

HBash的特性

HBase的特性包括:

1)线性和模块化的扩展性;

2)严格的读写一致性;

3)自动且可配置的数据表分片机制;

4)RegionServer之间可以进行热备份切换;

5)为MapReduce操作HBase数据表提供方便JAVA基础类;

6)易用的JAVA客户端访问API;

7)支持实时查询的数据块缓存和模糊过滤;

8)提供Trift网关和REST-ful Web服务,并支持XML,Protobuf和二进制编码;

9)可扩展的Jrubyshell;

10)支持通过Hadoop检测子系统或JMX导出检测数据到文件、Ganglia集群检测系统。

MongoDB

MongoDB 是一个面向集合的,模式自由的文档型数据库。

在数据库里每个聚集有一个唯一的名字,可以包含无限个文档。聚集是RDBMS中表的同义词,区别是聚集不需要进行模式定义。

特点:

面向文档存储

高效的传统存储方式:支持二进制数据及大型对象(如照片和频)。

复制及自动故障转移

Auto-Sharding自动分片支持云级扩展性

动态查询

全索引支持

多语言支持。

易存储复杂的文件类型;

模式自由

支持完全索引,包含内部对象。

MongoDB的功能

查询:基于查询对象或者类SQL语句搜索文档。查询结果可以排序,进行返回大小限制,可以跳过部分结果集,也可以返回文档的一部分。

插入和更新:插入新文档,更新已有文档。

索引管理:对文档的一个或者多个键(包括子结构)创建索引,删除索引等等。

常用命令:所有MongoDB 操作都可以通过socket传输的DB命令来执行。

MongoDB适用于:

适合实时的插入,更新与查询

适合由数十或数百台服务器组成的数据库

网站数据

适合作为信息基础设施的缓存层

大尺寸,低价值的数据

用于对象及JSON数据的存储

不适用于:1)高度事务性的系统;2)传统的商业智能应用;3)极为复杂的SQL查询;4)高度事务性的系统:例如银行或会计系统。传统的关系型数据库目前还是更适用于需要大量原子性复杂事务的应用程序;5)传统的商业智能应用:针对特定问题的BI数据库会对产生高度优化的查询方式。

MongoDB数据组织形式

MongoDB组织数据的方式如下:Key-Value对 > 文档 > 集合 > 数据库。

多个Key-Value对组织起来形成类似于JSON格式的文档,多个文档组织成为一个集合,多个集合组织起来,就形成了数(database)。单个MongoDB实例可以使用多个数据库

MapReduce

MapReduce是Google公司提出的一种用于大规模数据集(大1TB)的并行运算的编程模型。

软件实现

指定一个Map(映射)函数,用来把一组键值对映射成一组新的键值对,

指定并发的Reduce(归纳)函数,用来保证所有映射的键值对中的每一个共享相同的键组。

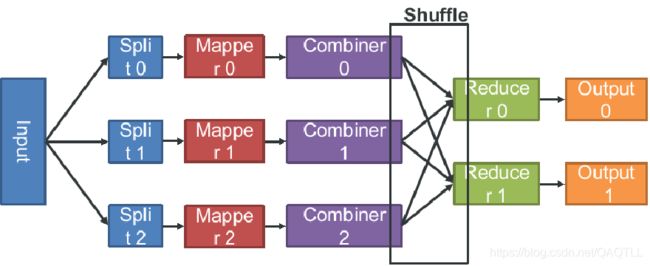

执行流程

(1)数据分片

(2)Master分配Map任务

(3)分配了map任务的worker读取和处理相关split的内容

(4)Master协调分配reducer到相应Mapper获取数据,期间称为Shuffle,包括一个按Key排序过程。

(5)Reducer对每个Key相应的Value列表进行读取并处理

(6)Reducer将处理后的文件写入HDFS输出文件

MapReduce的优缺点

优点:

1、移动计算而不是移动数据,避免了额外的网络负载。

2、任务之间相互独立,实现高容错性。

3、理想状态下可线性扩展的,是为便宜的商业机器而设计的计算模型。

4、MapReduce模型结构简单,终端用户至少只需编写Map和Reduce函数。

5、集群扩展代价曲线平坦。

局限:

1、一个中心用于同步各个任务。

2、用MapReduce模型来实现常见的数据库连接操作效率低下。

3、MapReduce集群管理、调试、部署以及日志收集工作困难。

4、单个Master节点有单点故障的可能性。

5、当中间结果必须给保留的时候,作业的管理并不简单。

6、对于集群的参数配置调优需要较多经验。