ASG:手动扩展、计划扩展、动态扩展。动态扩展保护一下扩展策略:

1,Amazon EC2 Auto Scaling supports the following types of scaling policies:

- Target tracking scaling - Increase or decrease the current capacity of the group based on a target value for a specific metric. This is similar to the way that your thermostat maintains the temperature of your home – you select a temperature and the thermostat does the rest.

- Step scaling - Increase or decrease the current capacity of the group based on a set of scaling adjustments, known as step adjustments, that vary based on the size of the alarm breach.

- Simple scaling - Increase or decrease the current capacity of the group based on a single scaling adjustment.

扩展策略类型

Amazon EC2 Auto Scaling 支持以下类型的扩展策略:

-

目标跟踪扩展 — 根据特定指标的目标值增加或减少组的当前容量。它的工作方式类似于您家中负责控制温度的恒温器 - 您只需选择一个温度,恒温器会替您完成所有其他工作。

-

分步扩展 — 根据一组扩展调整,增加或减小组的当前容量,这些调整称为分步调整,将根据警报严重程度发生变化。

-

简单扩展 — 根据一个扩展调整值增加或减小当前组容量。

2,You have the following options for protecting data at rest in Amazon S3 数据加密:

Use Server-Side Encryption – You request Amazon S3 to encrypt your object before saving it on disks in its data centers and decrypt it when you download the objects.

Use Client-Side Encryption – You can encrypt data client-side and upload the encrypted data to Amazon S3. In this case, you manage the encryption process, the encryption keys, and related tools.

- Data at rest inside the volume

- All data moving between the volume and the instance

- All snapshots created from the volume

- All volumes created from those snapshots

在创建加密的 EBS 卷并将其附加到支持的实例类型后,将对以下类型的数据进行加密:

-

卷中的静态数据

-

在卷和实例之间移动的所有数据

-

从卷创建的所有快照

-

从这些快照创建的所有卷

加密操作在托管 EC2 实例的服务器上进行,用于确保静态数据安全性以及在实例和其附加的 EBS 存储之间传输的数据的安全性。

您可以加密 EC2 实例的引导卷和数据卷。

4,AWS Database Migration Service 可帮助您快速并安全地将数据库迁移至 AWS。源数据库在迁移过程中可继续正常运行,从而最大程度地减少依赖该数据库的应用程序的停机时间。AWS Database Migration Service 可以在广泛使用的开源商业数据库之间迁移您的数据。

AWS Database Migration Service 支持同构迁移(例如从 Oracle 迁移至 Oracle),以及不同数据库平台之间的异构迁移(例如从 Oracle 或 Microsoft SQL Server 迁移至 Amazon Aurora)。借助 AWS Database Migration Service,您可以持续地以高可用性复制数据,并通过将数据流式传输到 Amazon Redshift 和 Amazon S3,将数据库整合到 PB 级的数据仓库中。

5,AWS Systems Manager Run Command lets you remotely and securely manage the configuration of your managed instances. A managed instance is any Amazon EC2 instance or on-premises machine in your hybrid environment that has been configured for Systems Manager. Run Command enables you to automate common administrative tasks and perform ad hoc configuration changes at scale. You can use Run Command from the AWS console, the AWS Command Line Interface, AWS Tools for Windows PowerShell, or the AWS SDKs. Run Command is offered at no additional cost.

借助 AWS Systems ManagerRun Command,您可以通过安全方式远程管理托管实例的配置。托管实例 是混合环境中已经针对 Systems Manager 配置的任意 Amazon EC2 实例或本地计算机。利用 Run Command,您可以自动完成常用管理任务以及大规模执行临时配置更改。您可以从 AWS 控制台、AWS Command Line Interface、AWS Tools for Windows PowerShell或 AWS 开发工具包使用 Run Command。Run Command 不另外收费。

6,Amazon SQS 可见性超时 VisibilityTimeout

当使用者接收并处理来自某个队列的消息时,消息将保留在该队列中。Amazon SQS 不会自动删除消息。因为 Amazon SQS 是分布式系统,所以无法保证使用者实际收到消息(例如,由于连接问题或由于使用者应用程序问题)。因此,使用者在接收和处理消息后必须从队列中删除该消息。

在收到消息后,消息将立即保留在队列中。为防止其他使用者再次处理消息,Amazon SQS 设置了可见性超时,这是 Amazon SQS 防止其他使用者接收和处理消息的时间段。消息的默认可见性超时为 30 秒。最小值为 0 秒。最大值为 12 小时。

7,AWS CloudHSM 服务通过在 AWS 云中使用专用的硬件安全模块 (HSM) 实例,帮助您满足企业、合同和监管合规性要求,以确保数据安全。AWS 和 AWS Marketplace 合作伙伴为保护 AWS 平台中的敏感数据提供了多种解决方案,但对于某些受管理加密密钥合同或监管要求约束的应用程序和数据,可能有必要提供额外的保护。CloudHSM 可补充现有的数据保护解决方案,让您可以在 HSM 内保护您的加密密钥,HSM 依据安全密钥管理的政府标准进行设计并经过验证。借助 CloudHSM,您可以安全地生成、存储和管理用于数据加密的加密密钥,使其只能由您访问。Attempting to log in as the administrator more than twice with the wrong password zeroizes your HSM appliance. When an HSM is zeroized, all keys, certificates, and other data on the HSM is destroyed. You can use your cluster's security group to prevent an unauthenticated user from zeroizing your HSM.

Amazon does not have access to your keys nor to the credentials of your Hardware Security Module (HSM) and therefore has no way to recover your keys if you lose your credentials. Amazon strongly recommends that you use two or more HSMs in separate Availability Zones in any production CloudHSM Cluster to avoid loss of cryptographic keys.

8,AWS CloudFormation 是一种让开发人员和企业都能轻松创建相关 AWS 资源集合,并按顺序和可预测的方式对其进行预配置的服务。

模板包含几个主要部分。Resources 部分是唯一的必需部分。模板中的某些部分可以任何顺序显示。但是,在您构建模板时,使用以下列表中显示的逻辑顺序可能会很有用,因为一个部分中的值可能会引用上一个部分中的值。

- Format Version(可选)

-

模板符合的 AWS CloudFormation 模板版本。模板格式版本与 API 或 WSDL 版本不同。模板格式版本可独立于 API 和 WSDL 版本,进行独立更改。

Description (可选)

-

一个描述模板的文本字符串。此部分必须始终紧随模板格式版本部分之后。

元数据(可选)

-

提供有关模板的其他信息的对象。

Parameters(可选)

-

要在运行时 (创建或更新堆栈时) 传递到模板的值。您可引用模板的

Resources和Outputs部分中的参数。 Mappings(可选)

-

可用来指定条件参数值的密钥和关键值的映射,与查找表类似。可以通过使用

Resources和Outputs部分中的 Fn::FindInMap 内部函数将键与相应的值匹配。 条件(可选)

-

用于控制是否创建某些资源或者是否在堆栈创建或更新过程中为某些资源属性分配值的条件。例如,您可以根据堆栈是用于生产环境还是用于测试环境来按照条件创建资源。

转换 (可选)

-

对于无服务器应用程序(也称为“基于 Lambda 的应用程序”),指定要使用的 AWS Serverless Application Model (AWS SAM) 的版本。当您指定转换时,可以使用 AWS SAM 语法声明您的模板中的资源。此模型定义您可使用的语法及其处理方式。

您也可以使用

AWS::Include转换来处理与主 AWS CloudFormation 模板分开存储的模板代码段。您可以将代码段文件存储在 Amazon S3 存储桶中,然后在多个模板中重用这些函数。 Resources(必需)

-

指定堆栈资源及其属性,如 Amazon Elastic Compute Cloud 实例或 Amazon Simple Storage Service 存储桶。您可引用模板的

Resources和Outputs部分中的资源。 Outputs(可选)

-

描述在您查看堆栈的属性时返回的值。例如,您可以声明 S3 存储桶名称的输出,然后调用

aws cloudformation describe-stacksAWS CLI 命令来查看该名称。

9,跨 S3 存储类的性能

| S3 标准 | S3 智能分层* | S3 标准 – IA | S3 单区 - IA† | S3 Glacier | S3 Glacier Deep Archive |

|

|---|---|---|---|---|---|---|

| 具有持久性设计 | 99.999999999% (11 个 9) |

99.999999999% (11 个 9) |

99.999999999% (11 个 9) |

99.999999999% (11 个 9) |

99.999999999% (11 个 9) |

99.999999999% (11 个 9) |

| 设计有可用性 | 99.99% | 99.9% | 99.9% | 99.5% | 99.99% | 99.99% |

| 可用性 SLA | 99.9% | 99% | 99% | 99% | 99.9% | 99.9% |

| 可用区 | ≥3 | ≥3 | ≥3 | 1 | ≥3 | ≥3 |

| 每个对象的最低容量费用 | 不适用 | 不适用 | 128KB | 128KB | 40KB | 40KB |

| 最低存储持续时间费用 | 不适用 | 30 天 | 30 天 | 30 天 | 90 天 | 180 天 |

| 检索费用 | 不适用 | 不适用 | 每检索 1GB | 每检索 1GB | 每检索 1GB | 每检索 1GB |

| 首字节延迟 | 毫秒 | 毫秒 | 毫秒 | 毫秒 | 选择分钟或小时 | 选择小时 |

| 存储类型 | 对象 | 对象 | 对象 | 对象 | 对象 | 对象 |

| 生命周期转换 | 是 | 是 | 是 | 是 | 是 | 是 |

10,AWS CloudTrail 是一种 Web 服务,可记录在您账户上进行的活动,并将日志文件传送至您的 Amazon S3 存储桶。

AWS CloudTrail 将仅显示您正在查看的当前区域在过去 90 天的 CloudTrail 事件历史记录结果,您可以在此处查看支持的 AWS 服务。这些事件仅限于管理事件(含创建、修改和删除 API 调用)和账户活动。要获取账户活动(包括所有管理事件、数据事件和只读活动)的完整记录,您需要配置 CloudTrail 跟踪。

通过数据事件,您可以了解对资源本身或在资源内部执行的资源(“数据平面”)操作。数据事件通常是高频率活动,包括诸如 Amazon S3 对象级 API 和 Lambda 函数调用 API 等操作。配置跟踪时,数据事件默认处于禁用状态。若要记录 CloudTrail 数据事件,您必须明确添加您想对其收集活动的受支持的资源或资源类型。与管理事件不同,数据事件会产生额外的成本。

AWS Lambda 数据事件用于记录 Lambda 函数的执行活动。通过 Lambda 数据事件,您可以获取有关 Lambda 函数执行的详细信息,例如,调用 Invoke API 的 IAM 用户或服务、调用时间以及执行的函数。所有的 Lambda 数据事件都提供给 Amazon S3 存储桶和 Amazon CloudWatch Events。您可以使用 AWS CLI 或 AWS CloudTrail 控制台为 AWS Lambda 数据事件启用日志记录,并通过创建新的跟踪或编辑现有跟踪来选择记录哪些 Lambda 函数。

CloudTrail 与 CloudWatch Logs 集成,让您可以将 CloudTrail 捕获的管理事件和数据事件传送到您指定的 CloudWatch Logs 日志组中的 CloudWatch Logs 日志流。

By default, CloudTrail event log files are encrypted using Amazon S3 server-side encryption (SSE). You can also choose to encrypt your log files with an AWS Key Management Service (AWS KMS) key. You can store your log files in your bucket for as long as you want. You can also define Amazon S3 lifecycle rules to archive or delete log files automatically. If you want notifications about log file delivery and validation, you can set up Amazon SNS notifications.

11,EBS 卷类型

-

支持 SSD 的卷针对涉及小型 I/O 的频繁读/写操作的事务性工作负载进行了优化,其中管理性能属性为 IOPS

-

支持 HDD 的卷针对吞吐量 (以 MiB/s 为单位) 是优于 IOPS 的性能指标的大型流式处理工作负载进行了优化。

-

Since HDD volumes cannot be used as a bootable volume

固态硬盘 (SSD) 硬盘驱动器 (HDD) 卷类型 通用型 SSD ( gp2)*预配置 IOPS SSD ( io1)吞吐优化 HDD ( st1)Cold HDD ( sc1)描述 平衡价格和性能的通用 SSD 卷,可用于多种工作负载 最高性能 SSD 卷,可用于任务关键型低延迟或高吞吐量工作负载 为频繁访问的吞吐量密集型工作负载设计的低成本 HDD 卷 为不常访问的工作负载设计的最低成本 HDD 卷 使用案例 -

建议用于大多数工作负载

-

系统启动卷

-

虚拟桌面

-

低延迟交互式应用程序

-

开发和测试环境

-

需要持续 IOPS 性能或每卷高于 16,000 IOPS 或 250 MiB/s 吞吐量的关键业务应用程序

-

大型数据库工作负载,如:

-

MongoDB

-

Cassandra

-

Microsoft SQL Server

-

MySQL

-

PostgreSQL

-

Oracle

-

-

以低成本流式处理需要一致、快速的吞吐量的工作负载

-

大数据

-

数据仓库

-

日志处理

-

不能是启动卷

-

适合大量不常访问的数据、面向吞吐量的存储

-

最低存储成本至关重要的情形

-

不能是启动卷

API 名称 gp2io1st1sc1卷大小 1 GiB - 16 TiB 4 GiB - 16 TiB 500 GiB - 16 TiB 500 GiB - 16 TiB 最大IOPS**/卷 16,000*** 64,000**** 500 250 最大吞吐量/卷 250 MiB/s*** 1,000 MiB/s† 500 MiB/s 250 MiB/s 最大IOPS/实例†† 80,000 80,000 80,000 80,000 最大吞吐量/实例†† 1,750 MiB/s 1,750 MiB/s 1,750 MiB/s 1,750 MiB/s 管理性能属性 IOPS IOPS MiB/s MiB/s *

-

12,Amazon WorkSpaces 是一种托管的、安全的云桌面服务。您可以使用 Amazon WorkSpaces 在几分钟内预配置 Windows 或 Linux 桌面,并快速扩展,从而为全球各地的员工提供数以千计的桌面。您只需要为启动的 WorkSpaces 按月付费或按小时付费。与传统的桌面和本地 VDI 解决方案相比,这样可以节省费用。Amazon WorkSpaces 可帮助您消除管理硬件清单、操作系统版本和补丁以及虚拟桌面基础设施 (VDI) 的复杂性,从而简化您的桌面交付策略。借助 Amazon WorkSpaces,您的用户能够选择运行快速的响应式桌面,该桌面可供他们随时随地从任何受支持的设备进行访问。

Amazon WorkSpaces 提供 Windows 7、Windows 10 或 Amazon Linux 2 桌面体验。您也可以使用自带的 Windows 7 或 Windows 10 桌面,在 Amazon WorkSpaces 上运行这些桌面并保持许可证合规。此外,您可以从 WorkSpaces 中选择多个生产力应用程序包。

您的用户可从任何支持的设备访问其 Amazon WorkSpaces,这些设备包括 Windows 和 Mac 计算机、Chromebook、iPad、Fire 平板电脑、Android 平板电脑,以及 Chrome 和 Firefox Web 浏览器。您的 WorkSpace 预配置好后,请在您的设备上下载客户端即可访问。

13,将 EC2 实例附加到 Auto Scaling 组

Amazon EC2 Auto Scaling 为您提供了一个选项,可通过将一个或多个 EC2 实例附加到现有 Auto Scaling 组来为这些实例启用自动扩展。附加实例后,它们将成为 Auto Scaling 组的一部分。

要附加的实例必须满足以下条件:

-

实例处于

running状态。 -

用于启动实例的 AMI 必须仍然存在。

-

实例不是其他 Auto Scaling 组的成员。

-

实例会启动到您的 Auto Scaling 组中定义的某个可用区。

-

如果 Auto Scaling 组具有附加的传统负载均衡器,则实例和该负载均衡器必须都位于 EC2- 或同一 VPC 中。如果 Auto Scaling 组具有附加的目标组,则实例和负载均衡器必须都位于同一 VPC 中。

14,数据库参数组,DB parameter groups act as a container for engine configuration values that are applied to one or more DB instances.

您通过将数据库实例与参数组关联来管理您的数据库引擎配置。Amazon RDS 使用适用于新创建的数据库实例的默认设置定义参数组。您可以使用自定义设置定义您自己的参数组。然后,您可以修改数据库实例来使用您自己的参数组。

数据库参数组就像是引擎配置值的容器,这些值可应用于一个或多个数据库实例。

如果创建的数据库实例未指定数据库参数组,数据库实例将使用默认的数据库参数组。 每个默认数据库参数组包含数据库引擎默认值和 Amazon RDS 系统默认值,具体根据引擎、计算等级及实例的分配存储空间而定。

15,VPC 终端节点

VPC 终端节点使您能够将 VPC 私密地连接到支持的 AWS 服务和 VPC 终端节点服务(由 PrivateLink 提供支持),而无需 Internet 网关、NAT 设备、VPN 连接或 AWS Direct Connect 连接。VPC 中的实例无需公有 IP 地址便可与服务中的资源通信。VPC 和其他服务之间的通信不会离开 Amazon 网络。VPC 终端节点有两种类型:接口终端节点 和 网关终端节点。创建受支持的服务所需要的 VPC 终端节点 类型。

- 【接口终端节点 (由 AWS PrivateLink 提供支持)】

接口终端节点是具有私有 IP 地址的弹性网络接口,用作发送到受支持的服务的通信的入口点。支持以下服务:

-

Amazon API Gateway

-

Amazon CloudWatch

-

Amazon CloudWatch Events

-

Amazon CloudWatch Logs

-

AWS CodeBuild

-

Amazon EC2 API

-

Elastic Load Balancing API

-

AWS Key Management Service

-

Amazon Kinesis Data Streams

-

Amazon SageMaker 运行时

-

AWS Secrets Manager

-

AWS Service Catalog

-

Amazon SNS

-

AWS Systems Manager

-

其他 AWS 账户托管的终端节点服务

-

支持的 AWS Marketplace 合作伙伴服务

- 【网关终端节点】

网关终端节点是一个网关,作为路由表中的指定路由的目标(用于发送到受支持的 AWS 服务的流量)。支持以下 AWS 服务:

-

Amazon S3

-

DynamoDB

默认情况下,IAM 用户无权使用终端节点。您可以创建一个 IAM 用户策略,向用户授予创建、修改、描述和删除终端节点的权限。对于所有 ec2:*VpcEndpoint* API 操作,或 ec2:DescribePrefixLists 操作,我们目前均不支持资源级权限。无法创建 IAM 策略,向用户授予使用特定终端节点或前缀列表的权限。以下是示例:

{

"Version": "2012-10-17",

"Statement":[{

"Effect":"Allow", "Action":"ec2:*VpcEndpoint*", "Resource":"*" } ] }Take note that your VPC lives within a larger AWS network and the services, such as S3, DynamoDB, RDS and many others, are located outside of your VPC, but still within the AWS network. By default, the connection that your VPC uses to connect to your S3 bucket or any other service traverses the public Internet via your Internet Gateway.

A VPC endpoint enables you to privately connect your VPC to supported AWS services and VPC endpoint services powered by PrivateLink without requiring an internet gateway, NAT device, VPN connection, or AWS Direct Connect connection. Instances in your VPC do not require public IP addresses to communicate with resources in the service. Traffic between your VPC and the other service does not leave the Amazon network.

There are two types of VPC endpoints: interface endpoints and gateway endpoints. You have to create the type of VPC endpoint required by the supported service.

An interface endpoint is an elastic network interface with a private IP address that serves as an entry point for traffic destined to a supported service. A gateway endpoint is a gateway that is a target for a specified route in your route table, used for traffic destined to a supported AWS service. It is important to note that for Amazon S3 and DynamoDB service, you have to create a gateway endpoint and then use an interface endpoint for other services.

16,快照是异步制作的;时间点快照是立即创建的,但在快照完成(当所有已修改数据块都已转移到 Amazon S3 时)之前,其状态为 pending,很多大型初始快照或后续快照(其中的数据块已更改)可能需要几个小时才能完成。执行期间,正在进行的快照不会受到同时发生的卷读写操作的影响。

尽管您可以在某个卷的前一个快照处于 pending 状态时拍摄该卷的快照,但一个卷有多个 pending 快照可能会导致该卷的性能降低,直至这些快照完成。

一个 gp2、io1 或 磁介质 卷最多可有 5 个 pending 快照,而一个 st1 或 sc1 卷只能有 1 个 pending 快照。如果您在尝试给同一个卷创建多个并发快照时收到 ConcurrentSnapshotLimitExceeded 错误,请等待一个或多个 pending 快照完成,然后再为该卷创建另一个快照。从加密卷制作的快照会自动加密。通过加密快照创建的卷也会自动加密。加密卷及所有关联快照中的数据在静态或传输过程中均受到保护。

Snapshots occur asynchronously; the point-in-time snapshot is created immediately, but the status of the snapshot is pending until the snapshot is complete (when all of the modified blocks have been transferred to Amazon S3), which can take several hours for large initial snapshots or subsequent snapshots where many blocks have changed.

While it is completing, an in-progress snapshot is not affected by ongoing reads and writes to the volume hence, you can still use the EBS volume normally.

To fix this, you can increase the message retention period to a maximum of 14 days using the SetQueueAttributes action.

| 标准 队列 | FIFO 队列 |

|---|---|

| 无限吞吐量 – 标准 队列每个 操作支持接近无限的每秒事务数 (TPS)。 至少传送一次 – 消息至少传送一次,但偶尔会传送消息的多个副本。 最大努力排序 – 消息偶尔可能按不同于其发送时的顺序传递。 |

高吞吐量 – 默认情况下,借助批处理,FIFO 队列每秒支持多达 3000 条消息。要请求提高上限,请提交支持请求。 在不使用批处理的情况下,FIFO 队列的每个操作(SendMessage、ReceiveMessage 或 DeleteMessage)每秒最多支持 300 条消息。 仅传输一次处理 – 消息传递一次并在使用者处理并删除它之前保持可用。不会将重复项引入到队列中。 先进先出传递 – 严格保持消息的发送和接收顺序。 |

| 当吞吐量很重要时,请在应用程序之间发送数据,例如:

|

当事件的顺序重要时,请在应用程序之间发送数据,例如:

|

18,Amazon ECS lets you run batch workloads with managed or custom schedulers on Amazon EC2 On-Demand Instances, Reserved Instances, or Spot Instances. You can launch a combination of EC2 instances to set up a cost-effective architecture depending on your workload. You can launch Reserved EC2 instances to process the mission-critical data and Spot EC2 instances for processing non-essential batch jobs.

There are two different charge models for Amazon Elastic Container Service (ECS): Fargate Launch Type Model and EC2 Launch Type Model. With Fargate, you pay for the amount of vCPU and memory resources that your containerized application requests while for EC2 launch type model, there is no additional charge. You pay for AWS resources (e.g. EC2 instances or EBS volumes) you create to store and run your application. You only pay for what you use, as you use it; there are no minimum fees and no upfront commitments.

19, CloudHSM provides a secure key storage in tamper-resistant hardware available in multiple Availability Zones (AZs) and not just on one AZ.

AWS CloudHSM runs in your own Amazon Virtual Private Cloud (VPC), enabling you to easily use your HSMs with applications running on your Amazon EC2 instances. With CloudHSM, you can use standard VPC security controls to manage access to your HSMs.

Your applications connect to your HSMs using mutually authenticated SSL channels established by your HSM client software. Since your HSMs are located in Amazon datacenters near your EC2 instances, you can reduce the network latency between your applications and HSMs versus an on-premises HSM.

AWS manages the hardware security module (HSM) appliance but does not have access to your keys。

- You control and manage your own keys

- Application performance improves (due to close proximity with AWS workloads)

- Secure key storage in tamper-resistant hardware available in multiple Availability Zones (AZs)

- Your HSMs are in your Virtual Private Cloud (VPC) and isolated from other AWS networks.

20,Elastic Load Balancing provides access logs that capture detailed information about requests sent to your load balancer. Each log contains information such as the time the request was received, the client's IP address, latencies, request paths, and server responses. You can use these access logs to analyze traffic patterns and troubleshoot issues.

Access logging is an optional feature of Elastic Load Balancing that is disabled by default. After you enable access logging for your load balancer, Elastic Load Balancing captures the logs and stores them in the Amazon S3 bucket that you specify as compressed files. You can disable access logging at any time.

Elastic Load Balancing 提供了访问日志,该访问日志可捕获有关发送到负载均衡器的请求的详细信息。每个日志都包含信息 (例如,收到请求的时间、客户端的 IP 地址、延迟、请求路径和服务器响应)。您可以使用这些访问日志分析流量模式并解决问题。

访问日志记录是 Elastic Load Balancing 的一项可选功能,默认情况下已禁用此功能。为负载均衡器启用访问日志记录之后,Elastic Load Balancing 捕获日志并将其作为压缩文件存储在您指定的 Amazon S3 存储桶中。您可以随时禁用访问日志记录。

如果为 S3 存储桶启用了使用 Amazon S3 托管加密密钥 (SSE-S3) 的服务器端加密,则每个访问日志文件在存储到 S3 存储桶之前会自动加密,并在您访问它时自动解密。您不需要执行任何操作,因为这与您访问加密的日志文件或未加密的日志文件的方式基本相同。每个日志文件都使用一个唯一密钥进行加密,此密钥本身将使用定期轮换的主密钥进行加密。

21,All of the APIs created with Amazon API Gateway expose HTTPS endpoints only. Amazon API Gateway does not support unencrypted (HTTP) endpoints. By default, Amazon API Gateway assigns an internal domain to the API that automatically uses the Amazon API Gateway certificate. When configuring your APIs to run under a custom domain name, you can provide your own certificate for the domain.

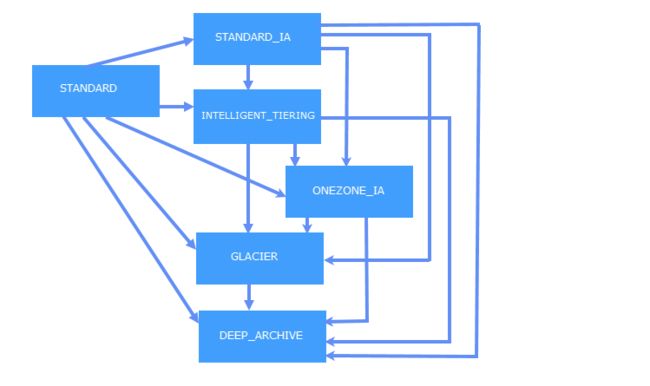

22,S3 生命周期转换对象

Since there is a time constraint in transitioning objects in S3, you can only change the storage class of your objects from S3 Standard storage class to STANDARD_IA or ONEZONE_IA storage after 30 days. This limitation does not apply on INTELLIGENT_TIERING, GLACIER, and DEEP_ARCHIVE storage class.

从 STANDARD 存储类到 STANDARD_IA 或 ONEZONE_IA。以下限制适用:

- 必须在当前存储类中将对象存储至少 30 天,然后才能将对象转换为 STANDARD_IA 或 ONEZONE_IA。例如,您无法创建用于在对象创建 1 天后将其转换为 STANDARD_IA 存储类的生命周期规则。

- Amazon S3 不会在第一个 30 天内转换对象,因为较新的对象的访问频率或删除速度通常高于 STANDARD_IA 或 ONEZONE_IA 存储应有的值。

- 如果您在转换非当前对象 (在受版本控制的存储桶中),则只能将至少在 30 天内是非当前版本的对象转换为 STANDARD_IA 或 ONEZONE_IA 存储。

转换为 GLACIER 和 DEEP ARCHIVE 存储类(对象存档)

23,Quick facts about SQS Long Polling:

- -Long polling helps reduce your cost of using Amazon SQS by reducing the number of empty responses when there are no messages available to return in reply to a ReceiveMessage request sent to an Amazon SQS queue and eliminating false empty responses when messages are available in the queue but aren't included in the response.

- -Long polling reduces the number of empty responses by allowing Amazon SQS to wait until a message is available in the queue before sending a response. Unless the connection times out, the response to the

ReceiveMessagerequest contains at least one of the available messages, up to the maximum number of messages specified in theReceiveMessageaction. - -Long polling eliminates false empty responses by querying all (rather than a limited number) of the servers. Long polling returns messages as soon any message becomes available.