hadoop-3.3.5安装过程

准备资源三台虚拟机:

1)准备3台服务器(关闭防火墙、静态IP、主机名称)

2)安装JDK

3)配置环境变量

4)安装Hadoop

5)配置环境变量

安装虚拟机(略)--1台即可,执行完毕下述内容,再克隆2台。

虚拟机准备完毕,开始安装——

1-通过yum安装epel-release

[root@kk ~]# yum install -y epel-release

注意:如果Linux安装的是最小系统版,还需要安装如下工具;如果安装的是Linux桌面标准版,不需要执行如下操作

Ø net-tool:工具包集合,包含ifconfig等命令,vim:编辑器

[root@kk ~]# yum install -y net-tools

[root@kk ~]#yum install -y vim

2-关闭防火墙,关闭防火墙开机自启

[root@kk ~]# systemctl stop firewalld

[root@kk ~]# systemctl disable firewalld.service

3-创建other用户,并修改other用户的密码

[root@kk ~]# useradd others

[root@kk ~]# passwd others

4-配置others用户具有root权限,方便后期加sudo执行root权限的命令

[root@kk ~]# vim /etc/sudoers

修改/etc/sudoers文件,在%wheel这行下面添加一行,如下所示:

%wheel ALL=(ALL) ALL

others ALL=(ALL) NOPASSWD:ALL

5-在/opt目录下创建文件夹,并修改所属主和所属组

(1)在/opt目录下创建module、software文件夹

[root@kk ~]# mkdir /opt/{module,sofeware}

(2)修改module、software文件夹的所有者和所属组均为others用户

[root@kk ~]# chown others:others /opt/module

[root@kk ~]# chown others:others /opt/software

(3)查看module、software文件夹的所有者和所属组

[root@kk ~]# cd /opt/

[root@kk opt]# ll

6-卸载虚拟机自带的JDK

注意:如果你的虚拟机是最小化安装不需要执行这一步。

[root@kk ~]# rpm -qa | grep -i java | xargs -n1 rpm -e --nodeps

Ø rpm -qa:查询所安装的所有rpm软件包

Ø grep -i:忽略大小写

Ø xargs -n1:表示每次只传递一个参数

Ø rpm -e –nodeps:强制卸载软件

7-重启虚拟机

[root@kk ~]# reboot

8-使用固定IP

1)查看自己主机的IP地址网段和DNS--这一步在自己电脑的网络属性中查看即可

2)修改静态的IP地址

[root@kk ~]# vim /etc/sysconfig/network-scripts/ifcfg-ens33

改成

BOOTPROTO=static

IPADDR=192.168.193.170

GATEWAY=192.168.193.2

DNS1=192.168.193.2

DNS2=8.8.8.8

另外两台的IP地址也如此修改 分别为:192.168.193.176、192.168.193.177

每个人的都不同,自己设置即可。

9-修改主机名,以下以kk 为例子

[root@kk ~]# vim /etc/hostname

hadoop1

配置Linux主机名称映射hosts文件,打开/etc/hosts

[root@hadoop1 ~]# vim /etc/hosts

192.168.193.170 hadoop1

192.168.193.176 hadoop2

192.168.193.177 hadoop3

重启 hadoop1

[root@kk ~]# reboot

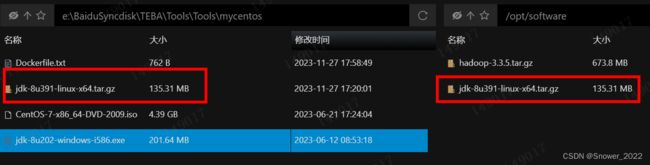

10-将JDK和hadoop 3.3.5 导入到opt目录下面的software文件夹下面

JDK需要到oracle 官方下载-

Java Downloads | Oracle

这里本人下载了 (jdk-8u391-linux-x64.tar.gz)

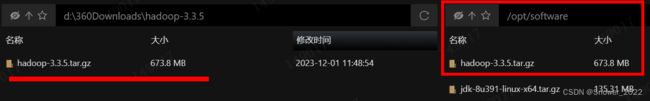

hadoop3.3.5 版本比较稳定,也到官方下载

https://dlcdn.apache.org/hadoop/common/hadoop-3.3.5/hadoop-3.3.5.tar.gz

[root@hadoop1 software]$ ls

hadoop-3.3.5.tar.gz jdk-8u391-linux-x64.tar.gz

11-切换为配置的others 用户来做其他的操作

[root@hadoop1 software]$ su others

[others@hadoop1 software]$ tar -zxvf jdk-8u391-linux-x64.tar.gz -C /opt/module

[others@hadoop1 software]$ tar -zxvf hadoop-3.3.5.tar.gz -C /opt/module

12-配置环境变量

[others@hadoop1 hadoop-3.3.5]$ sudo vim /etc/profile.d/my_env.sh

#JAVA_HOME

export JAVA_HOME=/opt/module/jdk1.8.0_371

export PATH=$PATH:$JAVA_HOME/bin

#HADOOP_HOME

export HADOOP_HOME=/opt/module/hadoop-3.3.5

export PATH=$PATH:$HADOOP_HOME/bin

export PATH=$PATH:$HADOOP_HOME/sbin

配置完毕,需要进行source ,之后配置文件才会生效

[others@hadoop1 hadoop-3.3.5]$ source /etc/profile

若还有问题,直接进行下重启-[others@hadoop1 hadoop-3.3.5]$ sudo reboot

之后进入系统查询 java -version 和 hadoop version

可用后表示已经成功配置。

13-hadoop 文件夹重要目录说明

[others@hadoop2 hadoop-3.3.5]$ ll

total 116

drwxr-xr-x. 2 others others 4096 Mar 16 2023 bin

drwxr-xr-x. 3 others others4096 Mar 15 2023 etc

drwxr-xr-x. 2 others others 4096 Mar 16 2023 include

drwxr-xr-x. 3 others others 4096 Mar 16 2023 lib

drwxr-xr-x. 4 others others 4096 Mar 16 2023 libexec

-rw-rw-r--. 1 others others 24496 Feb 25 2023 LICENSE-binary

drwxr-xr-x. 2 others others 4096 Mar 16 2023 licenses-binary

-rw-rw-r--. 1 others others 15217 Jul 17 2022 LICENSE.txt

-rw-rw-r--. 1 others others 29473 Jul 17 2022 NOTICE-binary

-rw-rw-r--. 1 others others 1541 Apr 22 2022 NOTICE.txt

-rw-rw-r--. 1 others others 175 Apr 22 2022 README.txt

drwxr-xr-x. 3 others others 4096 Mar 15 2023 sbin

drwxr-xr-x. 4 others others 4096 Mar 16 2023 share

drwxrwxr-x. 2 others others 4096 Dec 1 14:24 wcinput(1)bin目录:存放对Hadoop相关服务(hdfs,yarn,mapred)进行操作的脚本

(2)etc目录:Hadoop的配置文件目录,存放Hadoop的配置文件

(3)lib目录:存放Hadoop的本地库(对数据进行压缩解压缩功能)

(4)sbin目录:存放启动或停止Hadoop相关服务的脚本

(5)share目录:存放Hadoop的依赖jar包、文档、和官方案例

Hadoop官方网站:https://hadoop.apache.org/

https://hadoop.apache.org/docs/r3.3.5/hadoop-project-dist/hadoop-common/SingleCluster.html

2)Hadoop运行模式包括:本地模式、伪分布式模式以及完全分布式模式。

Ø 本地模式:单机运行,只是用来演示一下官方案例。生产环境不用。

Ø 伪分布式模式:也是单机运行,但是具备Hadoop集群的所有功能,一台服务器模拟一个分布式的环境。个别缺钱的公司用来测试,生产环境不用。

Ø 完全分布式模式:多台服务器组成分布式环境。生产环境使用。

14-克隆已经部署好的这台资源,修改克隆机的hostname即可。

[root@hadoop1 ~]# vim /etc/hostname

hadoop2

另外一台修改为 hadoop3 即可。

以上就是hadoop 的部署。