人工智能原理复习--不确定推理

文章目录

- 上一篇

- 不确定推理概述

- 主观Bayes(贝叶斯)方法

- 可信度方法

- 证据理论

- 下一篇

上一篇

人工智能原理复习–确定性推理

不确定推理概述

常识具有不确定性。

常识往往对环境有极强的依存性。

其中已知事实和知识是构成推理的两个基本要素,不确定性可以理解为在缺少足够信息的情况下做出判断。

要实现对不确定性知识的处理,要解决:1、不确定知识的表示问题 2、不确定信息的计算问题 3、不确定性表示 4、计算的语义解释问题

解决办法:

-

表示问题:

规则不确定性( E → H , f ( H , E ) E \rightarrow H, f(H, E) E→H,f(H,E))表示知识的不确定性程度

证据不确定性( E , C ( E ) E, C(E) E,C(E)), 证据E为真的程度,由初始证据,和推出揭露为来源 -

计算问题:

指不确定性的传播和更新- 不确定性的传递算法

已知规则E的不确定性C(E) 和规则强度f(H, E) 求C(H)

C ( H ) = f 1 ( C ( E ) , f ( H , E ) ) C(H) = f_1 (C(E), f(H, E)) C(H)=f1(C(E),f(H,E)) - 结论不确定合成

已知两个独立证据 E 1 E_1 E1 和 E 2 E_2 E2 ,求得所求的假设H的不确定性度量C1(H)和 C2(H)求C(H)

C ( H ) = f 2 ( C 1 ( H ) , C 2 ( H ) ) C(H) = f_2 (C1(H), C2(H)) C(H)=f2(C1(H),C2(H)) - 组合证据不确定算法

方法:- 最大最小法

C ( E 1 ∧ E 2 ) = m i n ( C ( E 1 ) , C ( E 2 ) ) C(E1 \land E2) = min( C(E1), C(E2)) C(E1∧E2)=min(C(E1),C(E2))

C ( E 1 ∨ E 2 ) = m a x ( C ( E 1 ) , C ( E 2 ) ) C(E1 \lor E2) = max( C(E1), C(E2)) C(E1∨E2)=max(C(E1),C(E2)) - 概率方法

C ( E 1 ∧ E 2 ) = C ( E 1 ) ∗ C ( E 2 ) C(E1 \land E2) = C(E1) * C(E2) C(E1∧E2)=C(E1)∗C(E2)

C ( E 1 ∨ E 2 ) = C ( E 1 ) + C ( E 2 ) − C ( E 1 ) ∗ C ( E 2 ) C(E1 \lor E2) = C(E1) + C(E2) - C(E1) * C(E2) C(E1∨E2)=C(E1)+C(E2)−C(E1)∗C(E2) - 有界方法

C ( E 1 ∧ E 2 ) = m a x { 0 , C ( E 1 ) + C ( E 2 ) − 1 } C(E1 \land E2) = max\{0, C(E1) + C(E2) - 1 \} C(E1∧E2)=max{0,C(E1)+C(E2)−1}

C ( E 1 ∨ E 2 ) = m i n { 1 , C ( E 1 ) + C ( E 2 ) } C(E1 \lor E2) = min\{1, C(E1) + C(E2) \} C(E1∨E2)=min{1,C(E1)+C(E2)}

- 最大最小法

- 不确定性的传递算法

-

语义问题:

表示问题可以使用概率论或模糊数学

不确定性推理方法分类:

- 在推理一级上拓展不确定性推理的方法(模型方法)

- 在控制策略级处理不确定性的方法(控制方法)

模型方法分为:

- 数值方法, 如概率方法

- 非数值方法,如古典逻辑方法,非单调推理方法

主观Bayes(贝叶斯)方法

传统贝叶斯方法

先验概率:p(事件)在没有知识支持它的出现或不出现的情况下赋给这个事件的概率,即先于证据的概率

后验概率:p(事件 / 证据)给定一些证据的条件下这个实践发生的概率

P ⇒ Q P \Rightarrow Q P⇒Q的不确定表示后验概率 p ( Q / P ) p(Q/P) p(Q/P)

条件概率公式:

p ( Q / P ) = p ( P / Q ) ∗ p ( Q ) p ( P ) p(Q/P) = \frac{p(P/Q)*p(Q)}{p(P)} p(Q/P)=p(P)p(P/Q)∗p(Q)

传统贝叶斯理论需要获取大量样本时间来统计 p ( P ) , p ( Q ) , p ( P / Q ) p(P), p(Q), p(P / Q) p(P),p(Q),p(P/Q)

但是有些同类事件发生的频率不高

主观贝叶斯方法

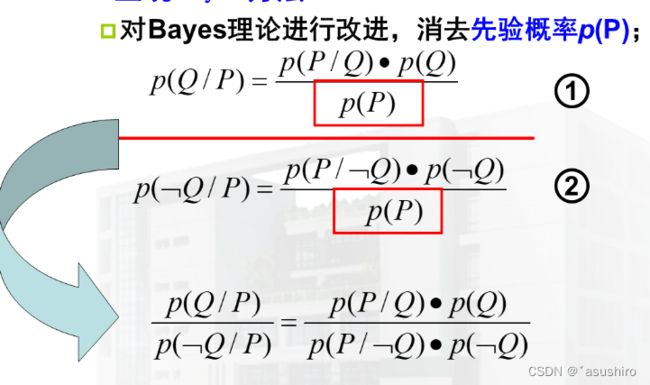

由于传统贝叶斯中的先验概率 p ( P ) p(P) p(P)很难获得,所以要消去 p ( P ) p(P) p(P)

定义先验几率:

Q 的先验几率为 O ( Q ) = p ( Q ) p ( ¬ Q ) Q的先验几率为O(Q) = \frac{p(Q)}{p(\lnot Q)} Q的先验几率为O(Q)=p(¬Q)p(Q)

Q 的后验几率为 O ( Q / P ) = p ( Q / P ) p ( ¬ Q / P ) Q的后验几率为O(Q/P) = \frac{p(Q/P)}{p(\lnot Q/ P)} Q的后验几率为O(Q/P)=p(¬Q/P)p(Q/P)

L S 为充分性因子 = p ( P / Q ) p ( P / ¬ Q ) LS为充分性因子 = \frac{p(P/Q)}{p(P/ \lnot Q)} LS为充分性因子=p(P/¬Q)p(P/Q)

充分因子表示P成立对Q成立的影响力

因此 O ( Q / P ) = L S ∗ O ( Q ) O(Q/P) = LS * O(Q) O(Q/P)=LS∗O(Q)称为Bayes公式的似然形式

同理可以推出:

p ( Q / ¬ P ) p ( ¬ Q / ¬ P ) = p ( ¬ P / Q ) p ( ¬ P / ¬ Q ) ∗ O ( Q ) \frac{p(Q/ \lnot P)}{p(\lnot Q / \lnot P)} = \frac{p(\lnot P /Q)}{p(\lnot P / \lnot Q)} *O(Q) p(¬Q/¬P)p(Q/¬P)=p(¬P/¬Q)p(¬P/Q)∗O(Q)

定义: L N 为必要性因子 = p ( ¬ P / Q ) p ( ¬ P / ¬ Q ) LN为必要性因子 = \frac{p(\lnot P / Q)}{p(\lnot P / \lnot Q)} LN为必要性因子=p(¬P/¬Q)p(¬P/Q)

O ( Q / P ) = L S ∗ O ( Q ) O(Q/P) = LS*O(Q) O(Q/P)=LS∗O(Q)

对LS—充分性因子

- =1时 P对Q无影响

- >1时 P支持Q

- <1时 P不支持Q

表示P成立对Q成立的影响力

O ( Q / ¬ P ) = L N ∗ O ( Q ) O(Q / \lnot P) = LN * O(Q) O(Q/¬P)=LN∗O(Q)

对LN—必要性因子

- =1时 ¬ P \lnot P ¬P对Q无影响

- >1时 ¬ P \lnot P ¬P支持Q

- <1时 ¬ P \lnot P ¬P不支持Q

表示P不成立对Q成立的影响力

而专家系统,基于专家主观估计的LS(和LN)而验算出来的后验概率p(Q/P)称为主观概率。

所以

p ( Q / P ) = L S ∗ O ( Q ) L S ∗ O ( Q ) + 1 = O ( Q / P ) O ( Q / P ) + 1 p(Q/P) = \frac{LS * O(Q)}{LS*O(Q) + 1} =\frac{O(Q/P)}{O(Q/P) + 1} p(Q/P)=LS∗O(Q)+1LS∗O(Q)=O(Q/P)+1O(Q/P)

p ( Q / ¬ P ) = L N ∗ O ( Q ) L N ∗ O ( Q ) + 1 p( Q/ \lnot P) = \frac{LN * O(Q)}{LN*O(Q) + 1} p(Q/¬P)=LN∗O(Q)+1LN∗O(Q)

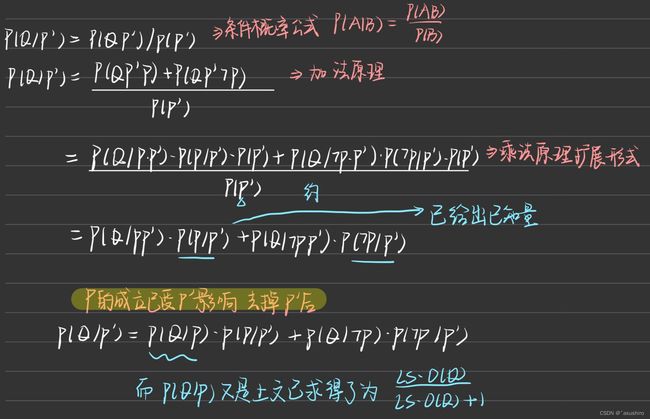

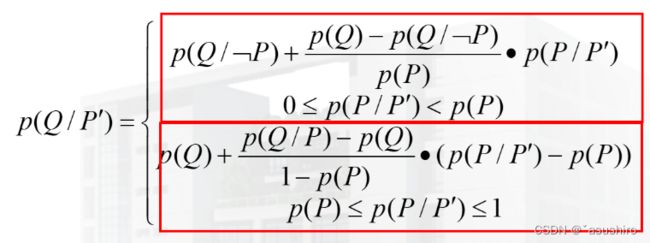

若 P ′ ⇒ P ⇒ Q P' \Rightarrow P \Rightarrow Q P′⇒P⇒Q, 给出 p ( P / P ′ ) p(P/P') p(P/P′), 则我们要求 p ( Q / P ′ ) p (Q/P') p(Q/P′)

- 加法原理:

p ( A ∨ B ) = p ( A ) + p ( B ) p(A \lor B) = p(A) + p(B) p(A∨B)=p(A)+p(B)

p ( Q ) = p ( Q , P ) + p ( Q , ¬ P ) p(Q) = p(Q, P) + p(Q, \lnot P) p(Q)=p(Q,P)+p(Q,¬P) - 乘法原理:

p ( A B ) = p ( A / B ) p ( B ) = p ( B / A ) p ( A ) p(AB) = p(A/B)p(B) = p(B/A)p(A) p(AB)=p(A/B)p(B)=p(B/A)p(A)

扩展形式

p ( A B C ) = p ( A / B C ) p ( B / C ) p ( C ) p(ABC) = p(A/BC)p(B/C)p(C) p(ABC)=p(A/BC)p(B/C)p(C)

同理可以传递更长路径:

P ′ ⇒ P ⇒ Q ⇒ W P' \Rightarrow P \Rightarrow Q \Rightarrow W P′⇒P⇒Q⇒W

p ( W / P ′ ) = p ( W / Q ) ∗ p ( Q / P ′ ) + p ( W / ¬ Q ) ∗ p ( ¬ Q / P ′ ) p(W/P') = p(W/Q)*p(Q/P') + p(W/ \lnot Q)*p(\lnot Q / P') p(W/P′)=p(W/Q)∗p(Q/P′)+p(W/¬Q)∗p(¬Q/P′)

而 p ( Q / P ′ ) = p ( Q / P ) ∗ p ( P / P ′ ) + p ( Q / ¬ P ) ∗ p ( ¬ P / P ′ ) p(Q/P') = p(Q/P)*p(P/P') + p(Q/\lnot P) * p(\lnot P / P') p(Q/P′)=p(Q/P)∗p(P/P′)+p(Q/¬P)∗p(¬P/P′)由上面已知

以此递归可求;

根据 p ( P / P ′ ) 的值, p ( Q / P ′ ) 值也会不同 p(P/P')的值, p(Q/P')值也会不同 p(P/P′)的值,p(Q/P′)值也会不同

但是当 p ( P / P ′ ) 的值位于折点之间时 p(P/P')的值位于折点之间时 p(P/P′)的值位于折点之间时

共有两条直线,而为与这两条直线上时

分段线性插值手段:

不确定性的组合

当多个相互独立的前提 P i P_i Pi支持同一结论Q的情况,表示为:

P 1 ′ ⇒ P 1 ⇒ Q P'_1 \Rightarrow P_1 \Rightarrow Q P1′⇒P1⇒Q

P 2 ′ ⇒ P 2 ⇒ Q P'_2 \Rightarrow P_2 \Rightarrow Q P2′⇒P2⇒Q

有 P 1 ′ P 2 ′ ⇒ Q P'_1P'_2 \Rightarrow Q P1′P2′⇒Q

主观贝叶斯的优点:1. 基于概率模型,具有坚实的理论基础,是目前不确定推理中最成熟的方法之一

缺点:1. 需要大量的概率数据来构造知识库,并且那一解释 2. 要求原始证据具有相互独立性

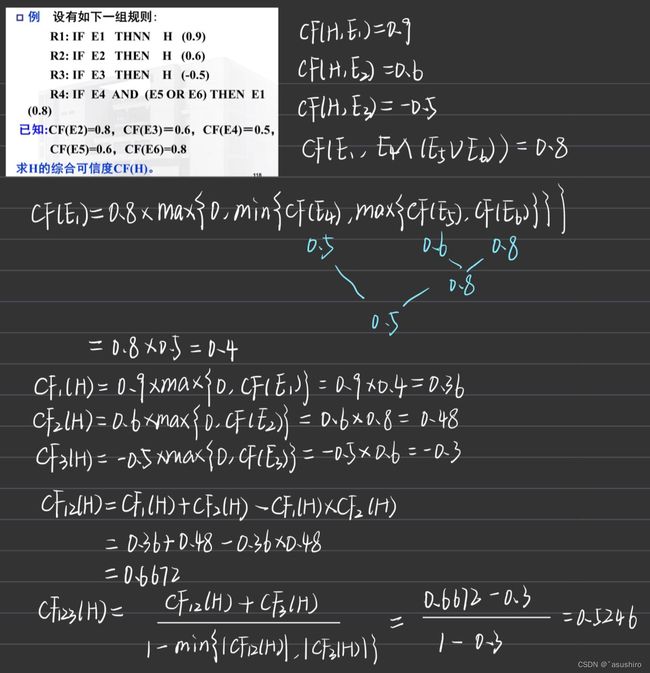

可信度方法

该方法采用可信度CF作为不确定性的度量,通过对CF(H, E)的计算,探讨证据E对假设H的定量支持程度,因此也称为C-F模型。

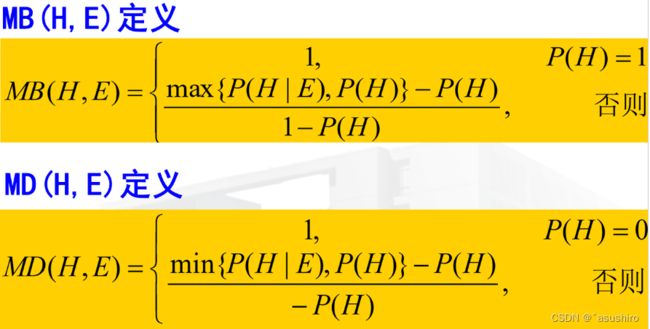

C F ( H , E ) = M B ( H , E ) − M D ( H , E ) CF(H, E) = MB(H,E) - MD(H, E) CF(H,E)=MB(H,E)−MD(H,E)

MB(H, E) = a —信任度量

证据E成立使结论H的可信度增加了数量a

MD(H, E) = B —不信任度量

证据E成立使结论H的不可信度增加了数量b

MB(H, E)和MD(H, E)不能同时大于0,因为同一证据E不能既增加结论H的可信度,有增强不可信度

(4)对H的信任增长度等于对非H的不信任增长度

M D ( ¬ H , E ) = M B ( H , E ) MD(\lnot H, E) = MB(H, E) MD(¬H,E)=MB(H,E)

对H的可信度与非H的可信度之和等于0

C F ( H , E ) + C F ( ¬ H , E ) = 0 CF(H,E) + CF(\lnot H, E) = 0 CF(H,E)+CF(¬H,E)=0

可信度不是概率

(5)对同一个前提E,若支持若干个不同的结论 H i H_i Hi则 ∑ C F ( H i , E ) < = 1 \sum{CF(H_i , E)} <= 1 ∑CF(Hi,E)<=1

所以如果出现 C F ( H 1 , E ) = 0.7 , C F ( H 2 , E ) = 0.4 CF(H_1, E) = 0.7, CF(H_2, E) = 0.4 CF(H1,E)=0.7,CF(H2,E)=0.4是不符合的要进行调整

由于实际应用中P(H)和P(H|E)的值很难获得,所以CF(H,E)的值应有领域专家给出

可信度的计算:

产生式规则表示

I f E T h e n H ( C F ( H , E ) ) If\ E\ Then\ H \ (CF(H,E)) If E Then H (CF(H,E))

E为前提,H为结论,CF(H, E)为规则的可信度所描述的是知识的静态强度

证据E的不确定性也是用CF表示为CF(E), 其取值范围为[-1, 1]

当E为真时:CF(E) = 1

当E为假时:CF(E) = -1

当E一无所知时:CF(E) = 0

CF(E)所描述的是证据的动态强度。

组合证据不确定性的计算

采用最大值最小值的形式

当组合证据是单一证据的合取( ∧ \land ∧)时取 m i n min min

当组合证据是单一证据的析取( ∨ \lor ∨)时取 m a x max max

C F ( ¬ E ) = ¬ C F ( E ) CF(\lnot E) = \lnot CF(E) CF(¬E)=¬CF(E)

不确定性的推理算法

-

证据肯定存在时(CF(E) = 1)时

有 CF(H) = CF(H, E) -

证据不是肯定存在的 ( C F ( E ) ≠ 1 ) (CF(E)\not = 1) (CF(E)=1)时

C F ( H ) = C F ( H , E ) ∗ m a x { 0 , C F ( E ) } CF(H) = CF(H, E) * max\{0, CF(E)\} CF(H)=CF(H,E)∗max{0,CF(E)}

这说明改模型没有考虑证据为假时对结论H所产生的影响

当是组合证据时

MYCIN优化

MYCIN定义:

C F = M B − M D 1 − m i n { M B , M D } CF = \frac{MB - MD}{1 - min\{ MB, MD\}} CF=1−min{MB,MD}MB−MD

这样可以削弱一个反面证据对多个正面证据的影响

同时提出规则前提的CF值必须 > 0.2的门阀值

优点:1. 具有简洁直观的优点。通过简单的计算,不确定性就可以在系统中传播,并且具有线性复杂度 2. 容易理解,将不信任和信任清楚的区分开来

缺点:1. 可能与条件概率的出的结果相反 2. MYCIN一般应用于短推理链,长了会有问题 3. 可能导致累计误差 4. 组合规则的顺序不同可能得到不同的结果

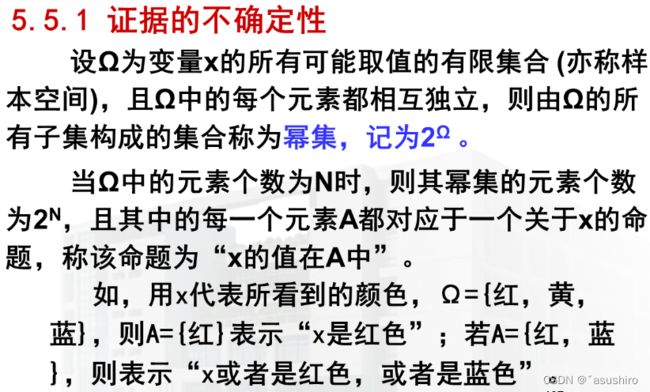

证据理论

用一个概率范围而不是单个概率值取模拟不确定性

可信度可以看作是证据理论的一个特例,同时给了可信度一个理论性的基础

在证据理论中,可以分别用信任函数、似然函数及类概率函数来描述精确信任度、不可驳斥信任度及估计信任度,可以从各个不同角度刻画命题的不确定性

采用集合表示命题,先建立命题与集合之间一一对应关系,不命题的不确定性问题转换成集合的不确定问题

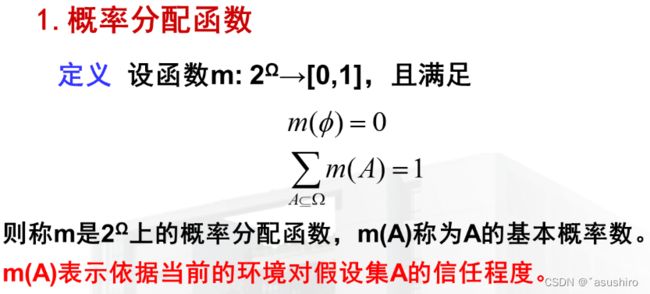

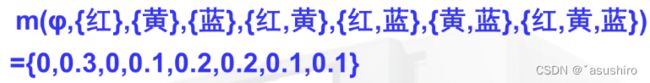

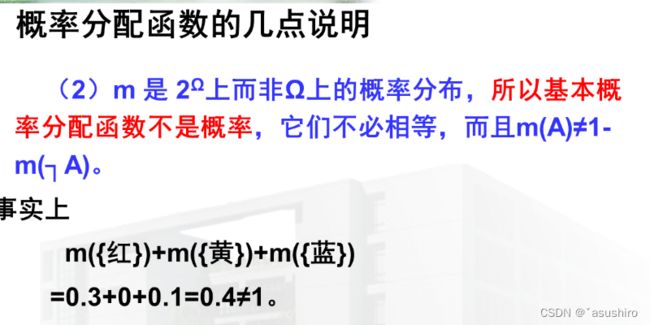

概率分配函数

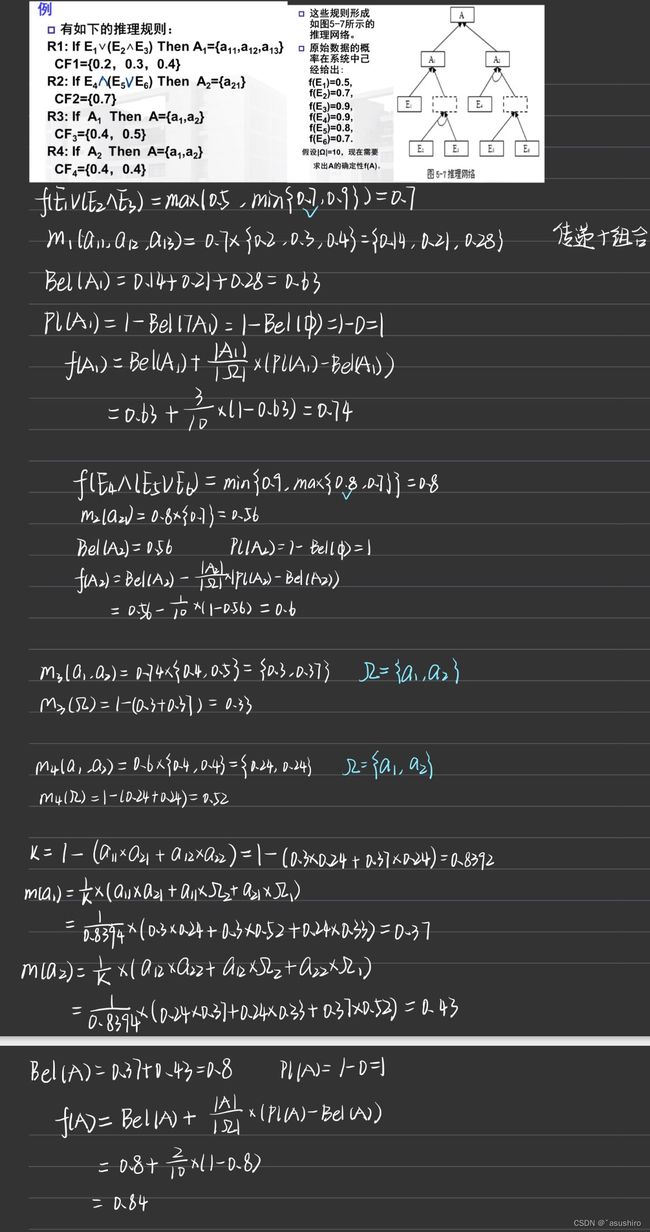

例:

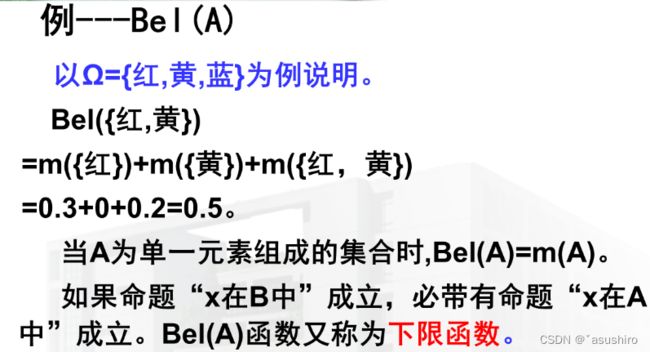

信任函数

定义:在Bel: 2 Ω → [ 0 , 1 ] 2^{\Omega \rightarrow [0, 1]} 2Ω→[0,1] 对任意的 A ⊆ Ω A \subseteq \Omega A⊆Ω有,

B e l ( A ) = ∑ B ⊆ A m ( B ) Bel(A) = \sum_{B \subseteq A}{m(B)} Bel(A)=B⊆A∑m(B)

Bel(A)表示当前环境下,对假设集A的信任程度,其值为A的所有子集的基本概率之和,表示对A的总的信任度

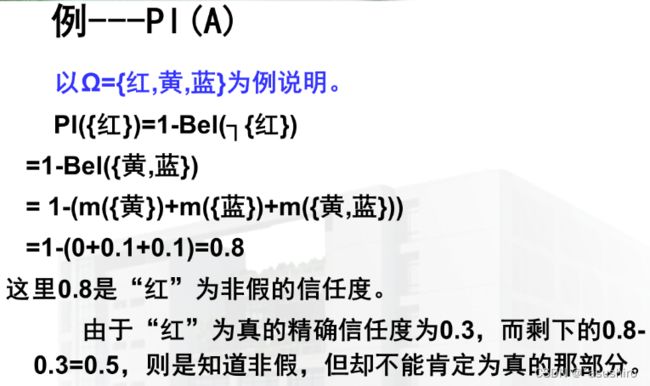

似然函数

定义:Pl: 2 Ω → [ 0 , 1 ] 2^{\Omega \rightarrow [0, 1]} 2Ω→[0,1] 对任意的 A ⊆ Ω A \subseteq \Omega A⊆Ω有

P l ( A ) = 1 − B e l ( ¬ A ) Pl(A) = 1 - Bel(\lnot A) Pl(A)=1−Bel(¬A)

其中, ¬ A = Ω − A \lnot A = \Omega - A ¬A=Ω−A

似然函数称为不可驳斥函数或上限函数

由于Bel(A)表示对A为真的信任度, B e l ( ¬ A ) Bel(\lnot A) Bel(¬A) 表示对 ¬ A \lnot A ¬A的信任度, 因此Pl(A)表示对A为非假的信任度。

推论

P l ( A ) = ∑ A ∩ B ≠ ∅ m ( B ) Pl(A) = \sum_{A \cap B \not = \emptyset}{m(B)} Pl(A)=A∩B=∅∑m(B)

信任函数和似然函数的性质

- B e l ( ∅ ) = 0 , B e l ( Ω ) = 1 , P l ( ∅ ) = 0 , P l ( Ω ) = 1 Bel(\emptyset) = 0, Bel(\Omega) = 1, Pl(\emptyset) = 0, Pl(\Omega) = 1 Bel(∅)=0,Bel(Ω)=1,Pl(∅)=0,Pl(Ω)=1

- 如果 A ⊆ B , A \subseteq B, A⊆B, 则

B e l ( A ) < = B e l ( B ) , P l ( A ) < = P l ( B ) Bel(A) <= Bel(B), Pl(A) <= Pl(B) Bel(A)<=Bel(B),Pl(A)<=Pl(B) - ∀ A ⊆ Ω , P l ( A ) > = B e l ( A ) \forall A \subseteq \Omega, Pl(A) >= Bel(A) ∀A⊆Ω,Pl(A)>=Bel(A)

- ∀ A ⊆ Ω , B e l ( A ) + B e l ( ¬ A ) < = 1 , \forall A \subseteq \Omega, Bel(A) + Bel(\lnot A) <= 1, ∀A⊆Ω,Bel(A)+Bel(¬A)<=1,

P l ( A ) + P l ( ¬ A ) > = 1 Pl(A) + Pl(\lnot A) >= 1 Pl(A)+Pl(¬A)>=1

信任区间

分别用Bel(A)和Pl(A)为对A信任程度的下限和上限,

记为:

A ( B e l ( A ) , P l ( A ) A(Bel(A), Pl(A) A(Bel(A),Pl(A)

P l ( A ) − B e l ( A ) Pl(A) - Bel(A) Pl(A)−Bel(A)表示既不信任A,也不信任 ¬ A \lnot A ¬A的程度, 即对于A是真是假不知道的程度。

类概率函数

f ( A ) = B e l ( A ) + ∣ A ∣ ∣ Ω ∣ ∗ ( P l ( A ) − B e l ( A ) ) f(A) = Bel(A) + \frac{|A|}{|\Omega|}*(Pl(A) - Bel(A)) f(A)=Bel(A)+∣Ω∣∣A∣∗(Pl(A)−Bel(A))

其中|A|、| Ω \Omega Ω|分别表示A和 Ω \Omega Ω中包含元素个数

类概率函数 f ( A ) f(A) f(A)也可以用来度量证据A的不确定性。

性质:

- f ( ∅ ) = 0 , f ( Ω ) = 1 f(\emptyset) = 0, f(\Omega) = 1 f(∅)=0,f(Ω)=1

- ∀ A ⊆ Ω , 0 < = f ( A ) < = 1 \forall A \subseteq \Omega ,0 <= f(A) <=1 ∀A⊆Ω,0<=f(A)<=1

- ∀ A ⊆ Ω , B e l ( A ) < = f ( A ) < = P l ( A ) \forall A \subseteq \Omega ,Bel(A) <= f(A) <= Pl(A) ∀A⊆Ω,Bel(A)<=f(A)<=Pl(A)

- ∀ A ⊆ Ω , f ( ¬ A ) = 1 − f ( A ) \forall A \subseteq \Omega ,f(\lnot A) = 1 - f(A) ∀A⊆Ω,f(¬A)=1−f(A)

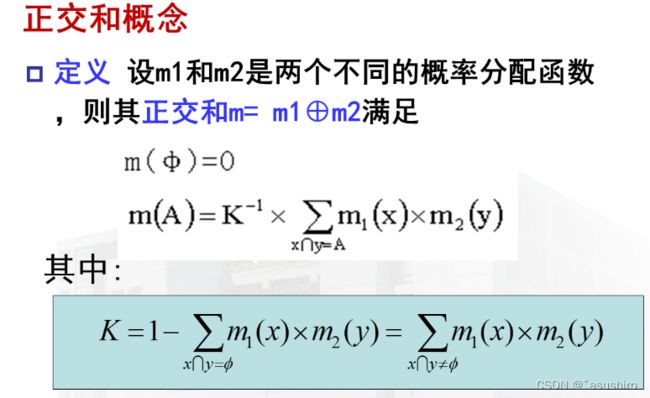

证据的组合函数

- 如果K ≠ \not = = 0,则正交和m也是一个概率分配函数

- 如果K = 0,则不存在正交和m, 称m1 与 m2矛盾

具有不确定的推理规则可表示为:

i f E T h e n H , C F if\ E\ Then\ H,\ CF if E Then H, CF

H可表示为: H = { a 1 , a 2 . . . a m a_1,a_2 ... a_m a1,a2...am}H为假设集合 Ω \Omega Ω的子集

CF = { c 1 , c 2 . . . c m c_1, c_2 ... c_m c1,c2...cm}其中 c i > = 0 c_i >= 0 ci>=0, ∑ c i < = 1 \sum c_i <= 1 ∑ci<=1

定义:

m ( { a i } ) = f ( E ) ∗ c i m(\{ a_i\}) = f(E)*c_i m({ai})=f(E)∗ci

规定 m ( Ω ) = 1 − ∑ m ( { a i } ) m(\Omega) = 1 - \sum m(\{a_i\}) m(Ω)=1−∑m({ai})

对于 Ω \Omega Ω的所有其他子集H,均有m(H) = 0

当H为 Ω \Omega Ω的真子集时有

B e l ( H ) = ∑ m ( B ) = ∑ m ( { a i } ) Bel(H) = \sum m(B) = \sum m(\{ a_i\}) Bel(H)=∑m(B)=∑m({ai})

合取( ∧ \land ∧)取 m i n min min

析取( ∨ \lor ∨)取 m a x max max

与求可信度方法类似;

不确定性的组合

优点:能够满足比概率论更弱的公理系统,可以区分不知道和不确定的情况,可以依赖证据积累,不断缩小集合。

缺点:证据的独立性不易保证

下一篇

未完待续