动态爬虫管理平台构建与实现

摘 要

随着互联网的迅速发展,Web的信息量越来越大。人们往往通过搜索引擎去从互联网上搜索想要的信息,比如:百度,谷歌,搜狗等。这类搜索引擎称之为通用搜索引擎,其为所有的用户所需的内容,但目前互联网上的信息繁杂,难于辨识,用户搜索出来的信息可能与自己想要的信息大相径庭。对于这种问题,就需要更加专业的,面向特定领域的搜索引擎来解决。

主题搜寻技术是垂直搜索引擎的重要组成部分。本文的主要目的是对主题爬虫技术的核心技术进行科学研究。主要研究方向如下:

(1)主题内容的提取是网络主题辨别的关键过程。本文综合了网页内容的特征和主题内容的相关特征,设计了一种提取网页主题内容的方法。

(2)明确提出了一种基于物理线路连接的主题辨别优化算法,以辨别网页的主题。将基于知识库系统的物理线路连接方法应用于特征提取。实验表明,该方法提高了主题网页辨别的准确性。

(3)本文基于Best-First算法,进行平台构建。平台构建是指导主题网络爬虫抓取网页的关键,本文采用基于Best-First算法的平台构建。

关键词:网络爬虫;Best-First算法;平台构建;链接

Abstract

With the rapid development of the Internet, the information online is more and more various. People often use search engines to search for the information they want from the Internet, such as: Baidu, Google, Sogou, etc. This type of search engine is called a general search engine, which provides all users with all the information they want. With the increasing amount of information on the Internet, the information that users search for may be very different from the information they want. For this kind of problem, a more professional, field-oriented search engine is needed to solve it.

The topic web crawler is a key part of the vertical search engine. This article mainly studies the key technologies in the topic web crawler. The main research contents are as follows:

(1) The extraction of subject content is an important step of web subject identification. This paper combines the distribution characteristics of web content and related features of subject content to design a web subject content extraction method.

(2) A topic recognition algorithm based on entity links is proposed to identify the topic of web pages. The entity link method based on knowledge base is applied to feature extraction. Experiments show that this method improves the accuracy of topic webpage recognition.

(3) A platform construction based on Best-First algorithm is proposed. Platform construction is the key to guiding thematic web crawlers to crawl web pages. This article uses a platform construction based on the Best-First algorithm.

Keywords: topic web crawler; entity link; Best-First algorithm; platform construction

目 录

第1章 绪论 1

1.1背景与意义 1

1.2主题网络爬虫的国内外研究现状 1

1.2.1主题辨别算法及平台构建 1

1.2.2主题爬虫系统 2

1.3本文的研究内容 2

第二章 主题网络爬虫的体系结构 4

2.1组成模块 4

2.1.1基本组成 4

2.1.2基本流程 5

2.2主题页面的分布特性 6

2.2.1 Hub/Authority特性 6

2.2.2 Linkage/Sibling Locality特性 6

2.2.3站点的主题特性 6

2.2.4隧道特性 6

2.3搜索策略以及链接提取 6

2.3.1 robots协议和相对链接的转换 6

2.3.2搜索策略概述 7

第三章 网页主题内容抽取 8

3.1 HTML简介 8

3.2网页文件解析 8

3.3网页去噪 9

3.3.1利用统计学去噪 11

3.4主题内容的抽取 11

第四章 基于实体链接的主题辨别算法 13

4.1实体链接简介 13

4.2 CN-DBpedia 13

4.3基于实体链接的特征抽取 14

4.3.1候选特征集合抽取 14

4.3.2常见特征抽取算法 16

4.3.3最终特征抽取 17

4.4基于朴素贝叶斯算法的分类器 18

第五章 基于Best-First算法的平台构建 22

5.1通用搜索策略 22

5.2常用平台构建 22

5.2.1基于内容评价的搜索策略 23

5.2.2基于链接结构评价的搜索策略 23

5.3基于Best-First算法的平台构建 24

5.3.1链接价值评估 24

5.3.2平台构建 25

第六章总结与展望 28

6.1总结 28

6.2展望 28

参考文献 29

致谢 31

第1章 绪论

1.1背景与意义

随着Internet的飞速发展,Internet技术信息已成倍增加。根据我国互联网信息管理中心(CNNIC)发布的第四十份《中国互联网发展状况统计报告》 [1],数据显示:“截至2017年6月,中国互联网用户数量已达7.51亿。占全世界的五分之一。互联网技术覆盖率为54.3%;中国网站总数为506万,在一年中的大部分时间里增长了4.8%。”

如此众多的URL包括无数的网页。网页是信息的媒介。人们通常使用百度搜索和Google之类的通用搜索引擎来从Internet技术中获取所需的信息。众所周知,通用搜索引擎检索到的信息通常更为广泛。垂直搜索引擎是一个特殊的领域,它是通用搜索引擎的细分,它集成了特定行业的网页信息,然后在解决方案之后以某种方式将其返回给客户。垂直场针模块可显示特定行业,特殊客户或特殊要求的相关信息和服务项目。垂直搜索引擎专用于某个行业或技术行业,因此它们似乎更加集中,实用和深入。

主题Web爬虫,也称为焦点Web爬虫,是垂直搜索引擎的关键组件,因此对于主题Web爬虫的科学研究具有关键的现实意义。主题Web搜寻器是一个程序过程,可从Internet技术自动搜寻网页。它浏览与Internet技术相关的链接,并基于预设主题获取网页信息。通用Web爬网程序逐渐从多个种子链接开始,首先对具有种子链接的网页进行爬网,然后从该网页中提取新链接,并将其置于要爬网的顺序中,直到达到由设置的爬网完成标准系统软件或等待。爬网队列为空。相比之下,主题Web搜寻器的搜寻步骤更为复杂。在整个爬网过程中,必须预测和分析所连接主题的相似性,然后放入根据主题相似度排序的待抓取队列中。

1.2主题网络爬虫的国内外研究现状

1999年,S.Chakrabani [2]首次明确提出了焦点网络爬虫的定义,并设计了计划并完成了Focus Proiect系统软件[3]。该技术一经提出很快获得了广泛关注。在下文中,我们将从基础理论和完整的系统软件两个层面详细介绍全球主题网络爬虫的研究现状。

1.2.1主题辨别算法及平台构建

P. DeBra [4]等。建议使用Fish-Search算法作为搜寻器的搜索策略。该算法假定主题相关的网页在逻辑上连接到与最近搜索主题相关的网页。 Shark-Search搜寻器[5]基本上在Fish-Search算法上得到了改进。 Fish-Search算法使用二进制实体模型来评估主题的相关性,而Shark-Search算法则基于连接锚链接和网页的情况。所计算的主题相关内容的相关性值的[0-1]范围内的值。该算法可以改善主题搜寻器的均方误差。 Best-First爬网程序[6]由CHO J等人在1998年提出,其关键概念是构建要爬网的序列,根据查看策略对序列中的连接进行注释,然后选择最佳的连接。

Larry Page以及Sergey Brin[7]两位专家提出了PageRank算法,运用于Google搜索引擎。leinberg博士首先提出HITS算法。

Diligenti[8]利用“语境图”构造分类器来作为爬虫的搜索策略。主题页面较近的页面将会被优先抓取,认为此部分页面的主题有较好的相关性。

陈军[13]提出了一种基于网页分层的Shark-Search算法,该算法以块为基本元素来衡量网页连接结构的使用价值。

熊忠阳[14]等人提出一种基于信息自增益的主题爬虫搜索策略。

1.2.2主题爬虫系统

基于理论基础研究,来自世界各地的权威专家设计并完成了许多高效的主题爬虫系统。

(1)科学体系。Elsevier Science和FAST联合开发了 Scirus系统[15],是一种垂直搜索的系统,可为在校学生和科研人员提供服务。有很多次,该系统都被评为了最佳垂直搜索引擎。

(2)美国数据科学公共图书馆的馆藏建设计划(CBP)系统。该系统的关键是用于科学和数学课程的在线电子书。实际操作很简单,客户只需要输入简单的查看信息内容即可查看更相关的连接。

(3)NEC研究所的CiteSeer系统。该系统是面向计算机的科学论文检索系统。

STIP系统。该系统是中科院参考信息中心实施中科院参考资源共享系统的子项目,关键是信息技术资源。

南京大学互联网技术数据收集系统(IDGS)。该系统使用匹配算法技术来完成对互联网技术中英文技术文档的自动检索。

北大天网系统[16]选择一组关键字来指示一个主题,并且网络爬虫根据对策使用这组主题关键字从Internet技术中获取数据,以便它可以尽快,全面地捕获该主题。相关信息资源。

专题数据收集系统Gsearch。由周鑫和其他人设计和完成。 Gsearch系统[17]有进行行业中市场评估分析的功能,例如公司管理决策的应用和该领域的市场需求分析。

1.3本文的研究内容

在本文中,基本的搜寻器技术基于获取导入网页的主题内容以及基于物理线路连接的主题标识优化算法辨别目标网页,而后基于Best-First算法进行平台搭建,并指挥主题网络爬虫从互联网上抓取主题相关的网页。

对本文的内容说明如下:

1)结合Web内容的普遍特征和主题内容的相关特征,提出了提取Web主题内容的设计方案。

2) 在主题网页的辨别级别,选择基于物理线路连接的主题辨别算法来辨别主题网页。

3)在搜索策略中,选择了基于最佳优先算法的服务平台,以指导主题网络爬虫对主题相关的网页进行爬网。

本文共分为六章,章节安排如下:

第一章,绪论。介绍了科学研究的现状和现实意义,各国主题网络爬虫的研究现状以及本文的研究方向和章节结构。

第二章主要介绍了网络爬虫的系统架构。在介绍通用Web爬网程序和主题Web爬网程序系统架构的基础上,讨论主题Web爬网程序和通用Web爬网程序之间的区别。

第三章主要介绍了网页主题内容的提取。首先介绍了HTML结构,然后介绍了网页分析以及如何解决网页噪音问题,最后讨论了如何提取网页主题内容和词性标注的相关内容。

第四章主要介绍了基于物理线路连接的主题辨别算法。本部分主要介绍主要内容有必要介绍物理线路连接以及如何在特征提取中应用主题连接,以提高主题辨别算法的准确性。

第五章基于Best-First算法构建服务平台。首先介绍通用网络爬虫的检索对策及相关算法,然后介绍了通用网络爬虫的搜索策略和相关算法的使用,接下来,介绍了其中两种主要的平台构建以及典型的算法,最后,详细阐述了本文所研究的基于Best-First算法的平台构建方法。

第六章,总结与展望本论文探讨的内容。

第二章 主题网络爬虫的体系结构

2.1组成模块

2.1.1基本组成

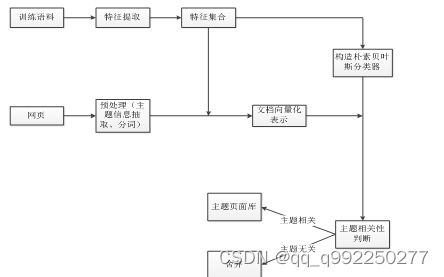

主题网络爬虫的组成结构如图2-1:

图2-1主题网络爬虫的体系结构

如图所示主题网络爬虫分为5个部分:下载,主题内容抽取,主题网页辨别和链接评价模组。

下载组件。

对于网络爬虫,从头到尾都是免费下载网页的关键任务。免费下载控制模块必须充分考虑各个方面的因素,例如:通常使用网页的点对点传输,在点对点传输中,资源的生产调度非常重要。此外,必须设置请求超时系统以放弃等待时间太长的网页,以改善Web爬网程序的特性。

主题内容提取。

主题网络搜寻器必须对网页进行细致的分析。主题内容提取在很大程度上改变了网页的主题标识。嘈杂的内容将干扰以后识别网页主题的实际效果,因此必须消除它。除了减少噪声外,初步处理还包括实际操作,例如网页主题内容的获取,分词算法和停止词删除。

主题页标识

本文的重点是根据网页内容是否与主题相关来识别主题网页。在本文中,主题是某种类型的预设信息资源的总称。主题选择是主题信息提取的第一步。网页的主题由一组与主题相关的功能指示。

在文本中应用文本分类技术以识别网页主题。整个过程是:选择某个主题和与该主题相关的训练数据信息集,使用矩阵的特征值来表示网页,然后,利用分类算法对其进行分类。首先用特征向量表示网页,然后,利用分类算法对其进行分类。

链接主题相关性评价及抽取

首先删除突出的广告链接,然后将相对链接转换为正链接,最后评估链接的主题相关性,并将其置于要爬网的顺序中。计算链接的主题相关性时要考虑父网页和链接锚链接的主题相关性。 Web爬网程序的基本步骤可以分为两个整个过程:免费下载的整个过程和网页分析的整个过程。免费下载整个过程中的关键日常任务是从要爬网的连接序列中获取连接,然后从Internet技术免费下载网页。网页分析的关键包括两个过程:网页主题内容的提取和主题网页的标识。

2.1.2基本流程

爬虫的基本流程可以分成下载过程和网页分析过程两个过程。下载过程主要的任务是从待抓取的链接队列中获取链接然后从互联网上下载网页,网页分析主要包括网页主题内容的抽取和主题网页的辨别两个步骤。

(1)下载过程

step1生产调度控制模块从要获取的连接序列中获取连接,然后运行相应的免费下载进程总数。

step2为每个免费下载过程创建一个对话框。

Step3创建一个链接并免费下载网页。

step4中,将网页保存在本地,然后再次获取下载地址,然后转到步骤3。如果没有下载地址,则将退出该过程。

(2)网页分析过程

步骤1网页准备处理控制模块首先将初始网页构建为dom树。

步骤2提取网页中的所有锚链接和文本连接点,并将它们存储在两个容器中:锚和文本。

步骤3过滤掉不相关的节点。

步骤4过滤噪音文本。

步骤5还根据网页主题内容的特征提取网页主题内容。

步骤6对提取的网页主题内容执行词性标注解决方案。

步骤7:获取特征,并使用要分类的矩阵的特征值来表示网页。

步骤8:预先结合训练网页,并基于朴素贝叶斯优化算法训练支持向量机。支持向量机对要分类的空间向量进行分类,以区分其是否与主题有关。

如果网页与主题相关,请将该网页保存到网页库中。

步骤10从锚点获得的所有锚点连接点剔除一些链接,并评估链接的主题相关度。将新的链接及其主题相关度存到待抓取的链接队列中。

2.2主题页面的分布特性

主题页面分布需要注意的有四个特性:Hub/Authority和Linkage/siblingLocality特性,以及站点的主题特性和隧道特性,需要符合一定规范。

2.2.1 Hub/Authority特性

康奈尔大学的克莱因伯格专家教授发现,网页可以大致分为两种类型,即管理中心网页和权威网页。管理中心网页上有许多链接。网页的另一种类型是权威网页。这种类型的网页倾向于指示单个主题。专家教授Kleinberg在网页上介绍了Hub和Authority值以反映上述特征[18],并明确提出了基于这些特征的HITS优化算法。

主题页面分布还有一种特性,即站点上的各个主题页面团往往会通过一些主题无关链接连接在一起。这些链接像

2.2.2 Linkage/Sibling Locality特性

Linkage功能是指网页中包含的链接所偏向的网页主题通常与主题相关。Sibling Locality功能是指网页上同一区域中链接的一般主题[19]。

2.2.3站点的主题特性

网站通常包含一个或多个主题。通常,有关主题的网页会聚在一起,而具有不同主题的网页的链接会更少。

2.2.4隧道特性

它是在主题页面中间粘贴跨隧道施工,这是隧道施工的特征。在整个爬行过程中,隧道施工会作用于爬行的高效性。

2.3搜索以及链接提取

检索对策是Web爬虫从Internet技术爬网网页的关键,它在很大程度上决定了Web爬虫的高效率。必须根据相关协议清除部分连接。

2.3.1 robots协议和相对链接的转换

2.3.1.1 robots.txt文件和META标签

(1)robots.txt。通常,Web爬网程序不会预期网站的某些内容。 ROBOTS开发和设计社区展示了两种解决方案:一种是robots.txt,另一种是META标签。 robots.txt是纯文本文档,其文件夹名称的小写字母存储在网址的根目录中。可以在此文件中声明不希望Web爬网程序浏览的Web地址部分。

“ robots.txt”文件包含许多记录,每个记录的文件格式如下所示:

<字段>:<可选空间> <值> <可选空间>

robots.txt文件用于描述网站的所有URL的网络搜寻器的浏览状态,而META标签是分隔实际网页的关键。

(2)META标记中没有英文区分大小写,name =“ Robots”表示对所有Web爬虫均有效,对于实际的Web爬虫,也可以将其写为name =“ BaiduSpider”。

2.3.1.2相对链接的转换

相对URL包括Web服务器相对URL和文本文档相对URL。确保URL的文件格式如下:

scheme://服务器/路径/资源

其中:scheme特定资源使用的协议,有诸如http,mailto,ftp等协议。服务器是指资源所属的网络服务器的名称,例如www.baidu.com。路径是指到达资源的方式,例如/ 18/0402/09。资源通常是文件夹的名称,例如:DECL75C900118017.html。它可以是单独的二进制流的“简单文档”,也可以是“结构化文本文档”。精确位置资源的所有信息内容都包含在“肯定URL”中。

相对URL相对于某个网页的整体目标连接。在实际的自然环境中,Web服务器中的更改将导致错误的连接,因此相对连接偏向于同一Web服务器下的网页。如今,网页部分通常被视为特殊的网页部分,或由基本标签定义,例如

2.3.2搜索策略概述

为了获得更高的渗透率,通用网络爬虫通常选择图的深度和广度来解析Internet技术上的网页。主题Web爬网程序必须检索的内容始终是针对特定主题,并且不需要解是Internet上的全部内容,仅必须选择与主题相关的网页来分析。

主题网络爬虫通常使用“首选”标准从Internet技术中检索网页。每次浏览“最有用的”链接时,您都可以有效地获取大量与主题相关的网页。主题网络爬虫的不同检索策略由连接的使用价值评估方法确定。链接通常包含在网页的内容中,因此通常父网页的使用价值很高,并且包含在其中的链接通常具有较高的使用价值。因此,评论链接的使用价值通常需要分析Web内容。

第三章 网页主题内容抽取

3.1 HTML简介

在此阶段,大多数网页都是用HTML编写的。网页根据Web链接连接在一起,从而创建一个间隙连接在一起的网络结构。

对于通用Web搜寻器,仅必须提取网页中的链接;众所周知,主题网络爬虫必须分析并获取网页的内容,然后评估链接的值并选择它。标签可以大致分为三类:

(1)为网页的合理布局开发标签。常见标签是

图3-1 html文件的树结构

在此阶段,有许多用于结构标签树的特殊工具,例如:htmlParser,W3C HTML词法分析器[22]等。

3.3网页去噪

许多网页包括与主题无关的内容。如图3-2所示的新闻报道网页的屏幕截图所示,可以感觉到文章正文之外的部分都是杂音。

图3-2网页的正文块

从网页的屏幕截图可以看出,除了文章正文块之外,网页的一部分还包括广告,导航栏链接和站点搜索。

在主题检索行业中,大量的噪声含量会导致主题漂移。当获取与主题相关的内容时,如果不去除初始网页中的噪声内容,通常很容易将噪声内容视为与主题相关的内容,这将作用于对网页主题的识别。

3.3.1利用统计学去噪

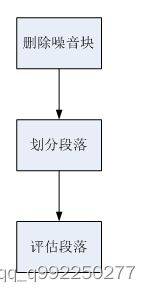

用统计分析进行去噪的步骤[23]如下。

删除噪音块:对网页进行降噪的基本方法是使用各种通用功能,将合理的文章正文与其他信息内容(如标题,底部和广告)区分开。共同特征之一是关联文本的比例。根据所连接文字的比例过滤掉噪音。

文章各段的划分。能够将HTML网页分为几个段落(段落)。完成此操作的简单方法是根据

图3-3去噪流程

3.4主题内容的抽取

提取网页主题内容是识别网页主题的第一步。主题内容提取的准确性立即危及网页主题标识的准确性。刘军等。 [24](基于DOM网页主题信息内容的提取)明确提出构建文本文档域模型DOM树,然后添加诸如单词含义之类的属性来处理HTML文本文档的半结构不足的问题,并提出了一种基于聚类算法标准的分层算法,最终获得了主题信息的内容。在此基础上,根据对许多网页的分析,除了文章正文的内容块,网页的文章标题内容(标题标签的内容)和元标签的属性内容通常还包含网页的主题信息内容,因此在提取的情况下,这部分内容也应被提取。通常,网页可以分为数据库索引网页和主题网页。 Web主题的标识是针对主题网页的。

主题网页中包含的链接文本通常是与主题无关的文本,例如广告,因此应首先将其删除。以后,您还应该查找与主题无关的杂色文本,例如网页的版本号信息。通常,网页主题内容的提取和优化算法如下:

步骤1首先选择p,li,td,h1作为层次连接点

步骤2删除网页的标签和内容

步骤3获取标题徽标中的文本,然后删除标题徽标和内容

步骤4获取元徽标的特征内容的值,然后删除元徽标

步骤5在p标签上执行与3相同的实际操作。

步骤6在li标签上执行与3相同的实际操作。

步骤7对td徽标执行与3相同的实际操作

步骤8对h1徽标执行与3相同的实际操作

将标点符号“,。?;、,.?”作为分层连接点的特征。如果连接点中的文本包含此功能,则认为内容与主题相关,然后将其提取。

第四章 基于实体链接的主题辨别算法

4.1实体链接简介

在详细介绍实体连接之前,首先,我们必须掌握实体的定义。实体是世界上存在的某个目标或目标的集合,并且通常通过特征来描述该实体。

实体连接是将文本中的实体描述连接到知识库系统中相应实体的整个过程[29]。实体连接中使用的知识库系统包括Wikipedia,Freebase,YAGO,DBpedia等[30]。在这个阶段,复旦数据库管理实验室的专业知识处理工厂已经建立了知识库系统,并且显示出了更全面的套接字。本文使用专业知识处理工厂提供的知识库系统和相关套接字。在一段文字中,实体连接的关键是两件事。一种是在文本中标识实体引用,另一种是将标识的实体引用与知识库系统中的相应实体相关联。因为自然语言理解中的常见现象是这种多义和混叠的情况,所以有必要基于文本中实体描述的上下文信息来澄清该实体描述所偏向的实体。因此,实体连接的关键包括两项核心技术:实体标识和实体歧义消除。实体标识[31]是指在文本中标识实体描述,该描述可能是偏向该实体的单词或句子。实体歧义消除[32]是指提供实体名称,其上下文和替代实体,并在当前上下文的上下文中区分其首选实体的整个过程。

4.2 CN-DBpedia

CN-DBpedia [33]是由复旦专业知识工厂实验室(知识工厂)开发和维护的大型通用行业结构的百度百科全书。它的前身是清华GDM中文语义网,该网最初在中国发布。它也是现阶段最大的开放式百度百科中文语义网,包含数百万个实体和数千万个连接。 CN-DBpedia以一般科学知识的沉积为主要内容,垂直深度行业图的积累为主要内容。它着重于展示丰富多彩的情况和专业知识,以了解设备的含义。有必要显示出对完成编程语言认知能力的必要支持。观点。 CN-DBpedia已从百度百科全书行业长期扩展到法律法规,工商局,金融业,文化娱乐,高科技,国防,文化教育,诊断和治疗等十多个垂直行业,显示了智能系统在各个领域中的应用支持点。知识服务项目目前有近100家公司在应用。 CN-DBpedia具有规模大,质量上乘,自动更新,API服务项丰富多彩的特点。长期以来,CN-DBpedia一直是业界向外界开放中文语义网的首选。本文的关键是使用CN-DBpedia作为知识库系统,并使用专业知识处理工厂生产的相关套接字来标识文本中的实体,然后使用所提供的套接字进行物理连接。

例如在下面的文本中:

![]()

图4.2

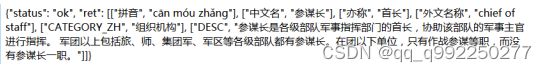

上述cuts字段是对文章中的词进行集合的内容,而entities(字段)则是分辨出的文中实在体。

此后,再调用知识工厂提供接口,来得到知识库中的实体明细:

图4.3

其中,status状态表示套接字激活状态,ret字段名称表示获得的结果,包括实体的详细信息:拼音字母,中文名称(也称为中文),外语名称,CATEGORY_ZH,DESC。

上述整个过程是识别文本中的实体并连接到知识库系统以获得实体信息的整个过程,即实体连接的整个过程。

4.3基于实体链接的特征抽取

特征提取对于主体识别而言是特别关键的步骤。所提取的特征是否准确决定了主体识别的准确性。由于存在词性标注的问题,传统方法无法很好地提取某些主题特征。因此,本文将实体连接引入特征提取的全过程,并以知识库系统为支撑点,使其更加准确。提取主题特征。

4.3.1候选特征集合抽取

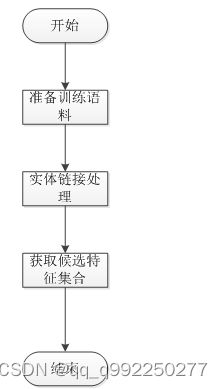

第一,在给定语料库里面选出备用特征集[34]。

图4.4

如图所示,操作步骤如下:

(1)事先准备训练语料库。预先准备有关多个主题的文本。

(2)物理连接分辨率。使用专业知识处理工厂的套接字,逐字识别与该主题有关的文本,并标记词性,并获得实体信息以从实体信息中提取大量候选特征。

(3)获得一组候选特征。删除上一步中获得的单词集的重复数据,停止单词解析,并获得一组候选特征。

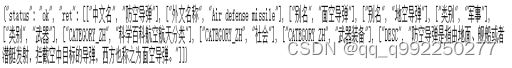

从搜狗搜索语料库中,选择与“国防”主题相关的50条新闻文章作为选择候选特征的语料库。首先,使用知识工程界面标记语料库文章的内容并标识语料库文章内容的实体。由于知识库系统的支持,文章内容中的潜在功能可以被更强地细分。响应于所标识的实体,执行实体连接以获得实体的信息。如下图所示:

图4.5

如图所示,在实体“防空导弹”的实体信息中,可以提取“已知”,“类型”和“ CATEGORY_ZH”的特征并将其组合为一组候选特征。 “ DESC”功能已添加到语料库中,以获取候选功能以进一步解决。

如上所述,根据实体连接的方法,由于知识库系统的支持,一方面可以更准确地提取潜在特征,另一方面,因为用于提取特征的训练语料库相对较快。有限的。可以从实体信息中提取大量特征。

如下图所示,通过实体连接的应用程序筛选出候选功能集的情况:

图4.6

4.3.2常见特征抽取算法

在这一阶段,常见的特征选择优化算法如下:文本文档频率[35],信息增益值[36],互信息[37]和关键字统计分析[38]等。

(1)文档频率。

训练语料库中包含单词的文本文档总数是单词和句子的文本文档频率。这种方法的基本思想是:低频词和句子通常携带很少的信息,因此不可能很好地区分类型,因此可以删除低频词,从而降低特征水平。它还可以提高分类的准确性。

信息增益:

信息增益值(IG)用于测量在某个功能出现和未出现两种情况下系统软件所携带的信息量的误差。就文本分类而言,包括特征词t的文本文档和不包含特征词t的文本文档的频率误差是指特征词t的IG值。 IG值使用以下计算公式:

(4-1)

在公式计算中,指示语料库中类别文本文档的出现概率,指示语料库中包含词语文本文档的概率,指示当文字文档包含单词时属于该类别的条件概率,并且指示文本文档在语料库中不包含单词的概率,指示当文本文档不包含单词时在类中的条件概率,指示类型的数量。

CHI统计分析

CHI统计分析通常称为开放根统计分析,用于检测两个独立变量是否独立。在两个自变量不相互关联的前提下,外推特定观察值的偏差水平和模板的标准偏差以指示CHI值。 CHI值越大,两个自变量往往相关;反之亦然。相反,两个自变量往往是分开的。CHI统计分析

特征词和文本文档类型的相对级别也可以通过这种方式来考虑。第一个预设关键字与特定类型分开。因此,基于基本度量计算出的关键字的CHI值越大,结果和假设误差越大,并且关键字和类型越相关。因此,以这种方式进行特征选择的整个过程是测量每个关键字和类型的CHI值,并将其从大到小排列,并且第一个值就是特征。单词和句子类型的CHI值的计算方法如下:

(4-2)

互信息,也叫Mutual Information,在信息论中,互信息(MI)表示当两件事相关时呈现的信息量。互信息量越大,相关性越大。

词语和类别的互信息计算公式如下:

(4-3)

公式(4-3)中A、B、C、D和N的含义与公式(4-2)中一致。

实验表明,信息增益值可以更合理地进行特征获取,因此本文选择了信息增益值的优化算法进行特征获取。

4.3.3最终特征抽取

根据候选特征集,提取最终特征集,操作步骤如下:

图4.7

(1)计算信息增益值。测量训练语料库中候选特征集中每个特征的信息增益值。

(2)获得特征。根据信息增益值的降序,选择顶部的多个特征。

(3)获得最终特征。将特征从实体信息添加到中。

(4)在该过程中获得的特征集中,将该特征集作为最终特征集。

4.4基于朴素贝叶斯算法的分类器

本文选择支持向量机作为朴素贝叶斯优化算法的结构。

假设使用一个特征集来表示每种情况A,并且从相对有限的集合C中分配类c。现在显示训练用例和测试用例(a1,a2,…,am)的集合。

A的目标是获取实例(a1,a2,…,am)的类标记。得到:

(4 - 4)

我们现在需要做的是基于训练案例集的公式(4-14)中的两个概率值。

朴素贝叶斯分类器[39]假设在给出类标识符时特征值彼此独立。换句话说,联合概率恰好是每个独立特征的概率的乘积。实际的公式如下:

(4-5)

代入式(4-14)中,可得朴素贝叶斯分类器的分类公式:

(4-6)

其中,为x的第j个特征值表示、而概率p(c)、以及条件概率都能在计算的训练实例集中以不同类、不同特征值重组的方式,按频率计算:

(4-7)

(4-8)

其中,n是训练案例的数量,是第i个训练案例的类别标识符,是第i个训练案例的第j个特征值,为一个二值函数,当时为l,否则为0。

显然,当出现零频率属性值的时候,这种方法会导致过低估计概率。更极端的情况会使得某个概率值为0,进而导致由式(4-6)计算的整个量为0。常常使用Laplace估计来进行平滑处理进而避免上述问题,重写式(4-7)和式(4-8)得到:

(4-9)

(4-10)

其中是训练案例的第一个特征的作业数量。为训练第个属性的取值的数目。

基于实体连接的朴素贝叶斯支持向量机的总体架构如图4.8所示。

图4.8整体框架图

其工作内容如下:

(1)应用基于物理线路连接特征提取方法的svm算法。

(2)根据获得的特征组合建立朴素的贝叶斯分类器并对其进行训练。

(3)对由网络爬行器爬行的网页进行预处理,包括主体信息提取,词性标注等预处理,然后对网页进行矢量化分析。

(4)在向量化分析解决之后,使用分类器来辨别网页的主题。如果该网页属于主题类别,则将该网页保存到主题网页库中,或者放弃该网页。

4.5测试分析

本节基于主题辨别中基于物理线路连接的朴素贝叶斯分类器的实际效果的实验验证。

为了评估主题辨别的实际效果,选择了三个关键指标值:准确性(P),召回率(R)和F值[40]。准确性是指与准确辨别的主题相关的单词总数中所占的比例;均方误差是与准确辨别的主题相关的总单词数与与培训集中化的所有主题相关的总单词数的比例; F值是一种综合评估方法。假设,在训练语料库中,与主题相关、且被明确判定的文本数量是a,虽然与主题无关但被判定为主题相关的文本数目是b,而属于与主题相关但未能被判定为与主题相关的文本是c,则三个评价指标的公式:

准确性比率:

召回率:

F值:

从搜狗新闻语料库中总共提出选择了1443条文章,其中有关国防的文章587份,非军事文章856份,本章的应用明确基于物理线路连接的方式构建朴素的贝叶斯分类器并进行实验。测试结果如下:

根据结果分析,与传统的朴素贝叶斯分类器进行比较,可以发现,引入实体链接技术后,其性能效果得到了很好的改善。

第五章 基于Best-First算法的平台构建

搜索策略是爬虫预先设置的一种爬网方法,专门用于指导Internet爬虫对Internet技术上的网页进行爬网。本章基于先前经验的基础,设计主题样式搜寻器策略以专门指导主题样式搜寻器搜寻网页。

5.1通用搜索策略

网络的链接可认为是一个复杂而庞大的非连通结构[41]。按照图的遍历,一般,通用的网络爬虫可以有两种策略:广度优先策略以及深度优先的策略[42]。

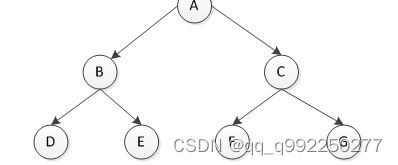

图5.1网络链接结构图

图5.1是一个简单的网络框架图,其中Internet上的网页由节点表示,而连接由边缘表示。深度优先搜索的思想是,爬虫继续沿某个方向搜索,直到在该位置没有可以再次搜索的节点,然后再从另一个方向开始。例如,像5.1一样,搜寻器的搜索顺序是ABDECFG。深度和广度有限的搜索策略是从近到远逐层爬网和搜索Internet上的节点。以5.1这样的网络架构为例,其中节点A是第一级网页,节点B是第二级网页,而D,E,F和G是第三级网页。页面。因此,根据深度优先级和广度优先级选择策略,搜寻器搜寻网页的方式为ABCDEFG。

从理论上讲,这两种搜索策略都是可行的。但是,实际自然环境中的网络技术庞大而复杂。深度优先策略通常会停留在某个位置,并且一般网页的级别越长,使用价值就越低。因此,一般的爬虫通常会选择深度优先策略。众所周知,为了更好地追求普通通用爬虫的完美渗透率,捕获的资源通常具有较低的使用价值。

5.2常用平台构建

主题Web爬网程序的总体目标是对与给定主题相关的网页进行爬网。因此,有必要预测和分析所连接内容的主题相关性,然后决定是否开始爬网。与一般的搜索策略不同,该服务平台旨在在主题的特定指导下评估连接的使用价值。根据连接的主题相关性的大小,将连接插入要获取的序列中,然后选择具有较高主题相关性的连接以再次获取[43]。这样,主题网络爬虫可以尽可能快地爬网与主题相关的网页,从而提高了爬网的效率。

近年来,大体将服务平台构建的关键分为两类:一类是基于内容审查,另一类是基于连接构建[44]。

5.2.1基于内容评价的搜索策略

搜索策略主要基于分析网页和给定主题之间的相关性,以专门指导主题网络爬虫对网页进行搜索。下面的关键是在详细介绍以下优化算法的基础上分析这种搜索策略。

(1)Best-First最佳优先优化算法

最佳优先搜索是一种研究性搜索优化算法,可以看作是深度和广度优先搜索优化算法的改善。最佳优先级搜索优化算法基于深度和广度优先搜索,使用估价函数来注释将在遍历中解析的点,然后选择代价小的分析,找到整个目标连接点后,或者解析完毕所有点后才停止。用来做主题网络爬虫的搜索策略的基本思路是:对链接的价值进行评估,优先抓取价值高的链接所指向的网页。

(2)Fish-Search算法

De Bra等于提出Fish-Search算法,该算法模拟鱼群觅食行为。该算法假设每个链接就是一条鱼,该链接的页面中的链接代表鱼的后代。如果鱼找到事务,即链接找到主题相关页面,那么将继续沿这个方向继续搜索。反之,如果鱼找不到食物,则后代变得虚弱,即此方向找不到主题相关页面。经过多次寻找,直到此线路再无其他链接则从其他方向重新开始搜索。

Shark-Search算法

Fish-Search算法使用二值模型来来判断鱼是否找到食物,这样无法精确的对链接优先队列进行排序。Hersovici提出了Shark-Search算法来改进Fish-Search算法。其相关度一般在0和1之间取值[44]。

5.2.2基于链接结构评价的搜索策略

在基于链接结构评价的整个搜索中,“PageRank”算法和“Hits”算法是最经典的两种。

(1)PageRank算法

定义“入度”和“出度”的概念,“入度”是指向网页的,而“出度”则是由网页指向其他的页面的链接。PageRank算法主要是依据入度和出度,对链接价值进行评估。

页面A的PageRank的计算公式如下:

(5-1)

上述表达式中:表示的是网页A“PageRank”的值。而则表示A的网页的“PageRank”值。代表Ti出度。而d则是阻尼常数,主要起调控作用,在0到1之间取值,一般设置d为0.85。

(2)HITS算法。

HITS算法的步骤如下:

1)网页i具有两个特征分值:中心度h(i)和权威度a(i)。初始情况下,h(i)=1,a(i)=1。

2)每次通过迭代计算页面的中心度和权威度。

计算网页的中心度h(i)为:

网页的权威度a(i)为:

标准化处理:,。其中,|h(i)|表示最大中心度,而|a(i)|则是网页集合中最大的权威度。

3)继续2)步骤,计算两轮迭代权值之差,若二者差的比较小,表面系统已逐渐趋于平稳。

5.3基于Best-First算法的平台构建

5.3.1链接价值评估

Best-First算法的基本思想是构建一个待抓取链接列表,然后从中选择最有价值的链接进行搜索。通常利用页面内容与主题的相似度来对页面的价值进行评估。利用向量空间模型来表示一个页面,将欧式距离和权重计算相结合的方法计算出页面与主题之间的相关性,其计算公式如下:

(5.2)

以上公式在欧式距离计算公式的基础上进行归一化并取反处理后的公式,其中,q,p分别表示主题向量和页面特征向量,向量的维数都为n,表示特征关键字i在页面p中权重,表示k在主题向量q中的权重,权重采用TF-IDF方式计算。

公式表示,当计算值最小为0,表示网页向量与主题向量相似度最低,当计算值最大为1,此时表示网页向量与主题向量相似度最高。

一个主题相关的网页上,并非所有的链接都是主题相关的;反之,一个主题不相关的网页上不一定所有的链接都是主题无关的[46]。所以可以由两部分评价链接的价值,第一部分是链接所继承的父页面的价值。另一部分则是链接的锚文本。

可以做如下假设:父页面的向量作为d1,而链接的锚文本向量表示成d2,至于主题向量则设为q,通过前文的分析,得到最终的计算链接价值的公式:

(5.3)

5.3.2平台构建

本文所使用的检索方式原则上是依据两个队列,它们来引导爬虫获取网络上的网页地址资源。一个是待抓取链接队列,另一个是已抓取链接队列。其中,待抓取链接队列是本文搜索策略的关键。

待抓取链接队列示例:

[{depth=2, url=http://tech.sina.com.cn/mobile/n/apple/2015-02-12/081510009651.shtm l,

thematicCorrelationVal=0.8}]

待抓取链接队列结构如上所示,主要由三个元素组成:url,depth,thematicCorrelationVal。url表示待抓取的链接,depth表示链接深度,thematicCorrelationVal表示链接的计算出的主题相关度。待抓取链接队列是按照主题相关度递减排序的有序队列。

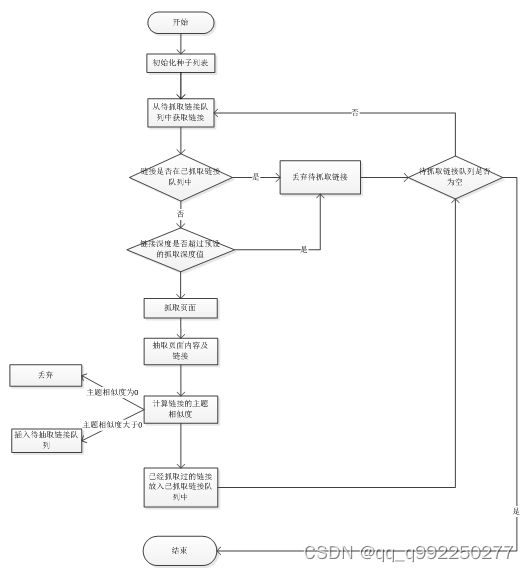

搜索策略的基本思路是:先从种子链接开始抓取,抽取页面上的链接,计算链接主题相关度,将链接按主题相关度大小插入待抓取链接队列中。详情如下图所示:

图5.2计算链接主题相关图

上图流程具体步骤如下:

(1)初始化种子列表。此步骤需要将种子列表初始化入待抓取链接列表,此步骤,将种子链接的深度设为0,主题相似度设为1。然后还需要预设抓取的深度。

(2)从待抓取链接队列中获取链接。

(3)判断待抓取的链接是否在已抓取链接队列。判断待抓取的链接是否在已抓取链接队列中,如果存在则跳到步骤(5)。

(4)丢弃待抓取链接。

(5)待抓取链接队列是否为空。判断待抓取列表是否为空,如果为空则结束。

(6)链接深度是否超过预设的抓取深度值。判断待抓取的链接的深度是否超过预设的抓取深度值,如果超过则跳转到步骤(4)。

(7)抓取页面。根据链接抓取网页。

(8)抽取页面内容及链接。

(9)计算链接的主题相似度。计算抽取出的链接的相似度,丢弃掉主题相似度为0的链接,将主题相似度大于0的链接插入到带抽取链接队列中。

(10)已经抓取过的链接放入已抓取链接队列中。将抓取过的链接放入已抓取链接队列中,然后跳转到步骤(5)。

5.3.2实验分析

实验的基本思路是:设定步长调节公式(5.3)中的参数,寻找最优的阈值。

本文选取“汽车”这个主题,选取网易和新浪这两个主流网站的链接作为种子链接。设定搜索深度depth为3,参数步长为0.1。

采用收获比的方式评价抓取效率。收获比(Harvest Rate)收获比(Harvest Rate)就是抓取到的网页中主题相关网页数目占所有抓取到的网页总数的比率。相应的计算公式如下:

(5-1)

其中,pages_downloadeds代表所抓取到的网页总数,而relevant_pages表示这些网页中与主题相关网页的数量。

图5.3网页中与主题相关网页的数量

如上图所示,当取值为0.6时能取得较好的效果。

第六章总结与展望

6.1总结

互联网的高速发展使得网络上的信息爆发时增长,信息庞大而杂乱。通用搜索引擎的内容陈旧、查全率查准率偏低、信息冗余等问题越来越不能满足用户特定的需求,所以,针对特定搜索领域的垂直搜索引擎逐渐成为研究热点。

本文在现有主题网络爬虫的研究的基础上,进一步进行探索,对于改进方式进行了详细的阐述。

为了提高爬虫对网页主题辨别的准确率,本文在网页预处理模块中,细致地分析了网页并构建了网页树,并对网页树进行减枝。然后,网页消噪也是网页预处理的重要步骤。

本文提出了基于实体链接的主题辨别算法。通过实体链接,更加准确且更多的获取到特征,从而提高主题辨别的准确性。

最后本文提出了基于Best-First算法的平台构建。通过综合父页面的主题相关度及链接锚文本的主题相似度综合评估链接的价值,然后,根据链接的价值决定抓取网页的顺序。

6.2展望

本文所设计的主题网络爬虫在搜索策略及架构方面做了一定的改进,但是还有注意一些问题。

一方面,网页的内容分析上,如果更好的去除网页的噪音,比如利用“统计学”及“视觉”。

另一方面,搜索策略上,可以尝试结合链接结构评价的方式,提高主题网络爬虫的爬行效率。

参考文献

[1]薛丽敏,吴琦,李骏.面向专用信息获取的用户定制主题网络爬虫技术研究[J].信息网络安全,2017(2).

[2]袁小玲.基于校园分布式主题网络爬虫技术基础框架实现研究[J].电子世界,2020,No.602(20):68-69.

[3]赵强.主题爬虫的关键技术[J].现代计算机:上下旬,2014.

[4]李慧,胡辉,庄冬梅.农产品供需对接系统中主题网络爬虫的设计与实现[J].现代计算机(专业版),2015,000(003):62-65.

[5]蒋宗礼,田晓燕,赵旭.一种基于语义分析的主题爬虫算法[J].计算机工程与科学,2010,32(009):145-147,151.

[6]樊多妮,李禹生.基于Heritrix的网络主题爬虫算法研究与应用——以粮食网站交易信息为例[J].新建设:现代物业上旬刊(9期):97-100.

[7]朱学芳,韩占校.一种图像主题网络爬虫的实现方法研究[J].南京师范大学学报(工程技术版),2008,8(004):115-117.

[8]周孝锞,郭克华.基于网络爬虫和改进的LCS算法的网站更新监测[J].计算机应用与软件,2017(1).

[9]面向专用信息获取的用户定制主题网络爬虫技术探究[J].电脑编程技巧与维护,2019,403(01):33-34.

[10]杨凌云.主题网络爬虫关键技术的应用探讨[J].电脑编程技巧与维护,2018,000(011):33-35.

[11]刘金红,陆余良.主题网络爬虫研究综述[J].计算机应用研究,2007,24(010):26-29.

[12]施磊磊,施化吉,宋玉平,等.基于Hadoop的分布式主题网络爬虫的设计与实现[J].信息技术,2015,000(007):109-112.

[13]盛亚如,魏振钢,刘蒙.基于主题网络爬虫的信息数据采集方法的研究与应用[J].电子技术与软件工程,2016,No.81(07):168-169.

[14]黄宇.分布式主题网络爬虫的设计与研究[J].黑龙江科技信息,2020,000(015):80-81.

[15]左薇,张熹,董红娟,等.主题网络爬虫研究综述[J].软件导刊,2020,v.19;No.208(02):284-287.

[16]牟宁,郭英杰,陈杰,等.面向社交网站的主题网络爬虫——以豆瓣网站为例[J].电脑知识与技术,2018,014(032):251-253.

[17]李俊,周玉英,唐志航.基于主题网络爬虫的服装信息采集[J].信息技术与信息化,2018,000(008):97-99.

[18]Drees D,Jiang X.Hierarchical Random Walker Segmentation for Large Volumetric Biomedical Data[J].2021.

[19]Ashley D,Kanervisto A,Bennett B.Back to Square One:Superhuman Performance in Chutes and Ladders Through Deep Neural Networks and Tree Search[J].2021.

[20]Madeira G,Izidoro,André,Winter S M G.Building the Galilean moons system via pebble accretion and migration:A primordial resonant chain[J].2021.

[21]Wu T,Liu Z,Huang Q,et al.Adversarial Robustness under Long-Tailed Distribution[J].2021.

[22]Yuan X,Zhao Y,Guo Y,et al.COSINE:A Web Server for Clonal and Subclonal Structure Inference and Evolution in Cancer Genomics[J].2021.

[23]Camisa A,Testa A,Notarstefano G.Multi-Robot Pickup and Delivery via Distributed Resource Allocation[J].2021.

[24]Kaiser M,Buklijas T,Gluckman P.Models and numbers:Representing the world or imposing order?[J].2021.

[25]Li Z.ANITA:An Optimal Loopless Accelerated Variance-Reduced Gradient Method[J].2021.

[26]Qiao J.An Improved Best-First Search Algorithm Based Focused Crawling Research[J].New Technology of Library and Information Service,2013.

[27]Nishizawa N,Kawai H.Unit selection algorithm based on best-first search for concatenative speech synthesis[J].Ieice Technical Report Speech,2006,105:67-72.

[28]Alhusainy M.Best-Job-First CPU Scheduling Algorithm[J].Information Technology Journal,2007,6(2).

[29]A-Husainy M.Best-Job First CPU Scheduling Algorithm[J].Information Technology Journal,2007.

[30]Marinescu R,Dechter R.Best-First AND/OR Search for Most Probable Explanations[J].Computer Science,2012.

[31]丁发梅.一种改进Best-First算法的主题爬虫搜索算法研究[D].重庆大学.

[32]Amirghasemi M.An Effective Decomposition-Based Stochastic Algorithm for Solving the Permutation Flow-Shop Scheduling Problem.2021.

[33]于林轩、李业丽、曾庆涛.PageRank算法在主题网络爬虫中的应用[J].北京印刷学院学报,2020,v.28(10):146-150.

[34]刘景发,李帆,蒋盛益.基于综合优先度和主机信息的暴雨灾害主题退火爬虫算法[J].计算机科学,2019,046(002):215-222.

[35]主题网络爬虫在校园网络平台监测中的应用研究[J].数码世界,2020,No.182(12):271-272.

[36]王鹏,郑贵省,郭强,等.基于网络爬虫的民用运力数据获取[J].军事交通学院学报,2020,v.22;No.150(01):91-94.

[37]郭锋锋.基于python的网络爬虫研究[J].佳木斯大学学报(自然科学版),2020,038(002):62-65.

[38]郑崇明.网民眼中的政府反腐败——基于网络爬虫和结构主题模型的分析(2012-2017)[J].广州大学学报(社会科学版),2020,019(002):91-100.

[39]刘亚琼.基于主题的社区挖掘算法[J].信息周刊,2020,000(004).1-1.

[40]孙陈娜,程祥.在线社交网络中基于主题的社交展示广告投放算法[J].2019.

[41]基于主题模型的热点新闻推荐算法研究[J].计算机科学与应用,2019,9(10):8.

[42]郑洪源.基于主题网络爬虫的程序设计资源库建设研究[J].大学教育,2019,000(009):76-79.

[43]朱熙曈.网络爬虫与KNN算法在房价分析中的应用[J].电脑编程技巧与维护,2019,No.404(02):105-106+121.

[44]宋婷婷.基于主题的多线程网络爬虫系统的研究[J].现代信息科技,2020,v.4(07):91-93+96.

[45]刘明洁,李珅,梁毅.基于网络爬虫的法律文本纠错词库构建[J].软件,2020,v.41;No.481(05):65-68.

[46]吴则建,王鹏虎,庞瑞江,等.主题网络爬虫在商业银行内部审计中的应用[J].中国内部审计,2019(11):50-53.

致谢

本论文是在我的老师悉心指导下完成的,从论文的选题、课题的执行、论文的撰写、论文的修改等各个方面都得到了老师细心的指导和帮助。大学生活中老师不仅在科研学习上给予我极大的帮助,而且在平时的生活中也给予我巨大的帮助与关心。同样,我在老师身上也学习到了很多东西,他严肃的科学态度、严谨的治学精神、精益求精的工作作风,这也将成为我在以后对待工作态度的标杆。在此我向老师表示诚挚的谢意,老师在平时的工作中的劳累以及为学生的操劳,望老师保重身体、一切顺利、万事如意。感谢毕业之际代我做毕业设计的老师,在我毕业设计中对我的帮助、关心与支持,以及师兄师姐们在我论文撰写期间以及平时生活给予我的帮助与关怀。感谢我的室友,陪我一起享受快乐的校园生活、陪我一起消磨无聊的时光、陪我一起渡过生活的难关,时刻与我共进退。感谢我的母校大学,虽然我即将毕业,但是对母校依旧怀有浓厚的感情,是母校给了我踏入社会大门的钥匙,让自己重新站到了一个新的起点上。学校给予我们无微不至的关怀,让我开心快乐的渡过校园到社会的过度阶段,给我们将来的工作生涯一个好的开始,同时给予我将来面对社会生活挑战的巨大信心。