NLP论文阅读记录-EMNLP2023| 04 GEMINI: Controlling The Sentence-Level Summary Style in Abstractive Text

文章目录

- 前言

- 0、论文摘要

- 一、Introduction

-

- 1.1目标问题

- 1.2相关的工作

- 1.3本文贡献

- 三.本文方法

-

- 3.1 句子级别的摘要风格

-

- Human Evaluation of Summary Style

- Automatic Detection of Summary Style

- Oracle Label for Summary Style

- 3.2 GEMINI:重写器生成器网络

-

- Input and Output

- Document Encoder

- Summary Decoder

- Training and Inference

- 四 实验效果

-

- 4.1数据集

- 4.2 对比模型

- 4.3实施细节

- 4.4评估指标

- 4.5 实验结果

-

- Automatic Evaluation

- Human Evaluation

- Ablation Study

- 五 Analysis

-

- 句子级别的摘要样式是可预测的吗?

- 自适应模型什么时候表现最好?

- 五 总结

-

- 局限性

前言

在这里插入图片描述

GEMINI:控制抽象文本摘要中的句子级摘要样式(2312 4)

code

paper

0、论文摘要

人类专家使用不同的技术编写摘要,包括从文档中提取句子并重写,或者融合文档中的各种信息以对其进行抽象。这些技术非常灵活,因此很难通过任何单一方法来模仿。为了解决这个问题,我们提出了一种自适应模型 GEMINI,它集成了重写器和生成器来分别模仿句子重写和抽象技术。 GEMINI 自适应地选择重写特定的文档句子或从头开始生成摘要句子。实验表明,我们的自适应方法在三个基准数据集上优于纯抽象和重写基线,在 WikiHow 上取得了最佳结果。有趣的是,实证结果表明,在给定上下文的情况下,人类总结句子的总结风格是一致可预测的。

一、Introduction

文本摘要旨在为给定的文本文档自动生成流畅、简洁的摘要(Maybury,1999;Nenkova 和 McKeown,2012;Allahyari 等人,2017)。使用了两种主要方法,即提取和抽象摘要技术。提取方法(Nallapati 等人,2017;Narayan 等人,2018;Liu 和 Lapata,2019;Zhou 等人,2020;Zhong 等人,2020)从输入中识别显着文本片段并将其组装成输出总结,导致忠实但可能冗余和不连贯的总结(Chen and Bansal,2018;Gehrmann et al.,2018;Cheng and Lapata,2016),其中重写技术可用于进一步减少冗余并增加连贯性(Bae et al.,2018)。 ,2019;鲍和张,2021)。相比之下,抽象方法(Rush et al., 2015;Nallapati et al., 2016;参见等人,2017; Lewis 等人,2020)应用自然语言生成(NLG)技术来合成输出,从而获得更简洁和连贯的摘要,但代价是忠实度降低(Huang 等人,2020;Maynez 等人,2020) 。

1.1目标问题

提取和抽象方法的有效性依赖于摘要的摘要风格。研究表明,人类在撰写每个摘要句子时采用不同的风格(Jing 和 McKeown,1999),我们将其大致分为提取风格和抽象风格。提取风格主要直接从文章句子中传达想法,而抽象风格则传达从各种文章句子中蕴含的新想法。图 1 显示了一个示例,其中摘要由两个句子组成。第一个句子是通过重写文档中的句子 生成的。相反,第二概要句子是通过抽象各种句子而生成的。这些风格非常灵活,因此很难通过单一方法来模仿。

1.2相关的工作

抽象摘要器通过对预训练的 seq2seq 模型进行微调,获得了有竞争力的结果(Lewis 等人,2020;Zhang 等人,2020)。我们的工作与小说风格控制对摘要句子的贡献相一致,使模型能够更好地适应“句子重写”和“远程抽象”风格中的人类摘要。我们的生成器是一个标准的 seq2seq 模型,与 BART 具有相同的架构(Lewis et al., 2020),我们的重写器与之前的单句重写相关(Chen and Bansal, 2018;Bae et al., 2019;Xiao et al., 2019)。 ,2020)和情境化重写(Bao 和Zhang,2021)。

我们的重写器使用上下文重写机制,它考虑每个重写句子的文档上下文,以便可以回忆上下文中的重要信息并保持跨句子的连贯性。然而,与Bao和Zhang(2021)依赖外部提取器来选择句子不同,我们使用指针机制集成了内部提取器(Vinyals et al., 2015),类似于NeuSum(Zhou et al., 2020)自回归选择句子。据我们所知,我们是第一个将重写器和生成器集成到独立的抽象摘要器中的人。

1.3本文贡献

在本文中,我们的目标是模仿人类摘要样式,我们相信这可以提高我们控制样式的能力并加深我们对人类摘要如何生成的理解。为了更好地适应人类摘要中的摘要样式,我们提出了一种自适应模型 GEMINI,它包含一个重写器和一个生成器,分别模仿提取风格和抽象风格。

对于重写器,我们采用与内部句子提取器集成的上下文重写(Bao 和Zhang,2021)。

对于生成器,我们使用标准 seq2seq 摘要器(Lewis et al., 2020)。

重写器和生成器集成到单个解码器中,使用风格控制器来切换生成的风格。风格控制器分配不同的组标签,以便输入中的相关句子可以用来指导解码器。在抽象风格中,解码器不关注特定的句子,而在提取风格中,解码器通过更多地关注特定的重写句子来引导。为了训练这样的自适应摘要生成器,我们使用句子级摘要样式的自动检测来生成 oracle 提取/抽象样式。我们在三个代表性基准数据集上评估我们的模型。结果表明,GEMINI 通过区分摘要样式,使模型能够更好地拟合训练数据。我们的自适应重写器生成器网络的性能优于强大的抽象基线和最近的重写器模型,在基准测试中具有显着的优势。有趣的是,实验还表明,在测试期间可以一致地预测句子的摘要风格,这表明人类在上下文中选择摘要句子的摘要风格具有下划线一致性。据我们所知,我们是第一个明确控制每个摘要句子的风格,同时提高 ROUGE 分数的人。我们的自动风格检测指标允许将来对摘要风格进行进一步的定量分析。

我们的模型 GEMINI 也可以被视为专家的混合体(Jacobs et al., 1991),它在重写器和生成器之间动态切换。一项相关工作是用于 seq2seq 建模的指针生成器网络(参见 et al., 2017),它也可以被视为专家混合模型。另一个相关的工作是HYDRASUM,它有两个解码专家。这些模型可以被视为专家的软混合体,它学习潜在专家并通过整合他们的输出来做出决策。相比之下,我们的模型可以被视为专家的硬混合,它在做出决定时咨询重写者或生成者。这两个模型之间的一个显着区别是,我们的 GEMINI 为每个句子做出决策,而以前的工作是在令牌级别做出决策。模型的目标非常不同。

三.本文方法

3.1 句子级别的摘要风格

Human Evaluation of Summary Style

我们对每个摘要句子的摘要风格进行人工评估,如果摘要句子可以由一个冠词句子暗示,则注释为提取风格;如果摘要句子需要多个冠词句子来暗示,则注释为抽象风格。我们为每个数据集抽取 100 个摘要句子,并要求三个注释者对其进行注释,其中我们将获得至少两票的样式作为最终标签。

风格的平均分布如表1所示。CNN/DM主要是抽取式风格,其中88.6%的摘要句子是以抽取式风格编写的。相比之下,XSum 主要是抽象风格,其中88.2%的摘要句子是用抽象风格写的。 WikiHow 的摘要样式分布更加均衡,大约 60% 的摘要句子采用摘录样式。结果表明,真实的摘要是多种风格的混合体,即使对于众所周知的提取数据集 CNN/DM 和抽象数据集 XSum 也是如此。

Automatic Detection of Summary Style

由于人工注释的成本很高,我们转向自动方法来检测句子级别的摘要样式。以往的研究主要是在摘要层面衡量摘要风格。例如,格鲁斯基等人。 (2018)提出了可提取碎片的覆盖范围和密度来衡量可提取性。参见等人。 (2017) 提出出现在摘要中但未出现在输入文档中的新颖 n 元语法的比例,作为抽象性指标。

我们将这些指标应用于句子,并将它们作为我们方法的基线。我们提出融合指数来衡量上下文信息的融合程度(Barzilay and McKeown,2005),考虑两个因素:

1)从一个文档句子中可以回忆起多少来自摘要句子的信息?如果召回率高,则该句子更有可能是提取式的,因为它可以通过简单地重写文档句子来产生。

2)摘要句子涉及多少个文档句子?此类句子数量越多,融合程度越高,概括句更可能是抽象风格。我们的融合指数是根据这两个因素计算的。

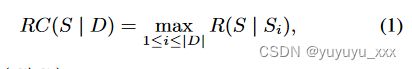

**Recall。**我们通过将摘要句子与文档句子进行匹配来衡量可回忆信息的百分比。给定一个摘要句子 S 和源文档 D = {S1, S2, …, S|D|},我们找到最佳匹配

其中R(S|Si)是给定Si的S的ROUGE-1/2/L回忆的平均值,代表句子Si覆盖句子S的信息的百分比。

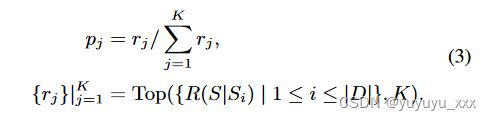

**Scatter.**我们通过将句子与所有文档句子进行匹配来测量摘要句子内容的分散度。如果匹配分数均匀分布在所有文档句子上,则分散度较高;如果除了一个文档句子之外,匹配分数全部为零,则分散度较低。我们使用从匹配分数得出的分布熵来计算分散度

其中 pj 是 S 是否从相应文档句子 Si 生成的估计概率,使用前 K 个最佳匹配 {rj}|jK=1 计算得出

超参数 K 通过对人类评估集的经验搜索来确定。

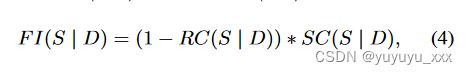

**Fusion index.**我们根据召回率(RC)和分散度(SC)计算融合指数(FI)

表示融合程度,0表示不融合,1表示极度融合,其他介于两者之间。

我们与之前研究中的候选指标一起评估我们的指标,报告皮尔逊与人工注释摘要样式的相关性,如表 2 所示。我们提出的融合指数给出了与摘要样式的最佳相关性。相比之下,在之前的指标中,只有新颖的 1-gram 具有最接近的相关性,但仍然比融合指数平均低约 0.14。结果表明,融合索引是句子级别更合适的提取-抽象度量。

Oracle Label for Summary Style

我们使用自动融合索引生成预言机提取/抽象标签,以便我们可以训练摘要器在句子级别具有明确的样式控制。如果融合指数高于阈值,我们将句子视为提取风格。如果摘要句子的融合指数低于阈值,我们将该句子视为抽象风格。我们使用开发实验来搜索每个数据集的最佳阈值。

3.2 GEMINI:重写器生成器网络

如图 2 所示,GEMINI 采用预训练的 BART(Lewis et al., 2020),使用样式控制器来决定摘要样式。根据样式,激活重写器或生成器来生成每个句子。直观上,GEMINI 在处理具有平衡风格的数据集时表现最好,这使得重写器和生成器能够互补,并且当预言机风格具有高精度时,使得训练监督可以是高质量的。

Input and Output

我们引入特殊的标识符标记,包括“” - 文档的开头,“” - 句子k的开头,以及“” - 句子的结尾。我们将输入文档表示为“ 句子一”。 第二句。 第三句。 …”,其中序列以标识符标记“”开头,并用“”和“”将每个句子括起来。我们将输出摘要表示为“ 句子一”。 句子二。 …”,其中每个句子以“”或“”开头,以“”结尾。如果摘要句子以“”开头,则解码器将根据第k个文档句子生成句子。如果摘要句子以“”开头,解码器将根据整个文档生成句子。

Document Encoder

我们扩展嵌入表以包含标识符标记,以便样式控制器可以匹配它们的嵌入来决定摘要样式。我们遵循上下文重写(Bao和Zhang,2021)为每个输入句子分配一个组标签,以便重写器可以依靠这些组标签使用多头注意力来定位重写的句子,如组标签 1 ⃝2 ⃝3 ⃝图2说明。具体来说,第一个摘要句子和第二个文档句子具有相同的组2 ⃝ 的标签,将其转换为组标签嵌入并添加到句子中的标记嵌入中。使用编码器和解码器之间共享的组标签嵌入表,可以训练解码器在生成第一个摘要句子时专注于第二个文档句子。形式上,我们将组标签嵌入表表示为 EMBtag,并根据每个句子的索引从 X 中唯一生成一个组标签序列 GX:

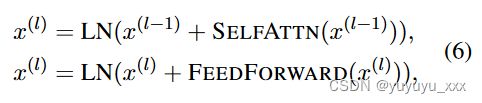

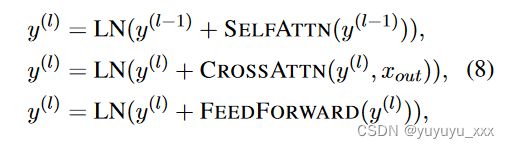

其中,对于第 k 个句子 Sk 中的标记 wi,我们分配一个编号为 k 的组标签。我们将 GX 转换为嵌入并将其注入 BART 编码器中。我们采用标准的 Transformer 编码层,其中包含自注意力模块和前馈模块:

其中 LN 表示层归一化(Ba et al., 2016)。最后一层 L 输出最终编码器输出 xout = x(L)。矢量 xemb 和 xout 被传递到解码器进行预测。

Summary Decoder

我们使用样式控制器和重写器扩展 BART 解码器,而对于生成器,我们使用默认解码器。

**Style Controller.**我们使用注意力指针(Vinyals et al., 2015)来预测样式,其中我们权衡每个输入句子(“”上的注意力)或整个文档(“”上的注意力)。如果“”获得最大的注意力分数,我们选择abs样式,如果获得最大的注意力分数,我们选择ext样式。

在摘要的开头或摘要句子的结尾,我们预测下一个摘要句子的风格。我们将令牌输出与编码器输出进行匹配来决定选择。

其中 α 是可训练标量,用于混合编码器输出 xout 和令牌嵌入 xemb。我们将这些混合嵌入与解码器输出 yout 相匹配,获得指针分布的 logits ymatch 。我们只保留句子标识符的 logits,包括“”和“”,并使用 softmax 函数预测分布。

我们使用标准解码器作为重写器和生成器的骨干。对于重写器,我们遵循 Bao 和Zhang (2021) 将组标签嵌入应用于解码器的输入。对于生成器,我们不应用组标签嵌入,因此它不对应于任何文档句子。形式上,给定摘要 Y = {wj}||Y | j=1,我们根据标识符标记“”和“”从Y唯一生成GY,对于以“”开头的句子中的每个标记wi,组标记是k并且对于该使用“”时,组标签为 0。例如,如果 Y 是序列“ w1 w2 w3 w4 …”,则 GY 将是 { 2, 2, 2, 2, 0, 0, 0, 0, 7, …}。我们不更改解码层,其中每个解码层包含一个自注意力模块、一个交叉注意力模块和一个前馈模块:

其中 LN 表示层归一化(Ba et al., 2016)。最后一层L输出最终的解码器输出you。然后,解码器输出 yout 与标记嵌入相匹配,以预测下一个标记。

Training and Inference

我们使用 MLE 损失来进行 token 预测和风格预测。我们将总体损失计算为

其中Lstyle是风格预测的MLE损失,Ltoken是token预测的MLE损失。由于风格和性质不同

对于 token 预测,我们使用超参数 κ 来协调它们的收敛速度。在实践中,我们根据开发集上的最佳性能来选择κ。在推理过程中,首先激活样式控制器来决定 ext/abs 样式。如果选择 ext 样式,则匹配的句子标识符“”将用于为后续标记生成组标签。如果它选择abs样式,我们将使用特殊的组标签0来制作标记。

四 实验效果

4.1数据集

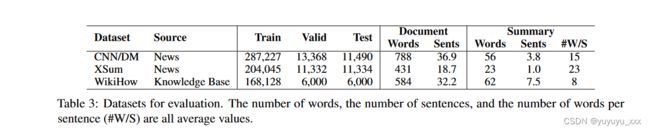

我们使用代表不同风格和领域的三个英语基准数据集,如表 3 所示。CNN/DailyMail(Hermann 等人,2015)是最流行的单文档摘要数据集,包括在线新闻文章和人工撰写的摘要。 XSum(Narayan 等人,2018)是一种抽象风格的摘要数据集,基于由专业作者撰写的单句摘要的新文章构建。 WikiHow(Koupaee 和 Wang,2018)是从人类作者编写的在线知识库 WikiHow 中提取的多样化摘要数据集。

4.2 对比模型

4.3实施细节

为了生成预言风格,我们分别对 CNN/DM、XSum 和 WikiHow 使用融合指数阈值 γ = 0.7、γ = 0.7 和 γ = 0.3。

我们使用两阶段策略来训练 GEMINI:预微调新参数,然后联合微调所有参数。由于我们向预训练的 BART 引入了额外的结构和新参数,因此直接联合微调这两类参数可能会导致预训练参数的降级。我们引入预微调来通过冻结预训练参数来准备随机初始化参数,并在联合微调之前微调 8 个 epoch。我们对两个阶段使用相同的 MLE 损失,并使用 κ = 1.1 的收敛协调参数。

4.4评估指标

ROUGE-1/2/L(Lin,2004)。

4.5 实验结果

Automatic Evaluation

如表 4 所示,我们在三个基准数据集上评估我们的模型,并与公平环境中其他基于 BART 的模型进行比较。我们报告自动度量ROUGE-1/2/L(Lin,2004)。

与抽象的 BART 基线相比,GEMINI 在 CNN/DM、XSum 和 WikiHow 上的 ROUGE 分数平均分别提高了 1.01、0.48 和 1.25。的改进CNN/DM 的 ROUGE-L 和 WikiHow 的 ROUGE-2 尤其显着,分别达到 1.44 和 1.56。

结果表明,自适应方法比纯抽象模型具有明显的优势。与依赖外部提取器提供重写句子的重写器基线 BARTRewriter 相比,GEMINI 在 CNN/DM 上将 ROUGE-1/L 分数提高了约 1.0,证明了自适应方法与纯重写器相比的有效性。与 HYDRASUM 相比,HYDRASUM 使用专家混合隐式表达摘要样式,但获得的 ROUGE 分数低于 BART 基线,GEMINI 使用显式风格控制实现了改进的 ROUGE 分数。

结果证明了具有自适应样式的模型相对于纯重写器和隐式样式控制的优势。表 4 列出了最近使用更大规模的预训练、组装、重新排序和强化学习技术的其他工作。然而,这些模型不能与我们的模型直接比较。例如,PEGASUS(大型)有 568M 参数,比 BART(大型)400M 多出 42%。 **BRIO 使用 4 个 NVIDIA RTX 3090 GPU 在 CNN/DM 上训练每个 epoch 需要 20 小时,总共 15 个 epoch,而我们的模型在同一设备上每个 epoch 只需要 2 小时,总共 11 个 epoch,仅使用 7 个BRIO 的计算资源百分比。**我们不将这些模型作为我们的基线,因为它们处于不同的工作领域,使用与本研究垂直的技术。更重要的是,我们关注句子级摘要风格及其控制,而不仅仅是 ROUGE 改进。

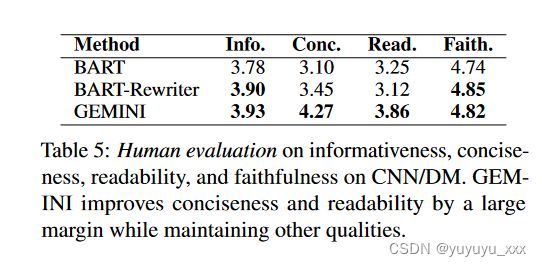

Human Evaluation

我们进行人工评估,以定量衡量生成的摘要的质量。我们将 GEMINI 与 BART 和 BART-Rewriter 基线进行比较,研究四种品质,包括信息性、简洁性、可读性和忠实性。我们关注最近的 HYDRASUM(Goyal 等人,2022)和 SummaReranker(Ravaut 等人,2022)从CNN/DM的测试集中抽取50份文档进行评估。我们聘请了三名具有专业英语水平的研究生(托福成绩在 100 分(满分 120 分)以上)对每个候选人的摘要进行注释,从 1(最差)到 5(最好),并报告三位注释者的平均分数。如表 5 所示,GEMINI 总体得分最高,尤其是在简洁性和可读性方面。与 BART-Rewriter 相比,GEMINI 在信息性和忠实性方面得分接近,但在简洁性和可读性方面得分较高。与 BART 相比,GEMINI 在四个指标上获得了更好的分数。 GEMINI显式的风格控制起到了粗略规划者的作用,限制了内容的生成。根据经验,它生成的摘要的句子数量(3.3 个发送/摘要)少于 CNN/DM 上的 BART(3.9 个发送/摘要)和 BART-Rewriter(3.7 个发送/摘要)。因此,GEMINI 生成了更简洁的摘要,其长度比 BART 短 20%,比 BART-Rewriter 短 10%,但仍获得更高的 n 元语法召回率,如表 4 中较高的 ROUGE-1/2 所示,这表明生成的摘要GEMINI 往往拥有更密集的信息。我们推测 GEMINI 的高可读性是其风格预测和句子生成的自回归建模的结果,通过该模型优化了风格转换。我们在附录A中列举了两个案例来说明GEMIN在简洁性和可读性方面的优势。

Ablation Study

Rewriter vs. Generator.

我们通过分别观察重写器和生成器的贡献来进一步研究我们的自适应模型。我们根据平均融合指数将CNN/DM中的测试样本分为10个桶,获得每个桶的平均ROUGE-1/2/L分数。我们

比较重写器(rwt)和生成器(gen)的ROUGE分数如图3所示。

我们可以看到,重写器在低融合指数区域上占主导地位,而生成器则在高融合指数区域上占主导地位。重写器和生成器的 ROUGE 分数分布说明了两种风格的专业化。

Pre-finetuning

预微调改变随机初始化参数的分布。以 CNN/DM 上的 GEMINI 为例。句子标识符和组标签的嵌入的初始平均范数均为 0.06,故意将其设置为较小的值,以减少对预训练网络的负面影响。如果我们直接对模型进行微调,训练后的模型对于句子标识符和组标签的平均范数分别为 0.44 和 0.17。然而,如果我们对模型进行 8 个时期的预调整,平均范数将分别攀升至 0.92 和 0.63。经过后续微调,平均范数分别收敛到0.66和0.50,远高于直接微调的模型。

如果我们删除预微调,GEMINI 在 CNN/DM 上的性能分别从 45.27、21.77 和 42.34 下降到 ROUGE-1/2/L 上的 44.76、21.60 和 41.71,这表明预微调的必要性阶段。

五 Analysis

句子级别的摘要样式是可预测的吗?

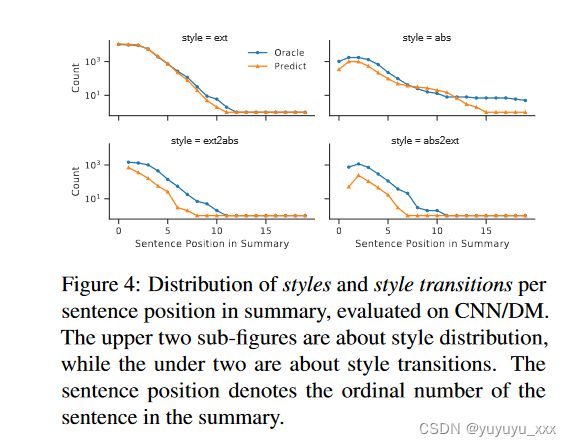

我们使用预言机风格来训练我们的模型,这使得模型更容易训练。然而,在测试过程中,每个句子的摘要风格可以任意选择。测试集中的风格是否在某种程度上是可预测的,仍然是一个有趣的研究问题。我们尝试使用 CNN/DM 风格分布的定量分析来回答这个问题。我们获得的风格预测 F1 为 0.78,其中更详细的分布如图 4 中的上部子图所示。

预测风格的分布与预言风格的分布相匹配,除了 15 以上的句子位置之间的狭窄范围外。 ,其中预测的腹肌风格比预言机腹肌风格的可能性更小。对于风格转换的分布,如下图所示,从 ext-to-abs 和 abs-to-ext 的转换显示了预测和预言机之间的一些差异,其中预测的风格转换总体上比预言机出现的频率要低风格转变但趋势相同。这些数字显示了预测风格和预言风格分布的一致性,表明风格在一定程度上是可预测的。我们通过使用随机选择的样式和预言样式与 GEMINI 解码的性能进行比较,进一步评估预测样式的贡献。如表 6 所示,当我们用随机样式替换预测样式时,CNN/DM 上的性能平均下降了 2.58 ROUGE 点,WikiHow 上的性能平均下降了 1.26 点。性能下降表明模型的风格预测为生成高质量的摘要提供了有用的信息。预测能力来自于对输入文档的理解。这也表明,在考虑到现有上下文的情况下,选择摘要句子的摘要风格存在一致的趋势。

自适应模型什么时候表现最好?

直观上,GEMINI 在具有平衡风格的数据集上效果最好,因此重写器和生成器可以相互补充。更重要的是,预言机样式需要准确,才能获得高质量的监管信号。

首先,数据集的分布很重要。在这三个数据集中,WikiHow 的风格最为平衡,有 61.1% 的摘要句子倾向于重写。结果,与纯抽象基线相比,GEMINI 在 WikiHow 上获得了最大的性能提升,平均提高了 1.25 ROUGE 点,证实了我们对数据集分布和模型性能之间关系的直觉。

其次,互补的重写器和生成器是必要的先决条件。如图3所示,CNN/DM上的重写器和生成器能力相对均衡,当融合指数低于0.55时优先选用重写器,高于0.55时优先选用生成器。相比之下,如图 5 所示,WikiHow 上的重写器和生成器的能力存在偏差,其中重写器较弱,仅在融合指数低于 0.15 时才首选。

因此,GEMINI 只为 19.3% 的摘要句子生成 ext 风格,而人类评估为 61.1%。分析表明,WikiHow 上的 GEMINI 可以通过使用更好的重写器来进一步增强,这可能通过使用改进的句子提取器来实现。最后,预言机风格的质量决定了两个生成器的专业化。如表2所示,WikiHow上融合指数的Pearson相关性仅为0.56,远小于CNN/DM上的0.76。它建议通过开发更好的自动指标来进一步改进预言风格。

五 总结

我们研究了人类撰写的摘要的句子级摘要样式,并评估了三个基准数据集的样式分布。我们提出了一种融合索引度量来自动检测句子级摘要样式,使用它我们生成用于训练自适应模型的预言样式。实验表明,我们的 GEMINI 在基准测试中显着优于纯抽象和重写基线,证明了摘要样式中细粒度控制的有效性。

局限性

在本文中,我们在句子级别模拟人类摘要样式,并更好地理解人类摘要的生成方式。基于这种理解,研究人员可以将 GEMINI 用于不同的目的。首先,在开发新数据集时,可以使用自动度量融合索引来分析风格分布。其次,GEMINI 可用于控制句子级别的摘要样式。由于ext式概括句自然比abs式概括句更不容易产生幻觉,因此我们可以通过确定abs式概括句的比例来控制忠实风险。最后,GEMINI 为每个摘要句子生成了明确的样式,因此我们甚至可以通过在关键应用中标记这些ABS 样式的摘要句子来警告忠实的风险。

GEMINI可以适应特定数据集的摘要风格,使得重写器和生成器专门针对不同的情况,这可以提高重写器和生成器的质量。然而,我们不知道这种自适应方法是否真的提高了摘要生成模型的“抽象”能力。目前我们还没有可靠的衡量抽象能力的方法来评估经过训练的生成器。我们将在未来的研究中考虑它。