CentOS 7 图形化(GUI) 安装Oracle 11G RAC

文章目录

-

- 准备规划

-

- 网络规划

- 共享存储规划

- 方案

-

- 1、主机名配置

- 2、创建用户组及用户

- 3、关闭并禁用firewalld和selinux

- 4、关闭并禁用avahi-daemon

- 5、关闭透明大页和NUMA

- 6、禁用NTP服务

- 7、配置内核参数

- 8、限制用户资源使用

- 9、配置用户环境变量

- 10、创建软件目录

- 11、配置SSH互信

- 12、配置共享存储

-

- 非多路径方式

-

- 1、查看磁盘的scsi_id

- 2、绑定磁盘

- 3、生效

- 4、验证

- 5、重启后再次验证

- 多路径方式

-

- 1、安装多路径

- 2、查看节点1磁盘的scsi_id

- 3、绑定磁盘

- 4、保存并加载多路径

- 1、安装多路径

- 2、查看节点2磁盘的scsi_id

- 3、绑定磁盘

- 4、保存并加载多路径

- UDEV配置

-

- 1、新增规则,有多少多路径配置就需要增加多少条规则。

- 2、重新加载udev

- 3、验证

- 1、新增规则,有多少多路径配置就需要增加多少条规则。

- 2、重新加载udev

- 3、验证

- 4、重启服务器验证

- 13、上传软件包、解压并授权

- 14、安装依赖包

- 15、校验

- 16、安装Grid软件

-

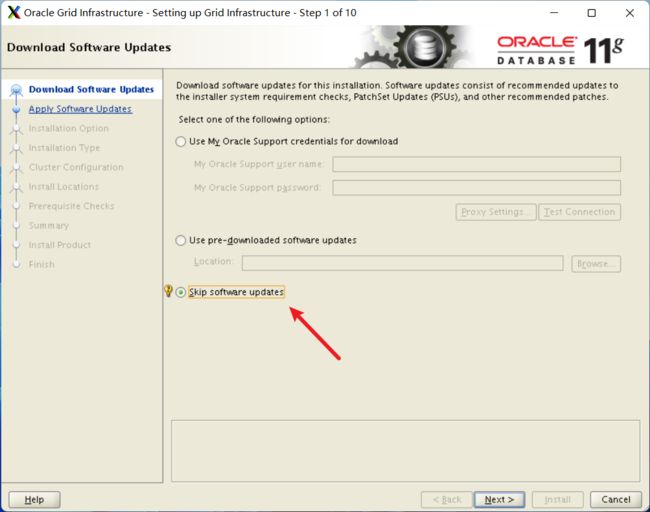

- 跳过软件更新

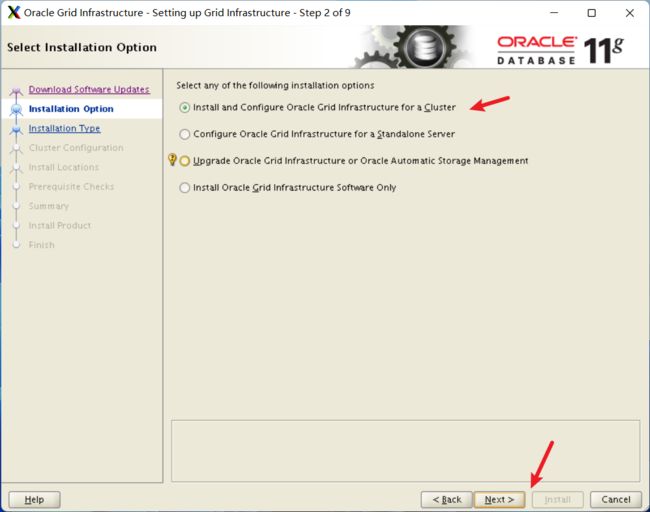

- 安装配置Grid软件

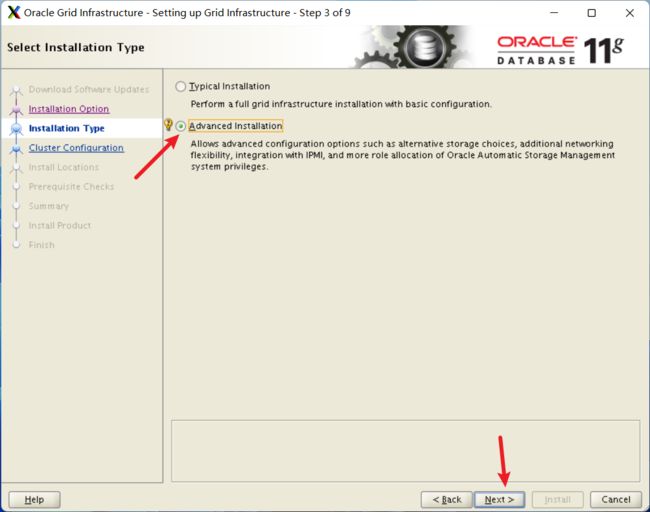

- 高级安装

- 选择语言

- 配置集群名称

- 添加节点

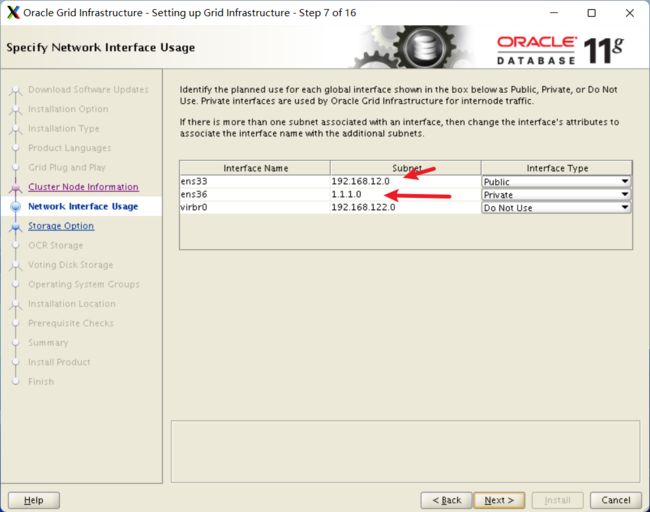

- 网络接口确认

- OCR存储选择

- 创建磁盘组

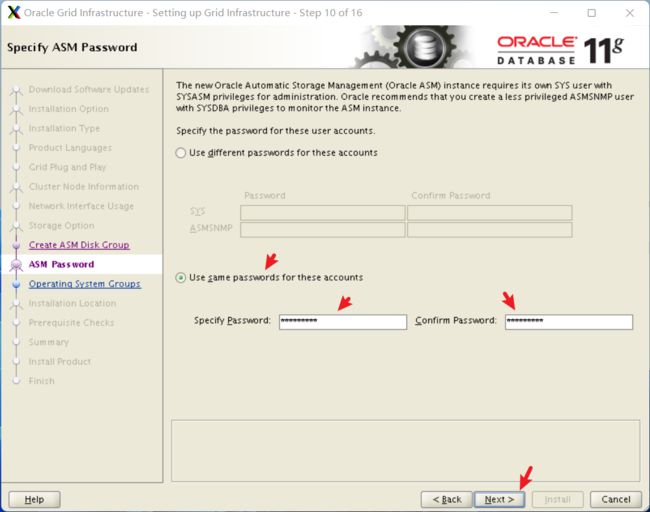

- 设置密码

-

- 配置IPM

- 配置用户组

- 配置安装目录

- 清单目录确认

- 先决条件检查

- 确认所有信息

- 执行脚本

-

- 完成Grid安装

- 16、配置其他ASM磁盘

- 17、安装数据库软件

-

- 配置安全更新

- 配置软件更新

- 配置安装选项

- Grid安装选项

- 选择语言

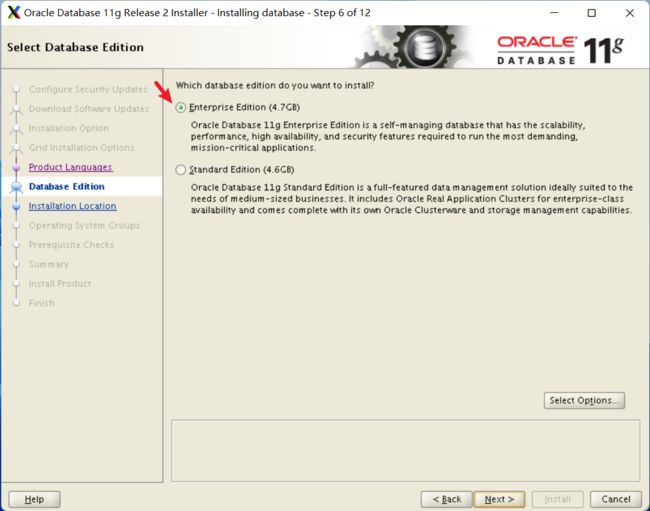

- 配置数据库版本

- 配置安装目录位置

- 操作系统组配置

- 执行root脚本

- 安装完成

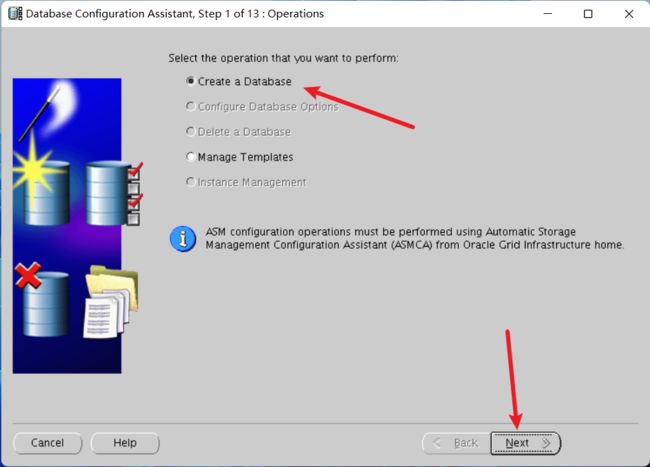

- 18、安装数据库实例

-

- 集群选项

- 数据库选项

- 选择数据库类型

- 选择管理策略

- 配置企业管理和自动任务

- 配置默认用户密码

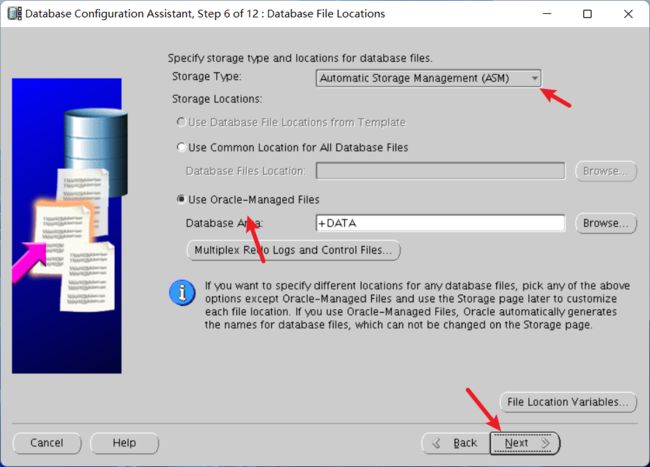

- 配置数据库文件存储

- 配置快速闪回区存储

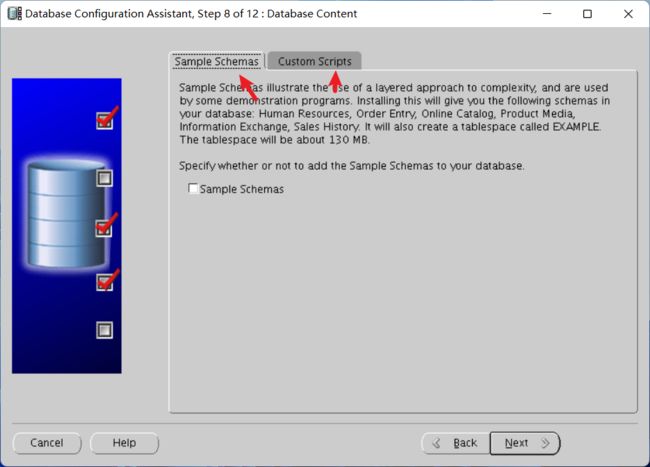

- 配置示例方案和安装后脚本

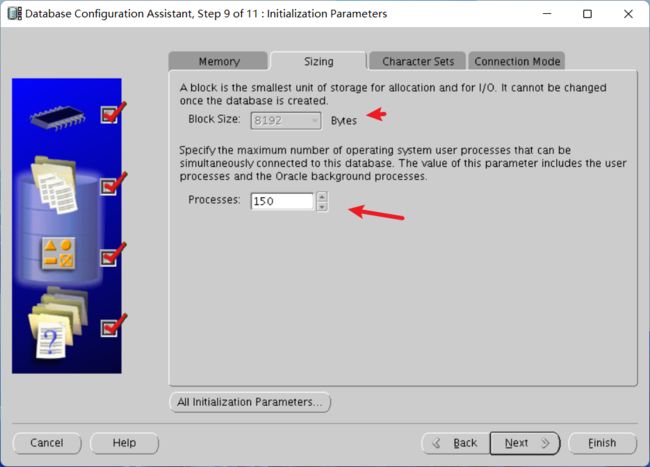

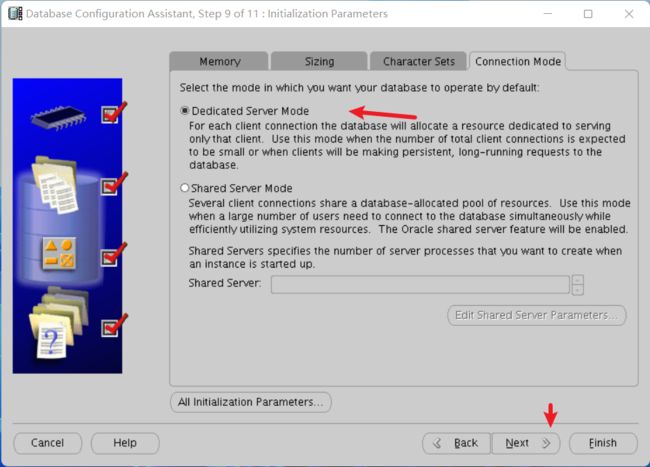

- 配置初始化参数

- 配置数据库存储

- 指定创建数据库

- 再次确认数据库信息

- 完成安装

- 错误

-

- 1、Package:pdksh-5.2.14

- 2、Device Checks for ASM

- 3、执行脚本root.sh脚本报错CRS-2101:The OLR was formatted using version 3.

- 4、安装Grid最后报错INS-20802

- 5、安装database软件报错

- 6、执行节点2的root脚本时报错

准备规划

对于Oracle RAC环境来说,在最初就需要规划好网络和共享磁盘。

网络规划

Oracle RAC对于网络有以下要求:

-

每个节点必须具有至少两个以上的网卡,一张网卡对外提供网络服务,另一张网卡用于各个节点间的通信和心跳检测等(私网)。

-

在配置RAC集群的网卡时,如果节点1的公共接口是eth0,则所有节点的公共接口必须是eth0。(配置私有网口时也必须一致)

-

每个节点的主机名必须符合RFC 952标准,不允许使用下划线。

对于Oracle 11G RAC双节点来说,Oracle要求我们至少有7个ip地址,Public IP、Virtual IP和Scan IP在同一个网段下,Private IP在另一个网段中。

因此,我在虚拟机中配置了两张网卡,一张网卡以桥接模式运行,另一张以仅主机模式运行。在两张网卡的基础上,配置了如下主机名及IP地址:

| 主机名 | rac-1 | rac-2 |

|---|---|---|

| Public IP | 192.168.12.20 | 192.168.12.21 |

| Private IP | 1.1.1.1 | 1.1.1.2 |

| Virtual ip | 192.168.12.22 | 192.168.12.23 |

| Scan ip | 192.168.12.100 | 192.168.12.100 |

共享存储规划

每个硬件提供厂商都有不同的共享存储解决方案,我这里测试使用的是VMware Workstation Pro虚拟机来配置共享存储。

在创建共享存储时,建议是OCR给3个磁盘,每个在1G-10G左右就足够了,冗余模式选择Normal,有条件的可以选择High;DATA盘尽量给多点空间,毕竟是要存储数据,需要根据业务去评估数据的大小,而我这里是测试使用,因此仅分配50G,冗余选择External;FRA可配也可不配置,如果不配置就将其放在Linux的文件系统中。配置如下表所示:

| 磁盘名 | 磁盘数量 | 磁盘大小 | 冗余模式 |

|---|---|---|---|

| OCR | 3 | 10G/个 | Normal |

| DATA | 1 | 50G | External |

| FRA | 1 | 20G | External |

方案

1、主机名配置

首先是配置两台节点的主机名,通常将其改成辨识度高的主机名。我这里分别修改为rac-1,rac-2。

rac-1

# 修改主机名

[root@localhost ~]# hostnamectl set-hostname rac-1

# 编辑配置文件hosts

[root@localhost ~]# vim /etc/hosts

修改rac-1的hosts文件,在下面新增映射规则,修改后保存并退出。

# Public ip

192.168.12.20 rac-1

192.168.12.21 rac-2

# Private ip

1.1.1.1 rac-1-priv

1.1.1.2 rac-2-priv

# Virtual ip

192.168.12.22 rac-1-vip

192.168.12.23 rac-2-vip

# Scan ip

192.168.12.100 rac-scan

配置好后刷新主机名

[root@localhost ~]# exec bash

rac-2

# 修改主机名

[root@localhost ~]# hostnamectl set-hostname rac-2

# 编辑配置文件hosts

[root@localhost ~]# vim /etc/hosts

修改rac-2的hosts文件,在下面新增映射规则,修改后保存并退出。

# Public ip

192.168.12.20 rac-1

192.168.12.21 rac-2

# Private ip

1.1.1.1 rac-1-priv

1.1.1.2 rac-2-priv

# Virtual ip

192.168.12.22 rac-1-vip

192.168.12.23 rac-2-vip

# Scan ip

192.168.12.100 rac-scan

配置好后刷新主机名

[root@localhost ~]# exec bash

2、创建用户组及用户

配好主机名后,在两台节点上创建grid和oracle的管理用户。

rac-1

# 新建用户组oinstall

[root@rac-1 ~]# groupadd oinstall -g 500

# 新建用户组dba

[root@rac-1 ~]# groupadd dba -g 501

# 新建用户组oper

[root@rac-1 ~]# groupadd oper -g 502

# 新建用户组asmadmin

[root@rac-1 ~]# groupadd asmadmin -g 2003

# 新建用户组asmdba

[root@rac-1 ~]# groupadd asmdba -g 2004

# 新建用户组asmoper

[root@rac-1 ~]# groupadd asmoper -g 2005

# 创建oracle用户并加入到相应组中

[root@rac-1 ~]# useradd -u 500 -g oinstall -G dba,oper,asmdba,asmadmin,asmoper -d /home/oracle oracle

# 创建grid用户并加入到相应组中

[root@rac-1 ~]# useradd -u 2001 -g oinstall -G asmadmin,asmdba,asmoper,dba -d /home/grid grid

# 设置oracle用户密码

[root@rac-1 ~]# passwd oracle

# 设置grid用户密码

[root@rac-1 ~]# passwd grid

rac-2

# 新建用户组oinstall

[root@rac-2 ~]# groupadd oinstall -g 500

# 新建用户组dba

[root@rac-2 ~]# groupadd dba -g 501

# 新建用户组oper

[root@rac-2 ~]# groupadd oper -g 502

# 新建用户组asmadmin

[root@rac-2 ~]# groupadd asmadmin -g 2003

# 新建用户组asmdba

[root@rac-2 ~]# groupadd asmdba -g 2004

# 新建用户组asmoper

[root@rac-2 ~]# groupadd asmoper -g 2005

# 创建oracle用户并加入到相应组中

[root@rac-2 ~]# useradd -u 500 -g oinstall -G dba,oper,asmdba,asmadmin,asmoper -d /home/oracle oracle

# 创建grid用户并加入到相应组中

[root@rac-2 ~]# useradd -u 2001 -g oinstall -G asmadmin,asmdba,asmoper,dba -d /home/grid grid

# 设置oracle用户密码

[root@rac-2 ~]# passwd oracle

# 设置grid用户密码

[root@rac-2 ~]# passwd grid

3、关闭并禁用firewalld和selinux

为避免在安装过程中受到firewalld和selinux的影响,导致安装失败,暂时将它们全部禁用掉。

rac-1

# 停止firewalld服务运行

[root@rac-1 ~]# systemctl stop firewalld

# 禁用firewalld服务自启动

[root@rac-1 ~]# systemctl disable firewalld

# 禁用selinux自启动

[root@rac-1 ~]# sed -i 's/SELINUX=enforcing/SELINUX=disabled/g' /etc/selinux/config

# 立即停止selinux

[root@rac-1 ~]# setenforce 0

rac-2

# 停止firewalld服务运行

[root@rac-2 ~]# systemctl stop firewalld

# 禁用firewalld服务自启动

[root@rac-2 ~]# systemctl disable firewalld

# 禁用selinux自启动

[root@rac-2 ~]# sed -i 's/SELINUX=enforcing/SELINUX=disabled/g' /etc/selinux/config

# 立即停止selinux

[root@rac-2 ~]# setenforce 0

4、关闭并禁用avahi-daemon

avahi-daemon服务可能会在网卡流量大的时候,造成网络请求障碍,因此禁用它。

rac-1

# 停止avahi-daemon服务

[root@rac-1 ~]# systemctl stop avahi-daemon

# 禁用avahi-daemon服务的自启动

[root@rac-1 ~]# systemctl disable avahi-daemon

# 配置NOZEROCONF参数

[root@rac-1 ~]# echo 'NOZEROCONF=yes' >> /etc/sysconfig/network

rac-2

# 停止avahi-daemon服务

[root@rac-2 ~]# systemctl stop avahi-daemon

# 禁用avahi-daemon服务的自启动

[root@rac-2 ~]# systemctl disable avahi-daemon

# 配置NOZEROCONF参数

[root@rac-2 ~]# echo 'NOZEROCONF=yes' >> /etc/sysconfig/network

5、关闭透明大页和NUMA

Oracle官方文档中指出透明大页可能会导致在RAC中造成性能影响,因此关闭透明大页。NUMA为什么关闭,暂时不清楚,后续研究下。

rac-1

# 配置启动禁用透明大页和NUMA

[root@rac-1 ~]# sed -i 's/quiet/quiet transparent_hugepage=never numa=off/' /etc/default/grub

# 生成启动规则

[root@rac-1 ~]# grub2-mkconfig -o /boot/grub2/grub.cfg

# 重启服务器

[root@rac-1 ~]# reboot

rac-2

# 配置启动禁用透明大页和NUMA

[root@rac-2 ~]# sed -i 's/quiet/quiet transparent_hugepage=never numa=off/' /etc/default/grub

# 生成启动规则

[root@rac-2 ~]# grub2-mkconfig -o /boot/grub2/grub.cfg

# 重启服务器

[root@rac-2 ~]# reboot

6、禁用NTP服务

RAC集群可以使用NTP服务或CTSS服务来同步时间,让所有节点的时间一致。

在安装过程中,默认会检查/etc/目录下是否有ntp.conf文件,如果能够找到该文件,则认为服务器采用NTP服务来进行时间同步的,会将自己的CTSS服务配置成观察模式;反之,在/etc/目录下找不到ntp.conf文件,则将自己的CTSS服务配置成激活状态,并使用CTSS服务来同步时间。

CTSS服务会将安装Grid软件的那台节点作为主节点,然后让集群中的其他节点与主节点的时间进行同步。

使用哪个服务进行时间同步,需要根据真实环境中的情况来分析。如果你有NTP服务器,则直接使用NTP服务进行时间同步;如果没有NTP服务器,就可以使用CTSS来同步时间。

我这里没有时间同步服务器,就直接使用CTSS服务来同步时间。使用CTSS服务也很简单,直接将NTP服务禁用掉,/etc/ntp.conf文件删除掉或重命名一下就可以了。

禁用NTP服务,使用Oracle的CTSS服务来同步节点的时间。

rac-1

# 停止NTP服务

[root@rac-1 ~]# systemctl stop ntpd

# 禁用NTP服务自启动

[root@rac-1 ~]# systemctl disable ntpd

禁用ntp服务后,确认下主节点的时区和时间。如果时区和时间错误,则将其改为正确的。

# 确认时区和时间

[root@rac-1 ~]# date

rac-2

# 停止NTP服务

[root@rac-1 ~]# systemctl stop ntpd

# 禁用NTP服务自启动

[root@rac-1 ~]# systemctl disable ntpd

禁用ntp服务后,确认下服务器与主节点的时间和时区。如果时区和时间差异较大,则将其修改为主节点的时区,并将时间调整到与主节点相近的时间,后续CTSS服务会修正时间。

# 确认时区和时间

[root@rac-1 ~]# date

7、配置内核参数

配置内核参数,调整Oracle性能。

rac-1

[root@rac-1 ~]# vim /etc/sysctl.conf

新增以下参数,并根据实际情况调整参数大小。

net.ipv4.icmp_echo_ignore_broadcasts = 1

net.ipv4.conf.all.rp_filter = 1

fs.file-max = 6815744

fs.aio-max-nr = 1048576

kernel.shmall = 2097152

kernel.shmmax = 2147483648

kernel.shmmni = 4096

kernel.sem = 250 32000 100 128

net.ipv4.ip_local_port_range = 9000 65500

net.core.rmem_default = 262144

net.core.rmem_max= 4194304

net.core.wmem_default= 262144

net.core.wmem_max= 1048576

配置介绍:

- fs.file-max 最大打开文件数

- kernel.shmall 共享内存的总量,8G内存设置:2097152*4k/1024/1024

- kernel.shmmax 最大共享内存的段大小,一般设置为服务器的80%内存总大小

- net.ipv4.ip_local_port_range 可使用的ipv4端口范围

其他参数有时间再去研究,这里暂时先写这几个重要的。如果你的服务器只运行单个实例(数据库),我这里给出一个大概的建议值参考:

- 内存为12G

- kernel.shmall = 3145728

- kernel.shmmax = 12884901887

- 内存为16G

- kernel.shmall = 4194304

- kernel.shmmax = 17179869183

- 内存为32G

- kernel.shmall = 8388608

- kernel.shmmax = 34359738367

- 内存为64G

- kernel.shmall = 16777216

- kernel.shmmax = 68719476735

重加载内核参数

# 让参数生效

[root@rac-1 ~]# sysctl -p

rac-2

[root@rac-1 ~]# vim /etc/sysctl.conf

新增以下参数,并根据实际情况调整参数大小。

net.ipv4.icmp_echo_ignore_broadcasts = 1

net.ipv4.conf.all.rp_filter = 1

fs.file-max = 6815744

fs.aio-max-nr = 1048576

kernel.shmall = 2097152

kernel.shmmax = 2147483648

kernel.shmmni = 4096

kernel.sem = 250 32000 100 128

net.ipv4.ip_local_port_range = 9000 65500

net.core.rmem_default = 262144

net.core.rmem_max= 4194304

net.core.wmem_default= 262144

net.core.wmem_max= 1048576

配置介绍:

- fs.file-max 最大打开文件数

- kernel.shmall 共享内存的总量,8G内存设置:2097152*4k/1024/1024

- kernel.shmmax 最大共享内存的段大小,一般设置为服务器的80%内存总大小

- net.ipv4.ip_local_port_range 可使用的ipv4端口范围

其他参数有时间再去研究,这里暂时先写这几个重要的。如果你的服务器只运行单个实例(数据库),我这里给出一个大概的建议值参考:

- 内存为12G

- kernel.shmall = 3145728

- kernel.shmmax = 12884901887

- 内存为16G

- kernel.shmall = 4194304

- kernel.shmmax = 17179869183

- 内存为32G

- kernel.shmall = 8388608

- kernel.shmmax = 34359738367

- 内存为64G

- kernel.shmall = 16777216

- kernel.shmmax = 68719476735

重加载内核参数

# 让参数生效

[root@rac-1 ~]# sysctl -p

8、限制用户资源使用

配置oracle用户和grid用户的资源硬限制和软限制。

rac-1

编辑limits配置文件

[root@rac-1 ~]# vim /etc/security/limits.conf

oracle soft nproc 2047

oracle hard nproc 16384

oracle soft nofile 1024

oracle hard nofile 65536

grid soft nproc 2047

grid hard nproc 16384

grid soft nofile 1024

grid hard nofile 65536

login文件增加参数

[root@rac-1 ~]# echo "session required pam_limits.so" >>/etc/pam.d/login

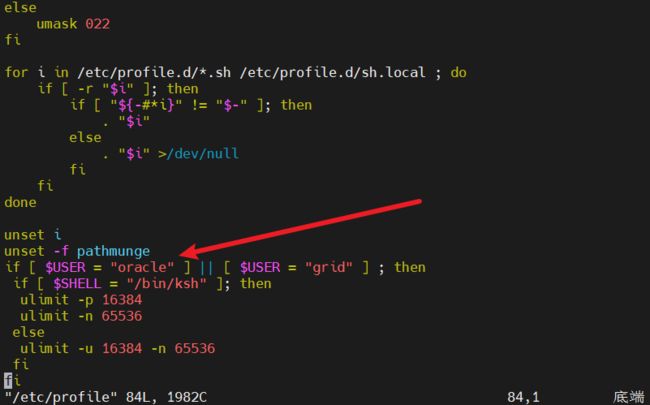

编辑profile文件,在最下面新增内容。

[root@rac-1 ~]# vim /etc/profile

if [ $USER = "oracle" ] || [ $USER = "grid" ] ; then

if [ $SHELL = "/bin/ksh" ]; then

ulimit -p 16384

ulimit -n 65536

else

ulimit -u 16384 -n 65536

fi

fi

rac-2

编辑limits配置文件

[root@rac-2 ~]# vim /etc/security/limits.conf

oracle soft nproc 2047

oracle hard nproc 16384

oracle soft nofile 1024

oracle hard nofile 65536

grid soft nproc 2047

grid hard nproc 16384

grid soft nofile 1024

grid hard nofile 65536

login文件增加参数

[root@rac-2 ~]# echo "session required pam_limits.so" >>/etc/pam.d/login

编辑profile文件,在最下面新增内容。

[root@rac-2 ~]# vim /etc/profile

if [ $USER = "oracle" ] || [ $USER = "grid" ] ; then

if [ $SHELL = "/bin/ksh" ]; then

ulimit -p 16384

ulimit -n 65536

else

ulimit -u 16384 -n 65536

fi

fi

9、配置用户环境变量

接下来就是配置oracle和grid的用户环境变量了。

rac-1

配置oracle用户变量

[root@rac-1 ~]# vim /home/oracle/.bash_profile

在文件内容的最下面新增以下内容

export ORACLE_BASE=/u01/app/oracle

export ORACLE_HOME=$ORACLE_BASE/product/11.2.0/dbhome_1

export PATH=$ORACLE_HOME/bin:$PATH

export LANG=en_US.UTF-8

配置grid用户变量

[root@rac-1 ~]# vim /home/grid/.bash_profile

在文件内容的最下面新增以下内容

export ORACLE_BASE=/u01/app/grid

export ORACLE_HOME=/u01/app/11.2.0/grid

export PATH=$ORACLE_HOME/bin:$PATH

export ORACLE_SID=+ASM1

export LANG=en_US.UTF-8

配置好后,生效一下

# 让oracle用户的环境变量生效

[root@rac-1 ~]# source /home/oracle/.bash_profile

# 让grid用户的环境变量生效

[root@rac-1 ~]# source /home/grid/.bash_profile

rac-2

配置oracle用户变量

[root@rac-2 ~]# vim /home/oracle/.bash_profile

在文件内容的最下面新增以下内容

export ORACLE_BASE=/u01/app/oracle

export ORACLE_HOME=$ORACLE_BASE/product/11.2.0/dbhome_1

export PATH=$ORACLE_HOME/bin:$PATH

export LANG=en_US.UTF-8

配置grid用户变量

[root@rac-2 ~]# vim /home/grid/.bash_profile

在文件内容的最下面新增以下内容

export ORACLE_BASE=/u01/app/grid

export ORACLE_HOME=/u01/app/11.2.0/grid

export PATH=$ORACLE_HOME/bin:$PATH

export ORACLE_SID=+ASM2

export LANG=en_US.UTF-8

配置好后,生效一下

# 让oracle用户的环境变量生效

[root@rac-2 ~]# source /home/oracle/.bash_profile

# 让grid用户的环境变量生效

[root@rac-2 ~]# source /home/grid/.bash_profile

10、创建软件目录

配置好后,创建软件的目录。

rac-1

# 创建软件存储目录,数据库软件和grid软件解压到这里

[root@rac-1 ~]# mkdir -p /u01/software

# 创建oracle用户的ORACLE_BASE目录

[root@rac-1 ~]# mkdir -p /u01/app/oracle

# 授权

[root@rac-1 ~]# chown oracle:oinstall /u01/app/oracle

# 创建Grid用户的ORACLE_BASE目录

[root@rac-1 ~]# mkdir -p /u01/app/grid

# 授权

[root@rac-1 ~]# chown grid:oinstall /u01/app/grid

# 授权

[root@rac-2 ~]# chgrp oinstall /u01/app

# 授权

[root@rac-1 ~]# chmod 775 /u01/app

rac-2

# 创建软件存储目录,数据库软件和grid软件解压到这里

[root@rac-2 ~]# mkdir -p /u01/software

# 创建oracle用户的ORACLE_BASE目录

[root@rac-2 ~]# mkdir -p /u01/app/oracle

# 授权

[root@rac-2 ~]# chown oracle:oinstall /u01/app/oracle

# 创建Grid用户的ORACLE_BASE目录

[root@rac-2 ~]# mkdir -p /u01/app/grid

# 授权

[root@rac-2 ~]# chown grid:oinstall /u01/app/grid

# 授权

[root@rac-2 ~]# chgrp oinstall /u01/app

# 授权

[root@rac-2 ~]# chmod 775 /u01/app

11、配置SSH互信

此步骤必须按顺序执行,否则可能会有报错或异常。

虽然Oracle有说明会自动配置SSH互相通信,但我们还是建议去手动配置。

grid用户互信

rac-1

使用grid用户配置免密登录

# 生成协议2版本的RSA密钥对

[grid@rac-1 ~]$ ssh-keygen -t rsa

# 将密钥内容复制到authorized_keys文件中

[grid@rac-1 ~]$ cat .ssh/id_rsa.pub >> .ssh/authorized_keys

rac-2

使用grid用户配置免密登录

# 生成协议2版本的RSA密钥对

[grid@rac-2 ~]$ ssh-keygen -t rsa

![]()

rac-1

拷贝刚刚生成的authorized_key文件至节点2。

[grid@rac-1 ~]$ scp .ssh/authorized_keys rac-2:/home/grid/.ssh

rac-2

将节点2的密钥写入到authorized_keys文件,并拷回至节点1中。

# 将节点2的密钥写入到authorized_keys文件中

[grid@rac-2 ~]$ cat .ssh/id_rsa.pub >> .ssh/authorized_keys

# 拷贝authorized_keys文件至节点1

[grid@rac-2 ~]$ scp .ssh/authorized_keys rac-1:/home/grid/.ssh

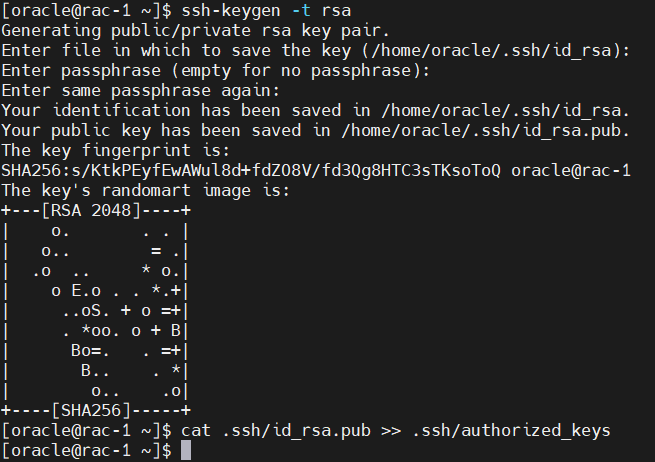

oracle用户互信

rac-1

使用oracle用户配置免密登录

# 生成协议2版本的RSA密钥对

[oracle@rac-1 ~]$ ssh-keygen -t rsa

# 将密钥内容复制到authorized_keys文件中

[oracle@rac-1 ~]$ cat .ssh/id_rsa.pub >> .ssh/authorized_keys

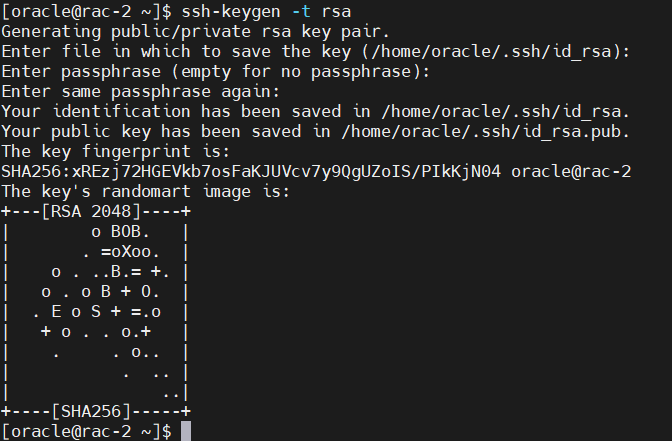

rac-2

使用oracle用户配置免密登录

# 生成协议2版本的RSA密钥对

[oracle@rac-2 ~]$ ssh-keygen -t rsa

rac-1

拷贝刚刚生成的authorized_key文件至节点2。

[oracle@rac-1 ~]$ scp .ssh/authorized_keys rac-2:/home/oracle/.ssh

rac-2

将节点2的密钥写入到authorized_keys文件,并拷回至节点1中。

# 将节点2的密钥写入到authorized_keys文件中

[grid@rac-2 ~]$ cat .ssh/id_rsa.pub >> .ssh/authorized_keys

# 拷贝authorized_keys文件至节点1

[grid@rac-2 ~]$ scp .ssh/authorized_keys rac-1:/home/oracle/.ssh

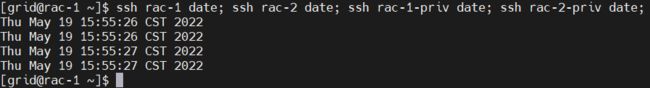

rac-1

最终,测试oracle和grid用户节点1连接节点2是否还需要输入密码。

# 测试grid用户

[grid@rac-1 ~]$ ssh rac-1 date; ssh rac-2 date; ssh rac-1-priv date; ssh rac-2-priv date;

# 测试oracle用户

[oracle@rac-1 ~]$ ssh rac-1 date; ssh rac-2 date; ssh rac-1-priv date; ssh rac-2-priv date;

![]()

rac-2

最终,测试oracle和grid用户节点1连接节点2是否还需要输入密码。

# 测试grid用户

[grid@rac-2 ~]$ ssh rac-1 date; ssh rac-2 date; ssh rac-1-priv date; ssh rac-2-priv date;

# 测试oracle用户

[oracle@rac-2 ~]$ ssh rac-1 date; ssh rac-2 date; ssh rac-1-priv date; ssh rac-2-priv date;

如上图所示,则表示免密登录配置完成。

12、配置共享存储

共享存储有多种解决方案,并且每个不同的存储厂商的解决方案也是不同的,我这里以VMware虚拟机为例。添加磁盘时需要注意,必须选择【立即分配所有磁盘空间】选项,否则,安装Grid软件执行root脚本时,节点2会不识别节点1的集群,从而导致会重新创建voting disk。

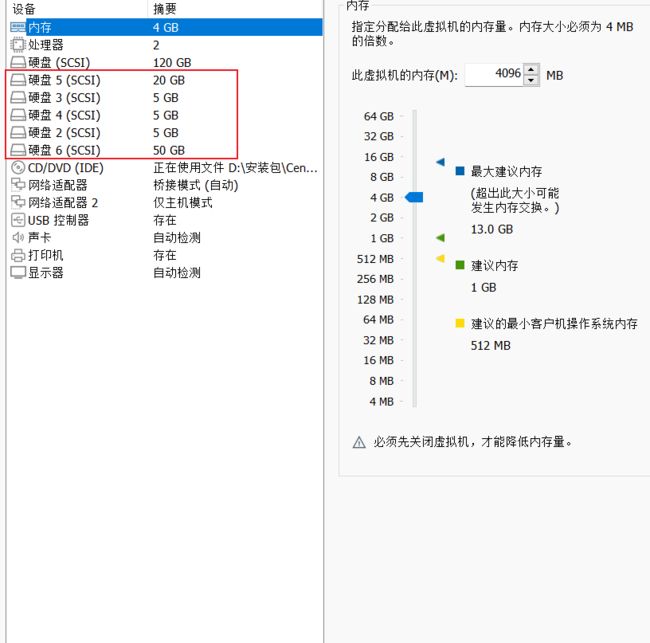

首先是关闭两台虚拟机,在虚拟机上的节点1服务器新增5块磁盘,分别是3个5G的OCR磁盘,20G的FRA磁盘和50G的DATA磁盘。如下图所示:

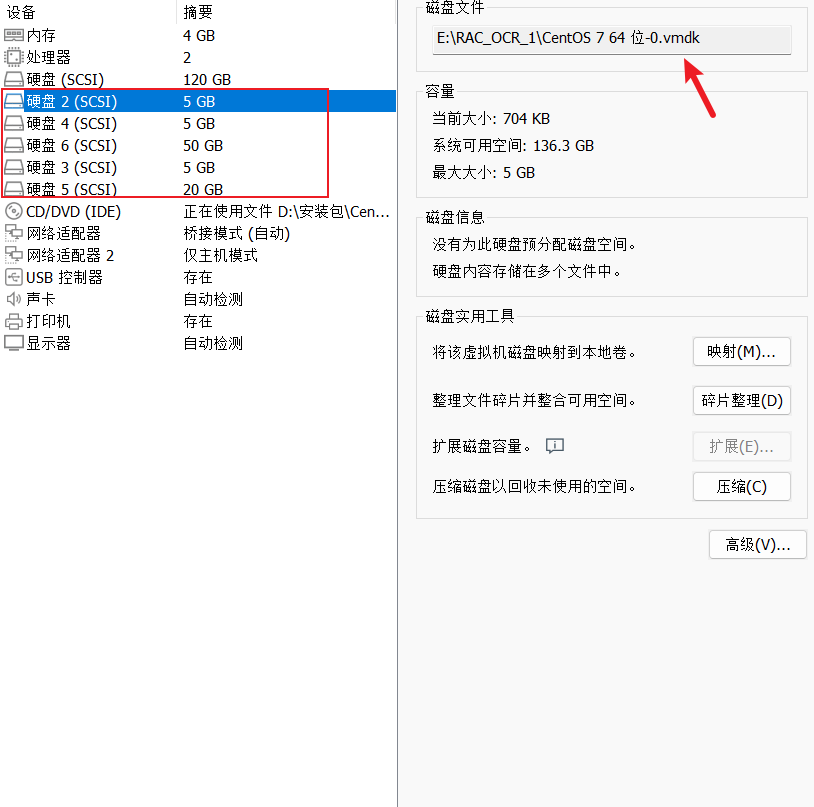

节点1服务器新增磁盘后,在节点2服务器上同样新增5块磁盘。注意,这里在新增磁盘的时候,选择【使用现有虚拟磁盘】,然后选中节点1服务器的5个磁盘文件。

两个节点都配置好磁盘后,分别在两个虚拟机的.vmx文件中,新增以下内容:

disk.locking="FALSE"

disk.EnableUUID ="TRUE"

scsi0:1.SharedBus="Virtual"

scsi0:2.SharedBus="Virtual"

scsi0:3.SharedBus="Virtual"

scsi0:4.SharedBus="Virtual"

scsi0:5.SharedBus="Virtual"

配置好后,启动节点1服务器和节点2服务器即可。

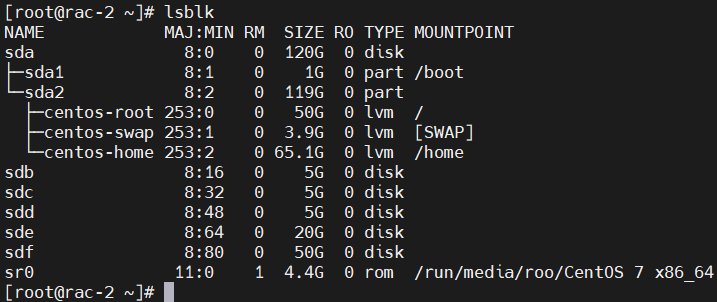

验证共享存储

配置好后,验证两台服务器共享存储是否成功。

rac-1

[root@rac-1 ~]# lsblk

rac-2

[root@rac-2 ~]# lsblk

注意,以下两种方式任选一种即可。非FC通道的话,建议使用非多路径方式配置ASM磁盘。

非多路径方式

不使用多路径的情况下,绑定磁盘使用UDEV就可以了。

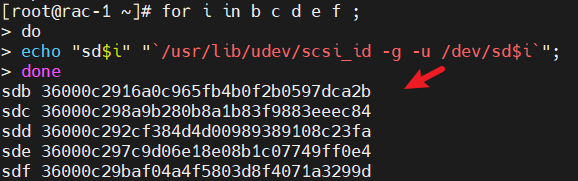

1、查看磁盘的scsi_id

rac-1

[root@rac-1 ~]# for i in b c d e f ;

> do

> echo "sd$i" "`/usr/lib/udev/scsi_id -g -u /dev/sd$i`";

> done

rac-2

[root@rac-2 ~]# for i in b c d e f ;

> do

> echo "sd$i" "`/usr/lib/udev/scsi_id -g -u /dev/sd$i`";

> done

2、绑定磁盘

rac-1

[root@rac-1 ~]# vim /etc/udev/rules.d/99-oracle-asmdevices.rules

编辑配置文件,新增规则。

KERNEL=="sd*",SUBSYSTEM=="block",PROGRAM=="/lib/udev/scsi_id -g -u -d /dev/$name",RESULT=="36000c292b5977370625e0cff350dc1b3",SYMLINK+="asm_ocr1",OWNER="grid",GROUP="asmadmin",MODE="0660"

KERNEL=="sd*",SUBSYSTEM=="block",PROGRAM=="/lib/udev/scsi_id -g -u -d /dev/$name",RESULT=="36000c2973a9a56e46deac8282fde0f38",SYMLINK+="asm_ocr2",OWNER="grid",GROUP="asmadmin",MODE="0660"

KERNEL=="sd*",SUBSYSTEM=="block",PROGRAM=="/lib/udev/scsi_id -g -u -d /dev/$name",RESULT=="36000c29477e56db667ad5e027c314742",SYMLINK+="asm_ocr3",OWNER="grid",GROUP="asmadmin",MODE="0660"

KERNEL=="sd*",SUBSYSTEM=="block",PROGRAM=="/lib/udev/scsi_id -g -u -d /dev/$name",RESULT=="36000c29c53e0c1bf2d5819b1199d89c8",SYMLINK+="asm_fra",OWNER="grid",GROUP="asmadmin",MODE="0660"

KERNEL=="sd*",SUBSYSTEM=="block",PROGRAM=="/lib/udev/scsi_id -g -u -d /dev/$name",RESULT=="36000c29de02cd10f176aa4626ac9be4a",SYMLINK+="asm_data",OWNER="grid",GROUP="asmadmin",MODE="0660"

rac-2

[root@rac-2 ~]# vim /etc/udev/rules.d/99-oracle-asmdevices.rules

编辑配置文件,新增规则。

KERNEL=="sd*",SUBSYSTEM=="block",PROGRAM=="/lib/udev/scsi_id -g -u -d /dev/$name",RESULT=="36000c292b5977370625e0cff350dc1b3",SYMLINK+="asm_ocr1",OWNER="grid",GROUP="asmadmin",MODE="0660"

KERNEL=="sd*",SUBSYSTEM=="block",PROGRAM=="/lib/udev/scsi_id -g -u -d /dev/$name",RESULT=="36000c2973a9a56e46deac8282fde0f38",SYMLINK+="asm_ocr2",OWNER="grid",GROUP="asmadmin",MODE="0660"

KERNEL=="sd*",SUBSYSTEM=="block",PROGRAM=="/lib/udev/scsi_id -g -u -d /dev/$name",RESULT=="36000c29477e56db667ad5e027c314742",SYMLINK+="asm_ocr3",OWNER="grid",GROUP="asmadmin",MODE="0660"

KERNEL=="sd*",SUBSYSTEM=="block",PROGRAM=="/lib/udev/scsi_id -g -u -d /dev/$name",RESULT=="36000c29c53e0c1bf2d5819b1199d89c8",SYMLINK+="asm_fra",OWNER="grid",GROUP="asmadmin",MODE="0660"

KERNEL=="sd*",SUBSYSTEM=="block",PROGRAM=="/lib/udev/scsi_id -g -u -d /dev/$name",RESULT=="36000c29de02cd10f176aa4626ac9be4a",SYMLINK+="asm_data",OWNER="grid",GROUP="asmadmin",MODE="0660"

3、生效

rac-1

[root@rac-1 ~]# /sbin/udevadm trigger --type=devices --action=change

[root@rac-1 ~]# /sbin/udevadm control --reload

rac-2

[root@rac-1 ~]# /sbin/udevadm trigger --type=devices --action=change

[root@rac-1 ~]# /sbin/udevadm control --reload

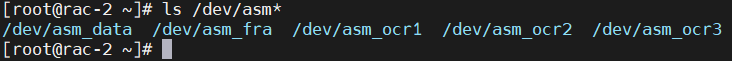

4、验证

rac-1

[root@rac-1 ~]# ls /dev/asm*

![]()

rac-2

[root@rac-2 ~]# ls /dev/asm*

5、重启后再次验证

rac-1

[root@rac-1 ~]# ls /dev/asm*

rac-2

[root@rac-2 ~]# ls /dev/asm*

多路径方式

通常多路径方式可能会用在FC环境中,当然也可以用在ISCSI中。

配置多路径

参考:https://blog.51cto.com/lishiyan/5121148

rac-1

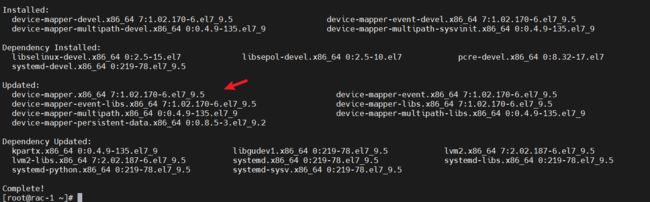

1、安装多路径

[root@rac-1 ~]# yum -y install device-mapper*

# 生成默认模板

[root@rac-1 ~]# mpathconf --enable --with_multipathd y

2、查看节点1磁盘的scsi_id

[root@rac-1 ~]# for i in b c d e f ;

> do

> echo "sd$i" "`/usr/lib/udev/scsi_id -g -u /dev/sd$i`";

> done

3、绑定磁盘

[root@rac-1 ~]# vim /etc/multipath.conf

defaults {

user_friendly_names yes

}

blacklist {

devnode "^sda"

}

multipaths {

multipath {

wwid "36000c2916a0c965fb4b0f2b0597dca2b"

alias asm_ocr1

}

multipath {

wwid "36000c298a9b280b8a1b83f9883eeec84"

alias asm_ocr2

}

multipath {

wwid "36000c292cf384d4d00989389108c23fa"

alias asm_ocr3

}

multipath {

wwid "36000c297c9d06e18e08b1c07749ff0e4"

alias asm_fra

}

multipath {

wwid "36000c29baf04a4f5803d8f4071a3299d"

alias asm_data

}

}

4、保存并加载多路径

# 删除原有配置

[root@rac-1 ~]# multipath -F

# 加载新配置

[root@rac-1 ~]# multipath -v2

rac-2

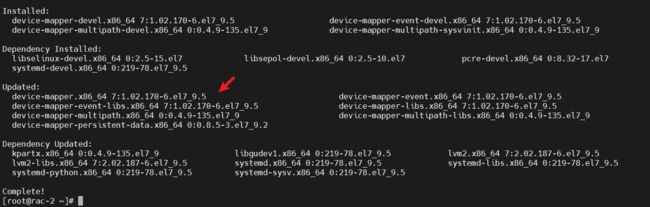

1、安装多路径

[root@rac-2 ~]# yum -y install device-mapper*

# 生成默认模板

[root@rac-2 ~]# mpathconf --enable --with_multipathd y

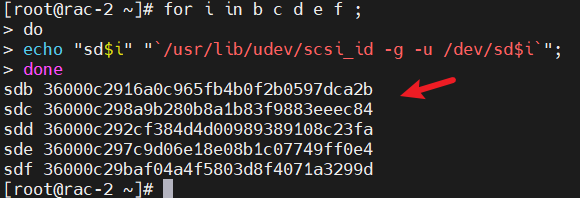

2、查看节点2磁盘的scsi_id

[root@rac-2 ~]# for i in b c d e f ;

> do

> echo "sd$i" "`/usr/lib/udev/scsi_id -g -u /dev/sd$i`";

> done

3、绑定磁盘

这里直接可以拷贝节点1的multipath.conf到节点2,毕竟共享磁盘的scsi_id都是一样的。

[root@rac-2 ~]# vim /etc/multipath.conf

defaults {

user_friendly_names yes

}

blacklist {

devnode "^sda"

}

multipaths {

multipath {

wwid "36000c2916a0c965fb4b0f2b0597dca2b"

alias asm_ocr1

}

multipath {

wwid "36000c298a9b280b8a1b83f9883eeec84"

alias asm_ocr2

}

multipath {

wwid "36000c292cf384d4d00989389108c23fa"

alias asm_ocr3

}

multipath {

wwid "36000c297c9d06e18e08b1c07749ff0e4"

alias asm_fra

}

multipath {

wwid "36000c29baf04a4f5803d8f4071a3299d"

alias asm_data

}

}

4、保存并加载多路径

# 删除原有配置

[root@rac-1 ~]# multipath -F

# 加载新配置

[root@rac-1 ~]# multipath -v2

UDEV配置

rac-1

[root@rac-1 ~]# vim /etc/udev/rules.d/99-oracle-asmdevices.rules

1、新增规则,有多少多路径配置就需要增加多少条规则。

KERNEL=="dm-*",ENV{DM_UUID}=="mpath-36000c2916a0c965fb4b0f2b0597dca2b",SYMLINK+="asm_ocr1",OWNER="grid",GROUP="asmadmin",MODE="0660"

KERNEL=="dm-*",ENV{DM_UUID}=="mpath-36000c298a9b280b8a1b83f9883eeec84",SYMLINK+="asm_ocr2",OWNER="grid",GROUP="asmadmin",MODE="0660"

KERNEL=="dm-*",ENV{DM_UUID}=="mpath-36000c292cf384d4d00989389108c23fa",SYMLINK+="asm_ocr3",OWNER="grid",GROUP="asmadmin",MODE="0660"

KERNEL=="dm-*",ENV{DM_UUID}=="mpath-36000c297c9d06e18e08b1c07749ff0e4",SYMLINK+="asm_fra",OWNER="grid",GROUP="asmadmin",MODE="0660"

KERNEL=="dm-*",ENV{DM_UUID}=="mpath-36000c29baf04a4f5803d8f4071a3299d",SYMLINK+="asm_data",OWNER="grid",GROUP="asmadmin",MODE="0660"

2、重新加载udev

[root@rac-1 ~]# udevadm control --reload-rules

[root@rac-1 ~]# udevadm trigger --type=devices

3、验证

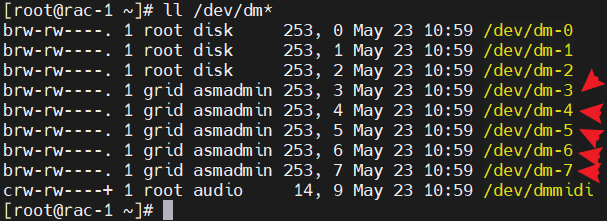

[root@rac-1 ~]# ll /dev/asm*

[root@rac-1 ~]# ll /dev/asm*

rac-2

[root@rac-2 ~]# vim /etc/udev/rules.d/99-oracle-asmdevices.rules

1、新增规则,有多少多路径配置就需要增加多少条规则。

KERNEL=="dm-*",ENV{DM_UUID}=="mpath-36000c2916a0c965fb4b0f2b0597dca2b",SYMLINK+="asm_ocr1",OWNER="grid",GROUP="asmadmin",MODE="0660"

KERNEL=="dm-*",ENV{DM_UUID}=="mpath-36000c298a9b280b8a1b83f9883eeec84",SYMLINK+="asm_ocr2",OWNER="grid",GROUP="asmadmin",MODE="0660"

KERNEL=="dm-*",ENV{DM_UUID}=="mpath-36000c292cf384d4d00989389108c23fa",SYMLINK+="asm_ocr3",OWNER="grid",GROUP="asmadmin",MODE="0660"

KERNEL=="dm-*",ENV{DM_UUID}=="mpath-36000c297c9d06e18e08b1c07749ff0e4",SYMLINK+="asm_fra",OWNER="grid",GROUP="asmadmin",MODE="0660"

KERNEL=="dm-*",ENV{DM_UUID}=="mpath-36000c29baf04a4f5803d8f4071a3299d",SYMLINK+="asm_data",OWNER="grid",GROUP="asmadmin",MODE="0660"

2、重新加载udev

[root@rac-2 ~]# udevadm control --reload-rules

[root@rac-2 ~]# udevadm trigger --type=devices

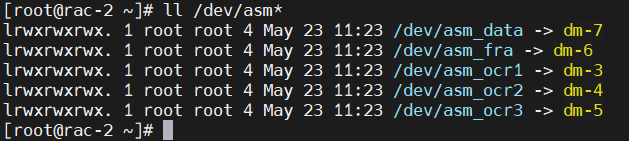

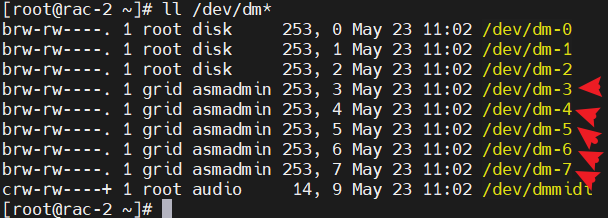

3、验证

[root@rac-2 ~]# ll /dev/asm*

[root@rac-2 ~]# ll /dev/dm*

4、重启服务器验证

在全部配置好后,重启两台节点服务器再验证一下。

rac-1

[root@rac-1 ~]# reboot

重启后再次查看/dev/asm*

[root@rac-1 ~]# ls /dev/asm*

如图所示,则说明共享存储配置完毕。

rac-2

[root@rac-1 ~]# reboot

重启后再次查看/dev/asm*

[root@rac-2 ~]# ls /dev/asm*

如图所示,则说明共享存储配置完毕。

13、上传软件包、解压并授权

配置完共享存储后,上传软件包并解压授权,我这里上传到了/u01目录下。

rac-1

[root@rac-1 u01]# unzip p13390677_112040_Linux-x86-64_1of7.zip -d software

[root@rac-1 u01]# unzip p13390677_112040_Linux-x86-64_2of7.zip -d software

[root@rac-1 u01]# unzip p13390677_112040_Linux-x86-64_3of7.zip -d software

[root@rac-1 u01]# chown -R grid:oinstall software/grid

[root@rac-1 u01]# chown -R oracle:oinstall software/database

rac-2

[root@rac-2 u01]# unzip p13390677_112040_Linux-x86-64_1of7.zip -d software

[root@rac-2 u01]# unzip p13390677_112040_Linux-x86-64_2of7.zip -d software

[root@rac-2 u01]# unzip p13390677_112040_Linux-x86-64_3of7.zip -d software

[root@rac-2 u01]# chown -R grid:oinstall software/grid

[root@rac-2 u01]# chown -R oracle:oinstall software/database

14、安装依赖包

解压包后,两个节点安装依赖包。

rac-1

[root@rac-1 u01]# yum -y install gcc* compat-libstdc* elfutils-libelf-devel* glibc-devel* glibc-headers* libaio-devel* libstdc* ksh* compat-libcap1*

# 安装Grid软件带的依赖包

[root@rac-1 u01]# rpm -ivh software/grid/rpm/cvuqdisk-1.0.9-1.rpm

rac-2

[root@rac-2 u01]# yum install gcc* compat-libstdc* elfutils-libelf-devel* glibc-devel* glibc-headers* libaio-devel* libstdc* ksh* compat-libcap1*

# 安装Grid软件带的依赖包

[root@rac-2 u01]# rpm -ivh software/grid/rpm/cvuqdisk-1.0.9-1.rpm

15、校验

rac-1

[grid@rac-1 ~]$ cd /u01/software/grid

# 校验

[grid@rac-1 grid]$ ./runcluvfy.sh stage -pre crsinst -n rac-1,rac-2 -verbose

校验内容太长就不再截图,最重要的就是要仔细检查所有检查项。有些检查项报错是可以不处理的,例如SWAP空间不够,但少依赖包的检查项必须处理,建议是所有错误项都处理掉,避免安装报错。

16、安装Grid软件

安装完依赖后,就可以选择一个节点安装Grid软件了。Grid软件任选一个节点安装即可,它会在安装过程中通过免密登录将其传输到另外的节点上,我这里以rac-1节点为例。

rac-1

使用grid用户登录并安装

# 进入安装目录

[grid@rac-1 grid]$ cd /u01/software/grid

# 启动图型界面安装

[grid@rac-1 grid]$ ./runInstaller

跳过软件更新

安装配置Grid软件

高级安装

选择语言

配置集群名称

这里可以不配置GNS,另外SCAN Name必须与hosts文件中指定的scan主机名一致。

添加节点

默认只有rac-1的节点,我们手动将rac-2添加上即可。添加节点的时候是指定公共主机名和虚拟主机名。

网络接口确认

确认Public IP段和Private IP段,第三个是虚拟机自己提供的一个,不用管,当然也可以提前给它卸载掉。

OCR存储选择

OCR肯定是选择ASM存储的,不然配置ASM干嘛。

创建磁盘组

默认是不显示磁盘的,因为我们的路径和它默认的路径不同,因此需要先改变路径,让Grid识别到ASM磁盘后,再配置OCR磁盘,我这里选择默认冗余,4MB的AU大小。

设置密码

Oracle会检查密码的复杂性,因此密码尽量包含字符数字和字母,否则会有警告。

配置IPM

配置用户组

配置安装目录

这里如果空白,则说明grid用户的环境变量没配置或者没有生效。

清单目录确认

先决条件检查

先决条件检查的时候,能够解决的尽量修复,对于某些必须要打补丁或者不太严重的,可以先跳过。

确认所有信息

确认所有的配置信息,如果没有问题的话,就可以开始安装了。

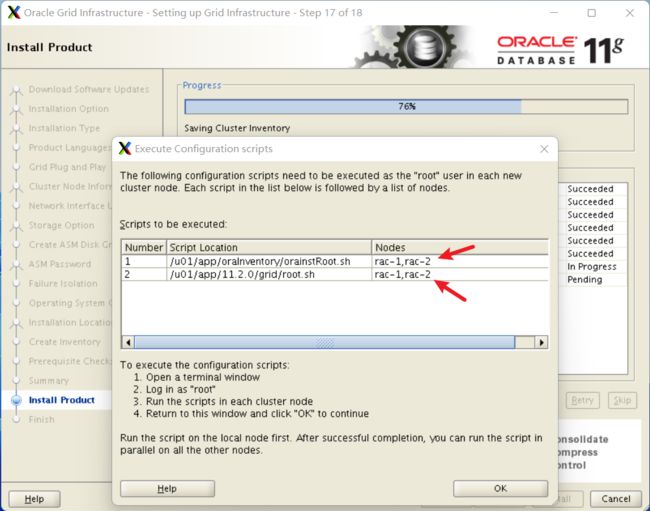

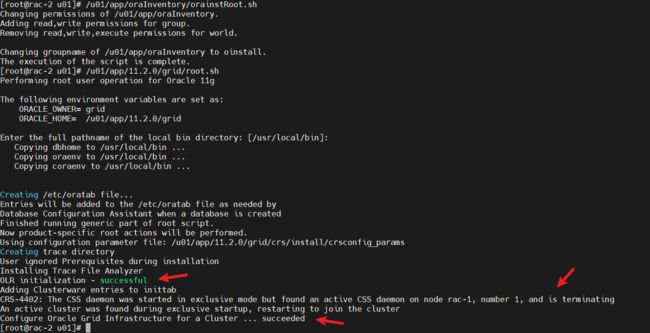

执行脚本

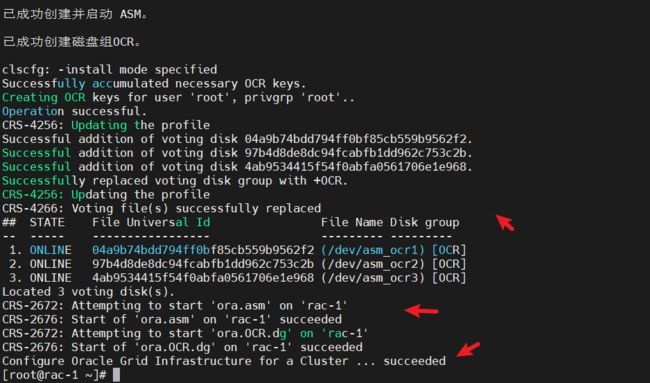

root用户执行脚本,所有节点都需要执行。

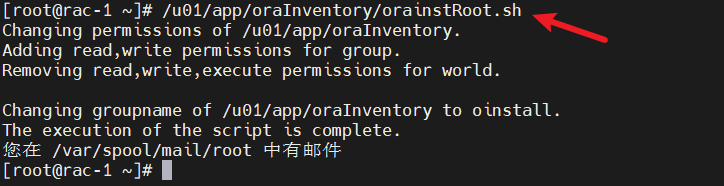

rac-1

[root@rac-1 ~]# /u01/app/oraInventory/orainstRoot.sh

[root@rac-1 ~]# /u01/app/11.2.0/grid/root.sh

rac-2

[root@rac-2 ~]# /u01/app/oraInventory/orainstRoot.sh

[root@rac-2 ~]# /u01/app/11.2.0/grid/root.sh

完成Grid安装

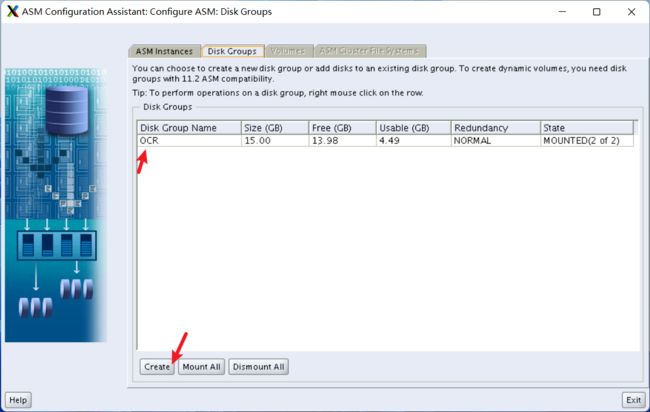

16、配置其他ASM磁盘

Grid软件安装完成后,我们需要配置其他ASM的磁盘组。它们分别是存储数据的DATA磁盘组,和存储归档日志的FRA磁盘组。

rac-1

启动ASM图型界面

[grid@rac-1 grid]$ asmca

新建DATA磁盘组

新建FRA磁盘组

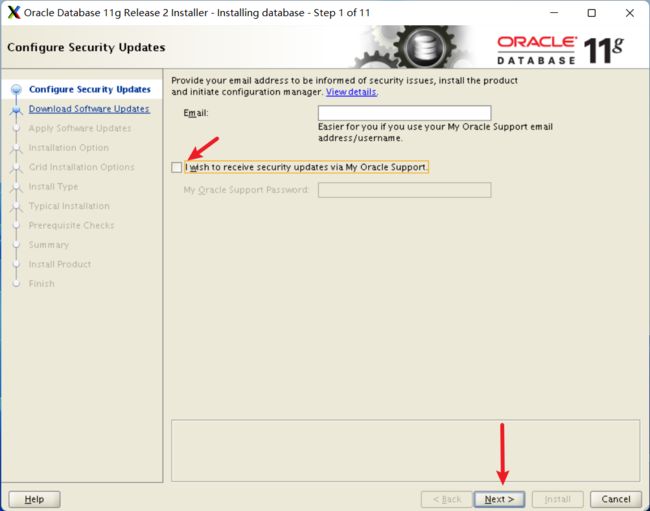

17、安装数据库软件

磁盘组配置好,我们使用oracle用户来安装Oracle数据库软件。

rac-1

# oracle用户进入软件目录中

[oracle@rac-1 ~]$ cd /u01/software/database

# 安装

[oracle@rac-1 database]$ ./runInstaller

配置安全更新

配置软件更新

配置安装选项

通常情况下我们选择仅安装数据库软件,后续再手动配置数据库实例。

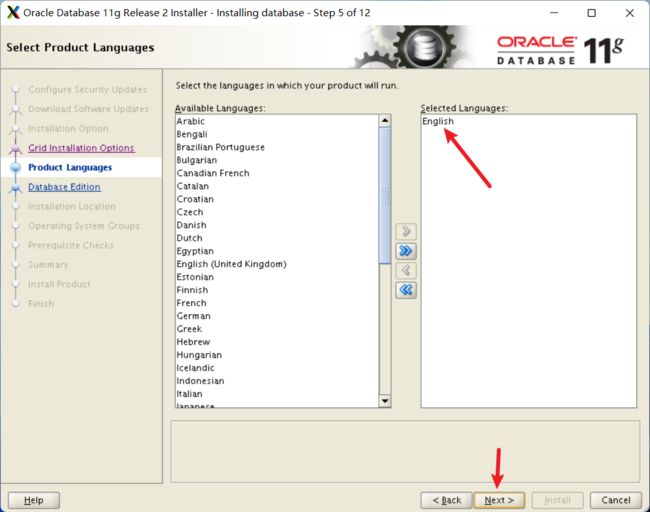

Grid安装选项

既然是配置集群,那肯定是选择第二项。

选择语言

仅选择英文即可,无需去刻意选择中文,这里跟数据库能不能存储中文没有关系。

配置数据库版本

毫无疑问,选择企业版。

配置安装目录位置

这里如果默认没有出现目录,则说明环境变量配置错误或没生效。

操作系统组配置

执行root脚本

rac-1

/u01/app/oracle/product/11.2.0/dbhome_1/root.sh

rac-2

[root@rac-2 ~]# /u01/app/oracle/product/11.2.0/dbhome_1/root.sh

安装完成

18、安装数据库实例

安装完数据库软件后,我们开始安装数据库实例。

rac-1

[oracle@rac-1 database]$ dbca

集群选项

数据库选项

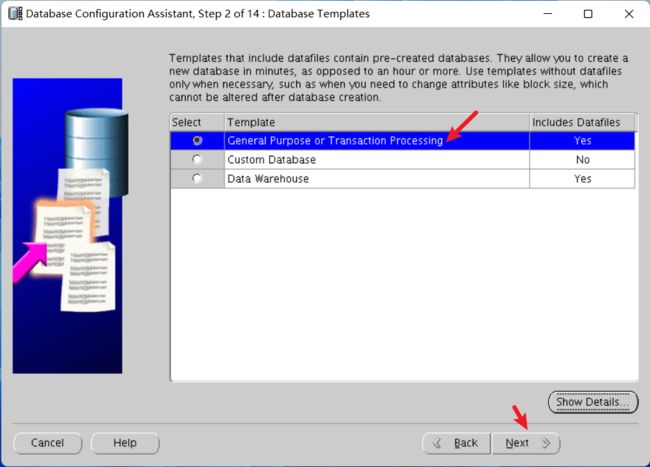

选择数据库类型

如果你的数据库更偏重于OLAP的话,则建议去选择Data Warehouse,否则选第一个即可。

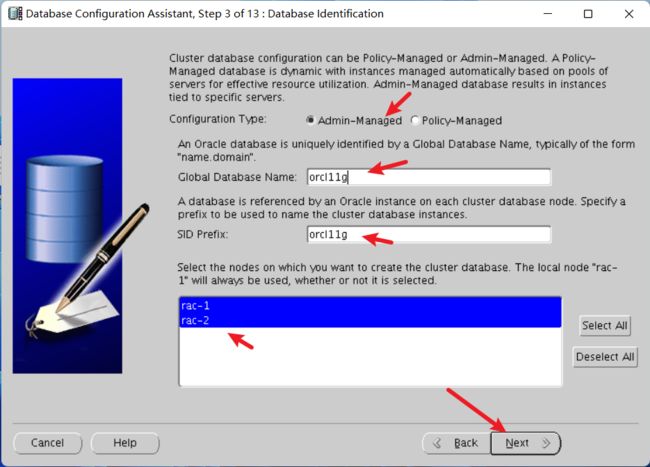

选择管理策略

配置企业管理和自动任务

配置默认用户密码

配置数据库文件存储

配置快速闪回区存储

配置示例方案和安装后脚本

配置初始化参数

配置数据库存储

指定创建数据库

![]()

再次确认数据库信息

完成安装

至此,RAC就正式安装完成,可以自行使用同IP段的服务器测试连接。

错误

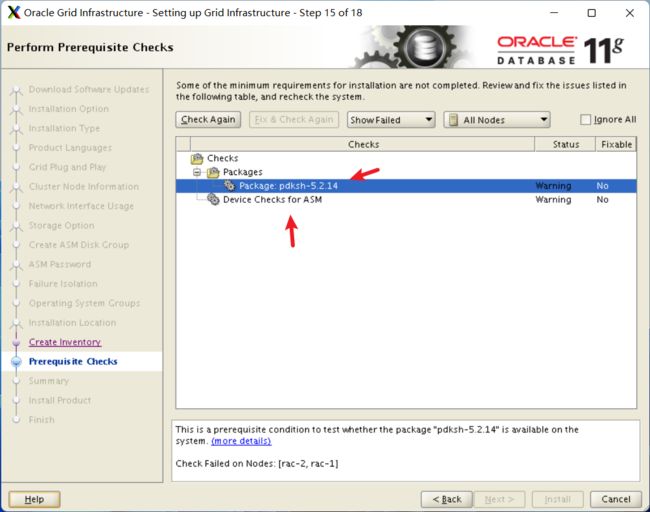

1、Package:pdksh-5.2.14

原因:可以理解为Oracle的bug,和先决条件检查有关系,检查的包不对。

解决方法:

rac-1

# 编辑文件

[root@rac-1 ~]# vim /u01/software/grid/stage/cvu/cv/admin/cvu_config

将OEL4修改为OEL6,保存退出即可。

CV_ASSUME_DISTID=OEL6

rac-2

# 编辑文件

[root@rac-2 ~]# vim /u01/software/grid/stage/cvu/cv/admin/cvu_config

将OEL4修改为OEL6,保存退出即可。

CV_ASSUME_DISTID=OEL6

两个节点上的文件都修改后,退出重新执行安装Grid界面即可。

2、Device Checks for ASM

原因:此问题好像是Oracle的bug,需要打补丁才行。

解决方法:暂时忽略警告,经过测试是不影响使用的,当然,最好是能够打补丁修复。

3、执行脚本root.sh脚本报错CRS-2101:The OLR was formatted using version 3.

原因:Oracle的bug

解决方法:可以通过打补丁去解决,如果不想打补丁,则执行一下命令。注意,所有节点都需要执行。

新开个bash窗口,执行如下命令,即可正常安装。注意,必须是执行root脚本或报错后才可以执行此命令,不然会报错文件找不到或目录找不到。

# 进入到临时目录中

[root@rac-1 ~]# cd /var/tmp/.oracle

# 新建npohasd文件

[root@rac-1 ~]# touch npohasd

# 授权npohasd文件

[root@rac-1 ~]# chmod 755 npohasd

4、安装Grid最后报错INS-20802

原因:没有配置DNS解析导致的SCAN IP解析失败。

解决方法:测试两个节点SCAN IP是否可以ping通,如果可以ping通,则跳过即可。

5、安装database软件报错

原因:Oracle的漏洞导致

解决方法:

编辑ins_emagent.mk文件

[root@rac-1 ~]# vim /u01/app/oracle/product/11.2.0/dbhome_1/sysman/lib/ins_emagent.mk

在$(MK_EMAGENT_NMECTL)后面新增-lnnz11

# emdctl

#===========================

$(SYSMANBIN)emdctl:

$(MK_EMAGENT_NMECTL) -lnnz11

6、执行节点2的root脚本时报错

原因:和私网网卡的HAIP有关系,Oracle RAC会利用私网去创建169.254.XXX.XXX网段来用于节点间的心跳检测。如果这两台节点上的私网HAIP不通,则会造成此问题。

解决方法:通过ifconfig去看下两个节点间的HAIP地址,然后检查两个IP是否可以正常通信。(在裸金属服务器中有遇到过此情况,HAIP不通,让云服务器的工程师处理后,正常执行root脚本)