4. 云原生之kubesphere基础服务搭建

文章目录

- 安装kubesphere插件

- 服务暴露

-

- NodePort方式

- LoadBalancer方式

-

- 安装 OpenELB

- 部署eip资源

- 配置网关

-

- 启动网关

- 创建路由

- 测试网关路由

- ingress高级功能

- 在服务中配置LoadBalancer

- 基础设施部署

-

- 服务部署建议

-

- helm仓库

- 添加helm仓库

- 运维相关

-

- 部署gitlab

- 部署nexus3

- 部署harbor

- 研发相关

安装kubesphere插件

官网参考:概述

- 资源定义->搜索clusterconfiguration

- 点击进入编辑ks-installer

- 编辑内容如下

若是担心内容存在出入可使用内容对比工具在线文本比对工具 | 菜鸟工具

替换内容确定后会自动安装相关插件

apiVersion: installer.kubesphere.io/v1alpha1

kind: ClusterConfiguration

metadata:

annotations:

kubectl.kubernetes.io/last-applied-configuration: >

{"apiVersion":"installer.kubesphere.io/v1alpha1","kind":"ClusterConfiguration","metadata":{"annotations":{},"labels":{"version":"v3.3.2"},"name":"ks-installer","namespace":"kubesphere-system"},"spec":{"alerting":{"enabled":false},"auditing":{"enabled":false},"authentication":{"jwtSecret":""},"common":{"core":{"console":{"enableMultiLogin":true,"port":30880,"type":"NodePort"}},"es":{"basicAuth":{"enabled":false,"password":"","username":""},"elkPrefix":"logstash","externalElasticsearchHost":"","externalElasticsearchPort":"","logMaxAge":7},"gpu":{"kinds":[{"default":true,"resourceName":"nvidia.com/gpu","resourceType":"GPU"}]},"minio":{"volumeSize":"20Gi"},"monitoring":{"GPUMonitoring":{"enabled":false},"endpoint":"http://prometheus-operated.kubesphere-monitoring-system.svc:9090"},"openldap":{"enabled":false,"volumeSize":"2Gi"},"redis":{"enabled":false,"volumeSize":"2Gi"}},"devops":{"enabled":false,"jenkinsMemoryLim":"8Gi","jenkinsMemoryReq":"4Gi","jenkinsVolumeSize":"8Gi"},"edgeruntime":{"enabled":false,"kubeedge":{"cloudCore":{"cloudHub":{"advertiseAddress":[""]},"service":{"cloudhubHttpsNodePort":"30002","cloudhubNodePort":"30000","cloudhubQuicNodePort":"30001","cloudstreamNodePort":"30003","tunnelNodePort":"30004"}},"enabled":false,"iptables-manager":{"enabled":true,"mode":"external"}}},"etcd":{"endpointIps":"192.168.31.21,192.168.31.22,192.168.31.23","monitoring":false,"port":2379,"tlsEnable":true},"events":{"enabled":false},"logging":{"enabled":false,"logsidecar":{"enabled":true,"replicas":2}},"metrics_server":{"enabled":false},"monitoring":{"gpu":{"nvidia_dcgm_exporter":{"enabled":false}},"node_exporter":{"port":9100},"storageClass":""},"multicluster":{"clusterRole":"none"},"network":{"ippool":{"type":"none"},"networkpolicy":{"enabled":false},"topology":{"type":"none"}},"openpitrix":{"store":{"enabled":false}},"persistence":{"storageClass":""},"servicemesh":{"enabled":false,"istio":{"components":{"cni":{"enabled":false},"ingressGateways":[{"enabled":false,"name":"istio-ingressgateway"}]}}},"terminal":{"timeout":600},"zone":"cn"}}

labels:

version: v3.3.2

name: ks-installer

namespace: kubesphere-system

spec:

alerting:

enabled: true

auditing:

enabled: true

authentication:

jwtSecret: ''

common:

core:

console:

enableMultiLogin: true

port: 30880

type: NodePort

es:

basicAuth:

enabled: false

password: ''

username: ''

elkPrefix: logstash

externalElasticsearchHost: ''

externalElasticsearchPort: ''

logMaxAge: 7

gpu:

kinds:

- default: true

resourceName: nvidia.com/gpu

resourceType: GPU

minio:

volumeSize: 20Gi

monitoring:

GPUMonitoring:

enabled: false

endpoint: 'http://prometheus-operated.kubesphere-monitoring-system.svc:9090'

openldap:

enabled: false

volumeSize: 2Gi

redis:

enabled: false

volumeSize: 2Gi

devops:

enabled: true

jenkinsMemoryLim: 8Gi

jenkinsMemoryReq: 2Gi

jenkinsVolumeSize: 8Gi

edgeruntime:

enabled: false

kubeedge:

cloudCore:

cloudHub:

advertiseAddress:

- ''

service:

cloudhubHttpsNodePort: '30002'

cloudhubNodePort: '30000'

cloudhubQuicNodePort: '30001'

cloudstreamNodePort: '30003'

tunnelNodePort: '30004'

enabled: false

iptables-manager:

enabled: true

mode: external

etcd:

endpointIps: '192.168.31.21,192.168.31.22,192.168.31.23'

monitoring: false

port: 2379

tlsEnable: true

events:

enabled: true

logging:

enabled: true

logsidecar:

enabled: true

replicas: 2

metrics_server:

enabled: true

monitoring:

gpu:

nvidia_dcgm_exporter:

enabled: false

node_exporter:

port: 9100

storageClass: ''

multicluster:

clusterRole: none

network:

ippool:

type: calico

networkpolicy:

enabled: true

topology:

type: weave-scope

openpitrix:

store:

enabled: true

persistence:

storageClass: ''

servicemesh:

enabled: false

istio:

components:

cni:

enabled: false

ingressGateways:

- enabled: false

name: istio-ingressgateway

terminal:

timeout: 600

zone: cn

- 查看安装情况

kubectl logs -n kubesphere-system $(kubectl get pod -n kubesphere-system -l 'app in (ks-install, ks-installer)' -o jsonpath='{.items[0].metadata.name}') -f

服务暴露

NodePort方式

LoadBalancer方式

安装 OpenELB

进入应用商店搜索OpenELB进行安装,安装0.2.6版本,无需修改配置直接安装

0.5.0版本会出现连接失败问题,导致容器不同重启

部署eip资源

- 编辑layer2-eip.yaml

apiVersion: network.kubesphere.io/v1alpha2

kind: Eip

metadata:

name: layer2-eip

spec:

address: 192.168.31.11-192.168.31.13

interface: ens192

protocol: layer2

- 部署eip

kubectl apply -f layer2-eip.yaml

- 查看eip

[root@ksmaster21 yaml]# kubectl get eip

NAME CIDR USAGE TOTAL

layer2-eip 192.168.31.11-192.168.31.13 3 3

配置网关

- 在应用商店搜索nginx部署用于测试

启动网关

lb.kubesphere.io/v1alpha1:openelb

protocol.openelb.kubesphere.io/v1alpha1:layer2

eip.openelb.kubesphere.io/v1alpha2:layer2-eip

创建路由

本质是ingress-nginx,适合http类型的请求进行转发

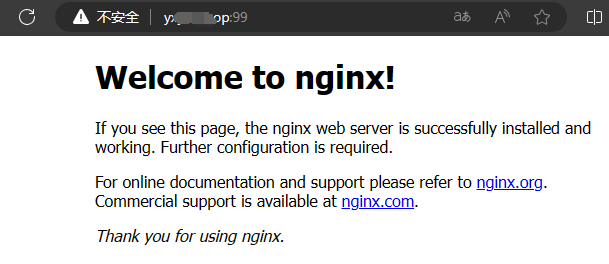

当上图网关地址出现信息则表格成功

测试网关路由

- 在ikuai中配置端口映射

- 使用域名:端口访问

ingress高级功能

- 高级功能通过注释实现,参考:ingress-nginx注解配置

在服务中配置LoadBalancer

mysql、redis需通过tcp连接,需在服务中配置外部访问

lb.kubesphere.io/v1alpha1:openelb

protocol.openelb.kubesphere.io/v1alpha1:layer2

eip.openelb.kubesphere.io/v1alpha2:layer2-eip

基础设施部署

服务部署建议

- 应用商店(添加三方应用商店)

- helm部署

- 编写k8s资源部署【资源多概念多】

- docker-compose转化为k8s资源部署

- docker-compose转化为k8s资源,在转化helm【定制化】

- 原生docker部署

- 自制应用

helm仓库

- https://kubernetes.github.io/ingress-nginx:

这是 Ingress Nginx 官方维护的 Helm 仓库。它提供了 Ingress Nginx 控制器的 Helm Chart,用于在 Kubernetes 集群中部署和管理 Ingress Nginx。 - https://charts.kubesphere.io/main:

这是 KubeSphere 官方维护的 Helm 仓库。KubeSphere 是一个开源的 Kubernetes 容器平台,该仓库提供了一系列与 KubeSphere 相关的 Helm Charts,用于部署和管理 KubeSphere 的各个组件和功能。 - https://mirror.kaiyuanshe.cn/kubernetes/charts/:

这是开源社区开源中国维护的 Helm 仓库镜像。它提供了一系列常用的 Kubernetes Helm Charts,包括各种应用、服务和工具的 Charts。 - https://mirror.azure.cn/kubernetes/charts/:

这是 Azure 中国区官方维护的 Helm 仓库镜像。它提供了一系列常用的 Kubernetes Helm Charts,包括各种应用、服务和工具的 Charts。 - https://charts.helm.sh/stable:

这是 Helm 官方维护的稳定版本 Helm 仓库。它提供了广泛使用的各种应用、服务和工具的稳定版本 Charts。然而,自 Helm 3.0 版本起,Helm 官方不再维护这个仓库,而是鼓励开发者将 Charts 发布到其他仓库。 - https://charts.bitnami.com/bitnami:

这是 Bitnami 维护的 Helm 仓库。Bitnami 提供了许多流行应用的 Helm Charts,使用户能够轻松地在 Kubernetes 上部署和管理这些应用。 - https://kubernetes.oss-cn-hangzhou.aliyuncs.com/charts:

这是阿里云官方维护的 Helm 仓库。它提供了一系列常用的 Kubernetes Helm Charts,包括各种应用、服务和工具的 Charts。阿里云还提供了其他地区的镜像仓库。

添加helm仓库

运维相关

运维相关基础设施特点是部署后基本就不会再动,出于稳定性考虑,可以考虑部署在k8s集群之外,好处在于:

- 避免个人在玩kubesphere时,把集群搞奔溃恢复不了

- 使用docker-compose部署比在kubesphere部署门槛低

- 使用docker-compose部署方便进行迁移

部署gitlab

汉化版:https://github.com/twang2218/gitlab-ce-zh

docker-compose.yaml

version: '2'

services:

gitlab:

image: 'twang2218/gitlab-ce-zh:11.1.4'

restart: unless-stopped

hostname: 'gitlab.example.com'

environment:

TZ: 'Asia/Shanghai'

GITLAB_OMNIBUS_CONFIG: |

# 使用服务内部域名

external_url 'http://192.168.31.8'

gitlab_rails['time_zone'] = 'Asia/Shanghai'

# 需要配置到 gitlab.rb 中的配置可以在这里配置,每个配置一行,注意缩进。

# 比如下面的电子邮件的配置:

# gitlab_rails['smtp_enable'] = true

# gitlab_rails['smtp_address'] = "smtp.exmail.qq.com"

# gitlab_rails['smtp_port'] = 465

# gitlab_rails['smtp_user_name'] = "[email protected]"

# gitlab_rails['smtp_password'] = "password"

# gitlab_rails['smtp_authentication'] = "login"

# gitlab_rails['smtp_enable_starttls_auto'] = true

# gitlab_rails['smtp_tls'] = true

# gitlab_rails['gitlab_email_from'] = '[email protected]'

ports:

- '1000:80'

- '1001:443'

- '1002:22'

volumes:

- config:/etc/gitlab

- data:/var/opt/gitlab

- logs:/var/log/gitlab

volumes:

config:

data:

logs:

登录http://192.168.31.8后台修改密码

部署nexus3

访问地址: http://ip:8081/

3.17版本密码改成随即的了,而且登录时候提示密码在/nexus-data/admin.password里

version: "3.3"

services:

nexus:

image: sonatype/nexus3

container_name: nexus3

restart: always

environment:

- TZ=Asia/Shanghai

ports:

- 1003:8081

volumes:

- ./nexus-data:/nexus-data

部署harbor

通过应用商店部署,核心在于TLS/SSL的配置,若是不清楚可采用docekr-compose进行部署修改。

自行选择版本:https://github.com/goharbor/harbor/releases

迅雷下载:https://storage.googleapis.com/harbor-releases/release-2.10.0/harbor-offline-installer-v2.10.0.tgz

Docker-compose部署Harbor实操

官网安装文档

helm部署harbor参考:【K8S教程】Helm方式部署Harbor

- 下载安装包

wget https://storage.googleapis.com/harbor-releases/release-2.10.0/harbor-offline-installer-v2.10.0.tgz

- 解压

tar -xzvf harbor-offline-installer-v2.10.0.tgz

- 查看解压目录

- 修改harbor.yml配置

将 harbor.yml.tmpl命名为harbor.yml,主要修改配置如下:

hostname: 域名或ip

https:

port: 443

# 证书路径

certificate: /data/harbor/cart/harbor.crt

private_key: /data/harbor/cart/harbor.key

harbor_admin_password: 登录密码

database:

password: 数据库密码

data_volume: /data/harbor

- 生成ssl证书,并拷贝到指定位置

- 如购买了ssl证书可直接使用,若没有则参考官网:配置harbor对https的访问

- 使用购买的证书和生成的证书区别:生成的证书需要再harbor和docker上都配置

- 将ssl证书拷贝到指定位置

- 首次安装执行安装命令

./install.sh

安装后会生成docker-compse.yaml文件 ,若出现端口冲突问题请修改docker-compse.yaml文件修改nginx端口为1004

- 编译

./prepare

- 使用docker-compose命令重启

研发相关

研发相关的基础设施特点:

- 变动也比较少,但比运维相关基础设施变动高

- 业务服务会与这些组件交互,从性能角度考虑建议部署到k8s中

研发相关组件mysql、redis、nacos等,这儿不详细介绍,部署方式介绍两种:

- 通过应用商店部署

- 习惯docker-compose方式部署的,可以转化为kubesphere可视化操作部署