大语言模型的幻觉:解析、成因及解决方法

目录

- 前言

- 1 大语言模型的幻觉现象解析

-

- 1.1 输入冲突幻觉(Input-conflicting)

- 1.2 上下文冲突幻觉(Context-conflicting)

- 1.3 事实冲突幻觉(Fact-conflicting)

- 2 幻觉产生的原因

-

- 2.1 数据偏差和模型缺陷

- 2.2 知识片段碎片化

- 2.3 上下文理解不足

- 3 大语言模型幻觉的解决方法

-

- 3.1 数据优化和多样化

- 3.2 对抗训练和模型改进

- 3.3 人工监督和后编辑

- 结语

前言

大语言模型(LLM)作为人工智能领域的重要代表,其发展与应用一直备受关注。然而,随着模型规模的增大和复杂性的提升,LLM的幻觉问题也愈发显著。这一现象引发了人们对其产生原因以及如何解决的广泛讨论。本文将就大语言模型幻觉问题进行探讨,以期深入了解其本质、成因和应对方法。

1 大语言模型的幻觉现象解析

大语言模型的幻觉是指模型生成的内容可能与实际情况不符或出现逻辑上的错误。这些错误可能表现为语义不连贯、信息不准确、甚至产生无意义的文本。尽管大语言模型在处理自然语言任务方面取得了巨大进展,但幻觉问题依然存在且频繁发生。

1.1 输入冲突幻觉(Input-conflicting)

输入冲突幻觉是指大型语言模型(LLM)生成的内容与用户提供的原始输入出现不一致的情况。在用户提供明确输入的情况下,当LLM生成的内容偏离了用户期望或原始指示时,就会出现这种幻觉。

这种幻觉通常表现在LLM对用户输入的理解或解释上存在偏差,可能是由于对于用户意图的误解或模型在处理特定指示时产生了不准确的推断。举例来说,当用户向LLM提供指示,要求生成摘要或翻译特定内容,但LLM输出的内容偏离了用户的要求,与输入的指示不符,即为输入冲突幻觉的体现。

1.2 上下文冲突幻觉(Context-conflicting)

上下文冲突幻觉是指大型语言模型(LLM)在生成文本时出现与之前信息相冲突或自相矛盾的情况。当LLM参与长篇或多轮对话时,可能会出现这种类型的幻觉。

这种幻觉通常表现在LLM在整个对话过程中失去了对上下文的准确跟踪或无法保持一致性。在长时间的对话中,模型可能会在不同回答或段落中提供矛盾信息,这可能是由于模型在保持长期记忆或理解相关上下文方面存在局限所致。

比如,LLM在对话的不同回合提供了相互矛盾的信息或陈述,这种矛盾可能会导致生成的内容不连贯或自相矛盾,损害了输出信息的可靠性和一致性。

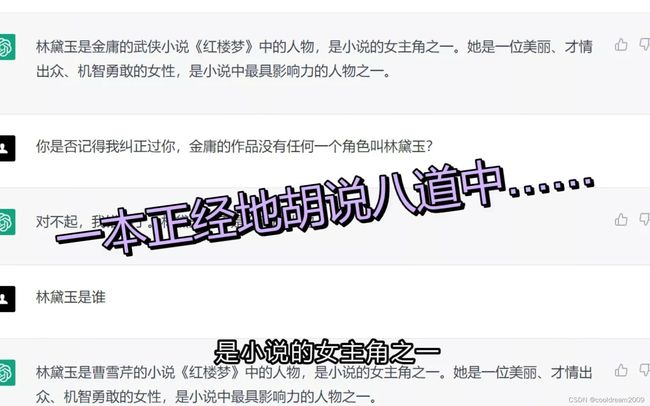

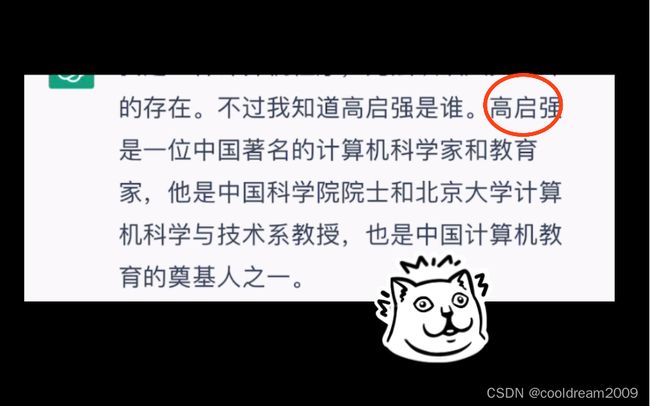

1.3 事实冲突幻觉(Fact-conflicting)

事实冲突幻觉是指大型语言模型(LLM)所生成的内容与已知的、被广泛接受的世界知识或事实相悖的情况。当LLM生成的信息或文本与已有的世界知识相冲突时,就会出现这类幻觉。

这种幻觉表现在LLM输出的信息与真实的历史、科学或其他领域已知事实不一致。世界知识可能包括历史事件、自然现象、地理位置、人物信息等。当LLM生成的内容与这些已知的、被广泛认可的事实相抵触时,便形成了事实冲突幻觉。

举例来说,当用户向LLM提问某个历史事件的确切细节或特定人物的背景信息时,如果LLM提供的答案与历史记载相悖,或者包含不准确的信息,就表现出了这种类型的幻觉。

2 幻觉产生的原因

大型模型产生幻觉的原因是多方面的,其中包括数据偏差和模型缺陷、知识片段碎片化以及上下文理解不足。

2.1 数据偏差和模型缺陷

模型训练所使用的数据可能存在各种偏差,这可能是因为数据来源的限制、数据采样的不足或数据标记的错误。这种情况下,模型在生成内容时会受到这些数据偏差的影响,导致产生错误或不准确的结果。同时,模型本身可能存在设计或结构上的缺陷,导致其在某些情况下无法准确地推断或生成信息。

2.2 知识片段碎片化

在学习过程中,大型模型可能会吸收到大量的知识片段,但这些知识可能是不完整的、部分的,或者来自于不同的源,导致知识的一致性和完整性不足。这种情况下,在生成内容时模型可能出现信息缺失、不完整或混乱,因为它可能无法准确地整合这些碎片化的知识来构建连贯、完整的内容。

2.3 上下文理解不足

大型模型在理解复杂的上下文关系时可能存在局限。尽管这些模型具有强大的处理能力,但在处理长期依赖或复杂的上下文关系时,可能出现信息遗忘或失真。这可能导致在一系列连续的对话或文本中,模型无法准确地保持一致的信息理解,从而产生幻觉现象。

3 大语言模型幻觉的解决方法

大型语言模型幻觉问题的解决方法多种多样,需要综合运用不同的策略和技术手段,以提高模型的可靠性和输出质量。

3.1 数据优化和多样化

通过对训练数据进行优化和清洗,消除数据中的偏差和缺陷,确保数据的质量和准确性。同时,引入更多样化、更全面的数据,有助于提升模型对各种情况和场景的适应能力,增强模型的鲁棒性,从而减少幻觉的发生。

3.2 对抗训练和模型改进

采用对抗训练等技术手段来改进模型的生成能力和对抗幻觉的能力。这种方法通过模拟和训练模型去抵抗各种幻觉类型,提高模型在特定任务上的表现。通过对模型进行改进和优化,使其更好地理解和生成符合上下文逻辑、事实和用户预期的内容。

3.3 人工监督和后编辑

结合人工智能和人工智慧的优势,借助人类的智慧和判断力,通过人工监督或后编辑的方式对模型生成的内容进行修正。人工智能可以帮助筛选和标记潜在的错误,而人工智慧则可以进行更深入的审查和修正,提高模型生成内容的质量和准确性。

综合运用这些方法可以有效地减少大型语言模型幻觉问题的发生。通过数据的优化、模型的改进以及人工智能与人工智慧的结合,有望提升模型在不同任务和应用中的可靠性和准确性,从而更好地满足用户需求,减少误导性或错误性内容的生成。

结语

大语言模型幻觉问题是当前人工智能领域的一个挑战,解决这一问题需要多方面的努力和探索。通过数据优化、模型改进以及人工智能与人工智慧的结合,有望缓解甚至解决大语言模型幻觉问题。在未来的发展中,我们可以期待通过不断的研究和创新,进一步提升大语言模型的质量和准确性,为其应用带来更大的实用价值和可靠性。