一不留神,大模型已经学会操纵手机了?!

你好,我是坚持分享干货的 EarlGrey,翻译出版过《Python编程无师自通》、《Python并行计算手册》等技术书籍。

如果我的分享对你有帮助,请关注我,一起向上进击。

本文分享自量子位。

一不留神,大模型已经学会了操纵手机?

最近,腾讯最新多模态智能体框架AppAgent曝光,可以像人类一样操作各种应用。

比如在地图软件中输入目标地址,然后唤起导航。

或者想要发一封邮件,AppAgent也能轻松编写,然后直接在客户端中发送。

就算是“反人类”的验证码,也丝毫难不住AppAgent。

甚至是用Lightroom这样人类都不一定会的专业软件P图,也能三下五除二地完成。

而且它还可以观察人类操作,甚至是自主探索,不用教就能学会新的APP。

目前,该项目在GitHub上已经取得了1.5k星标。

操纵水平超越GPT4

为了更具体地评估AppAgent的表现,研究团队一共在10个不同的应用程序上测试了50个任务,其中还包括没有学习过的新APP或操作,结果它都能出色完成。

除了P图的效果由人工评判,AppAgent在其它九个APP上的表现,分别用成功率(SR)、奖励分数和平均步数来衡量。

在自动探索模式下时,AppAgent完成这些任务的成功率达到了73.3%,学习过DEMO之后可以提升到84.4%。

虽然离人类手工指导的95.6%还存在差距,但这样的表现已经远远超过了GPT-4。

而在使用Lightroom进行P图操作时,真人会对“参赛选手”的表现进行评价,评价的方式是对它们的作品效果进行排名而不是打分。

结果AppAgent自行学习DEMO后,表现的平均排名为1.95/3,略低于手工指导的1.75,但比GPT4的2.3还是高出不少。

那么,AppAgent优异表现的背后,采用了什么样的方法呢?

通过界面变化学习操作

研究人员给AppAgent设定了点击、长按、滑动、输入、返回和退出这六种预置操作。

后续的学习过程和操作方案,都是由这六种操作按一定顺序排列组合而成的。

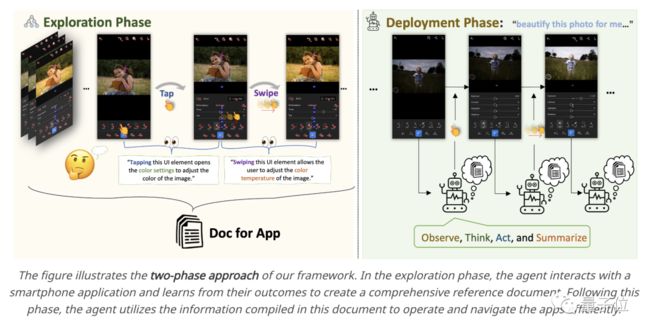

模型方面,AppAgent的基础模型是多模态版的GPT4;工作流程则分为了探索和操作两个阶段。

探索阶段中,研究人员会把应用说明和标有界面中元素位置的XML文件,连同界面截图一起输入给模型。

然后模型通过分析不同截图之间的界面变化,学习APP的功能和操作逻辑。

以发送邮件为例,人类的操作过程被转换成六种预置操作的组合,然后被AppAgent学习。

到了操作阶段,AppAgent会调用学习后的知识库,对应用界面进行分析,了解界面中的功能并根据任务需要设计操作策略。

目前,AppAgent已有DEMO可供体验,暂只支持安卓手机,具体详情和使用方法可以到项目页中查看。

论文地址:

https://www.arxiv.org/abs/2312.13771

- EOF -

文章已经看到这了,别忘了在右下角点个“赞”和“在看”鼓励哦~

推荐阅读 点击标题可跳转

1、VS Code 变身小霸王游戏机!

2、认知升级:模型与范式转换

3、超赞的 Python 编译器,单核提速100倍

4、高效的终极秘诀

5、Python 3.12 版本有什么变化?

回复下方「关键词」,获取优质资源

回复关键词「 pybook03」,领取进击的Grey与小伙伴一起翻译的《Think Python 2e》电子版

回复关键词「书单02」,领取进击的Grey整理的 10 本 Python 入门书的电子版

关注我的公众号

告诉你更多细节干货

欢迎围观我的朋友圈

每天更新所想所悟