symmetryMDPI2022(GSTN):A Graph Skeleton Transformer Network for Action Recognition

A Graph Skeleton Transformer Network for Action Recognition

- Abstract

- 1. Introduction

- 2. Methods

-

- 2.1. Feature Encoding

-

- 2.1.1. Spatial Position Encoding

- 2.1.2. Centrality Encoding

- 2.2. GST Layer

-

- 2.2.1. Self-Attention Mechanism in the GST Layer

- 2.2.2. Introduction of Graphical Information

- 2.2.3. Multi-Head Attention

- 2.3. GST Module

- 2.4. GST NetWork

- 2.5. Grid-Search-Based Multi-Stream Fusion Strategy

- 3. Experiments

-

- 3.1. Experimental Details

-

- 3.1.1. Effectiveness of Feature Encoding

- 3.1.2. Effectiveness of the Introduction of Graphical Information

- 3.1.3. Effectiveness of Grid-Search-Based Multi-Stream Fusion Strategy

- 3.2. Comparison with Previous Methods

- 4. Conclusions

Abstract

GCN 主要依靠图拓扑来描述关节之间的依赖关系,在捕获长距离依赖方面受到限制。

基于 Transformer 的方法有效地捕获长距离依赖,但由于没有关注初始图结构信息会丢失人体骨骼关节的固有连接信息。

本文通过Transformer架构提取全局特征,并利用对称矩阵表示的无向图信息提取局部特征,通过两种编码方法改进关节的语义和中心性特征,使用基于网格搜索的方法优化多流融合策略

1. Introduction

GCN缺点:(1)非物理连接的关节的依赖关系不能在某些动作中有效地表示。在随后研究中,建立了新的自适应图来进一步表示这种关系。然而,重复使用自适应图卷积来获得非真实连接关节之间的长距离依赖关系会增加计算复杂度。(2)基于 GCN 的方法不区分骨架关节的高阶语义信息

基于 Transformer 的方法通过自我注意机制直接关注骨架的全局信息来提取全局特征;通过位置编码来解决基GCN 方法中不区分语义信息的问题。

基于 Transformer方法的缺点:(1)基于 Transformer 的方法不包含人体骨骼的拓扑结构。人体骨骼组成的拓扑结构包含了人体自然连接的先验知识,忽略了人体自然连接结构特征可能会降低模型的性能。(2)大多数Transformer方法使用多流数据作为模型输入,如关节、骨骼、关节运动和骨骼运动。现有的多流融合策略基于手动修复每个输入权重。然而,在不同数据集设置中使用相同的权重进行多流融合的结果并不是最优的。

本文提出了一种图骨架变压器网络 (GSTN) 来解决上述问题。引入了有关注意力图中骨架关节邻接图结构的信息,这不仅使用 Transformer 的自注意力机制进行非自然连接的关节特征,还添加了图的骨架拓扑,以便更好地学习局部特征。

为了区分不同骨架关节表达的语义和中心性信息,本文采用位置编码和中心性编码来标记关节的语义和中心性信息。

与多流融合策略中的固定权重不同,本文采用基于网格的权重搜索遍历区间内所有可能的权重组合,找到每个流权重的最佳组合。

2. Methods

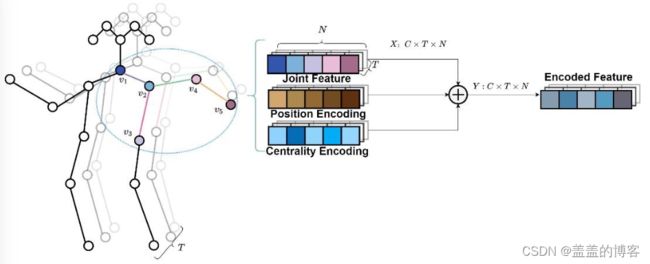

2.1. Feature Encoding

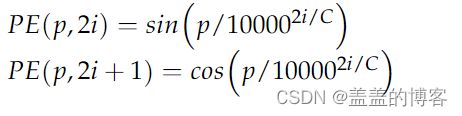

2.1.1. Spatial Position Encoding

2.1.2. Centrality Encoding

在骨架图中,中心性表示连接到关节的骨架边的数量。肢体末端的关节只与一个骨相邻,而中心位置的关节可以相邻多个骨。具有不同中心性的关节可以以不同的方式影响动作识别。

对称邻接矩阵用于表示无向图,来计算每个关节的度。

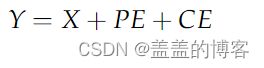

其中 Edp (A) 是第 p 个关节度数的嵌入向量。嵌入维度等于通道数 C。中心性编码通过如下公式添加到输入中:

图2 位置编码和中心性编码的示意图,其中关节特征与两个编码相加以获得编码的特征。

Y是编码的特征。

2.2. GST Layer

2.2.1. Self-Attention Mechanism in the GST Layer

2.2.2. Introduction of Graphical Information

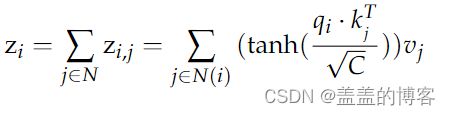

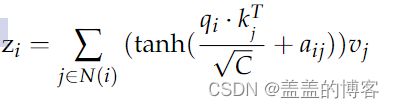

无向邻接图可以表达人体的连通性信息。本文设计了一个名为 A ∈ RN×N 的对称邻接矩阵(N是身体关节的数量)。将名为aij的关节之间的连接添加到公式中,aij表示υi和υj关节之间的邻接关系。υi与其他关节之间的注意关系可表示为式:

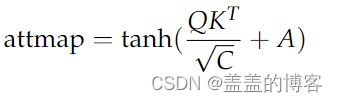

为了使模型学习更多的注意力,并且防止模型过拟合,参考DSTA-net中的全局正则化,引入可学习的注意掩码矩阵B。在图4中,矩阵B完全从训练数据中学习。掩模矩阵的加法允许动态更改边的权重,并将注意力图进一步更新为等式:

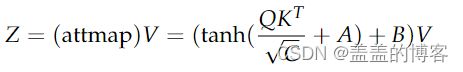

最后,将原始输入特征V与注意图相乘,使inputV得到相应的注意权重,如式所示:

2.2.3. Multi-Head Attention

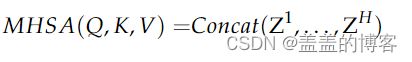

如图 4 所示,本文通过使用线性变换将输入 X 的通道数分成组 H。H 是多头注意力的头部数量。整体多头注意力可以表示为等式:

2.3. GST Module

前馈神经网络层的卷积核为1 × 1,实现输出信息的聚合。功能是独立处理每个关节的特征。

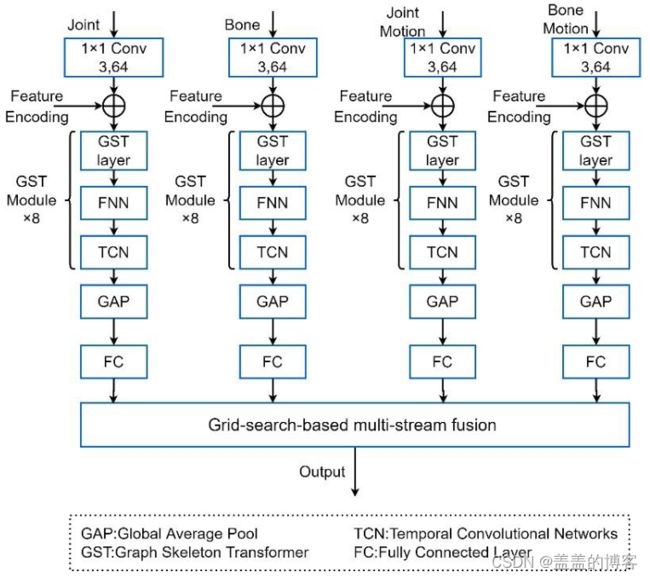

2.4. GST NetWork

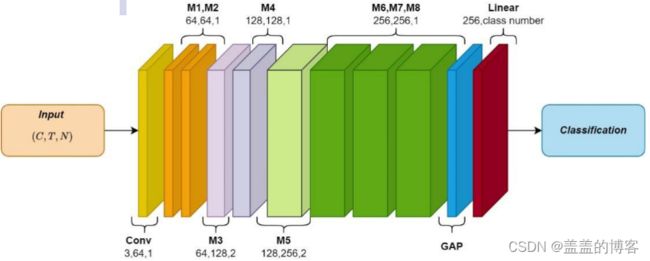

图6 Graph Skeleton Transformer(GSTN)网络结构示意图。通过8个GST模块来提取骨架序列的时空特征。

2.5. Grid-Search-Based Multi-Stream Fusion Strategy

对每个参数的可能值进行排列和组合,列出所有可能组合的结果,并生成“网格”。在遍历所有参数组合后,自动调整到最佳参数组合。

3. Experiments

3.1. Experimental Details

3.1.1. Effectiveness of Feature Encoding

实验结果表明,中心编码和位置编码都有助于提高识别精度。当组合两种方法时,效果会增强得更多,这也证明了将语义信息添加到骨架关节的必要性。

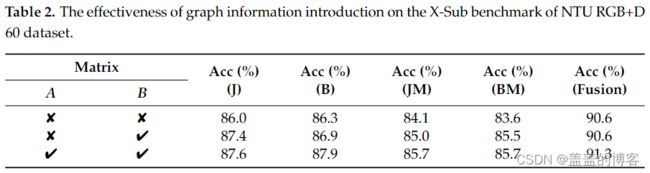

3.1.2. Effectiveness of the Introduction of Graphical Information

3.1.3. Effectiveness of Grid-Search-Based Multi-Stream Fusion Strategy

结果表明,双流输入的精度显着提高,并通过融合四流输入达到更高的精度。

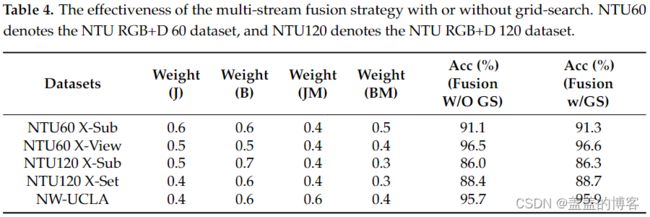

为了证明网格搜索权重对多流融合策略的有效性,我们使用具有固定权重的多流融合作为比较。

应用自动权重搜索获得的权重比直接融合四流时的准确度高 0.1-0.3%。

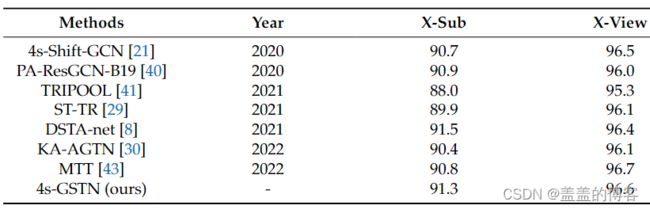

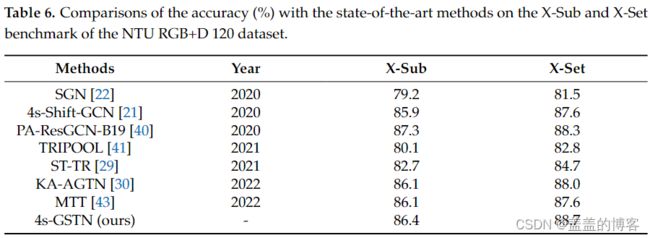

3.2. Comparison with Previous Methods

4. Conclusions

本文的主要贡献包括:(1)编码骨架关节,以便关节的特征包含有关位置和中心性的信息。(2) 添加图信息来弥补 Transformer 中缺乏图信息。(3)多流融合策略采用网格搜索。

未来工作:在输入模型之前融合多流,并在时间维度中使用时间转换器来代替卷积操作。旨在进一步降低参数和FLOPs,提高识别精度。