- AIGC领域AI作画:在数字雕塑中的应用实践

AI原生应用开发

AI原生应用开发AIGCAI作画ai

AIGC领域AI作画:在数字雕塑中的应用实践关键词:AIGC、AI作画、数字雕塑、生成对抗网络、3D建模、艺术创作、深度学习摘要:本文深入探讨了AIGC(人工智能生成内容)技术在数字雕塑领域的创新应用。我们将从技术原理、算法实现到实际案例,全面解析AI如何赋能传统数字雕塑创作流程。文章首先介绍AIGC在艺术创作中的背景和发展现状,然后详细讲解核心算法原理和数学模型,接着通过实际项目案例展示AI作画

- 【C语言】学习过程教训与经验杂谈:思想准备、知识回顾(五)

个人主页:艾莉丝努力练剑❄专栏传送门:《C语言》、《数据结构与算法》、C语言刷题12天IO强训、LeetCode代码强化刷题学习方向:C/C++方向⭐️人生格言:为天地立心,为生民立命,为往圣继绝学,为万世开太平前言:我们在学习过程中会碰到很多很多问题,本系列文章不会博主不会额外再创建一个新的专栏来收录,因为这一系列文章创作的初心主要是针对回顾知识点(遵循遗忘曲线并且根据自身的实际情况可以做出一些

- Python爬虫实战:爬取网易云音乐热评的完整教程

Python爬虫项目

python爬虫开发语言能源selenium

1.背景介绍:为什么爬网易云音乐热评?网易云音乐是中国最受欢迎的音乐平台之一,其用户活跃度极高。评论区往往蕴含丰富的情感表达和用户反馈,是音乐数据分析、情感分析、推荐算法等领域的宝贵数据源。爬取热评可以用于:歌曲口碑分析用户情绪挖掘热门歌曲趋势追踪机器学习训练数据准备但网易云音乐对评论接口进行了加密,直接请求很难成功。本文将帮你攻克这一难点。2.网易云音乐热评接口分析我们首先用浏览器开发者工具(C

- C++实现冒泡,选择,插入排序算法

1.冒泡排序1.主要思路过程总体思想是通过两层循环,逐个来确定当前最值,并通过交换,把最值逐渐移动到某一端,从而完成升序或者降序排序,这段代码采用的是升序,也就是逐个把当前的最大值挪向数组右边。2.代码实现过程冒泡排序中,选出了一个最大值,放在了某一端,下一轮就不会访问到这个上一轮的最大值了,而是从剩下的数中进行选择,这里通过while循环来控制“冒泡“的次数,length为数组长度,每一轮冒泡确

- 阿里也出手了!十分钟接入Spring Cloud Alibaba AI 体验JAVA微服务AI人工智能,可接通义千问等模型,

Java斌

十分钟学会JavaAI人工智能java微服务

什么是SpringAISpringAI是从著名的Python项目LangChain和LlamaIndex中汲取灵感,它不是这些项目的直接移植,它的成立信念是,「下一波生成式人工智能应用程序将不仅适用于Python开发人员,而且将在许多编程语言中无处不在」。我们可以从SpringAI的官网描述中,总结出SpringAI的几个核心的关键词:提供抽象能力简化AI应用的开发模型与向量支持AI集成与自动配置

- 分布式生成 ID 策略的演进和最佳实践,含springBoot 实现(Java版本)

一、背景在单体架构中,ID通常使用数据库自增或UUID即可满足需求。但在微服务、分布式环境中,这些方式存在性能瓶颈、重复冲突、时序不全等问题。因此,分布式ID生成策略应运而生,用于确保在高并发、跨节点、异地部署的系统中,生成全局唯一、趋势递增、高性能的ID。二、演进历程单机自增ID(如数据库自增)Java原生UUID工具类生成(如雪花算法、KeyUtil等)中间件分布式协调(如Zookeeper、

- 【零基础学AI】第33讲:强化学习基础 - 游戏AI智能体

1989

0基础学AI人工智能游戏transformer分类深度学习神经网络

本节课你将学到理解强化学习的基本概念和框架掌握Q-learning算法原理使用Python实现贪吃蛇游戏AI训练能够自主玩游戏的智能体开始之前环境要求Python3.8+PyTorch2.0+Gymnasium(原OpenAIGym)NumPyMatplotlib推荐使用JupyterNotebook进行实验前置知识Python基础编程(第1-8讲)基本数学概念(函数、导数)神经网络基础(第23讲

- 【AI与数据管理】基于AI大模型的企业元数据管理方案

暴躁小师兄数据学院

人工智能ai语言模型

基于AI大模型的元数据关键解决方案元数据(metadata)是描述数据的数据,例如数据的来源、结构、类型和质量信息。它在数据管理、分析和应用中至关重要。随着人工智能(AI)大模型(如基于Transformer的模型)的发展,这些模型凭借其强大的自然语言处理、模式识别和生成能力,为元数据处理提供了高效、自动化的解决方案。下面,我将逐步解释基于AI大模型的元数据关键解决方案,帮助您理解核心方法、挑战和

- 【人工智能之大模型】思维链(Chain of Thought,CoT) 在大模型中是如何引导模型逐步推理的?

985小水博一枚呀

人工智能pytorch语言模型大模型

【人工智能之大模型】思维链(ChainofThought,CoT)在大模型中是如何引导模型逐步推理的?【人工智能之大模型】思维链(ChainofThought,CoT)在大模型中是如何引导模型逐步推理的?文章目录【人工智能之大模型】思维链(ChainofThought,CoT)在大模型中是如何引导模型逐步推理的?前言思维链(CoT)在大模型中的应用示例示例任务:应用思维链提示:模型输出:分析:思维

- 什么是智能体(Agent)?

用什么都重名

大模型相关人工智能Agent大模型

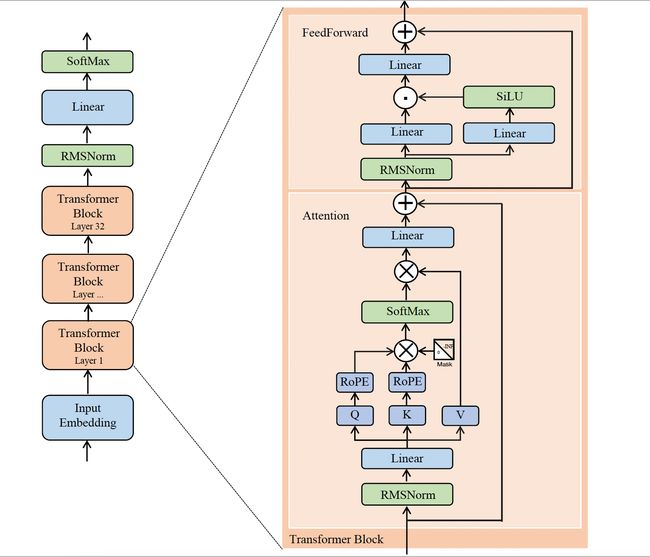

目录前言一、大语言模型1.什么是大语言模型?2.应用领域二、什么是Agent三、Agent核心特点1.感知能力2.规划能力3.行动能力4.记忆能力总结前言目前智能体市场正处于快速发展阶段,呈现出市场规模增长迅猛、应用领域广泛、竞争格局多元化等特点。基于此,让我们一起来学习一下何为智能体。一、大语言模型1.什么是大语言模型?大语言模型是一种采用大量数据进行训练的人工智能模型,主要用于理解和生成自然语

- Python深度学习实践:建立端到端的自动驾驶系统

AI天才研究院

AgenticAI实战计算AI人工智能与大数据计算科学神经计算深度学习神经网络大数据人工智能大型语言模型AIAGILLMJavaPython架构设计AgentRPA

Python深度学习实践:建立端到端的自动驾驶系统1.背景介绍自动驾驶系统是当今科技领域最具挑战性和前景的应用之一。它融合了计算机视觉、深度学习、规划与控制等多个领域的先进技术,旨在实现车辆的自主感知、决策和操控。随着人工智能技术的不断发展,越来越多的公司和研究机构投入了大量资源来开发自动驾驶系统。Python作为一种高效、易学且开源的编程语言,在这一领域扮演着重要角色。本文将探讨如何利用Pyth

- 华为OD机试 2025B卷 - 字符串序列判定(C++&Python&JAVA&JS&C语言)

YOLO大师

华为od华为OD机试2025B卷华为OD2025B卷华为OD机试华为OD机考2025B卷

2025B卷目录点击查看:华为OD机试2025B卷真题题库目录|机考题库+算法考点详解2025B卷100分题型题目描述:字符串序列判定/最后一个有效字符(本题分值100)输入两个字符串S和L,都只包含英文小写字母。S长度<=100,L长度<=500,000。判定S是否是L的有效子串。判定规则:S中的每个字符在L中都能找到(可以不连续),且S在L中字符的前后顺序与S中顺序要保持一致。(例如,S=”a

- C++11 算法详解:std::copy_if 与 std::copy_n

码事漫谈

c++11c++算法开发语言

文章目录引言std::copy_if:条件筛选复制函数原型核心功能参数解析返回值实现逻辑示例:筛选容器中的偶数注意事项std::copy_n:固定数量复制函数原型核心功能参数解析返回值实现逻辑示例:复制前N个元素注意事项对比分析与应用场景功能差异性能对比典型应用场景`std::copy_if`适用场景`std::copy_n`适用场景最佳实践与常见陷阱1.避免目标容器空间不足2.谓词函数的设计3.

- C++游戏开发需要具备哪些能力

星宇工作室

c++开发语言

1.C++语言基础:熟悉C++语法,包括变量、数据类型、控制结构(if,for,while等)、函数、类和对象等。理解C++的内存管理,包括堆和栈的区别、动态内存分配(new/delete)和智能指针的使用。掌握C++的高级特性,如模板、异常处理、STL(标准模板库)等。2.面向对象编程(OOP):理解面向对象的概念,如封装、继承和多态。能够设计和实现面向对象的系统。3.数据结构和算法:熟悉基本的

- 华为OD机试 2025B卷 - 小明减肥(C++&Python&JAVA&JS&C语言)

YOLO大师

华为odc++python华为OD2025B卷华为OD机试华为机试2025B卷华为OD机试2025B卷

2025B卷目录点击查看:华为OD机试2025B卷真题题库目录|机考题库+算法考点详解2025B卷100分题型最新华为OD机试真题目录:点击查看目录华为OD面试真题精选:点击立即查看题目描述小明有n个可选运动,每个运动有对应卡路里,想选出其中k个运动且卡路里和为t。k,t,n都是给定的。求出可行解数量输入描述第一行输入ntk第一行输入每个运动的卡路里按照空格进行分割备注00,00输出描述求出可行解

- AIGC空间智能在服装设计领域的颠覆性变革

AI天才研究院

ChatGPT实战ChatGPTAI大模型应用入门实战与进阶AIGCai

AIGC空间智能在服装设计领域的颠覆性变革关键词:AIGC、空间智能、服装设计、数字孪生、生成式AI、3D人体建模、智能设计系统摘要:本文深入探讨AIGC(人工智能生成内容)与空间智能技术在服装设计领域的融合创新,揭示其如何通过三维人体建模、场景模拟、智能生成算法重构传统设计流程。从技术原理层解析空间智能的核心模块,结合生成对抗网络(GAN)、Transformer模型等前沿算法,展示从创意生成到

- OpenCV实战之二 | 基于哈希算法比较图像的相似性

w94ghz

OpenCV实战笔记opencv哈希算法人工智能

前言☘️本章节主要介绍常用的图像相似性评价算法:图像哈希算法。图像哈希算法通过获取图像的哈希值并比较两幅图像的哈希值的汉明距离来衡量两幅图像是否相似。两幅图像越相似,其哈希值的汉明距离越小。图像哈希算法可以用于图片检索,重复图片剔除,以图搜图以及图片相似度比较。目录一、汉明距离二、img_hash模块三、哈希算法哈希算法实现步骤:代码实现一、汉明距离汉明距离(HammingDistance)是用于

- 煤炭传送带YOLOv8异物检测系统介绍

qq1309399183

计算机视觉实战项目集合YOLO目标检测人工智能深度学习计算机视觉传送带识别异物识别

传送带YOLOv8异物检测系统介绍随着工业自动化水平的不断提高,传送带系统在矿山、食品加工、制造业等领域的应用日益广泛。然而,传送带在运行过程中常常会混入各种异物,如金属零件、石块、木块等,这些异物不仅会影响产品质量,还可能损坏设备甚至危及人员安全。基于YOLOv8算法的传送带异物检测系统应运而生,为解决这一问题提供了智能化解决方案。系统概述YOLOv8(YouOnlyLookOnceversio

- 【学无止境,每天一题】三倍子串

请叫我小蜜蜂同学

算法c++

题目:三倍子串题目描述第三届上海青少年算法竞赛T4时间限制:1000ms空间限制:256mb给定一个十进制正整数n,请问可以从n中截取多少种不同的子串,使得子串构成的数字是3的倍数。例如:当n=1234,有且仅有3,12,123,234这四个子串是3的倍数。输入格式单个整数:表示输入的数字n输出格式单个整数:表示3的倍数的子串数量。数据范围对于20%的数据,1≤n≤10^9对于50%的数据,1≤n

- Python编程菜鸟教程:从入门到精通的完全指南_python菜鸟教程

2401_89285717

python开发语言

我们将介绍Python在数据科学、机器学习、Web开发等方面的应用,并带你了解Python社区和生态系统。基础入门Python安装:在官方网站下载安装包,根据不同操作系统进行安装。Mac用户可直接使用Homebrew进行安装Windows用户需下载安装包后进行手动安装Linux用户可使用apt-get或yum进行安装基础语法:Python是一种解释型语言,支持面向对象、函数式和面向过程等多种编程范

- Docker快速部署Hive服务

长路 ㅤ

运维Docker配置Hive环境大数据远程调试

文章目录前言Docker快速配置hive环境资料获取前言博主介绍:✌目前全网粉丝4W+,csdn博客专家、Java领域优质创作者,博客之星、阿里云平台优质作者、专注于Java后端技术领域。涵盖技术内容:Java后端、大数据、算法、分布式微服务、中间件、前端、运维等。博主所有博客文件目录索引:博客目录索引(持续更新)CSDN搜索:长路视频平台:b站-Coder长路Docker快速配置hive环境Ap

- 编程效率的飞跃、创新驱动的测试与行业应用的新篇章

###引言 在人工智能技术飞速发展的今天,AI工具、大模型及行业应用正在深刻改变着开发者的工作模式与各领域的发展格局。从智能编码助手到自动化测试平台,从大模型落地实践到垂直行业解决方案,AI正成为提升效率、驱动创新的核心引擎。本文将围绕“AI技术如何重塑你的工作与行业”这一主题,探讨AI工具、AI编程、AI测试以及AI行业应用和大模型落地等方面的影响。 ###一、AI工具重塑开发工作 #

- 中电金信 :十问高质量数据集:金融大模型价值重塑有“据”可循

2025年,随着大模型在金融领域的深度应用,高质量数据集已逐渐成为决定模型性能的“基石”。面对数据要素价值释放的关键机遇期,国家政策不断深入推进:2月,国务院国资委启动“AI+”专项行动,着力攻克数据难题;5月,数字中国峰会发布了首批30项央企AI高质量数据集成果;6月,在央国企金融领域人工智能高质量数据集工作推进会上,14家企业共同签署了“央国企金融数据产业共同体倡议书”,旨在推动人工智能与数据

- 毕业论文 | 人工智能侵权责任法律问题研究——以无人驾驶汽车为例

北斗猿

毕业论文设计人工智能无人驾驶法律侵权责任法民法典

===========================================github:https://github.com/MichaelBeechanCSDN:https://blog.csdn.net/u011344545===========================================人工智能侵权责任法律问题研究——以无人驾驶汽车为例目录摘要一、绪论(一)课

- 人工智能发展简史——未来是属于AI人工智能的。

AI天才研究院

ChatGPTAI人工智能与大数据人工智能

目录人工智能发展简史第一章:起步期-20世纪50年代及以前1.1计算机象棋博弈(Programmingacomputerforplayingchess)1.2图灵测试(TuringTest)1.3达特茅斯学院人工智能夏季研讨会(DartmouthSummerResearchConferenceonArtificialIntelligence)1.4感知机(Perceptrons)第二章:第一次浪潮

- 算法化资本——智能投顾技术重构金融生态的深度解析

田园Coder

人工智能科普人工智能科普

金融市场的数字化进程正经历着本质性跃迁。当传统交易大厅的开放式喊价被服务器集群的低频嗡鸣取代,当投资决策从人类直觉转向概率矩阵计算,一场由人工智能驱动的资本范式革命已悄然降临。智能投顾作为这场变革的核心载体,其技术架构不仅重塑财富管理的运作逻辑,更在认知层面挑战着金融市场的存在根基。理解这场变革的深度与广度,需要穿透技术表象,审视算法与资本结合引发的复杂生态嬗变。智能投顾系统的技术支柱建立于三重认

- 集训DAY7之线性dp与前缀优化/stl优化

心之所向凉月空

c++开发语言数据结构算法

集训DAY7之线性DP与前缀优化/STL优化目录DP的概念与思想核心DP的题目类型线性DP详解DP的优化策略后记DP的概念与思想核心DP的定义DP也就是动态规划(DynamicProgramming)是求解决策过程最优化的过程动态规划主要用于求解以时间划分阶段的动态过程的优化问题DP的基本思想动态规划算法通常用于求解具有某种最优性质的问题。在这类问题中我们常常需要在多个可行解中寻找最优解,其基本思

- 03 数据可视化的世界非常广阔,除了已提到的类型,还有许多更细分或前沿的可视化形式。

晨曦543210

信息可视化人工智能

十五、机器学习与数据科学专用图表特征重要性图(FeatureImportancePlot)用途:展示机器学习模型中各特征对预测结果的贡献度。示例:随机森林模型中影响房价预测的关键因素。混淆矩阵热力图(ConfusionMatrixHeatmap)用途:分类模型性能评估,显示预测结果与真实标签的对比。示例:疾病诊断模型的真阳性/假阳性分布。学习曲线(LearningCurve)用途:分析模型训练过程

- AI“大航海”时代:企业人力资源的AI-HR实践与效能提升策略

在数字化浪潮的推动下,人工智能(AI)正以前所未有的速度渗透各行各业,人力资源管理(HR)领域也不例外。AI技术的引入与应用落地,不仅提升HR管理效率,更在深层次上带来人力资源运作模式的变革。什么是AI-HR所谓AI-HR,是指将人工智能技术应用于人力资源管理,并通过机器学习、自然语言处理、数据挖掘等技术,优化招聘、培训、绩效评估、员工关系等人力资源各个业务模块。近年来,随着AI技术的成熟和普及,

- 【华为OD机试真题 2025B卷】2025华为OD机试 B卷目录,考点说明,持续收录中,已更新700+

哪 吒

搬砖工逆袭Java架构师华为od华为OD机试2025B卷pythonjavascript

专栏导读本专栏收录于《华为OD机试(JAVA)真题(B卷+A卷+C卷+D卷+E卷)》。刷的越多,抽中的概率越大,私信哪吒,备注华为OD,加入华为OD刷题交流群,每一题都有详细的答题思路、详细的代码注释、3个测试用例、为什么这道题采用XX算法、XX算法的适用场景,发现新题目,随时更新,全天CSDN在线答疑。2025年5月12日,华为官方已经将华为OD机试(A卷)切换为B卷。目前正在考的是B卷,按照华

- LeetCode[位运算] - #137 Single Number II

Cwind

javaAlgorithmLeetCode题解位运算

原题链接:#137 Single Number II

要求:

给定一个整型数组,其中除了一个元素之外,每个元素都出现三次。找出这个元素

注意:算法的时间复杂度应为O(n),最好不使用额外的内存空间

难度:中等

分析:

与#136类似,都是考察位运算。不过出现两次的可以使用异或运算的特性 n XOR n = 0, n XOR 0 = n,即某一

- 《JavaScript语言精粹》笔记

aijuans

JavaScript

0、JavaScript的简单数据类型包括数字、字符创、布尔值(true/false)、null和undefined值,其它值都是对象。

1、JavaScript只有一个数字类型,它在内部被表示为64位的浮点数。没有分离出整数,所以1和1.0的值相同。

2、NaN是一个数值,表示一个不能产生正常结果的运算结果。NaN不等于任何值,包括它本身。可以用函数isNaN(number)检测NaN,但是

- 你应该更新的Java知识之常用程序库

Kai_Ge

java

在很多人眼中,Java 已经是一门垂垂老矣的语言,但并不妨碍 Java 世界依然在前进。如果你曾离开 Java,云游于其它世界,或是每日只在遗留代码中挣扎,或许是时候抬起头,看看老 Java 中的新东西。

Guava

Guava[gwɑ:və],一句话,只要你做Java项目,就应该用Guava(Github)。

guava 是 Google 出品的一套 Java 核心库,在我看来,它甚至应该

- HttpClient

120153216

httpclient

/**

* 可以传对象的请求转发,对象已流形式放入HTTP中

*/

public static Object doPost(Map<String,Object> parmMap,String url)

{

Object object = null;

HttpClient hc = new HttpClient();

String fullURL

- Django model字段类型清单

2002wmj

django

Django 通过 models 实现数据库的创建、修改、删除等操作,本文为模型中一般常用的类型的清单,便于查询和使用: AutoField:一个自动递增的整型字段,添加记录时它会自动增长。你通常不需要直接使用这个字段;如果你不指定主键的话,系统会自动添加一个主键字段到你的model。(参阅自动主键字段) BooleanField:布尔字段,管理工具里会自动将其描述为checkbox。 Cha

- 在SQLSERVER中查找消耗CPU最多的SQL

357029540

SQL Server

返回消耗CPU数目最多的10条语句

SELECT TOP 10

total_worker_time/execution_count AS avg_cpu_cost, plan_handle,

execution_count,

(SELECT SUBSTRING(text, statement_start_of

- Myeclipse项目无法部署,Undefined exploded archive location

7454103

eclipseMyEclipse

做个备忘!

错误信息为:

Undefined exploded archive location

原因:

在工程转移过程中,导致工程的配置文件出错;

解决方法:

- GMT时间格式转换

adminjun

GMT时间转换

普通的时间转换问题我这里就不再罗嗦了,我想大家应该都会那种低级的转换问题吧,现在我向大家总结一下如何转换GMT时间格式,这种格式的转换方法网上还不是很多,所以有必要总结一下,也算给有需要的朋友一个小小的帮助啦。

1、可以使用

SimpleDateFormat SimpleDateFormat

EEE-三位星期

d-天

MMM-月

yyyy-四位年

- Oracle数据库新装连接串问题

aijuans

oracle数据库

割接新装了数据库,客户端登陆无问题,apache/cgi-bin程序有问题,sqlnet.log日志如下:

Fatal NI connect error 12170.

VERSION INFORMATION: TNS for Linux: Version 10.2.0.4.0 - Product

- 回顾java数组复制

ayaoxinchao

java数组

在写这篇文章之前,也看了一些别人写的,基本上都是大同小异。文章是对java数组复制基础知识的回顾,算是作为学习笔记,供以后自己翻阅。首先,简单想一下这个问题:为什么要复制数组?我的个人理解:在我们在利用一个数组时,在每一次使用,我们都希望它的值是初始值。这时我们就要对数组进行复制,以达到原始数组值的安全性。java数组复制大致分为3种方式:①for循环方式 ②clone方式 ③arrayCopy方

- java web会话监听并使用spring注入

bewithme

Java Web

在java web应用中,当你想在建立会话或移除会话时,让系统做某些事情,比如说,统计在线用户,每当有用户登录时,或退出时,那么可以用下面这个监听器来监听。

import java.util.ArrayList;

import java.ut

- NoSQL数据库之Redis数据库管理(Redis的常用命令及高级应用)

bijian1013

redis数据库NoSQL

一 .Redis常用命令

Redis提供了丰富的命令对数据库和各种数据库类型进行操作,这些命令可以在Linux终端使用。

a.键值相关命令

b.服务器相关命令

1.键值相关命令

&

- java枚举序列化问题

bingyingao

java枚举序列化

对象在网络中传输离不开序列化和反序列化。而如果序列化的对象中有枚举值就要特别注意一些发布兼容问题:

1.加一个枚举值

新机器代码读分布式缓存中老对象,没有问题,不会抛异常。

老机器代码读分布式缓存中新对像,反序列化会中断,所以在所有机器发布完成之前要避免出现新对象,或者提前让老机器拥有新增枚举的jar。

2.删一个枚举值

新机器代码读分布式缓存中老对象,反序列

- 【Spark七十八】Spark Kyro序列化

bit1129

spark

当使用SparkContext的saveAsObjectFile方法将对象序列化到文件,以及通过objectFile方法将对象从文件反序列出来的时候,Spark默认使用Java的序列化以及反序列化机制,通常情况下,这种序列化机制是很低效的,Spark支持使用Kyro作为对象的序列化和反序列化机制,序列化的速度比java更快,但是使用Kyro时要注意,Kyro目前还是有些bug。

Spark

- Hybridizing OO and Functional Design

bookjovi

erlanghaskell

推荐博文:

Tell Above, and Ask Below - Hybridizing OO and Functional Design

文章中把OO和FP讲的深入透彻,里面把smalltalk和haskell作为典型的两种编程范式代表语言,此点本人极为同意,smalltalk可以说是最能体现OO设计的面向对象语言,smalltalk的作者Alan kay也是OO的最早先驱,

- Java-Collections Framework学习与总结-HashMap

BrokenDreams

Collections

开发中常常会用到这样一种数据结构,根据一个关键字,找到所需的信息。这个过程有点像查字典,拿到一个key,去字典表中查找对应的value。Java1.0版本提供了这样的类java.util.Dictionary(抽象类),基本上支持字典表的操作。后来引入了Map接口,更好的描述的这种数据结构。

&nb

- 读《研磨设计模式》-代码笔记-职责链模式-Chain Of Responsibility

bylijinnan

java设计模式

声明: 本文只为方便我个人查阅和理解,详细的分析以及源代码请移步 原作者的博客http://chjavach.iteye.com/

/**

* 业务逻辑:项目经理只能处理500以下的费用申请,部门经理是1000,总经理不设限。简单起见,只同意“Tom”的申请

* bylijinnan

*/

abstract class Handler {

/*

- Android中启动外部程序

cherishLC

android

1、启动外部程序

引用自:

http://blog.csdn.net/linxcool/article/details/7692374

//方法一

Intent intent=new Intent();

//包名 包名+类名(全路径)

intent.setClassName("com.linxcool", "com.linxcool.PlaneActi

- summary_keep_rate

coollyj

SUM

BEGIN

/*DECLARE minDate varchar(20) ;

DECLARE maxDate varchar(20) ;*/

DECLARE stkDate varchar(20) ;

DECLARE done int default -1;

/* 游标中 注册服务器地址 */

DE

- hadoop hdfs 添加数据目录出错

daizj

hadoophdfs扩容

由于原来配置的hadoop data目录快要用满了,故准备修改配置文件增加数据目录,以便扩容,但由于疏忽,把core-site.xml, hdfs-site.xml配置文件dfs.datanode.data.dir 配置项增加了配置目录,但未创建实际目录,重启datanode服务时,报如下错误:

2014-11-18 08:51:39,128 WARN org.apache.hadoop.h

- grep 目录级联查找

dongwei_6688

grep

在Mac或者Linux下使用grep进行文件内容查找时,如果给定的目标搜索路径是当前目录,那么它默认只搜索当前目录下的文件,而不会搜索其下面子目录中的文件内容,如果想级联搜索下级目录,需要使用一个“-r”参数:

grep -n -r "GET" .

上面的命令将会找出当前目录“.”及当前目录中所有下级目录

- yii 修改模块使用的布局文件

dcj3sjt126com

yiilayouts

方法一:yii模块默认使用系统当前的主题布局文件,如果在主配置文件中配置了主题比如: 'theme'=>'mythm', 那么yii的模块就使用 protected/themes/mythm/views/layouts 下的布局文件; 如果未配置主题,那么 yii的模块就使用 protected/views/layouts 下的布局文件, 总之默认不是使用自身目录 pr

- 设计模式之单例模式

come_for_dream

设计模式单例模式懒汉式饿汉式双重检验锁失败无序写入

今天该来的面试还没来,这个店估计不会来电话了,安静下来写写博客也不错,没事翻了翻小易哥的博客甚至与大牛们之间的差距,基础知识不扎实建起来的楼再高也只能是危楼罢了,陈下心回归基础把以前学过的东西总结一下。

*********************************

- 8、数组

豆豆咖啡

二维数组数组一维数组

一、概念

数组是同一种类型数据的集合。其实数组就是一个容器。

二、好处

可以自动给数组中的元素从0开始编号,方便操作这些元素

三、格式

//一维数组

1,元素类型[] 变量名 = new 元素类型[元素的个数]

int[] arr =

- Decode Ways

hcx2013

decode

A message containing letters from A-Z is being encoded to numbers using the following mapping:

'A' -> 1

'B' -> 2

...

'Z' -> 26

Given an encoded message containing digits, det

- Spring4.1新特性——异步调度和事件机制的异常处理

jinnianshilongnian

spring 4.1

目录

Spring4.1新特性——综述

Spring4.1新特性——Spring核心部分及其他

Spring4.1新特性——Spring缓存框架增强

Spring4.1新特性——异步调用和事件机制的异常处理

Spring4.1新特性——数据库集成测试脚本初始化

Spring4.1新特性——Spring MVC增强

Spring4.1新特性——页面自动化测试框架Spring MVC T

- squid3(高命中率)缓存服务器配置

liyonghui160com

系统:centos 5.x

需要的软件:squid-3.0.STABLE25.tar.gz

1.下载squid

wget http://www.squid-cache.org/Versions/v3/3.0/squid-3.0.STABLE25.tar.gz

tar zxf squid-3.0.STABLE25.tar.gz &&

- 避免Java应用中NullPointerException的技巧和最佳实践

pda158

java

1) 从已知的String对象中调用equals()和equalsIgnoreCase()方法,而非未知对象。 总是从已知的非空String对象中调用equals()方法。因为equals()方法是对称的,调用a.equals(b)和调用b.equals(a)是完全相同的,这也是为什么程序员对于对象a和b这么不上心。如果调用者是空指针,这种调用可能导致一个空指针异常

Object unk

- 如何在Swift语言中创建http请求

shoothao

httpswift

概述:本文通过实例从同步和异步两种方式上回答了”如何在Swift语言中创建http请求“的问题。

如果你对Objective-C比较了解的话,对于如何创建http请求你一定驾轻就熟了,而新语言Swift与其相比只有语法上的区别。但是,对才接触到这个崭新平台的初学者来说,他们仍然想知道“如何在Swift语言中创建http请求?”。

在这里,我将作出一些建议来回答上述问题。常见的

- Spring事务的传播方式

uule

spring事务

传播方式:

新建事务

required

required_new - 挂起当前

非事务方式运行

supports

&nbs