佛像控制点质心提取(附代码)

本文主要包含一些矩阵运算的代码(矩阵转置、求逆、相乘),如果你只对矩阵运算这部分感兴趣的话请直接移步到下面Matrix_function.cpp和Matrix_function.h处,需要注意的是矩阵运算代码是与你的矩阵形式息息相关的,比如3*4的矩阵,有人用二维方式存储,有人用一维方式存储,我这儿用的是二维的。

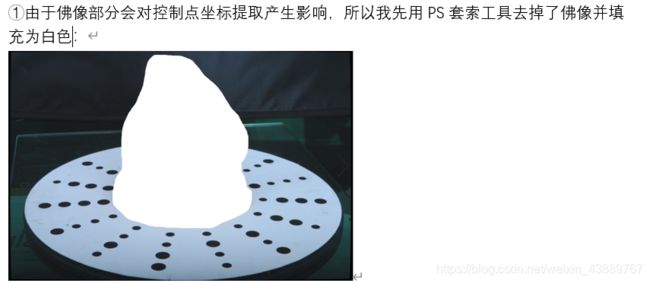

计算机视觉老师让写空间后方交会求解相机外部参数的代码。具体就是老师会给一张相片,相片上有黑色控制点,这些控制点带有编号,老师会给出控制点对应的世界坐标以及相机内方位元素。然后我们需要自己用PS或者用程序提取出该控制点的像素坐标,在这里我会给出用OpenCV代码提取自动提取控制点像素坐标的方法,但是事实上程序提取的像素坐标不是很准,因为是提取的质心,采用这个像素坐标解算出来的方位元素与老师提供的标准答案是一点点差距,所以事实上我本人是用PS工具(或者选择用VisualStudio 打开图片)刺探出来的,人工刺探的像素坐标很准,解算结果很不错。因为没有啥底子,所以用了摄影测量里空间后方交会的方法,但是本质都是一样的,无伤大雅。

1.数据:

(1)消除畸变的影像2张(整个过程不考虑畸变);

(2)控制点编号方式和控制点坐标;

(3)相机内部参数,相机外部参数的初始值。

实习内容:

(1)在影像上提取控制点并编号:

(2)分别计算每张影像的外部参数(后方交会);

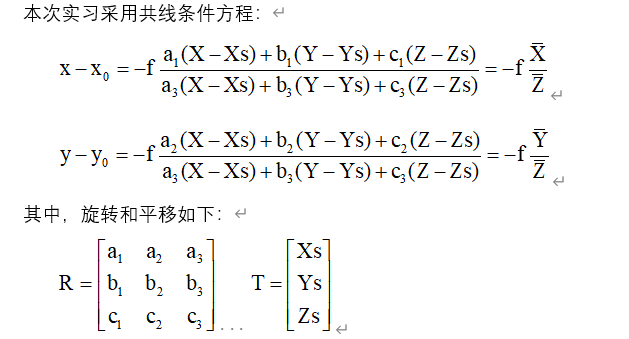

2.平差模型:

本次实习采用共线条件方程:

OpenCV提取质心的方法,是依据这篇文章改的,https://blog.csdn.net/yuyangyg/article/details/70888944

[](https://blog.csdn.net/yuyangyg/article/details/70888944)

,感谢大佬提供的参考!

我改之后的代码如下:

```cpp

#include

#include

#include

using namespace cv;

using namespace std;

int g_nMedianBlurValue = 2;

Mat element = getStructuringElement(MORPH_RECT, Size(3, 3));

vector point_seq;

Mat selectChannel(Mat src, int channel);

bool objectDetection(Mat src, int threshold_vlaue, int areasize, int channel)

{

int i;

Mat displayImage = src.clone();

Mat imageSC = selectChannel(src, channel);

medianBlur(imageSC, imageSC, g_nMedianBlurValue * 2 + 1);//中值滤波

threshold(imageSC, imageSC, threshold_vlaue, 255, CV_THRESH_BINARY);

if (1)

threshold(imageSC, imageSC, threshold_vlaue, 255, CV_THRESH_BINARY_INV); //cvNot(imageSC,imageSC);//把元素的每一位取反

dilate(imageSC, imageSC, element);//膨胀

Scalar color = Scalar(155, 155, 155);

vector> Contours;

vector Hierarchy;

findContours(imageSC, Contours, Hierarchy, CV_RETR_TREE, CV_CHAIN_APPROX_SIMPLE, Point(0, 0));

vector mu(Contours.size());

vector mc(Contours.size());

Mat drawing = Mat::zeros(src.size(), CV_8UC3);

for (int i = 0; i < Contours.size(); i++) {

mu[i] = moments(Contours[i], false);

}

for (int i = 0; i < Contours.size(); i++) {

mc[i] = Point2d(mu[i].m10 / mu[i].m00, mu[i].m01 / mu[i].m00);

}

for (int i = 0; i < Contours.size(); i++) {

double tmparea = fabs(contourArea(Contours[i]));

if (tmparea > areasize) {

drawContours(displayImage, Contours, i, color, 2, 8, Hierarchy, 0, Point());//you can change 1 to CV_FILLED

if (1) {

char tam[10000];

sprintf(tam, "(%0.0f,%0.0f)", mc[i].x, mc[i].y);

cout << "质心x " << mc[i].x << " 质心y " << mc[i].y << endl;

circle(src, mc[i], 100, cvScalar(255, 255, 255), 2); //画圆,第三个参数是半径,最后一个参数是线宽

putText(src, tam, Point(mc[i].x, mc[i].y), FONT_HERSHEY_COMPLEX, 1.3, Scalar(0, 0, 255), 2, 1); //画出重心的坐标,最后一个参数是线宽

}

}

}

namedWindow("控制点坐标", WINDOW_NORMAL);

imshow("控制点坐标", src);

waitKey(0);

return false;

}

Mat selectChannel(Mat src, int channel)

{///select image channel

Mat image, gray, hsv;

image = src.clone(); //not directly operate on source image

cvtColor(image, gray, CV_BGR2GRAY);

cvtColor(image, hsv, CV_BGR2HSV);

vector imageRGBORHSV;

Mat imageSC;

switch (channel)

{

case 1:

//cvSplit(image,imageSC,0,0,0);

split(image, imageRGBORHSV);

imageSC = imageRGBORHSV[0];

break;

case 2:

//cvSplit(image,0,imageSC,0,0);

split(image, imageRGBORHSV);

imageSC = imageRGBORHSV[1];

break;

case 3:

//cvSplit(image,0,0,imageSC,0);

split(image, imageRGBORHSV);

imageSC = imageRGBORHSV[2];

break;

case 4:

//cvSplit(hsv,imageSC,0,0,0);

split(hsv, imageRGBORHSV);

imageSC = imageRGBORHSV[0];

break;

case 5:

//cvSplit(hsv,0,imageSC,0,0);

split(hsv, imageRGBORHSV);

imageSC = imageRGBORHSV[1];

break;

case 6:

//cvSplit(hsv,0,0,imageSC,0);

split(hsv, imageRGBORHSV);

imageSC = imageRGBORHSV[2];

break;

default:

//cvCopy( gray, imageSC, 0 );

imageSC = gray;

}

return imageSC;

}

int main() {

//无畸变影像 - 左.bmp

Mat src = imread("去掉佛像.jpg", 1);

//Mat imageSC=selectChannel(src, 1);

objectDetection(src, 100, 100, 1);

}