Zookeeper(持续更新)

VIP-02 Zookeeper客户端使用与集群特性

文章目录

- VIP-02 Zookeeper客户端使用与集群特性

- 正文

- Zookeeper 集群模式:

- Zookeeper集群模式安装

- 配置动态文件

- Zookeeper分布式锁实战

- 公平锁:

正文

Zookeeper 集群模式:

Zookeeper 集群模式一共有三种类型的角色

Leader: 处理所有的事务请求(写请求),可以处理读请求,集群中只能有一个Leader

Follower:只能处理读请求,同时作为 Leader的候选节点,即如果Leader宕机,Follower节点

要参与到新的Leader选举中,有可能成为新的Leader节点。

Observer:只能处理读请求。不能参与选举

Zookeeper集群模式安装

本例搭建的是伪集群模式,即一台机器上启动四个zookeeper实例组成集群,真正的集群模式无

非就是实例IP地址不同,搭建方法没有区别

Step1:配置JAVA环境,检验环境:保证是jdk7 及以上即可

1 java ‐version

Step2:下载并解压zookeeper

1 wget https://mirror.bit.edu.cn/apache/zookeeper/zookeeper‐3.5.8/apache‐zookeep

er‐3.5.8‐bin.tar.gz

2 tar ‐zxvf apache‐zookeeper‐3.5.8‐bin.tar.gz

3 cd apache‐zookeeper‐3.5.8‐bin

Step3:重命名 zoo_sample.cfg文件

1 cp conf/zoo_sample.cfg conf/zoo‐1.cfg

Step4:修改配置文件zoo-1.cfg,原配置文件里有的,修改成下面的值,没有的则加上

1 # vim conf/zoo‐1.cfg

2 dataDir=/usr/local/data/zookeeper‐1

3 clientPort=2181

4 server.1=127.0.0.1:2001:3001:participant// participant 可以不用写,默认就是part

icipant

5 server.2=127.0.0.1:2002:3002:participant

6 server.3=127.0.0.1:2003:3003:participant

7 server.4=127.0.0.1:2004:3004:observer

配置说明

tickTime:用于配置Zookeeper中最小时间单位的长度,很多运行时的时间间隔都是

使用tickTime的倍数来表示的。

initLimit:该参数用于配置Leader服务器等待Follower启动,并完成数据同步的时

间。Follower服务器再启动过程中,会与Leader建立连接并完成数据的同步,从而确定自

己对外提供服务的起始状态。Leader服务器允许Follower再initLimit 时间内完成这个工

作。

syncLimit:Leader 与Follower心跳检测的最大延时时间

dataDir:顾名思义就是 Zookeeper 保存数据的目录,默认情况下,Zookeeper 将

写数据的日志文件也保存在这个目录里。

clientPort:这个端口就是客户端连接 Zookeeper 服务器的端口,Zookeeper 会监

听这个端口,接受客户端的访问请求。

server.A=B:C:D:E 其中 A 是一个数字,表示这个是第几号服务器;B 是这个服

务器的 ip 地址;C 表示的是这个服务器与集群中的 Leader 服务器交换信息的端口;D

表示的是万一集群中的 Leader 服务器挂了,需要一个端口来重新进行选举,选出一个新

的 Leader,而这个端口就是用来执行选举时服务器相互通信的端口。如果是伪集群的配

置方式,由于 B 都是一样,所以不同的 Zookeeper 实例通信端口号不能一样,所以要给

它们分配不同的端口号。如果需要通过添加不参与集群选举以及事务请求的过半机制的

Observer节点,可以在E的位置,添加observer标识。

Step4:再从zoo-1.cfg复制三个配置文件zoo-2.cfg,zoo-3.cfg和zoo-4.cfg,只需修改

dataDir和clientPort不同即可

1 cp conf/zoo1.cfg conf/zoo2.cfg

2 cp conf/zoo1.cfg conf/zoo3.cfg

3 cp conf/zoo1.cfg conf/zoo4.cfg

4

5 vim conf/zoo2.cfg

6 dataDir=/usr/local/data/zookeeper2

7 clientPort=2182

8 vim conf/zoo3.cfg

9 dataDir=/usr/local/data/zookeeper3

10 clientPort=2183

11 vim conf/zoo4.cfg

12 dataDir=/usr/local/data/zookeeper4

13 clientPort=2184

Step5:标识Server ID

创建四个文件夹/usr/local/data/zookeeper-1,/usr/local/data/zookeeper-

2,/usr/local/data/zookeeper-3,/usr/local/data/zookeeper-4,在每个目录中创建文件

myid 文件,写入当前实例的server id,即1,2,3,4

1 cd /usr/local/data/zookeeper‐1

2 vim myid

3 1

4 cd /usr/local/data/zookeeper‐2

5 vim myid

6 2

7 cd /usr/local/data/zookeeper‐3

8 vim myid

9 3

10 cd /usr/local/data/zookeeper‐4

11 vim myid

12 4

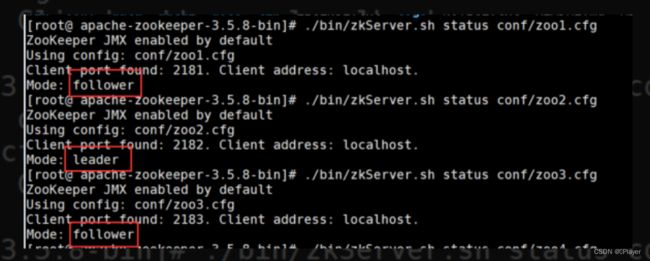

Step6:启动三个zookeeper实例

1 bin/zkServer.sh start conf/zoo1.cfg

2 bin/zkServer.sh start conf/zoo2.cfg

3 bin/zkServer.sh start conf/zoo3.cfg

4

Step7:检测集群状态,也可以直接用命令 zkServer.sh status conf/zoo1.cfg 进行每台服务

的状态查询

1 bin/zkCli.sh ‐server ip1:port1,ip2:port2,ip3:port3

可以通过 查看/zookeeper/config 节点数据来查看集群配置

Zookeeper 3.5.0 新特性: 集群动态配置

Zookeeper 3.5.0 以前,Zookeeper集群角色要发生改变的话,只能通过停掉所有的

Zookeeper服务,修改集群配置,重启服务来完成,这样集群服务将有一段不可用的状态,为了

应对高可用需求,Zookeeper 3.5.0 提供了支持动态扩容/缩容的 新特性。但是通过客户端API

可以变更服务端集群状态是件很危险的事情,所以在zookeeper 3.5.3 版本要用动态配置,需要

开启超级管理员身份验证模式 ACLs。如果是在一个安全的环境也可以通过配置 系统参数 -

Dzookeeper.skipACL=yes 来避免配置维护acl 权限配置。

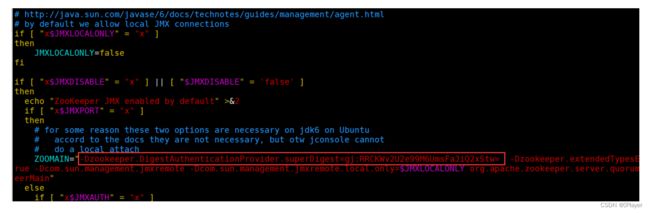

第一步,按照上节课的方式,先配置一个超级管理员(如果不配管理员,也可以设置系统参数 -

Dzookeeper.skipACL=yes):如:

在zookeeper启动脚本中添加 超级管理员授权模式:

1 echo ‐n gj:123 | openssl dgst ‐binary ‐sha1 | openssl base64

2 // RRCKWv2U2e99M6UmsFaJiQ2xStw=

3

4 ‐Dzookeeper.DigestAuthenticationProvider.superDigest=gj:RRCKWv2U2e99M6UmsFaJiQ

2xStw=

配置动态文件

修改配置 zoo1.cfg

注意这里去除了端口号,添加了

reconfigEnabled : 设置为true 开启动态配置

dynamicConfigFile : 指定动态配置文件的路径

创建文件 zoo_replicated1.cfg.dynamic

动态配置文件,加入集群信息

server.A=B.C.D.E;F

A: 服务的唯一标识

B: 服务对应的IP地址,

C: 集群通信端口

D: 集群选举端口

E: 角色, 默认是 participant,即参与过半机制的角色,选举,事务请求过半提交,还有一个是

observer, 观察者,不参与选举以及过半机制。

之后是一个分号,一定是分号,

F:服务IP:端口

1

2 server.1=192.168.109.200:2001:3001:participant;192.168.109.200:2181

3 server.2=192.168.109.200:2002:3002:participant;192.168.109.200:2182

4 server.3=192.168.109.200:2003:3003:participant;192.168.109.200:2183

5

6

依次配置其他服务 zoo2.cfg ,zoo3.cfg注意数据文件的路径

1 依次启动所有服务

2 如: ./bin/zkServer.sh start conf/zoo1.cfg

3 查看集群状态:

4 ./bin/zkServer.sh status conf/zoo1.cfg

连上任意一台服务器:

1

2 查看集群配置

3 config // 将会把动态配置打印出来

4 也可以直接查看目录

5 /zookeeper/config

6 该节点存储了集群信息

7

8 如果要修改集群状态,需要授权登录

9 addauth digest gj:123

10

11 reconfig ‐remove 3 // 移除serverId为 3 的机器

12 // 把对应的机器加进来

13 reconfig ‐add

server.3=192.168.109.200:2003:3003:participant;192.168.109.200:2183

14

15

如果要变更/或者添加新的服务需要将服务加到配置文件 zoo_replicated1.cfg.dynamic 中,启

动服务

然后通过reconfig 命令进行添加或者变更服务角色,但是需要保证服务列表中 participant 角色

能够形成集群(过半机制)。

客户端可以通过监听 /zookeeper/confg 节点,来感知集群的变化。从而实现集群的动态变更.

Zookeeper 类提供了对应的API 用来更新服务列表 : updateServerList

(完整的工程代码,在课程对应的资料包中)

1

2 Watcher watcher = new Watcher() {

3 @Override

4 public void process(WatchedEvent event) {

5 if (event.getType() == Event.EventType.None

6 && event.getState() == Event.KeeperState.SyncConnected){

7 countDownLatch.countDown();

8 log.info(" 连接建立");

9 // start to watch config

10 try {

11 log.info(" 开始监听:{}",ZooDefs.CONFIG_NODE);

12 zookeeper.getConfig(true,null);

13 } catch (KeeperException e) {

14 e.printStackTrace();

15 } catch (InterruptedException e) {

16 e.printStackTrace();

17 }

18 }else if( event.getPath()!=null && event.getPath().equals(ZooDefs.CONFIG_NOD

E)){

19 try {

20 byte[] config = zookeeper.getConfig(this, null);

21 String clientConfigStr = ConfigUtils.getClientConfigStr(new String(config));

22 log.info(" 配置发生变更: {}",clientConfigStr);

23 zookeeper.updateServerList(clientConfigStr.split(" ")[1]);

24 } catch (KeeperException e) {

25 e.printStackTrace();

26 } catch (InterruptedException e) {

27 e.printStackTrace();

28 } catch (IOException e) {

29 e.printStackTrace();

30 }

31

32 }

33 }

34 };

Curator 也自带了动态配置的监听,不需要额外的配置和代码实现监听更新;

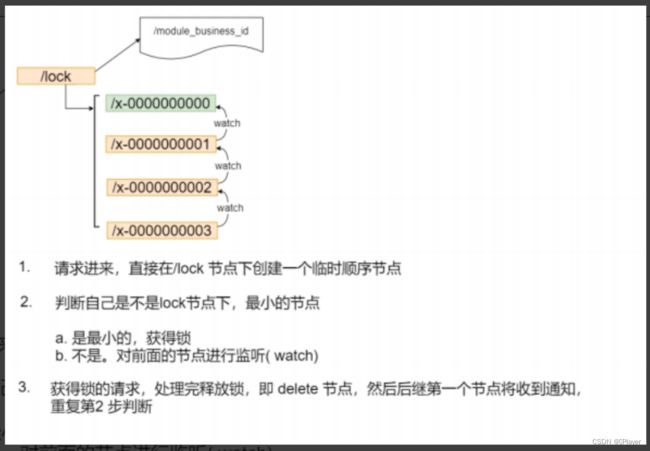

Zookeeper分布式锁实战

如上实现方式在并发问题比较严重的情况下,性能会下降的比较厉害,主要原因是,所有的连接

都在对同一个节点进行监听,当服务器检测到删除事件时,要通知所有的连接,所有的连接同时

收到事件,再次并发竞争,这就是羊群效应。如何避免呢,我们看下面这种方式。