Docker容器引擎(2)

目录

一.批量删除镜像,容器

二.Docker 网络实现原理

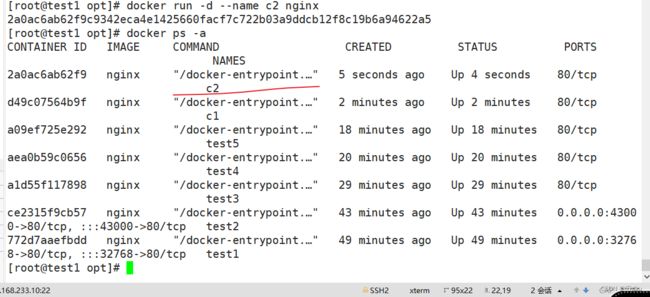

随机映射端口(从32768开始)

访问自己:

在10服务器上配置路由转发:

指定映射端口:

查看容器的输出和日志信息:

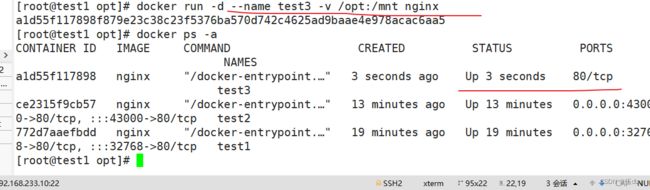

将宿主机目标|文件挂载到容器的数据卷:

先在宿主机上添加文件:

编辑

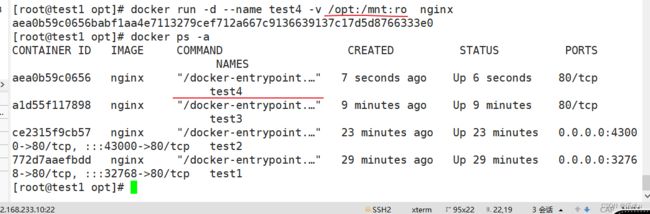

创建只能读的权限的容器:

创建共享数据卷容器的数据卷:编辑

可实现在容器内通过目标容器名或连接别名与目标容器通信:

三.docker网络模式

设置容器的网络模式:

创建网络模式:

查看c1容器进程号:

查看c3容器进程号:

四.资源控制

1.CPU 资源控制

进入id号中,查看容器进程能够使用的最大CPU时间 cpu.cfs_quota_us 文件:

查看单个CPU调度周期时间 cpu.cfs_period_us文件:

进行CPU压力测试:

设置50%的比例分配CPU使用时间上限:

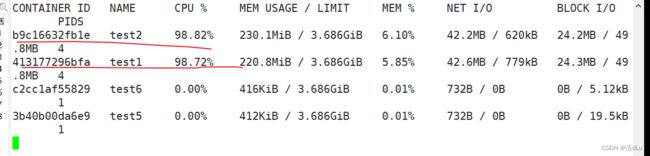

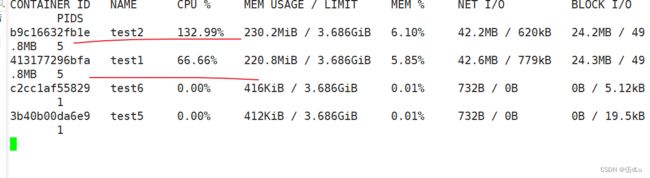

设置多个容器的CPU占用份额(只能在多个容器同时运行且CPU资源紧张时生效):

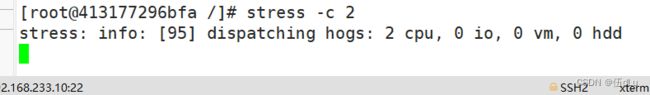

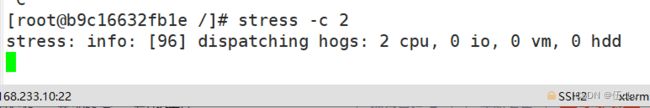

分别进入容器,进行压力测试

编辑编辑编辑

编辑

编辑

编辑

编辑

将t改为2:

编辑

编辑

设置容器绑定指定的CPU

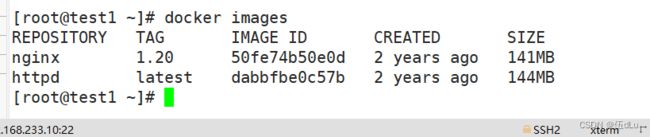

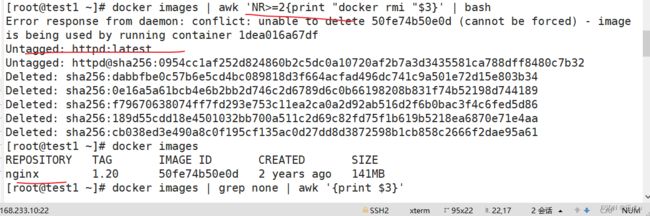

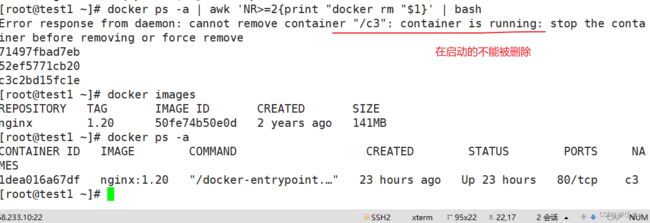

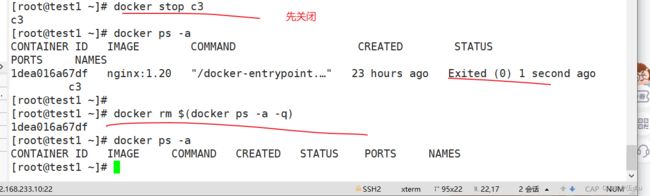

一.批量删除镜像,容器

格式:docker rm [-f] 容器ID/名称

docker images | awk 'NR>=2{print "docker rmi "$3}' | bash

docker ps -a | awk 'NR>=2{print "docker rm "$1}' | bash

docker rm $(docker ps -a -q) :批量清理后台停止的容器

二.Docker 网络实现原理

Docker使用Linux桥接,在宿主机虚拟一个Docker容器网桥(docker0),Docker启动一个容器时会根据Docker网桥的网段分配给容器一个IP地址,称为Container-IP,同时Docker网桥是每个容器的默认网关。因为在同一宿主机内的容器都接入同一个网桥,这样容器之间就能够通过容器的 Container-IP 直接通信。

Docker网桥是宿主机虚拟出来的,并不是真实存在的网络设备,外部网络是无法寻址到的,这也意味着外部网络无法直接通过 Container-IP 访问到容器。如果容器希望外部访问能够访问到,可以通过映射容器端口到宿主主机(端口映射),即 docker run 创建容器时候通过 -p 或 -P 参数来启用,访问容器的时候就通过[宿主机IP]:[容器端口]访问容器。

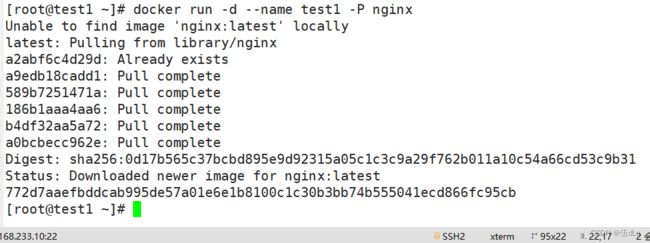

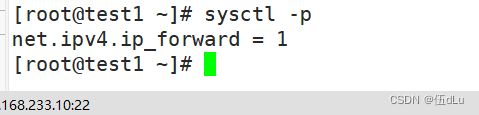

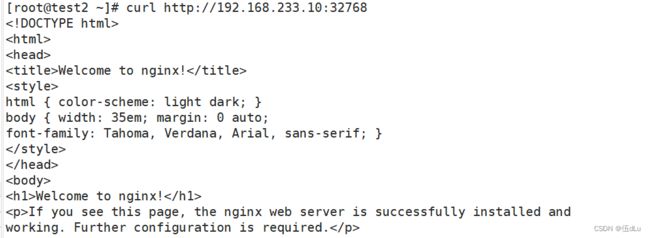

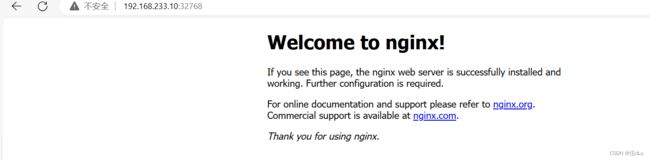

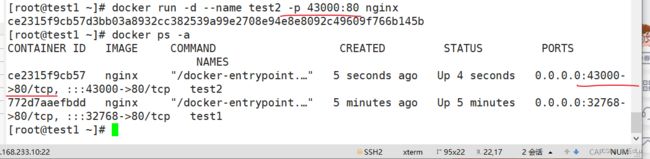

随机映射端口(从32768开始)

docker run -d --name test1 -P nginx

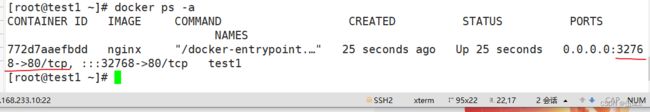

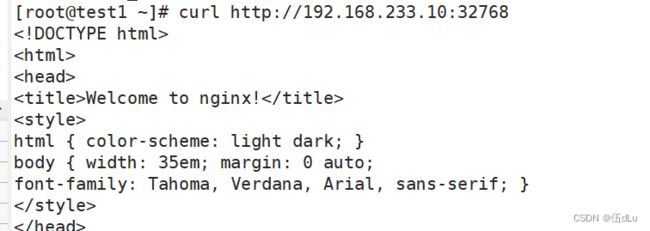

访问自己:

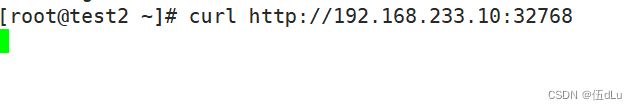

另一台服务器访问会卡顿,需要开启路由转发:

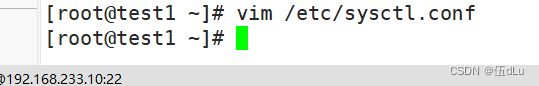

在10服务器上配置路由转发:

再次访问:

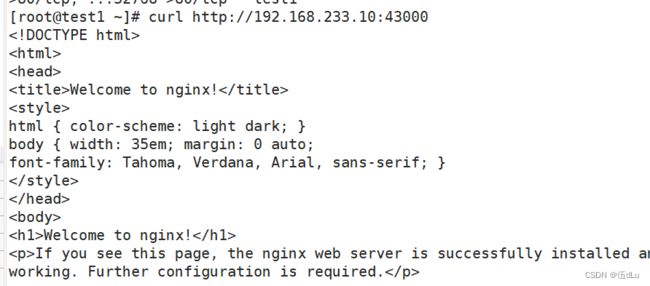

指定映射端口:

docker run -d --name test2 -p 43000:80 nginx

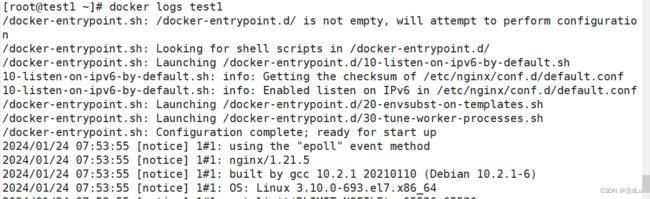

查看容器的输出和日志信息:

docker logs 容器的ID/名称

将宿主机目标|文件挂载到容器的数据卷:

docker run -d -v 宿主机绝对路径:容器绝对路径[:ro] : 将宿主机目标|文件挂载到容器的数据卷:[权限]

docker run -d --volumes-from 数据卷容器名 : 共享数据卷容器的数据卷

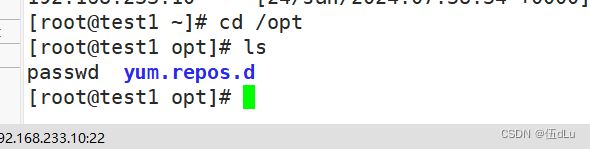

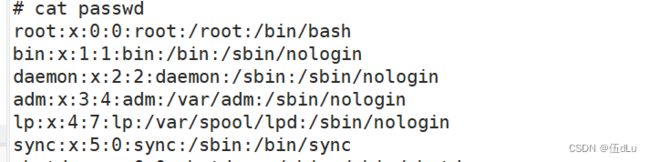

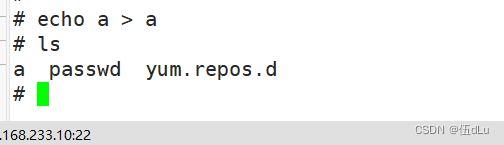

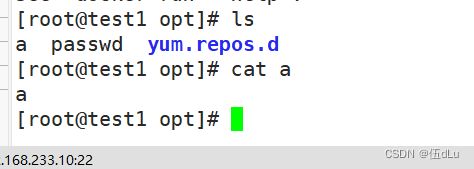

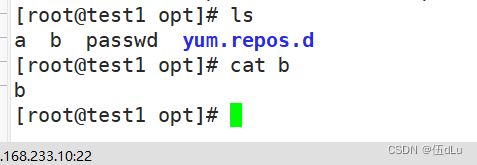

先在宿主机上添加文件:

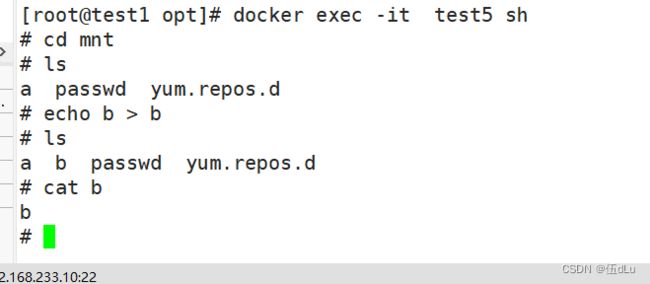

进入容器test3中看下:

可以给文件进行写入查看:

创建只能读的权限的容器:

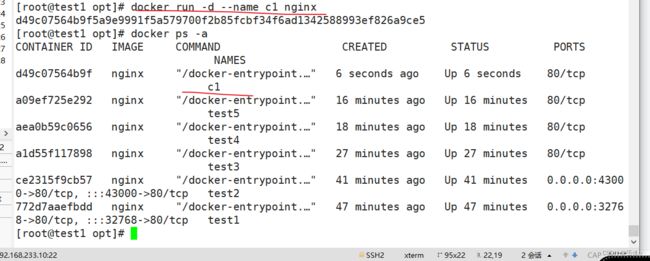

创建共享数据卷容器的数据卷:

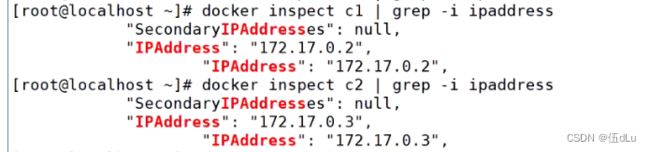

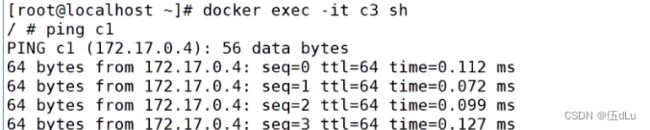

可实现在容器内通过目标容器名或连接别名与目标容器通信:

docker run -d --link 目标容器名:连接别名

docker inspect c1 |grep -i ipaddress

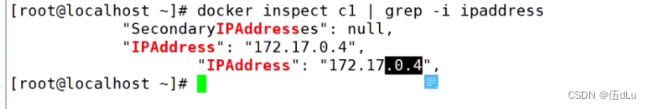

删除c1,在创建c1:

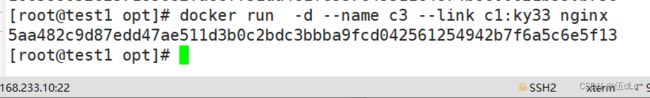

创建容器与目标容器通信:

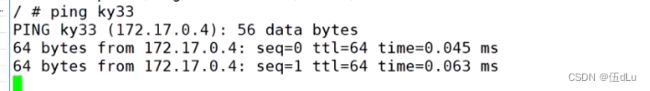

三.docker网络模式

bridge

docker的默认网络模式。使用此模式的每个容器都有独立的网络命名空间namespace,即每个容器都有独立的IP、端口范围(每个容器可以用同一个端口)、路由、iptables规则等网络资源。

docker run [--network=bridge] ....

host

容器与宿主机共享网络namespace,即容器和宿主机使用同一个IP、端口范围(容器与宿主机或其它使用host模式的容器不能用同一个端口)、路由、iptables规则等网络资源。

docker run --network=host ....

container

和指定已存在的容器共享网络namespace,即这两个容器使用同一个IP、端口范围(容器与指定的容器不能用同一个端口)、路由、iptables规则等网络资源。

docker run --network=container:容器名|容器ID ....

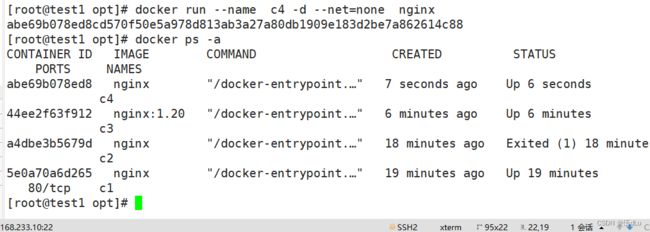

none

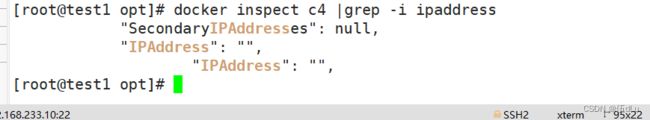

每个容器都有独立的网络namespace,但是容器没有自己的eth0网卡、IP、端口等,只有lo网卡。

docker run --network=none ....

自定义网络

可以用来自定义创建一个网段、网桥、网络模式,从而可以创建容器时自定义容器IP

docker network create --subnet 自定义网段 --opt "com.docker.network.bridge.name"="自定义网桥名" 自定义网络模式名

docker run --network 自定义网络模式名 --ip 自定义容器IP ....

设置容器的网络模式:

docker run -d --network bridge|host|none|container:容器名或ID

查看当前的网络模式:

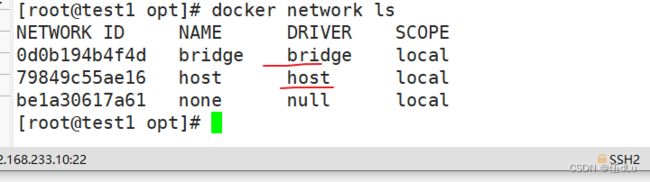

删除所有容器:

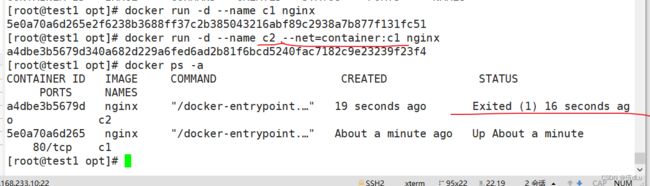

创建网络模式:

默认bridge模式,container模式:

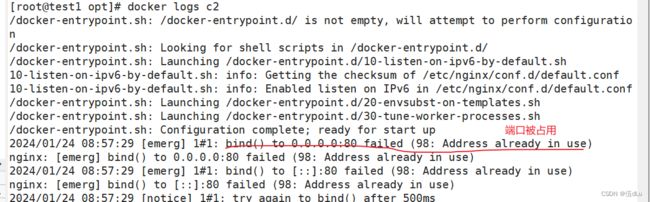

c2 与c1共享一个ip端口,c1的80端口开启了,c2就不行。

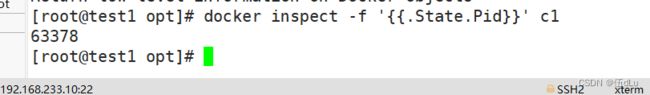

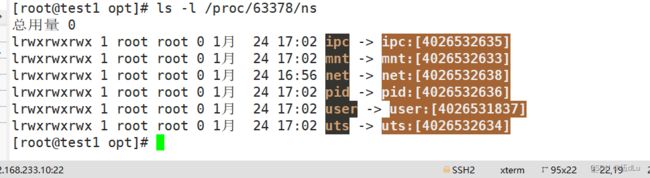

查看c1容器进程号:

docker inspect -f '{{.State.Pid}}' 容器名/id

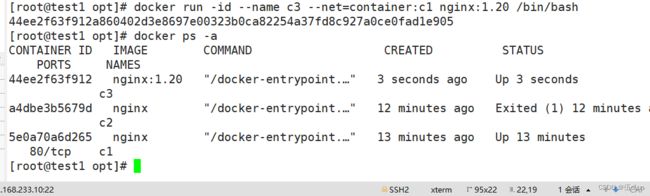

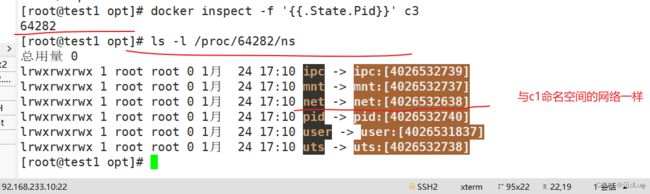

创建c3:

查看ip号:

查看容器的进程、网络、文件系统等命名空间编号:

查看c3容器进程号:

none模式:

四.资源控制

Docker 通过 Cgroup 来控制容器使用的资源配额,包括 CPU、内存、磁盘三大方面, 基本覆盖了常见的资源配额和使用量控制。

cgroup资源限制(限制容器进程对CPU 内存 磁盘IO 等资源的最大使用量)

1.CPU 资源控制

设置CPU使用率上限:

Linux通过CFS(Completely Fair Scheduler,完全公平调度器)来调度各个进程对CPU的使用。CFS默认的调度周期是100ms。

我们可以设置每个容器进程的调度周期,以及在这个周期内各个容器最多能使用多少 CPU 时间。

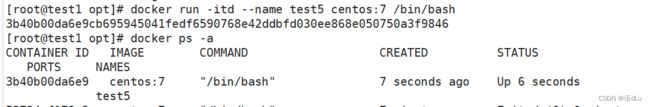

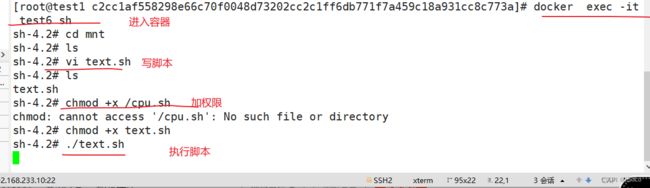

docker run -itd --name test5 centos:7 /bin/bash

cd /sys/fs/cgroup/cpu/docker:查看容器的id位置

进入id号中,查看容器进程能够使用的最大CPU时间 cpu.cfs_quota_us 文件:

表示该cgroups限制占用的时间(微秒),默认为-1,表示不限制。

如果设为50000,表示占用50000/100000=50%的CPU。

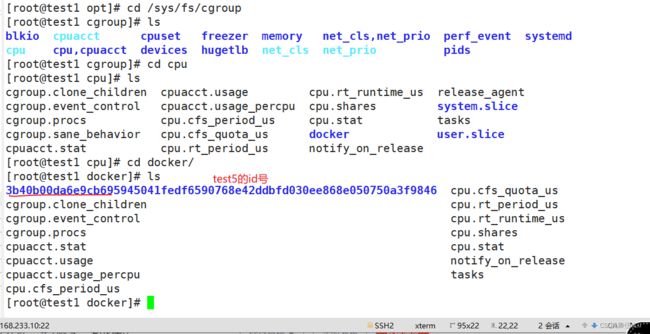

查看单个CPU调度周期时间 cpu.cfs_period_us文件:

cpu分配的周期(微秒,所以文件名中用 us 表示),默认为100000。

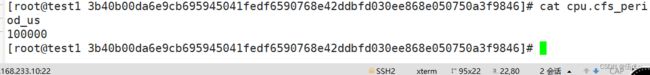

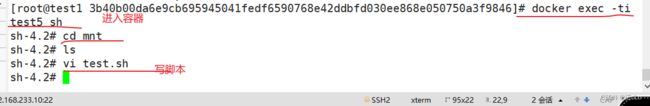

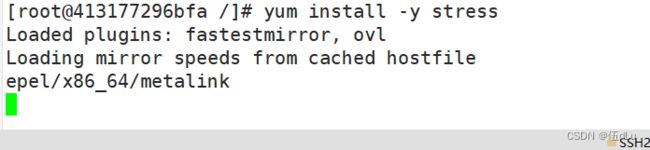

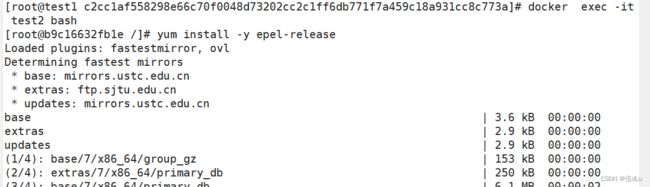

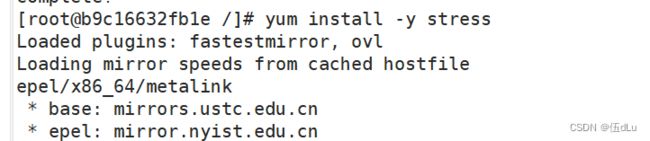

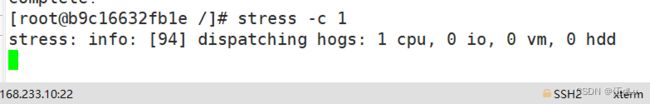

进行CPU压力测试:

docker exec -it 容器名/id /bin/bash :进入容器

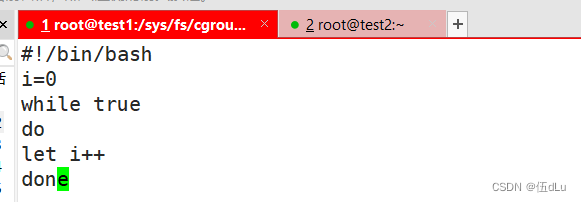

写个脚本:

#!/bin/bash

i=0

while true

do

let i++

done赋予权限:

![]()

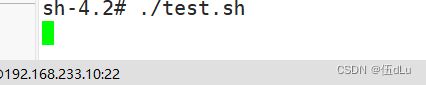

执行脚本:

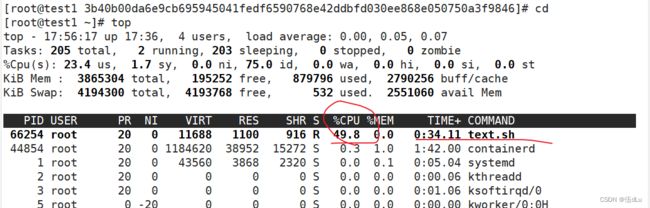

开个终端测试查看一下:

![]()

可以看到这个脚本占了很多的cpu资源。

设置50%的比例分配CPU使用时间上限:

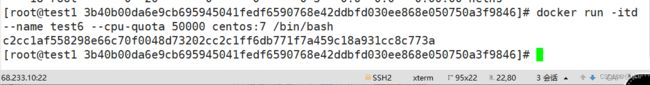

可以重新创建一个容器并设置限额:

docker run -itd --name test6 --cpu-quota 50000 centos:7 /bin/bash

查看下test6的限额:

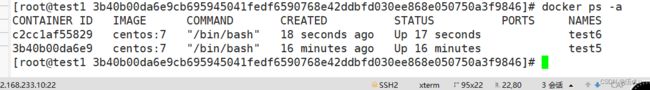

看下占用情况:

控制到50%左右。

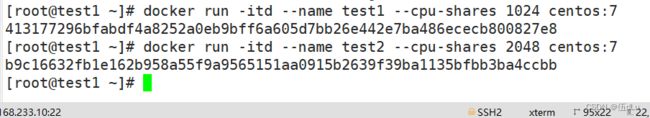

设置多个容器的CPU占用份额(只能在多个容器同时运行且CPU资源紧张时生效):

docker run -itd --name 容器名 --cpu-shares 容器进程最大占用CPU的份额(值为1024的倍数) 镜像

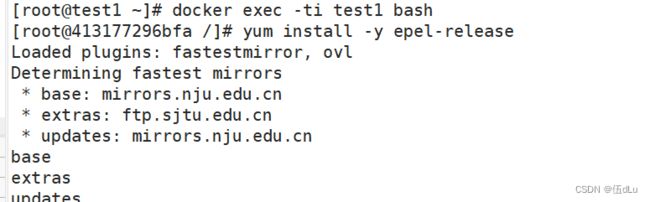

分别进入容器,进行压力测试

测试:

将t改为2:

可以看到在 CPU 进行时间片分配的时候,容器 c2 比容器 c1 多一倍的机会获得 CPU 的时间片。

设置容器绑定指定的CPU

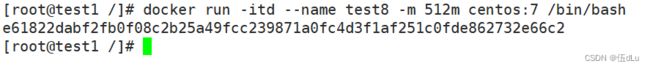

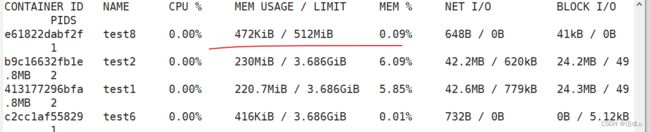

docker run -itd --name test8 -m 512m centos:7 /bin/bash

如果 --memory-swap 设置为 0 或者 不设置,则容器可以使用的 swap 大小为 -m 值的两倍。

如果 --memory-swap 的值和 -m 值相同,则容器不能使用 swap。

如果 --memory-swap 值为 -1,它表示容器程序使用的内存受限,而可以使用的 swap 空间使用不受限制(宿主机有多少 swap 容器就可以使用多少)。