AI+数据库——梳理Snowflake 和 Databricks 在峰会上的重要发布,快来看市值数百亿美金的数据巨头的贴身肉搏!

目录

01 背景

02 买、买、买

03 肉搏

Snowflake:要做AI-Powered数据驱动平台

Databricks:到处都是AI以及统一的数据管理

04 写在结尾

One more thing

01 背景

Snowflake 和 Databricks 两者都在云环境中提供数据的存储、处理和治理。他们原本定位略有不同,Databricks 是一个用于数据工程、数据科学和分析的集成环境,它构建在 Apache Spark 之上,提供实时摄取、处理和分析数据的工具。Snowflake 是一个基于云的数据仓库平台,允许用户使用 SQL 存储、处理和分析数据。Snowflake 将存储与计算分开,允许用户根据需要扩展或缩小规模,而无需管理基础设施。虽然 Databricks 原本是数据湖,但是它近年来走得也都是“湖仓一体”的路线,这导致两家公司产品的应用的场景高度重合,公关战争(打嘴仗)不断,卷到飞起。

上周,两家公司非常巧妙地都举行了峰会,并且产品的方向上都走向了在其平台存储的数据之上构建生成式AI和其他智能应用程序。无论是AI for database 还是 Database for AI,AI 的发展都让数据领域的从业者感到欣喜,也能够给数据领域带来巨大的创新和变化。于是,小猿姐“半程”(实在太多,全程看不完)观看了两个企业峰会的重点 Keynote,数据和AI应用擦出的火花,实在很精彩,忍不住分享给大家。

02 买、买、买

今年,AI大模型爆火,加上 Snowflake 和 Databricks 前期的公关大战,给这两家的峰会带来了极大的热度。

Databricks 早在4月中旬开始就动作频频,发布了自研大模型 Dolly,一步一步地把 Databricks 的用户心智往 AI 上面靠,并收购了数据治理工具 Okera。在会前,Databricks 发布新闻,宣布用 13 亿美元收购了 MosaicML,该公司专注于培训和部署大模型的工具。这 13 亿对于一个尚未上市的Databricks来说并不是一笔小的费用。而这两笔收购之前,Databricks 还完成了对营销分析供应商 DataJoy、ML 模型服务的 Cortex Labs、低代码/无代码供应商 8080 Labs,以及数据可视化和 SQL 查询工具 Redash 的收购。

而 Snowflake 上个月宣布收购 Neeva,给自己的平台增加了搜索工具,并以此网罗一波高端人工智能工程人才。去年,Snowflake 还收购了 Streamlit,Streamlit 可在几分钟内将数据脚本转变为可共享的Web应用,此项收购使得 Snowflake 可以根据平台中存储的数据构建应用程序。Snowflake在2022年9月收购了总部位于华沙的Applica。

为了向 AI 升级,两家公司都在用“钞能力”不断给自己加装备,增强自己的竞争力。

03 肉搏

除了“挥金如土”的收购,两家公司还通过合作和产品开发,努力向人工智能迈进。

Snowflake:要做AI-Powered数据驱动平台

Snowflake 请来了黄仁勋作为其重磅嘉宾宣布与 GPU 巨头 Nvidia 建立合作伙伴关系,今后可以提供 Nvidia GPU 基础设施和该公司的 NeMo 框架,Snowflake 选择不依赖外部大模型 ,而是基于 NeMo 本身提供基础模型,让客户使用自己的 Snowflake 数据进行补充训练,这些动作都是在客户自己的 Snowflake 帐户内部环境和安全边界中进行的,“让用户能够训练属于自己的大模型”。

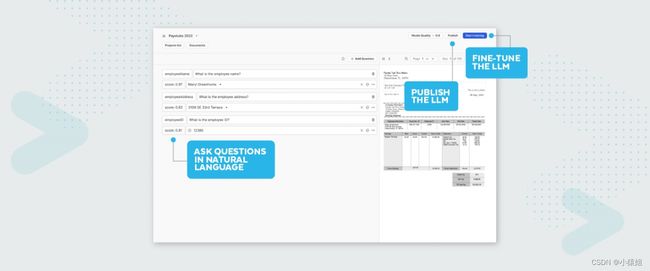

Snowflake 推出了 Document AI ,可以帮助用户使用自然语言查询存储在文档中的非结构化数据。Document AI 的搜索功能由大模型提供支持,但客户可以使用自己的数据对其进行微调(fine-tune)。由于有了Applica,因此在文档方面并不依赖OpenAI或其他大型模型提供商。

"Snowflake产品高级副总裁 Christian Kleinerman 说:"(有了Document AI)我们正在为客户开启一个新的数据时代,利用人工智能和消除以前受格式、地点等约束的孤岛,彻底改变企业利用自有数据的方式,并通过数据云推动洞察力。

Snowflake 还做了一系列对开发者非常友好的发布,宣布在 AWS 上推出原生应用程序框架的开放预览版。其思路是帮助开发人员构建和测试 Snowflake Native Apps,借此运用 Snowflake 中的现有数据,开发者可以通过这个平台将自己的作品发布和变现。目前,Snowflake 已经与合作伙伴合作构建了 20 多个原生应用程序,并且已经在 Marketplace 推出。

Snowflake 有数据治理功能,加上 NeMo 来帮助客户根据自己的信息构建自己的模型,还有 Streamlit 来使最终产品变得可用。收购的Neeva 则提供了基于 AI 的搜索数据的能力。这一系列的产品战略使其能够像自己本次会议主题宣传的那样,“让用户通过大模型利用好自己最有价值的数据”。

除了 Native App 之外,Snowpark也发布了新的feature,其公开版本支持用 Scala 和 Java 还有 Python进行代码编写。但是为了满足客户使用不同的语言开发的需求,Snowflake 宣布推出私有预览版 Snowpark 容器服务,这是一个基于 K8s 的平台,允许用户使用几乎任何语言开发代码。Snowpark 容器服务还允许使用开源和合作伙伴提供的大模型(合作伙伴可以在 Snowflake Native Apps 中提供大模型服务)。通过集成 Snowflake 的一方大模型产品、Snowpark 容器服务和 Snowpark 外部服务(一种允许 Snowflake 环境中的代码调用外部 API 端点的功能),Snowflake 会逐步将自己包装成为一流的生成式 AI 平台。

此外,数据格式上面的卷也并未停止,在去年的峰会上,Snowflake 宣布很快将支持使用 Apache Iceberg 标准存储的数据库表。本次峰会也宣布了 Snowflake 对 Iceberg 表模型进行的改进,将某些表保留为 Iceberg 格式,允许 Snowflake 与 Iceberg 甚至仅与 Parquet 兼容的其他数据引擎共享数据。此版本宣称将打破数据孤岛,只是并不支持 Hudi 和 Delta 格式。

总体而言,Snowflake 最近的所有的动作显示了其建立一个 AI-Powered 以数据为中心的完整的云应用程序平台的热切愿望。

Databricks:到处都是AI以及统一的数据管理

Databricks不遑多让, 在峰会上发布了“LakehouseIQ”品牌,这是一个由大模型支持的自然语言搜索界面,可用于搜索和查询数据。尽管许多大数据供应商最近也添加了类似功能,但 Databricks 坚称 LakehouseIQ 解除了一般大模型在理解特定客户数据、内部术语和使用模式方面的限制。LakehouseIQ 集成了 Unity Catalog,它的自然语言搜索和查询会遵循目录中的访问控制,仅反馈提问者有权查看的那部分数据。对于开发人员,可以在Notebook中可以安装 LakehouseIQ,帮助开发人员完成代码补全、代码生成和注释,以及代码修复、调试和报告的生成。

此外,LakehouseAI 的发布是对 Databricks 的机器学习能力的一次品牌的重新定位。除了此前发布的 Dolly 之外,LakehouseAI 还选择了三款开源大模型,MPT-7B、Falcon-7B 和 Stable Diffusion。Lakehouse AI 还包括了许多“LLMOps”的能力。如,AI Gateway 可以管理 SaaS 大模型服务和模型 API 的凭证(credentials);为大模型提供访问控制的路由、预测缓存和服务使用速率限制;Prompt 工具,一个无代码界面,可以根据一组 prompt 来比较各种模型的输出,并在 Unity Catalog 中自动跟踪这些比较的结果;还有针对 Databricks Model Serving 的大模型优化,包括延迟时间缩短 10 倍的大模型推理等……

LakehouseAI的矢量搜索组件和Databricks Model Serving可以通过自动更新统一目录中的搜索索引,并实时访问预先计算的特征来为模型提供数据,从而释放组织内非结构化数据的价值。

在 Delta Lake 3.0 中,Databricks 推出了通用格式(UniForm),允许以 Apache Iceberg 或 Apache Hudi 的格式读取存储在 Delta 中的数据。(是不是看上去比Snowflake更开放)

Databricks 还推出了 Lakehouse Federation,支持的外部数据源包括——Snowflake、MySQL、PostgreSQL、Amazon Redshift、微软的 Azure SQL 和 Azure Synapse 以及 Google BigQuery 等等。“Lakehouse Federation 能够扩展我们的平台,帮助客户轻松管理和查询其他系统中的数据,”Databricks 联合创始人兼首席技术专家 Matei Zaharia 表示。他解释说,这项新功能的核心功能之一是联邦查询,它允许用户连接不同的数据源并高效地查询它们,同时本质上可以将其视为 Databricks 内部的标准数据库。

Snowflake和Databricks都承认他们无法直接管理所有数据,因而必须提供一个桥梁,这样才能真正的打破孤岛,进行全面分析和人工智能。总之就是你有啥,我也有,咱俩就是个卷。

当然两家峰会上,还有非常多大大小小的技术发布,这篇文章中小猿姐就暂不包含了。

04 写在结尾

AI掀起的热浪也席卷了其他厂商,Lakehouse 供应商 Dremio 已经在其产品中添加了 Text-to-SQL、自治语义层和 Vector Lakehouse 功能。SingleStore 也已演示 ChatGPT 对其存储的数据进行处理。这些厂商也面临着巨大压力,如果不能跟上他们的脚步,就有可能被迅速地抛在后面。人工智能无疑能在数据领域带来巨大的创新和变化,不过,当下的数据平台,整体做的事还仅仅是“和AI一起工作”(work with AI),但是 AI 和数据之间只有这些关系吗?大模型对于数据只是一个新的 HCI 还是它真的能把数据变成金山银山。有了人工智能的辅助,我们可以相信在可以预见的未来,无论对数据的管理,对数据价值的挖掘,还是通过挖掘数据价值而产生的应用,都会插上 AI 的翅膀,数据的世界也必然变得更加智能。也期待竞争带来创新和共同进步,也给业界带来更多的创新灵感。

One more thing

号外号外!

KubeBlocks 已经支持多款面向大模型的向量数据库,并且正在探索开源大模型的私有化部署以及大模型辅助的数据集成。欢迎大家到GitHub体验和试用产品,提交issue。

试用:https://kubeblocks.io/docs/release-0.5/user_docs/quick-start/try-kubeblocks-on-your-laptop

官网:www.kubeblocks.io

GitHub: https://github.com/apecloud/kubeblocks

参考资料:

https://techcrunch.com/2023/06/28/databricks-builds-a-data-mesh-with-the-launch-of-lakehouse-federation/

https://www.montecarlodata.com/blog-databricks-data-ai-summit-2023-keynote-recap/#delta-lake-3-0-and-uniform

https://siliconangle.com/2023/06/30/revolutionizing-data-management-ai-open-source-power-analysis-data-ai-summit-databrickssummit/

https://www.montecarlodata.com/blog-snowflake-summit-2023-keynote-recap-document-ai-container-services/

https://edition.cnn.com/videos/business/2023/06/28/exp-databricks-ai-ceo-intv-fst-062809aseg2-cnni-business.cnn

https://www.databricks.com/blog/2023/04/12/dolly-first-open-commercially-viable-instruction-tuned-llm

https://www.montecarlodata.com/blog-snowflake-summit-2023-keynote-recap-document-ai-container-services/#document-ai

YouTube双方峰会频道