大模型日报-20240202

文章目录

-

- 企业如何使用开源LLM:16个案例

- 多模态LLM多到看不过来?先看这26个SOTA模型吧

- 伯克利开源高质量大型机器人操控基准,面对复杂自主操控任务不再犯难

- 市值登顶全球!微软上财季营收创历史新高,AI需求驱动云业务增收

- Elvis为Code Llama编写提示指南,介绍了如何有效地使用Code Llama 70B Instruct,为开发者和实践者提供了大量示例

- 由Apple Neural Engine驱动的Whisper!

- Clem:在HuggingFace Datasets上公开超过100,000个数据集供任何人使用

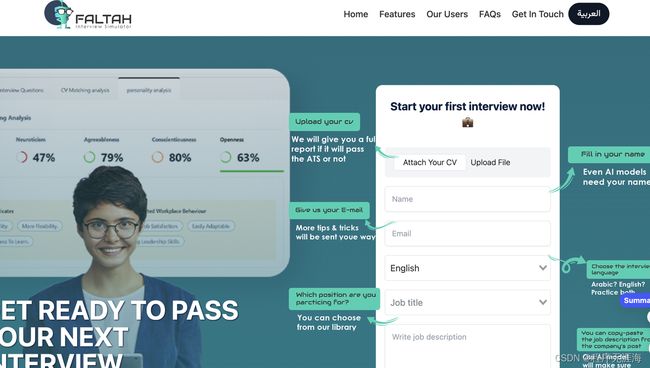

- Faltah

- OpenCiv1

- 机器人仿真技术浅淡和Nvidia Omniverse Isaac Sim介绍

- 大白话解说Continous Batching

企业如何使用开源LLM:16个案例

https://x.com/ylecun/status/1752437014840930553?s=20

企业如何使用开源LLM:16个案例。

许多企业使用Llama-2:Brave、富国银行、IBM、格莱美奖、Perplexity、Shopify、LyRise、Niantic…

“很多客户都在问自己:等等,我为什么要为一个对我的业务知之甚少的超大模型付费?我难道不能使用这些开源模型之一吗?顺便说一下,也许对于(信息检索)工作流,我可以使用一个更小的开源模型?”

多模态LLM多到看不过来?先看这26个SOTA模型吧

https://mp.weixin.qq.com/s/Bvp0gBOkxHGH-XXNdrvOqg

当前 AI 领域的关注重心正从大型语言模型(LLM)向多模态转移,于是乎,让 LLM 具备多模态能力的多模态大型语言模型(MM-LLM)就成了一个备受关注的研究主题。近日,腾讯 AI Lab、京都大学和穆罕默德・本・扎耶德人工智能大学的一个研究团队发布了一份综述报告,全面梳理了 MM-LLM 的近期进展。文中不仅总结了 MM-LLM 的模型架构和训练流程,而且还梳理了 26 个当前最佳的 MM-LLM。如果你正考虑研究或使用 MM-LLM,不妨考虑从这份报告开始研究,找到最符合你需求的模型。

伯克利开源高质量大型机器人操控基准,面对复杂自主操控任务不再犯难

https://mp.weixin.qq.com/s/jF2CmIlt3afb99KpmbjhkQ

机器人操控面临两个主要挑战:机器人如何智能地处理复杂的接触动力学以及如何应对环境和物体的多样性。针对这些挑战,机器人学习技术被视为关键的解决手段。因此,该领域需要一个全面易得的框架,提供有挑战性的实际任务、高质量数据、易于复制的设置,集合了基线结果的相关方法,基于该框架,研究人员能够对所提出任务的实验发现进行深入分析。加州大学伯克利分校智能机器人实验室(RAIL)的研究团队提出了如上所述的现实世界基准,称为 FMB(Functional Manipulation Benchmark for Generalizable Robotic Learning)。

市值登顶全球!微软上财季营收创历史新高,AI需求驱动云业务增收

https://www.thepaper.cn/newsDetail_forward_26207327

市场对云计算和AI(人工智能)热情不减,推动全球市值最高的微软在2023年最后三个月取得创纪录的季度营收。科技巨头微软公布截至2023年12月31日的2024财年第二财季业绩,第二财季营收620.20亿美元,高于市场预期的610亿美元并创下微软的季度营收最高纪录,同比增长18%,按固定汇率计算增长16%;净利润同比增长33%(按固定汇率计算增长30%)至218.70亿美元,高于市场预期的206亿美元;摊薄后每股收益同比增长33%(按固定汇率计算增长30%)至2.93美元,高于市场预期的2.77美元。

Elvis为Code Llama编写提示指南,介绍了如何有效地使用Code Llama 70B Instruct,为开发者和实践者提供了大量示例

https://x.com/omarsar0/status/1752337360098865232?s=20

Elvis:为Code Llama编写提示指南

我很兴奋地发布了我最新的提示指南,介绍了如何有效地使用Code Llama 70B Instruct,为开发者和实践者提供了大量示例。

Code Llama 70B Instruct是目前最强大的开源代码生成模型之一。

昨天发布后,我觉得我们需要为它开发一个合适的指南,以了解它如何用于各种有趣的代码生成任务,如调试和文本到SQL生成。

该指南包括以下内容:

• 配置模型访问

• 基础代码完成

• 调试

• 单元测试

• 文本到SQL生成

• 使用Code Llama的小样本提示

• 函数调用

• 安全防护

• 笔记本

• 参考文献

更多示例即将推出!

由Apple Neural Engine驱动的Whisper,在iOS和Mac上以惊人的速度运行

https://x.com/reach_vb/status/1752434666659889575?s=20

由Apple Neural Engine驱动的Whisper!

@argmaxinc的团队优化了Whisper,在iOS和Mac上以惊人的速度运行!

所有代码均采用MIT许可。

比竞争对手快达3倍。

使用神经引擎以及Metal运行器。

开源CoreML模型。

只需2行代码

Whisper & Whisper-Turbo(更快的变体)

(看看它在展示他们的Mac样品应用程序的视频中是如何美妙地利用ANE的!)

https://github.com/argmaxinc/WhisperKit

Clem:在HuggingFace Datasets上公开超过100,000个数据集供任何人使用

https://x.com/ClementDelangue/status/1752379522110943727?s=20

HuggingFace Clem:

刚刚在http://hf.co/datasets上公开超过100,000个数据集供任何人使用!真正酷的是看到现在的多样性,从文本、图像、视频、生物学、化学、时间序列、指令数据集等等,覆盖数百种语言!祝贺Huggingface Quentin Lhoest团队,并感谢社区为这项非常有影响力的工作(在我看来,现在分享数据集比分享模型更有影响力)。告诉我你接下来会分享哪个数据集,我会确保放大宣传!

Faltah

https://faltah.ai/

Faltah 是一个个人 AI 面试辅导官,帮助用户准备面试、完善简历并增强信心。它提供面试排练和详细反馈,帮助用户提高面试表现。此外,Faltah 还能分析简历,以提高其被招聘人员注意到的有效性,并通过 ATS(申请追踪系统)。该产品支持多种语言,适用于技术专业人士和应届毕业生。

OpenCiv1

https://github.com/rajko-horvat/OpenCiv1

OpenCiv1 是 Sid Meier 和 Bruce Shelley 于 1991 年设计的 Civilization 1 游戏的开源重写。基于文本的策略游戏,类似于经典的文明系列游戏。它是由志愿者开发者共同努力创建的,希望可以提供一个免费且开放的游戏平台,让玩家可以自由地定制和修改游戏内容。OpenCiv1 的目标是为玩家提供一种全新的文明建设体验,同时保持开放性和灵活性。游戏代码的一部分使用虚拟 CPU 进行模拟,其余代码已从头开始重写,直到所有代码都替换为新的无版权代码。在发布完整游戏之前,其他资源(如图形、音乐和文本)也将完全替换为无版权资源。

机器人仿真技术浅淡和Nvidia Omniverse Isaac Sim介绍

https://zhuanlan.zhihu.com/p/545418917?utm_medium=social&utm_oi=56635854684160&utm_psn=1735121841205661696&utm_source=wechat_timeline

这篇文章介绍了机器人仿真技术和Nvidia Omniverse Isaac Sim。作者参与了Isaac Sim的开发,该仿真工具能够模拟机器人的动力学物理定律和传感器,提供真实的物理仿真和高效的图像渲染。Isaac Sim还与ROS生态系统进行了整合,支持与ROS的自由通信。该工具在四足机器人仿真方面具有广泛的应用,可以进行基本运动控制、传感器数据发布到ROS、神经网络控制器的训练以及基于视觉的定位等。Isaac Sim还提供了便利的调试方式和Isaac Gym插件,支持并行强化学习训练。总的来说,Isaac Sim是一款功能强大的机器人仿真器,可以加速机器人程序的开发和验证过程,提高开发效率和用户体验。

大白话解说Continous Batching

https://zhuanlan.zhihu.com/p/680123256?utm_medium=social&utm_oi=56635854684160&utm_psn=1735273118556520448&utm_source=wechat_timeline

文章讲述了Continous Batching技术,该技术通过Iteration-level Scheduling算法,对早完成和晚加入的请求进行调度,优化了大型语言模型(LLM)的推理性能。Continous Batching可有效增减样本批量,动态管理显存使用,显著提升系统吞吐率,减少无效计算资源浪费。该技术在提高分布式Transformer生成模型的服务效率方面发挥了重要作用,多个LLM推理框架已采用这一策略。