Data Augmentation and Deep Learning Methods in SoundClassification: A Systematic Review

文章为翻译,仅供学习参考

论文原地址:Data Augmentation and Deep Learning Methods in Sound Classification: A Systematic Review

作者:Olusola O. Abayomi-Alli , Robertas Damaševiˇcius , Atika Qazi, Mariam Adedoyin-Oloweand Sanjay Misra 4

论文翻译地址: https://download.csdn.net/download/ggqyh/88815505

摘要

这篇系统文献综述(SLR)的目标是识别并对小数据和使用数据增强方法来增加用于声音(包括语音、讲话和相关音频信号)分类的深度学习分类器所需数据量的当前研究进展进行批判性评价。方法论:本文采用基于PRISMA的标准SLR指南进行,检索了三个文献数据库,分别是Web of Science、SCOPUS和IEEE Xplore。研究结果:通过使用多种关键词组合在过去五年(2017年至2021年)进行的初步检索共找到了131篇论文。为了选择符合本研究范围的相关文章,我们采用了一些筛选排除标准和前后向雪球采样,最终选定了56篇文章。独创性:以往研究存在的不足包括数据不足、标注不够准确的数据、不平衡的数据集、嘈杂的数据集、声音特征呈现不佳以及缺乏有效的增强方法,从而影响了分类器的整体性能,我们在本文中进行了讨论。在对鉴定的文章进行分析后,我们概述了声音数据集、特征提取方法、数据增强技术及其在声音分类研究问题中的应用。最后,我们总结了SLR的摘要,回答了研究问题,并对声音分类任务提出了建议。

1.引言

人工智能(AI)方法在各个科学领域的应用不断增长,在解决现实问题方面发挥着重要作用,特别是在计算机视觉[1]、自然语言处理(NLP)[2]、医疗保健[3]、工业信号处理[4]等各个领域的分类任务中。有趣的是,这些AI方法的成功也扩展到了其他领域,包括语音识别和音乐推荐任务[5]。高效且自动的声音分类系统的需求正在增加,因为它在我们的日常生活中具有重要性。自动声音分类技术广泛应用于监控系统[6]、语音助手[7]、聊天机器人[8]、智能安全设备[9]以及工程[10]、工业[11]、家庭[12]、城市[13]、道路[14]和自然[15]等不同的现实环境中。

机器学习方法,例如随机森林(RF)、决策树(DT)、逻辑回归(LR)、多层感知器(MLP)等,已被应用于声音识别系统[16]。在过去的十年中,包括深度学习方法在内的机器学习算法的进步表明其在提取高级特征方面具有很强的能力,这有助于有效地从原始输入数据中学习复杂的特征,从而提高了分类模型的性能[17]。最近,对这些深度学习算法的改进范式的转变,例如微调超参数、增强丢弃率和正则化、梯度下降的动量方法等[18],在诸如计算机视觉、自然语言处理(NLP)、金融和生物医学成像等许多领域中发挥了重要作用,推动了研究人员在这些领域的贡献[19-22]。

深度学习的出色表现,特别是卷积神经网络(CNN)在模式识别方面的出色表现,让其继续在高效的现代分类任务中产生巨大的影响。最近,深度学习方法在不同类型的声音/音频分类任务中的应用已经取得了很大进展,特别是在环境声音检测[23]、自动语音识别(ASR)[24]、音乐/声学分类[25]、医学诊断[26]等领域。然而,由于缺乏解决音频相关问题所需的数据、嘈杂的音频信号[27]以及工业声音[28]的可用性限制,在使用深度学习方法解决音频/声音相关问题时,仍然面临着性能不佳的困境。考虑到深度学习方法的广泛应用,一些研究人员被吸引将不同的机器学习算法应用于声音分类[29-31]。然而,音频信号具有高维度,这意味着需要超过一千个浮点值来表示一个短音频信号,这提高了探索降维和特征提取方法的需求。

深度学习模型在声音识别系统中可能会受到环境噪音的严重影响,这可能导致详细信息的丢失[32]。开发高效的声音识别系统面临的另一个重要挑战是获取大规模且有良好注释的数据集。此外,在声音分类系统中,数据稀缺性也面临着隐私[33]、道德和法律考虑[34]等挑战。

深度学习模型性能不佳可以归因于以下几个方面:

• 数据不足使得训练深度神经网络变得极为困难,因为音频/声音系统的高效训练和评估仅依赖于大量的训练数据[35]。

• 传统的音频特征提取方法缺乏有效识别更好特征表示的能力,从而影响声音识别的性能[36]。

• 建立高性能声音识别系统的关键挑战在于鲁棒性和泛化能力,一些现有系统由于一些因素如混响、噪声类型、信道等导致场景不匹配而降级[37]。

• 可靠的音频数据注释需要依赖专业知识[38]。

声音分类研究中另一个负面影响研究进展的问题是数据不平衡[39];这对深度学习系统的性能产生了严重影响,降低了其表现水平,因为大多数音频记录容易受到环境噪声的影响[40]。此外,创建一个声音记录数据集需要极大的时间和资源限制;因此,需要数据增强技术来生成综合数据集(图像、声音、文本等),这种方法在改善深度学习模型的性能方面发挥了重要作用。

与流行观点相反,即训练大型数据集对于获得深度架构模型的最佳结果至关重要[41],数据增强在声音分类任务中的进展已经表明它对于改善小数据集的训练模型性能具有一定的一致性[42]。数据增强的需求是不容忽视的,因为先前的研究表明在声音/音频分类任务中应用神经网络模型时[43,44],由于典型的过参数化模型,因此需要更大的数据集来减轻过拟合,并降低对背景噪声和信息冗余的敏感性[45]。此外,神经网络模型的应用高度依赖于在训练过程中初始化和精心调整超参数以改进分类模型[46]。

本文系统评述了声音分类任务中数据增强技术过去、现在和未来的全面趋势。该研究旨在介绍文献中应用的不同数据增强方法,通过定量和定性的统计分析措施展示研究趋势,以应对不足/不平衡数据集,提高数据泛化和检测率。在本文中,基于全面的方法论,系统地评价了文献资料,旨在确定与来源、数据库、特征提取方法、数据增强步骤和分类模型相关的声音分类任务的当前进展和相关研究的进展。

提出了以下研究问题(RQs),以确定系统综述的范围,并提出分析结果,以加强未来关于声音分类的研究,如下所示:

- 基于合理分类任务的现有论文是否适用于具体和既定的实验数据源?

- 使用的数据存储库或数据集源是什么?

- 使用哪些特征提取方法,提取哪些数据?

- 声音分类中应用的不同数据增强技术是什么?

- 我们如何衡量数据增强技术在学习算法中的重要性?

- 增强技术的未来研究建议是什么?

- 在应用数据增强进行声音分类时,发现了哪些障碍?

本文的剩余部分组织如下:第2节详细讨论声音数据集、特征提取方法、数据增强技术以及声音分类在不同领域中的应用概述。第3节介绍了SLR方法步骤,并描述了搜索选择方法。第4节详细介绍了我们的研究结果和发现,以及对所提出的研究问题进行的分析。最后,第5节总结了SLR并提出了声音分类任务的未来建议。

2.搜索和挑选文献的方法

我们采用了指南[47],该指南涵盖了系统文献综述的研究问题制定、搜索研究结构和数据提取标准。除此之外,我们还采用了一种简单而有效的过程,符合[48]中提出的方法论方法,如图1所示。

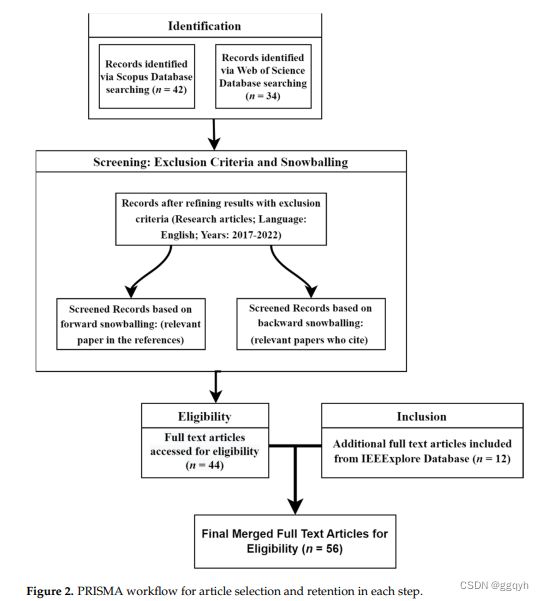

在这个情况下,首先概述了一个研究计划,其中包括研究目标和问题,并构建了各种组合/关键词元数据,如图1所示。为了保持文章的一致性,避免混淆和误解,本文决定将术语“声音”作为一个范畴,涵盖音频、语音和声音等内容。在Web of Science和Scopus数据库上进行了搜索,如表1所示。从2017年1月至2022年,使用关键词组合进行的文章搜索在Scopus数据库返回了42篇文章,而在Web of Science数据库返回了34篇文章。这些文章经过了标题、摘要和关键词的筛选,并通过前向和后向雪球法进行了补充[49]。还选择了其他数据库,总共包括了12篇相关文章在本研究中。因此,最终的相关选定文章仅包括55篇全文文章,这些文章与SLR的研究重点进行了比较。将这些选定的文章组进行了阅读、评论、分类和分析,以确保对系统文献综述过程进行开放和详细的报告[50],如图2所示的PRISMA工作流程图所示。

考虑到提出的研究问题,本研究旨在确定在不同研究领域中与声音分类相关的变化概念和主要观点,使用如图1所示的关键词组,并总结每个关键词组合找到的研究摘要,如表1所示。表1总结了关键词组合以及使用这些关键词在论文的标题、摘要和关键字中识别的论文数量。

3.SLR的研究结果

本章节介绍了系统文献综述的结果,包括符合纳入标准的选定文章的定量和定性分析。我们描述了本文所选56篇原始研究[51-106]的主要统计数据。

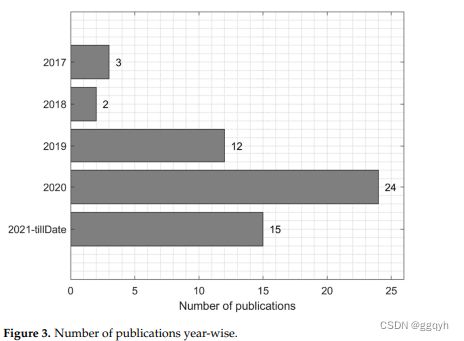

在本次系统文献综述中,我们包括了56篇原始研究,其中最高比例的研究是在2020年发表的,超过26%的选定文章发表于2021年,23%发表于2019年,而不到10%的选定文章发表于2018年和2017年,如图3所示。出版物类型被分类为研讨会(包括研讨会和研讨会论文)、会议和期刊。在出版物类型中,选定文章中59%是期刊文章,34%是会议论文,还有7%的研究是研讨会论文。

如图4所示,最受欢迎的原始研究数据库是IEEE和ScienceDirect,分别为28(50%)和16(29%),其余21%的选定文章同样来自MDPI、Springer和其他出版物来源。

在本LSR中,特征提取方法在声音分类任务中的重要性不容忽视,因为我们分析了选定出版物中特征提取的不同方法。从选定的研究中,我们意识到以前的研究人员比其他研究人员更多地使用一些特征提取方法,我们的分析结果表明,25.6%的选定出版物使用基于MFCC的表示,而18.6%的选定出版物应用了log-mel频谱图,16.3%的选定出版物使用Mel频谱法,9.3%的应用了STFT方法,其余30%的出版物应用了其他特征表示方法,如单词袋、CQT和ZCR能量,如图5所示。

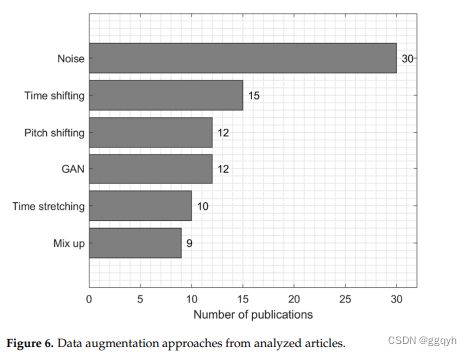

数据增强方法的结果如图6所示,基于添加噪声的数据增强方法拥有最高数量的出版物,达到22篇(39.2%),其次是时间偏移方法,有15篇(26.7%)被选中发表。其次是基于GAN的模型和音调偏移,各有12篇(21.4%),接着是其他方法,如时间拉伸、混合、背景噪声,分别有10篇(17.8%)、9篇(16.1%)和8篇(13.6%)。而诸如速度调制、掩模、VTLP、消除静音、翻转等方法在所选出版物中的应用均不到10%。

图7中的性能评估方法的结果显示,准确度是36篇出版物(64.3%)中最常用的性能评估方法,其次是F1得分,有14篇(25%)的分析出版物采用该方法。其次是召回率,有13篇(23.2%)的出版物使用该方法,而精确度方法在9篇(16.1%)的出版物中使用。其他一些指标,如等错误率(EER)、词错误率(WER)、均方误差(MSE)和特异度的使用较少。

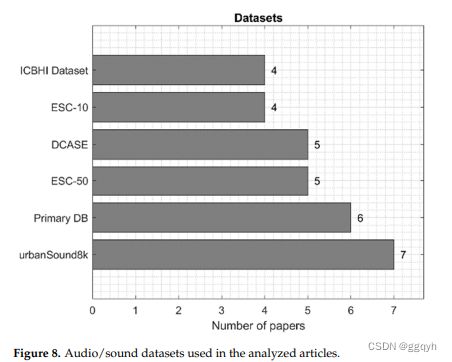

图8中的数据集使用结果显示,UrbanSound8K是7篇出版物(12.5%)中最受欢迎的数据集,而第二受欢迎的是Primary DB,占分析出版物的6篇(10.7%)。其次是ESC-50和DCASE,每个数据集都有5篇(8.9%)的出版物使用,然后是ESC-10和ICBHI数据集,每个数据集都有4篇(7.1%)的出版物使用。

图9中的分类方法结果显示,卷积神经网络(CNN)是44篇出版物(78.5%)中最常用的分类方法,其次是各种变体的循环神经网络(RNN),有9篇(16.1%)的分析出版物采用。集成学习和机器学习方法各自在6篇(10.7%)的出版物中使用。

为了进行更深入的分析,在接下来的部分中,我们还使用气泡图进行可视化,通过不同的维度来展示分析的各个方面之间的关系。这样可以识别现有文献中的研究空白。在第4节中,我们将讨论分析研究中使用的方法。

4.综述结果的讨论

我们详细讨论了声音分类模型的不同类别概述,如图10所示。在过去几十年中,研究人员引入并实施了一些有趣的发现和研究方法,涉及从环境声音、医学声音等方面创建声音数据库。

另外,一些研究改进了数据清洗方法,因为声音数据集容易受到噪音的影响,这对于改善或降低学习模型的性能起着重要作用。同时还提供了有趣的特征提取方法概述,并讨论了现有特征提取技术的独特性。为了进一步拓宽这篇综述的范围,我们专注于应用于音频/声音数据集以及从特征提取生成的图像的数据增强方法。最后,在本节中,我们分析了先前研究中提出的各种分类方法,并强调了这些分类器在整体性能方面的优缺点。

4.1声音数据集

声音数据集的现实应用范围广泛,包括用于开发智能系统(智能城市、智能医疗等)的自动语音识别(ASR)系统[107],声场识别[69],音乐分类[108],说话人识别[78],语音康复[109],语音障碍检测[110],语音情感检测[111],心脏听诊[61]等。相关研究中提到的数据集包括以下内容:Audioset标记[21],用于自动鼾声识别的INTERSPEECH 2017计算声学语言学挑战[112],动物音频数据集如Birdz和CAT[77],以及说话者验证数据集包括PRISM[113],NIST SRE10,SRE08[114]等。

缺乏足够数量的标记数据已成为声音分类进展的主要障碍之一。这其中的主要原因可以概述如下:类别不平衡、数据隐私问题、数据收集中的时间限制、对有效标注高度依赖专业知识等。在现有声音数据集中需要考虑的另一个有趣因素是数据集内部存在噪音环境的问题,特别是在识别儿童的语音时 [63]。

近年来,深度学习方法在模式识别任务中的出色表现继续对现代声音分类任务产生了巨大影响。随着深度学习的发展,一些最先进的可能性已经出现;然而,由于解决音频/声音相关问题的数据不足,这种方法仍然面临着性能较差的困境(见图11)。值得注意的是,缺乏足够的声音数据会对深度学习方法的性能产生负面影响,特别是对CNN [100]。根据研究,我们能够总结出现有声音数据集存在的一些问题,如弱标记数据问题 [96]、嘈杂的环境、数据不足[115]以及现有声音数据集内部类别不平衡[116]。

分析研究中使用的数据集总结如表2所示。区分了四种类型的声音数据集:语音数据集(包括从语音数据中识别情绪)、医学声音数据集,包括来自人体的各种声音、自然声音数据集,包括来自自然界(动物)的各种声音,以及环境声音数据集,结合了环境中的各种声音。

4.2声音分类中的特征提取方法

模型的表现优劣程度还取决于所使用的特征选择。因此,在考虑先前研究中使用的各种最新特征提取方法时非常重要。先前工作的一些发现表明,手工特征的使用在音频信号的通用表示方面存在问题[117]。

先前的研究者在不同领域的声音分类中广泛使用了频谱图特征,比如用于检测心脏疾病的心跳声[64]。梅尔频率倒谱系数(MFCC)的特征在表示声音方面表现出良好的成就,可用于检测呼吸系统疾病[51]。Ramesh等人[86]基于肺部声音提出了不同特征提取方法的组合,用于检测呼吸系统疾病,其中提出的特征提取方法的示例如下:ZCR、能量、能量熵、频谱质心、频谱展宽、频谱熵、频谱通量、频谱滚降和MFCC。类似的研究使用了四种特征提取方法来表示肺部声音,如CQT、STFT和mel-STFT,并最终与经验模态分解(EMD)相结合[54]。[118]中的作者介绍了一种基于局部和全局声学特征组合的聚合特征提取方案。

对于声音事件,提取了依赖类别的时域-频谱结构和长期描述性统计特征。其他作者应用了离散 Gabor 变换(DGT)音频图像表示[119],多分辨率特征[53],基于梅尔频率倒谱系数和伽玛音频频谱系数的混合方法[62],倒转的 MFCC 和扩展的 MFCC [66],音频单词包(BoAW)[120],窄带自相关特征(NB-ACF)[121]。

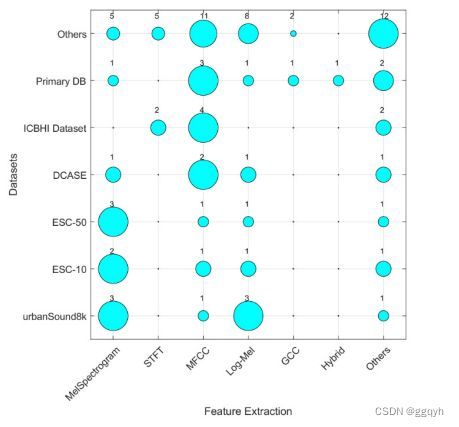

图12展示了特征提取方法和所使用的数据集的发表刊物分布。尽管melSpectrogram和MFCC是常用的方法,但该图允许我们确定一些数据集的空缺,例如melSpectrogram未被用于ICBHI数据集,而STFT也很少被使用。

根据我们的研究结果,特征表示对于提高学习算法在声音分类任务中的性能至关重要。音频信号通常具有高维度。因此,需要通过应用更好的特征表示技术来开发有效的特征识别方法,以增强声音识别。

分析研究中使用的特征提取方法总结在表3中。

4.3声音分类中的数据扩充方法

越来越多基于数据增强技术的文章应用于声音分类研究,这表明这些技术在各个研究领域中对于有效分类声音数据的重要性,从医学疾病检测到环境声音分类。

针对现有声音数据集存在的一些挑战,特别是缺乏足够的声音数据集和类别不平衡会对分类器的性能产生巨大影响,因此,增加数据样本数量并平衡类别分布对于改善声音识别系统至关重要。用于生成合成数据集的通用术语是数据增强[122]。当应用于音频领域时,可以通过应用一些滤波器(如音高变换、噪声去除、压缩、时间拉伸等)来实现音频数据的增强[88]。除了增加输入训练数据的泛化能力和表现形式外,数据增强还允许该系统提高数据的显著性,而不管可用的数据样本[59]。

考虑到深度学习方法的广泛应用,一些研究人员已经着迷于将不同的机器学习算法应用于声音分类。数据增强(DA)是一种非常流行的方法,用于增强训练数据的数量。简单地描述 DA 是通过转换训练数据来创建合成样本的过程,旨在提高学习分类器的性能和鲁棒性。这是解决过拟合问题最有效的方法之一,尤其是在使用深度学习模型时,从而提高了泛化能力[105]。在音频或语音数据中,通过添加噪声来破坏清洁的训练语音,被认为可以提高语音识别系统的鲁棒性[123]。此外,先前的研究表明,当使用更多数据来进行训练模型时,数据驱动算法的准确性显著提高,从而降低了过拟合的可能性[93]。同样,Diffallah 等人 [56] 将数据增强的主要目标描述为通过注入变换合成数据的变化来破坏训练数据,从而增加训练数据。数据增强的重要性不言而喻,因为它在获得最先进的结果方面发挥了重要作用。作者在[124]中的另一项研究应用窗口删除方法来增加训练样本并改善膝盖健康分类。

错误选择数据增强方案的影响更容易产生具有差异化较差的合成样本,这将导致分类器性能不佳。不幸的是,在医疗应用领域,就图像或声音而言,数据不足的问题一直存在重大差距,因为现有数据仍然在可用数据库中存在类别不平衡的问题,ICBHI 数据集[125]就是一个典型例子。一些现有的声音数据集也受到背景噪声的影响,这也会影响学习模型的整体性能。除了传统的数据增强方法之外,还提出了一些有趣的转换方法来生成合成训练样本,例如随机擦除、缩放、掩蔽(频率和时间)、标准化和修剪[126]。[71]的另一项研究引入了一个二阶段的环境声音分类数据增强框架,被归类为蛮力、条件类和基于度量的增强。[103]提出了一些有趣的数据增强方法,如Griffin Lim和WORLD Vocode技术。

环境声音识别任务面临的一个主要挑战是缺乏一个通用的数据库;这是因为现有大多数声学数据库都是针对特定应用任务,并间接与自然环境声音相关[55]。在环境声音分类任务中应用数据增强方法有助于从现有的声音或音频样本中创建人工输入数据,这些数据经过修改,使其与原始样本有所不同,并保持了该任务所需的重要信息[74]。在以往的研究中,用于生成从声音数据中提取出的声音和图像特征的合成数据集的传统数据增强或转换方法包括:时间偏移、音高变化、随机噪声、音量增益范围、声道长度扰动 VTLP[54]等。在本文中,我们意识到随机噪声数据增强方法在我们选择的刊物中的应用,包括白噪声[75,79]、喋喋不休的噪声、MUSAN 噪声、静态噪声[78]、工厂噪声、控制室、工厂车间、喷气式驾驶舱[80]、volvo[63]、大声喊叫、铜管乐器[91]、背景噪声[55,90]、椒盐噪声等。Leng 等人[69]提出的其他数据增强技术基于主题模型-潜在狄利克雷分配(LDA)算法,用于生成合成数据,还有混合方法[81]等。

更复杂的数据增强方法包括应用生成对抗网络(GANs)[85,86]以及其他变种的GAN,如ACGAN [104]、WCCGAN [57]、GAN和VAE [95]以及WaveGAN [74,99]。这项SLR展示了在不同的声音分类任务、语音识别、音乐检索等领域中使用的一些最先进的数据增强方法。考虑到音频/声音数据的复杂顺序结构,生成人工数据样本是非常具有挑战性的[74]。

生成对抗网络(GANs)最显著的贡献之一是在逼真图像合成和视频中运动模式建模方面。使用GANs可以改进合成数据集,使其统计分布模拟真实世界数据集的分布。许多方法研究了如何通过使用GAN模型更有效地改变声谱图像[85,86]。此外,GAN的成功在于对高维数据的建模能力,对缺失数据的处理能力以及产生准确结果的能力。

最近,一维RNN模型(如长短时记忆网络(LSTM)和门控循环单元(GRU))已经与CNN相结合。三维卷积是分析图像时间序列的另一种方法。为了获取时序信息,第三个维度被用来堆叠多个连续的帧。一种可能的替代方法是将GAN扩展为一个针对时间序列的特定模型,如三维卷积或RNN。编码器-解码器网络将高维输入转换为潜在空间中的低维向量,然后再将其转换回原始的高维或结构化输入。数据增强技术对从潜在空间中取样的向量样本进行解码,以产生新的模式。例如,可以使用基于LSTM的自编码器(LSTM-AE)生成人工数据[95]。

尽管数据增强在增加训练样本和整体声音分类任务方面具有重要作用和改进,但仍存在一些缺点,如先前的分析研究所述,显示数据量的扩大可能会限制神经网络的结构复杂性[106]。此外,从数据增强方法生成的数据集缺乏适当的表示,因此导致模型学习不足[127]。其他高级方法,例如传统的GAN增强方法,基于普通随机输出,导致训练样本的不受控制的扩展,对学习分类器的影响很小或没有[74]。GAN的另一个问题是生成合成数据涉及高计算复杂度。因此,基于现有声音识别数据增强技术的一些缺点,未来的研究努力应考虑通过采用有效的混合模型来改进合成数据表示,从而生成更好的训练样本,可以更好地表示,从而提高声音分类的分类模型。

分析研究中使用的数据增强方法概述如表4所示。

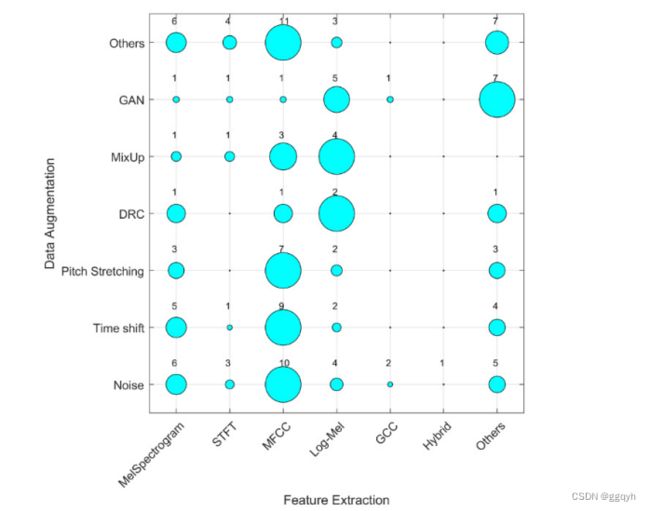

图13显示了使用特征提取和数据增强方法的刊物的分布情况。图中显示,音高拉伸、时间偏移和其他数据增强方法更常用于MFCC特征,而GAN、Mix-up和动态范围压缩(DRC)增强更常用于对数梅尔特征。基于MFCC的特征是最常用的,并且可以在该领域实现最先进的结果。

4.4声音分类中的分类方法

分类是机器学习和模式识别中的常见任务。深度学习方法,如CNN模型,在与机器学习方法(如随机森林、Adaboost等)相比,通常在小数据集上表现较差[100]。为了获得更好的分类器性能,需要更多的数据来可靠地估计泛化误差。相反,传统的机器学习算法,如集成分类器,已经被证明在学习具有改进的泛化能力的特征方面适应得非常好,即使在小规模和不平衡的数据集的情况下也是如此。

近年来,不同的机器学习算法已被应用于声音事件检测和医学声音检测,并取得了重要的成果。有趣的是,一些单一分类器在自动声音分类任务中显示出非常有用,例如支持向量机(SVM)[66,74,126]、使用语音和呼吸声进行人员识别的多层感知器[92]、隐马尔可夫模型(HMM)[53]、逻辑回归和线性判别分析[118]等。其他研究应用了集成方法,如随机森林[86,100]、XgBoost[99]等。虽然考虑到声音的复杂性以及学习分类器对于识别声音特征的不同表示需要极高的敏感性,传统的机器学习算法仍然在有效分类声音数据的复杂任务中存在问题。因此,在声音分类任务中,深度学习方法的选择被证明更加高效。深度学习是机器学习的一个分支,与其他分支不同之处在于它能够通过应用层次结构并且无需人为干预从数据中提取有意义的特征[67]。声音分类方法已经从简单的机器学习分类器过渡到先进的深度学习分类器,并且CNN能够实现显著且更准确的训练结果[65]。

先前的研究工作已经展示了深度学习方法和神经网络架构在声音分类任务中的多样应用。例如,[66]提出了MLP和其他四种机器学习算法的声音分类方法,包括VGG网络[90]、长短期记忆网络[69]、DCNN[82,83]、TDNN[70,96]和GoogleNet[77]。Mushtaq等人的另一项研究[76]在环境声音分类中进一步应用了不同的预训练深度学习模型,包括DenseNet、ResNet[56,60]、AlexNet、SqueezeNet以及BiGRU Attention XGBoost [103]。Greco等人[59]还基于音频事件识别网络(AReN)实现了一个基于CNN的方法。张等人[101]提出了一种使用SVM和GRU-RNN组合的混合方法,Celin等人[53]则应用了深度神经网络(DNN)的隐马尔可夫模型与混合方法进行声音分类。

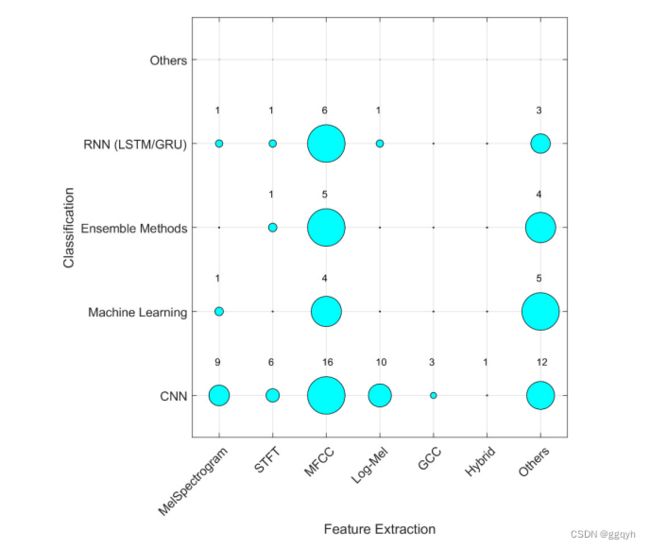

图14展示了按照特征提取和分类方法的文献分布情况。大多数文章使用MFCC进行特征提取,并使用CNN进行分类。MFCC也经常与RNN、集成学习和机器学习一起使用,然而其他特征很少与集成和机器学习方法一起使用。

分析研究中使用的分类方法总结在表5中。

4.5在声音分类中应用数据增强方法的障碍是什么?

表6显示了从选定的研究中获得的信息摘要,包括相应研究的总数。本文综述中选择的大多数文章都强调,与训练时间相关的数据增强方法的计算复杂性增加或高度是一个严重的障碍。更重要的是,另一个有趣的障碍是从嘈杂的数据集(例如使用低质量麦克风捕获的数据)创建嘈杂的合成数据可能会导致声音质量较差,从而导致机器学习分类器性能不佳。此外,现有数据增强方法存在高误分类率、高假阳性率和数据泛化能力差等障碍在声音分类任务中也起着关键作用。

尽管在选定的文章中发现了一些缺陷,但我们还发现,在过去的五年里(2017年至2022年),数据增强方法在声音分类研究中取得了显著进展。通过将数据增强技术与声音数据集的分类或识别相结合,改善了作者在[62,69,72,92,98,103]中记录的泛化能力。其次,在不平衡数据集中引入特定类别的数据增强技术有助于解决过拟合问题[67,86,92,104],从而提高了预测性能[58,61]和分类稳定性[59,65,66,69,91,106]。一些选定文章中的报告暗示,数据增强技术的实施可以获得更好的分类结果[51,63,67,75,76,79,84,87,89,93,95],并减少误分类或错误率[62]。

4.6结果总结

我们将SLR的结果总结为声音分类方法的分类法(图15),该分类法基于图16中呈现的方法概述。该分类法包括特征提取和数据增强方法,以及声音分类研究领域中使用的数据集。预计这个分类法对于从事该领域研究的研究人员将会很有用。

4.7推荐

不同的增强方法已经被确认,并且大多数应用的增强技术对改善整体分类性能产生了显著影响,比如添加随机噪声、时间偏移、时间拉伸和扭曲、音调修改、混合、缩放以及频谱图变换。建议研究人员在数据稀缺的情况下使用这些方法来提高分类性能。此外,这项研究还确定并报告了在声音分类中应用数据增强方面所选研究的贡献和局限性。所有与数据增强技术应用相关的问题都将有助于未来的研究工作,并帮助未来的研究人员开发或实施更加健壮的增强方法,以实现更好的声音泛化和改善适用于真实系统的声音识别系统。

目前,在声音分类领域,具有记忆功能的各种卷积深度学习方法,如RNN、LSTM,以及它们的衍生方法,如时延神经网络(TDNN)和双向门控循环神经网络(BiGRU),提供了最佳结果。深度学习模型通常需要将输入数据格式化为矩阵,并将其解释为图像。在这种情况下,常用的适当特征提取方法是梅尔频率倒谱系数和梅尔频谱图,它们可以将一维音频序列转换为可用于训练深度学习模型的图像。此外,除了整合有效的数据增强技术外,识别最佳的声音数据表示形式对于改善声音分类的性能结果也是一个关键因素。

4.8对有效性的潜在威胁

为确保SLR的完整发现,识别潜在的有效性威胁非常重要。可能的有效性威胁可以分为内部、外部和结论有效性。这个SLR解决了内部类别,并构建为作者之间的讨论,他们同意制定本研究中的所有研究问题,并确定我们制定的研究问题与研究目标之间的协同关系。与其他领域最近的SLR只关注期刊论文不同,这个SLR在高质量的期刊和会议上进行了彻底而细致的文献搜索。基于这个因素,主要的文献搜索是在期刊文章和会议论文中进行的,考虑到所提出的发现的质量和提供解决我们定义的研究目标所需的足够信息的能力。

本研究中选择的56篇文章可以代表应用数据增强技术在声音分类领域的最新进展。此外,我们系统地应用自动化和手动搜索策略来识别现有的文献。采用了滚雪球法在搜索相关文章时避免遗漏任何相关文章的可能性,并通过仔细阅读摘要来评估搜索结果的相关性。

为了确保我们结论的有效性,我们报告了所有发现的细节并分析了搜索结果。因此,我们能够获得可靠且有意义的结果,并且已经仔细处理了这项研究的所有潜在威胁。

5.结论

本综述研究的目的是识别与环境和医学声音检测相关的声音分类任务中数据增强方法的进展,并其次是识别在分类和特征提取模型方面最佳的方法。为此,我们应用了定量和定性相结合的系统文献综述方法。据我们所知,这项研究是首个分析数据增强方法不同视角的研究之一;然而,以前确实有一些基于声音分类方法的综述,但本SLR将数据增强、分类和特征提取方法的所有进展整合到一篇连贯的论文中。与计算机视觉中数据增强方法的进展不同,通过我们的系统文献综述,我们发现在生成合成声音数据的先进方法应用方面仍存在滞后现象。

文献检索基于三个数据库(Web of Science(WoS)、Scopus 和 IEEEXplore),目的是仅搜索期刊和会议中的高质量学术出版物。这项文献的系统综述显示声音分类的研究涉及广泛的应用领域,包括环境声音分类、乐器识别、机械声音识别、医学疾病检测等。为了专注于声音分类先前研究的最新趋势和未来预测,我们将搜索范围限定在五年内的研究(2017年至2022年),经过深入的选择标准后确定了56篇选择出版物。为了更好地解释,这些选定的出版物是基于定量和定性方法进行分析的,旨在回答有关采用数据增强技术的研究问题;衡量这些技术对学习算法的效率,提出未来建议的增强技术以改善分类器在开发智能声音分类系统中的效率,适用于现实场景。

本研究通过彻底创建一项新的、全面的系统文献综述,结构化了数据增强技术以推进声音分类任务,从而为最新技术做出了贡献。本研究通过识别障碍和改进领域,展示了数据增强方法的影响和不足之处,这将在未来的研究中大大受益,着重关注改进小型数据集的数据增强方法和提高声音分类的需要。