该作业要求来源于:https://edu.cnblogs.com/campus/gzcc/GZCC-16SE2/homework/3075

一、作业要求

一.把爬取的内容保存取MySQL数据库

- import pandas as pd

- import pymysql

- from sqlalchemy import create_engine

- conInfo = "mysql+pymysql://user:passwd@host:port/gzccnews?charset=utf8"

- engine = create_engine(conInfo,encoding='utf-8')

- df = pd.DataFrame(allnews)

- df.to_sql(name = ‘news', con = engine, if_exists = 'append', index = False)

二.爬虫综合大作业

- 选择一个热点或者你感兴趣的主题。

- 选择爬取的对象与范围。

- 了解爬取对象的限制与约束。

- 爬取相应内容。

- 做数据分析与文本分析。

- 形成一篇文章,有说明、技术要点、有数据、有数据分析图形化展示与说明、文本分析图形化展示与说明。

- 文章公开发布。

参考:

32个Python爬虫项目

都是谁在反对996?

Python和Java薪资最高,C#最低!

给《流浪地球》评1星的都是什么心态?

《都挺好》弹幕数据,比剧情还精彩?

爬了自己的微信好友,原来他们是这样的人……

春节人口迁徙大数据报告!

七夕前消费趋势数据

爬了一下天猫上的Bra购买记录,有了一些羞羞哒的发现...

Python做了六百万字的歌词分析,告诉你中国Rapper都在唱些啥

分析了42万字歌词后,终于搞清楚民谣歌手唱什么了

十二星座的真实面目

唐朝诗人之间的关系到底是什么样的?

中国姓氏排行榜

三.爬虫注意事项

1.设置合理的爬取间隔,不会给对方运维人员造成压力,也可以防止程序被迫中止。

- import time

- import random

- time.sleep(random.random()*3)

2.设置合理的user-agent,模拟成真实的浏览器去提取内容。

- 首先打开你的浏览器输入:about:version。

- 用户代理:

- 收集一些比较常用的浏览器的user-agent放到列表里面。

- 然后import random,使用随机获取一个user-agent

- 定义请求头字典headers={’User-Agen‘:}

- 发送request.get时,带上自定义了User-Agen的headers

3.需要登录

发送request.get时,带上自定义了Cookie的headers

headers={’User-Agen‘:

'Cookie': }

4.使用代理IP

通过更换IP来达到不断高 效爬取数据的目的。

headers = {

"User-Agent": "",

}

proxies = {

"http": " ",

"https": " ",

}

response = requests.get(url, headers=headers, proxies=proxies)

四、第十周课堂检查

二、结果

这次作业我是爬取了猎聘网的信息。爬取的是关于软件几个语言的招聘信息。例如需求该语言的职位需要什么要求,有什么福利,工资等等。并且保存为csv文件。

1.爬取JAVA

2.爬取c++

3.爬取web

三、分析

以java为例:

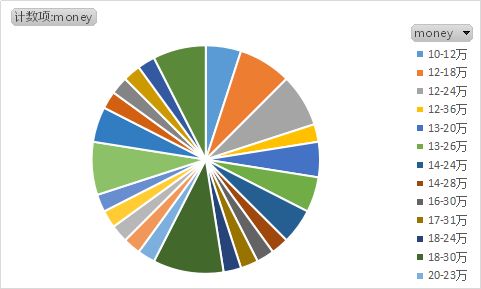

由这个图可以看出大部分岗位的年薪都在15-30万左右。

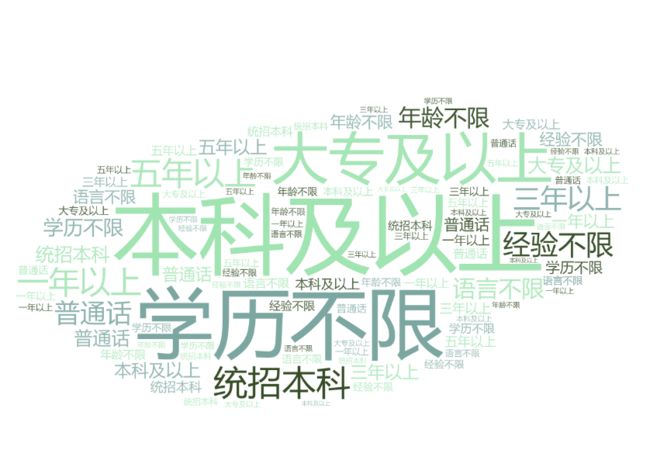

由这个图可以清楚的看到,对于java这个语言来说,大部分招聘岗位要求都是本科以上,对于工作经验而言,很多都是要3年以上的工作经验。

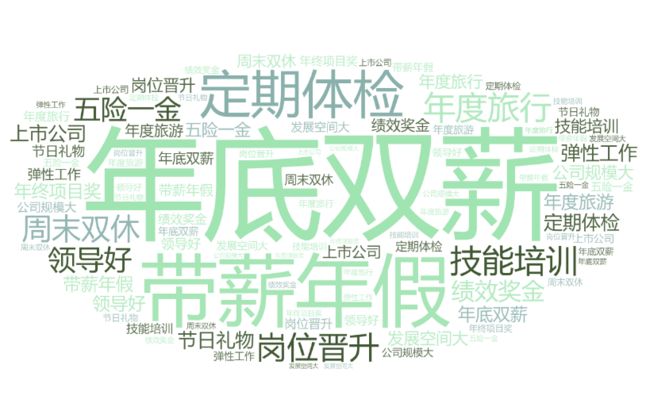

上图是各大公司招聘的福利关键字的词云图,由此可以看到,很多公司都是以年底双薪、带薪年假、岗位晋升等福利来吸引员工。这个侧面也反映了目前这个行业,能够吸引人的福利是这些。对于员工来说薪酬是最重要的,还有员工的身体健康和发展空间。

四、部分代码

import requests

from bs4 import BeautifulSoup

from datetime import datetime

import time

import random

import pandas as pd

'''爬取招聘网相关信息例如公司名、工资、待遇福利等'''

def work(url):

newDict={}

res = requests.get(url)

res.encoding = ('utf-8')

soup = BeautifulSoup(res.text, 'html.parser')

title = soup.select('.title-info')[0].text.split()[0]

company = soup.select('.title-info')[0].text.split()[1]

money = soup.select('.job-item-title')[0].text.split()[0]

welfare=soup.select('.comp-tag-list li span')

requirement=soup.select('.job-qualifications span')

newDict["title"]=title

newDict["company"]=company

newDict["money"]=money

newDict["welfare"]=welfare

newDict["requirement"]=requirement

p = print(title,'\n',company,'\n', money,'\n',welfare,'\n',requirement)

return newDict

'''获取url列表'''

def alist(url):

res = requests.get(listUrl)

res.encoding = 'utf-8'

soup = BeautifulSoup(res.text, 'html.parser')

worksList = []

for news in soup.select('li'):

if len(news.select('.job-info'))>0:

worksUrl = news.select('a')[0]['href']

worksData=work(worksUrl)

worksList.append(worksData)

return worksList

allnews=[]

for i in range(0,1):

listUrl = 'https://www.liepin.com/zhaopin/?init=-1&headckid=830b7ffde0cfe00f&dqs=050&fromSearchBtn=2&imscid=R000000035&ckid=830b7ffde0cfe00f°radeFlag=0&key=java&siTag=k_cloHQj_hyIn0SLM9IfRg~ha394EQxjcUgWMmp6o3mbw&d_sfrom=search_sub_site&d_ckId=9466ede2f349c7ec6ded841fd0a2075d&d_curPage=0&d_pageSize=40&d_headId=9466ede2f349c7ec6ded841fd0a2075d&curPage={}'.format(i)

allnews.extend(alist(listUrl))

for j in range(5):

time.sleep(random.random()*3)

newsdf=pd.DataFrame(allnews)

newsdf.to_csv('work.csv')

以上是我爬取数据的主要代码。剩下的词云,使用的是在线词云生成工具。