大模型GUI系列论文阅读 DAY4:《PREDICT: Multi-Agent-based Debate Simulation for Generalized Hate Speech Detecti》

摘要

虽然已经提出了一些公共基准用于训练仇恨言论检测模型,但这些基准之间的标注标准差异为模型的泛化学习带来了挑战,限制了其适用性。先前的研究提出了通过数据整合或扩充来泛化模型的方法,但在克服数据集之间的标注标准差异方面仍然存在局限性。为了解决这些挑战,我们提出了PREDICT,一种基于多代理(multi-agent)概念的仇恨言论检测新框架。PREDICT包括两个阶段:(1)PRE(基于视角的推理):根据给定数据集的标注标准创建多个代理,每个代理生成立场和推理;(2)DICT(使用不一致参考进行辩论):代表仇恨和非仇恨立场的代理进行辩论,裁判代理负责分类仇恨或非仇恨并提供平衡的理由。对五个代表性公共基准的实验表明,PREDICT在跨评估性能上优于专注于特定标注标准或多数投票的方法。此外,我们验证了PREDICT能够有效调解代理之间的意见分歧,并适当地整合少数意见以达成共识。我们的代码可在GitHub - Hanyang-HCC-Lab/PREDICT: Multi-Agent-based Debate Simulation for Generalized Hate Speech Detection获取。

1. 引言

互联网仇恨言论的增长已成为一个重要的社会问题,促使研究人员对仇恨言论检测展开了广泛研究(Moy等,2021;Jahan和Oussalah,2023;Zhou等,2021)。仇恨言论检测面临的主要难题之一是泛化性(Yin和Zubiaga,2021),即在特定数据集上训练的高效模型在应用于不同数据集时可能表现不佳(Cai等,2022)。这种泛化困难主要源于各种标注标准的差异(Ramalingam等,2022),包括:

- 目标(识别社交和历史背景中的仇恨言论、基于情感分类仇恨言论,或专注于仇恨言论的目标对象),

- 标注方法(标注员数量、标注流程及指南),

- 标注粒度(多类或二元分类),

- 数据集规模,

- 数据收集的时间与方法(Sachdeva等,2022;Khurana等,2022)。

因此,需要一种不依赖于特定标注标准的方法,以提高仇恨言论检测的泛化能力。

先前研究

以往的研究尝试通过多种方法来解决泛化性问题,包括数据整合、数据增强和解释生成。例如:

- 通过整合涵盖性别和种族等不同主题的数据集(Bourgeade等,2023),模型可以学习更广泛的仇恨言论模式。然而,由于不同数据集的标注差异,相似词语或表达的句子可能被赋予不同标签,导致模型在一致性上的困惑。

- 使用GPT-2进行数据增强(Wullach等,2021)可以帮助模型学习各种形式的仇恨言论,但此方法的局限性在于可能生成与原始数据集中存在的重复模式。

- 利用GPT生成的解释进行训练(Yang等,2023)依赖于特定的标注标准,导致在不同标注标准数据集上的表现欠佳。

尽管上述方法在一定程度上提高了仇恨言论检测的性能,但它们在将不同标注标准纳入模型训练或推理过程中仍存在不足。

我们的研究

本研究采用多元视角方法(Waseem等,2018),旨在尊重和包容多种观点,以建立共识,并应对数据集中不同标注标准导致的过拟合问题。最近的社会科学研究强调多元主义在仇恨言论问题中的价值(Tontodimamma等,2021),主张包容多样化的价值观和观点,并强调理性整合这些观点以达成社会共识的必要性(Dudley-Marling和Burns,2014;Feldman,2021)。

在本文中,我们提出了PREDICT框架,该框架利用**大语言模型(LLM)**构建一个多代理(multi-agent)辩论环境,每个代理根据仇恨言论数据集的标注标准拥有独立的观点,并模拟多元决策过程。PREDICT包括两个阶段:

- PRE(基于视角的推理):在该阶段,代理根据分配的标注标准和相似上下文形成观点。

- DICT(使用不一致参考进行辩论):在该阶段,两个立场对立的代理进行辩论,最终由裁判代理提供最终标签和理由。DICT阶段的决策过程借鉴了Liang等(2023)和Xiong等(2023)的研究,进行两轮辩论以达成最终决定。

实验与贡献

我们在五个公共基准数据集(对应五个不同代理)上进行了实验,以量化评估PREDICT在泛化仇恨言论检测中的性能(详见第4节)。结果表明,PREDICT在所有五个数据集中均能准确检测仇恨言论,具有显著的有效性。

贡献总结

我们的研究强调了仇恨言论研究中建立共识的重要性,并展示了多元观点在提高检测准确性方面的价值。主要贡献如下:

- 尊重多元视角:PREDICT将不同数据集的标注标准视为“独立视角”,尊重多元化仇恨言论观点,并将其存储为辩论的参考依据。

- 通过辩论达成共识:PREDICT提供了一种基于推理的辩论模拟方法,帮助多代理在不同视角下达成共识。

- 泛化能力:我们验证了PREDICT的泛化能力及其在仇恨言论检测中的卓越性能。

2 相关工作

2.1 仇恨言论检测的泛化

针对仇恨言论检测泛化性的挑战,已有多种研究方法(Rizos等,2019;Ludwig等,2022;Pendzel等,2024;Nirmal等,2024;Fortuna等,2020;Jin等,2023)。我们将这些方法归类为三种主要类别:数据增强、数据整合和利用大语言模型(LLM)生成解释。

Wullach等(2021)提出了一种基于GPT-2生成大量合成仇恨文本的方法,该方法在特定仇恨言论数据集上训练,以增加数据集的规模并解决仇恨与非仇恨数据之间的不平衡问题。然而,该方法的局限性在于,生成的数据仍然反映了原始数据中的偏见。

Bourgeade等(2023)整合了涵盖性别和种族等多种主题的仇恨言论数据集。通过在此数据集上训练,模型能够学习不同形式的仇恨言论模式,并减少对特定主题的偏见。然而,由于不同数据集的标注指南存在差异,导致相同主题的标注不一致,限制了模型的泛化能力。

Yang等(2023)采用LLM通过“链式思考”提示生成仇恨言论的自由文本推理。这些生成的推理帮助模型更好地理解文本的细微差别和上下文,从而提高仇恨言论检测的准确性。然而,各数据集之间缺乏共同特征(如语言模式和结构元素),仍然对泛化造成挑战。

Hong和Gauch(2023)提出了一种多任务学习框架,同时训练仇恨言论检测(主任务)和情感分析(次任务)。该框架利用共享参数编码器在两个任务之间进行知识共享,并探索将额外的情感标签纳入模型以提高泛化能力。然而,该方法的局限性在于情感数据的质量和范围有限,仅在特定数据集上有效。

尽管已有多种技术方法用于提升仇恨言论检测的泛化能力,但对数据集之间标注标准差异的考虑仍不足,表明需要进一步努力来识别并克服数据集之间的差异。本研究采用多元化方法,以有效应对标注标准差异带来的挑战,并探索提高仇恨言论检测泛化性能的方法。

2.2 代理辩论

随着大语言模型(LLMs)的显著进步,研究人员已经开展了一系列工作,以利用多个代理来模拟人类行为,从而改进某些下游任务,如算术问题和翻译(Liang等,2023;Wu等,2023;Subramaniam等,2023)。

Chan等(2023)提出了CHATEVAL,一个用于评估LLM在各个领域和主题下生成答案质量的系统。CHATEVAL采用多代理方法对答案进行评估,从而提高评估的准确性和可靠性。

Du等(2023)提出了一种方法,使多个代理独立分析并解决给定任务(如算术问题)。代理之间相互审查并进行辩论,提出反驳意见,以提高模型的推理能力和准确性。

此外,MAD(Multi-Agent Debate)框架为代理设定了支持方和反对方,使代理在翻译、算术等特定任务上进行辩论。研究表明,MAD框架通过代理之间的相互反馈,缓解了由“思维退化”(Degeneration of Thoughts,DoT)引起的问题。

尽管先前的研究展示了基于LLM的多代理交互和辩论框架在各种下游任务中的有效性,但代理生成的文本仍然依赖于LLM的内部知识,这种方法受制于模型的固有偏见和不确定性。因此,在仇恨言论检测领域,执行一致且无偏见的辩论至关重要。

在本研究中,我们基于先前的研究成果,手动精炼每个公共基准数据集的标注标准,并将其分配给各代理的独立视角。此方法促成了PREDICT框架的提出,使其能够根据代理的不同视角生成和辩论观点。我们认为,这是首次在仇恨言论检测领域提出基于多代理模拟的研究。

2.3 PREDICT的理论基础

多项理论与实证研究为多代理系统在仇恨言论检测中的决策改进提供了基础。

Mannes等(2014)表明,群体平均预测比个人估计更准确,这解释了PREDICT框架中多代理集体判断如何克服单个代理的局限性,从而提高仇恨言论检测的准确性。

Bose等(2017)强调,群体可以在没有集中领导的情况下做出有效决策。这一理论是PREDICT框架的核心,在该框架中,各代理能够独立推理并达成共识,而无需依赖专注于特定数据集的单一代理。

Davani等(2023)研究了人类标注员的偏见如何影响人工智能系统,并表明,这些偏见会在AI系统中被放大,进而强化社会偏见和歧视性态度。因此,在PREDICT框架中,纳入具有多样化背景和偏见的代理至关重要,以帮助减少单个代理的偏见并提高仇恨言论检测的准确性。

支持PREDICT方法的进一步研究(Muthukrishna和Henrich,2016;Malone等,2009;Riedl等,2021)表明,当具有不同背景和经验的成员参与问题解决时,群体的能力会显著提高,这进一步验证了我们框架中多样化视角的价值。

3 方法

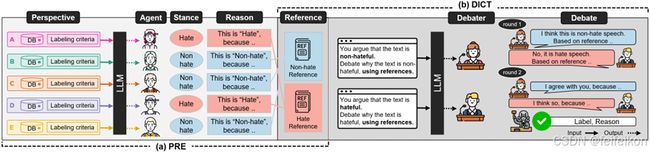

图2展示了PREDICT框架的整体概览,该框架由两个主要阶段组成:

- PRE(基于视角的推理): 该阶段基于精炼的独立视角,为给定文本生成代理的立场和推理。

- DICT(基于不一致参考的辩论): 该阶段中,代理根据其立场(即“仇恨”或“非仇恨”)模拟辩论,并最终达成共识以进行仇恨言论检测。

在DICT阶段,代理根据立场被划分为两个阵营。辩论者结合各自阵营的理由进行两轮辩论,最终由裁判代理对文本进行仇恨或非仇恨的判定,并提供平衡的理由,尊重双方的观点。

3.1 PRE:基于视角的推理

PRE(Perspective-based REasoning)的目标是为每个代理定义立场和推理,以模拟基于推理的辩论。五个代理分别被赋予五种独立视角,并对相同文本是否具有仇恨性进行立场表态,同时生成支持其立场的理由。

独立视角由以下两个组成部分构成:

- 标注标准(Labeling criteria): 作为判断文本是否为仇恨言论的决定性因素。

- 相似上下文(Similar contexts): 通过这些标准标注的文本提供了类似的上下文,有助于建立独立视角。

图3-(a)展示了为每个代理分配独立视角的过程,而图3-(b)展示了基于视角生成立场和理由的过程。

为反映标注标准作为独立视角,本文的三名研究人员对五个公共基准数据集进行了内容和主题分析(如数据集构建目的、标注方法),详见附录A。以数据集B为例,标注标准被精炼后转换为提示,并被分配给各代理的独立视角。为确保文本生成的稳定性和一致性,我们采用了Huang等(2024)提出的角色分配提示框架,并在其基础上添加了我们的独立视角,详细提示结构见附录D。

为了呈现类似的上下文作为独立视角,我们基于输入文本在特定视角数据库中使用余弦相似度搜索提取最相关的三条文本。每条提取文本包括句子和标签,为代理生成立场和理由提供依据。

- 若代理将文本分类为“仇恨”,则理由被添加到“仇恨参考”;

- 若分类为“非仇恨”,则理由被添加到“非仇恨参考”。

这些参考作为仇恨或非仇恨阵营的辩论基础,并将在DICT阶段(3.2节)中用于辩论。PRE阶段确保每个代理基于标注标准和相似上下文形成独特视角,以支持后续的辩论模拟。算法1描述了PRE阶段的整体过程:

算法1 PRE:基于视角的推理

输入:

- 文本 ttt

- 标注标准集合 {A,B,C,D,E}\{A,B,C,D,E\}{A,B,C,D,E}

- 数据库集合 {dbA,dbB,dbC,dbD,dbE}\{dbA, dbB, dbC, dbD, dbE\}{dbA,dbB,dbC,dbD,dbE}

输出:

- 非仇恨参考 nh_Refnh\_Refnh_Ref

- 仇恨参考 h_Refh\_Refh_Ref

步骤:

- 初始化

nh_Ref和h_Ref为空列表; - 对于每个标注标准及其对应数据库:

- 计算输入文本与数据库中文本的相似度;

- 生成独立视角提示;

- 基于提示利用LLM生成立场和理由;

- 根据立场将理由添加到相应参考集合中。

- 返回

h_Ref和nh_Ref。

3.2 DICT:基于不一致参考的辩论

DICT(Debate using InCongruenT references)的目标是通过多代理辩论模拟,在仇恨言论检测中达成共识。

图4展示了DICT阶段的整体流程。首先,在辩论开始前,五个代理根据PRE阶段的立场被分配到“仇恨”或“非仇恨”阵营。每个阵营的两名辩论者分别收到对应阵营的参考,即由相应代理提供的理由集合。我们的框架中,辩论共进行两轮。

第1轮辩论:

- 由主持代理基于预定义提示(图4-(a))生成文本,引导双方辩论者围绕输入文本展开辩论。

- 辩论者基于参考提供立场和观点,并相互反驳。

- 辩论内容被存储到辩论历史中。

第2轮辩论:

- 主持代理要求辩论者根据预定义提示,针对对方的观点进行反驳或同意,并可能修正其最初的立场(图4-(b))。

- 该阶段的所有辩论记录将被存储。

最终,裁判代理参考辩论历史,对文本是否为仇恨言论做出裁决,并提供平衡的理由。即便代理立场的分布可能存在偏差,DICT阶段通过两名辩论者的辩论,确保少数观点得到代表,从而促进公平的辩论模拟。

算法2 DICT:基于不一致参考的辩论

输入:

- 文本 ttt

- 仇恨参考集合 h_Refh\_Refh_Ref

- 非仇恨参考集合 nh_Refnh\_Refnh_Ref

输出:

- 最终标签 labellabellabel

- 裁判理由 judge_reasonjudge\_reasonjudge_reason

步骤:

- 将五个代理分配到仇恨或非仇恨阵营;

- 辩论者获取相应参考并进行第一轮辩论;

- 记录辩论历史;

- 第二轮辩论期间,辩论者可调整其立场;

- 裁判代理根据辩论历史做出最终决定,并提供理由;

- 返回最终标签和裁判理由。

附录E提供了框架中使用的实际提示词。

PREDICT框架的PRE和DICT两个阶段协同工作,以模拟多视角辩论,提高仇恨言论检测的泛化能力,同时在公平的基础上达成共识。

4 实验

4.1 实验设置

4.1.1 数据集

我们使用了韩国仇恨言论基准数据集——K-HATERS、K-MHaS、KOLD、KODORI和UnSmile——来实现和评估我们的框架:

- K-HATERS(Park等,2023a):包含192K条新闻评论的仇恨言论检测语料库,每条评论根据目标特定的冒犯程度进行三点李克特(Likert)量表评分。

- K-MHaS(Lee等,2022):包含109K条来自在线新闻的多标签仇恨言论数据集,分为八个类别。

- KOLD(Jeong等,2022):包含40.4K条来自在线平台的评论,采用分层注释以识别针对个人或群体的冒犯性语言。

- KODORI(Park等,2023b):包含39.5K条来自在线社区和新闻的评论,标注了冒犯性、辱骂性和情感标签。

- UnSmile(Kang等,2022):由35K条来自在线社区和新闻的评论组成的多标签仇恨言论数据集,涵盖七个类别。

在实验中,我们从每个测试数据集中随机选择共400条样本,其中200条为仇恨言论,200条为非仇恨言论。我们的采样方法基于以往关于LLM情境学习(in-context learning)的研究(Guo等,2023)。本文中,这些数据集分别被称为数据集A(K-HATERS)、数据集B(K-MHaS)、数据集C(KOLD)、数据集D(KODORI)和数据集E(UnSmile)(有关数据集的详细说明,请参见附录A)。

4.1.2 实现细节

在PRE阶段,我们使用OpenAI的“text-embedding-ada-002-v2”嵌入模型,为每个数据集的训练集构建向量数据库,以检索相似的上下文。我们采用了FAISS(Douze等,2023)作为向量数据库。五个代理均使用“gpt-3.5-turbo-0125”模型。为了验证在分配视角时立场和理由生成的一致性,每项实验重复五次,并使用Fleiss’ Kappa一致性评估指标。

在DICT阶段,我们使用基于规则的代理来接收针对每个角色定制的提示,主持代理使用预设文本,而两位辩论代理及裁判代理均使用“gpt-3.5-turbo-0125”模型。每项实验重复五次,并以均值和标准差作为评估指标。

4.2 PRE阶段的有效性与一致性

为了评估在PRE阶段分配“独立视角”(即标注标准、相似上下文)的有效性,我们进行了**同数据集(in-dataset)和跨数据集(cross-dataset)**评估。

- 同数据集评估:评估针对特定数据集优化的代理在其各自数据集上的仇恨言论检测准确性。

- 跨数据集评估:评估针对特定数据集优化的代理在其他数据集上的表现。

表1显示,每个代理在其对应的数据集上取得了最佳性能,这表明分配给Agents_A、_B、_C、_D和_E的视角(即标注标准、相似上下文)是有效的。另一方面,在未针对特定数据集优化的情况下,代理的性能普遍下降,有时甚至低于基线(Agent_Base),例如Agent_A在数据集B、C、D和E上的表现低于基线,表明专注于特定数据集特征会降低模型的泛化能力。

此外,我们通过Fleiss’ Kappa评估了各代理在相同文本上的一致性。括号内的Fleiss’ Kappa值表明所有代理的一致性均属于“接近完美”级别。五个代理的多数投票显示一致性较低,处于“公平”或“中等”一致性类别。这表明每个代理在保持各自视角的同时,能够一致地做出预测。

总而言之,我们通过实验验证了数据集之间视角差异对模型泛化能力的影响,并定量测量了五个代理之间的视角差异,证明了考虑多种标注标准以达成共识的多元化方法的必要性。

4.3 DICT在泛化中的有效性

在本节中,我们评估了我们提出的基于辩论的DICT方法在泛化仇恨言论检测中的有效性。

为了评估多代理辩论模拟的性能,我们与**非辩论方法(in-dataset)和多数投票方法(majority voting)**进行了比较:

- 非辩论方法(in-dataset): 使用PRE阶段每个数据集上表现最好的代理作为基线。

- 多数投票方法: 以五个代理中超过半数的投票结果决定最终标签。

表2的实验结果表明,**DICT(两轮辩论)**在所有公共基准数据集上均取得了最佳性能。相较之下,尽管使用了五个代理,多数投票方法在除数据集E之外的所有数据集上的性能均低于非辩论方法。这定量证明了在未充分考虑数据集视角差异的情况下,多数投票方法的局限性。

为评估允许辩论者更改观点的效果,我们对比了仅执行第一轮辩论与执行两轮辩论的实验结果:

- 第一种情况(仅第1轮)在某些情况下表现不及非辩论或多数投票方法,说明辩论者在第1轮中可能仅关注自身立场,未充分考虑对方意见。

- 第二种情况(第1轮+第2轮)显著提高了性能,这可能是由于在第2轮中,辩论者纠正了第一轮可能存在的多数偏见,从而帮助裁判做出更准确的决定。

图4提供了一个案例,展示了我们的方法如何通过充分反映少数意见来正确分类仇恨言论。在图4-(b)中,非仇恨立场的辩论者认可了其观点中被忽视的部分,并尊重对方的立场,这使得裁判代理能够做出更平衡的决策。此外,在图4-(c)中,裁判代理全面审查了双方的相互矛盾的观点,正确分类了仇恨言论并提供了平衡的理由。

实验结果表明,通过充分考虑不同视角并适当地反映少数意见,DICT显著提高了泛化性能。

5 讨论

5.1 社会科学研究的机遇

PREDICT 框架在社会科学研究中具有广泛的应用潜力,尤其是在仇恨言论等议题上。通过分配具有代表性的代理并构建交互环境,研究人员可以模拟复杂的社会互动和决策过程,从而识别出传统社会科学研究方法难以揭示的新行为模式和洞察。

PREDICT 框架可以进一步扩展,考虑在同一数据集中引入具有不同特征的多个代理。本研究仅考虑了来自单一数据集的代表性代理,并在相对简单的辩论条件下进行。然而,未来可以探索更广泛的多样性,例如:

- 增加代理的数量,

- 增加辩论阶段的数量,

- 调整代理、主持人和裁判的参与程度,

- 以及引入更复杂的辩论环境。

虽然在研究条件下不一定需要找到最优参数,但通过多样化代理和环境,PREDICT 框架可以为社会科学研究提供更多有趣的探索机会。

6 结论

本文提出了PREDICT 框架,这是一种新颖的基于多代理辩论模拟的方法,采用多元化方法来克服数据集之间的标注标准差异,以改进仇恨言论检测。

在五个基准数据集上的实验结果表明,PREDICT 在跨数据集评估中表现最佳,证明其通过整合多样化视角提高了泛化能力。

本研究的结果表明,PREDICT 不仅限于仇恨言论检测领域,还具有潜力应用于更广泛的社会科学研究,为结合大语言模型(LLM)的社会科学研究提供了新的发展方向。

4o