深度强化学习算法在金融交易决策中的优化应用【附数据】

金融数据分析与建模专家 金融科研助手 | 论文指导 | 模型构建

✨ 专业领域:

金融数据处理与分析

量化交易策略研究

金融风险建模

投资组合优化

金融预测模型开发

深度学习在金融中的应用

擅长工具:

Python/R/MATLAB量化分析

机器学习模型构建

金融时间序列分析

蒙特卡洛模拟

风险度量模型

金融论文指导

内容:

金融数据挖掘与处理

量化策略开发与回测

投资组合构建与优化

金融风险评估模型

期刊论文

✅ 具体问题可以私信或查看文章底部二维码

✅ 感恩科研路上每一位志同道合的伙伴!

(1)单资产交易任务中的深度强化学习算法改进

在单资产交易场景中,为克服现有强化学习算法存在的问题,做出了多方面的优化。

对于市场状态表示,进行了深入且全面的挖掘。通过构造多种特征,从价格走势、成交量变化、波动性指标等多个维度来描述市场状态,使得所构建的状态表示能够更精准地反映真实市场情况,为后续交易决策提供更可靠的依据。例如,不仅考虑资产的当前价格,还纳入了过去一段时间的价格均值、标准差,以及成交量的变化趋势等因素,以此来更细致地刻画市场的动态特征。

同时,提出了一种独特的考虑资产回撤的回报方程。传统的回报计算往往只关注资产的增值情况,而此回报方程将资产回撤纳入考量范围。在交易过程中,从市场环境中获取的回报信息被用于引导算法学习如何在训练阶段降低收益的回撤风险。这意味着算法在追求收益增长的同时,会更加谨慎地避免大幅回撤情况的发生,从而提升交易策略的稳定性和抗风险能力。

基于深度强化学习中的 DQN 算法,进一步提出了适用于单资产交易的改进算法。在神经网络的全连接层中创新性地加入服从高斯分布的噪声来驱动探索过程。相较于 DQN 算法原本采用的贪心探索策略,这种噪声驱动的探索方式能够更广泛地搜索策略空间,具有更好的探索效果。而且,网络中的噪声影响由一组特定参数进行控制,这组参数如同网络中的其他参数一样,通过梯度下降法进行学习和优化,使得噪声的添加更加智能和自适应,能够根据不同的市场情况灵活调整探索的力度和方向。

此外,还对加入噪声后的 DQN 算法中目标网络的更新模式进行了改进。在传统 DQN 算法中,目标网络的更新方式可能会导致目标值的不稳定,进而影响算法的学习效果。通过采用新的更新模式,能够生成更加稳定的目标值,使得算法在训练过程中能够更准确地逼近最优策略,提高交易决策的准确性和效率。

(2)金融资产配置任务中的深度强化学习算法优化

在金融资产配置这一复杂任务中,同样针对现有问题实施了一系列有效的改进措施。

首先,利用丰富的技术指标来完善市场状态表示。除了常见的价格、成交量等基本信息外,还引入了诸如移动平均线、相对强弱指标(RSI)、布林带等技术分析工具所产生的指标,从不同角度刻画市场的趋势、波动程度以及买卖信号等特征,使市场状态的描述更加全面和细致,为算法的决策提供更丰富的信息基础。

基于深度强化学习中的 DDPG 算法,提出了一种专门的金融资产配置算法。在该算法中,引入资产权重的熵作为正则项,这一举措具有多重意义。一方面,它鼓励算法在输出资产权重时将权重分散,避免过度集中在单个或少数几个资产上。这种分散化的配置方式有助于降低投资组合的整体风险,因为它减少了因个别资产表现不佳而对整个组合造成严重冲击的可能性。另一方面,熵的引入还可以作为 DDPG 算法探索机制的补充,引导算法在广阔的资产配置空间中进行更有效的探索,发现潜在的更优配置策略。

同时,在 DDPG 算法中引入优先经验回放机制。在算法的学习过程中,并非对所有的经验样本一视同仁地进行回放学习,而是将 TD 误差大的样本优先进行采样。TD 误差较大的样本往往蕴含着更多的学习价值,因为这些样本代表着算法当前预测与实际情况之间存在较大的偏差,通过优先学习这些样本,能够更快地纠正算法的错误,提升算法的学习效果和收敛速度,使得算法能够更高效地从历史经验中学习到优化资产配置的策略。

(3)算法的回测与效果评估

为验证基于 DQN 的单资产交易算法以及基于 DDPG 的金融资产配置算法的实际表现,在不同的市场环境中进行了全面的回测工作。

在回测过程中,精心选取了多个具有代表性的市场环境,涵盖了牛市、熊市以及震荡市等不同的市场走势情况,同时还考虑了不同的市场流动性、波动性水平等因素,以确保回测结果能够全面反映算法在各种实际可能遇到的市场条件下的性能表现。

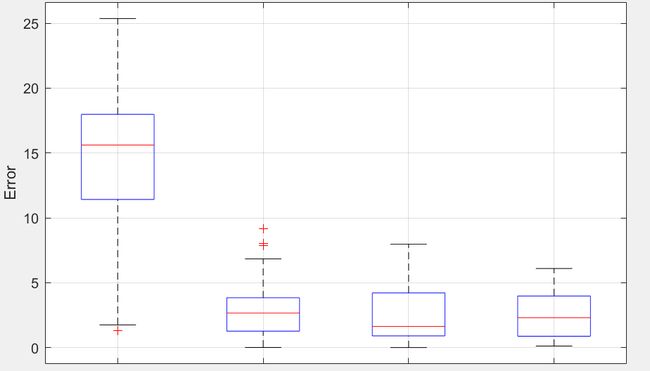

与多种传统的交易策略以及其他现有的对照策略进行了收益和风险方面的对比评估。在收益评估方面,两种改进后的交易算法均展现出显著的优势,其收益效果明显超过了其余对照策略。基于 DQN 的单资产交易算法在捕捉市场机会、优化交易时机选择等方面表现出色,通过精准的买卖决策实现了资产的稳健增值。而基于 DDPG 的金融资产配置算法则在多资产组合管理方面发挥了其优势,通过合理配置不同资产的权重,在不同市场环境下都能够实现较为可观的投资回报,有效提升了投资组合的整体收益水平。

在风险评估方面,基于 DDPG 的金融资产配置算法相比原始的 DDPG 算法取得了显著的进步。通过引入资产权重的熵作为正则项以及优先经验回放机制等优化措施,该算法成功降低了投资组合的风险水平。在面对市场波动时,能够更好地保持投资组合的稳定性,减少了因市场不确定性带来的资产价值大幅下跌的风险,使得投资组合的收益曲线更加平滑,回撤幅度明显减小,为投资者提供了更可靠的风险控制保障。

import numpy as np

import tensorflow as tf

# 定义 DQN 网络类

class DQN_Network(tf.keras.Model):

def __init__(self, input_dim, output_dim):

super(DQN_Network, self).__init__()

self.fc1 = tf.keras.layers.Dense(64, activation='relu', input_shape=(input_dim,))

self.fc2 = tf.keras.layers.Dense(64, activation='relu')

self.out = tf.keras.layers.Dense(output_dim)

def call(self, x):

x = self.fc1(x)

x = self.fc2(x)

return self.out(x)

# 定义基于 DQN 的单资产交易算法类

class DQN_Trading_Agent:

def __init__(self, input_dim, output_dim, learning_rate):

self.q_network = DQN_Network(input_dim, output_dim)

self.target_network = DQN_Network(input_dim, output_dim)

self.optimizer = tf.keras.optimizers.Adam(learning_rate)

self.gamma = 0.99 # 折扣因子

self.epsilon = 0.1 # 探索率

self.noise_stddev = 0.1 # 噪声标准差

def choose_action(self, state):

if np.random.rand() < self.epsilon:

# 探索:随机选择动作

return np.random.randint(0, 2)

else:

# 利用:选择 Q 值最大的动作

q_values = self.q_network(np.expand_dims(state, axis=0))

return np.argmax(q_values.numpy()[0])

def add_noise_to_action(self, action):

# 给动作添加噪声

if action == 0:

noisy_action = action - np.random.normal(0, self.noise_stddev)

else:

noisy_action = action + np.random.normal(0, self.noise_stddev)

return np.clip(noisy_action, 0, 1)

def train(self, batch_states, batch_actions, batch_next_states, batch_rewards, batch_dones):

with tf.GradientTape() as tape:

# 计算当前状态的 Q 值

q_values = self.q_network(batch_states)

q_action_values = tf.reduce_sum(q_values * tf.one_hot(batch_actions, depth=2), axis=1)

# 计算目标 Q 值

next_q_values = self.target_network(batch_next_states)

max_next_q_values = tf.reduce_max(next_q_values, axis=1)

target_q_values = batch_rewards + (1 - batch_dones) * self.gamma * max_next_q_values

# 计算损失

loss = tf.keras.losses.MSE(q_action_values, target_q_values)

# 计算梯度并更新网络参数

gradients = tape.gradient(loss, self.q_network.trainable_variables)

self.optimizer.apply_gradients(zip(gradients, self.q_network.trainable_variables))

def update_target_network(self):

# 更新目标网络参数

self.target_network.set_weights(self.q_network.get_weights())

# 主程序示例

if __name__ == "__main__":

# 假设市场状态维度为 5,交易动作维度为 2(买或卖)

input_dim = 5

output_dim = 2

learning_rate = 0.001

agent = DQN_Trading_Agent(input_dim, output_dim, learning_rate)

# 模拟训练数据

num_episodes = 100

for episode in range(num_episodes):

state = np.random.rand(input_dim) # 初始市场状态

done = False

while not done:

action = agent.choose_action(state)

noisy_action = agent.add_noise_to_action(action)

# 模拟执行动作后得到下一个状态、奖励和是否结束

next_state = np.random.rand(input_dim)

reward = np.random.rand()

done = np.random.rand() < 0.1

agent.train(np.expand_dims(state, axis=0), np.array([action]), np.expand_dims(next_state, axis=0),

np.array([reward]), np.array([done]))

state = next_state

if episode % 10 == 0:

agent.update_target_network()