卷积神经网络

全连接层的每一个结点都与上一层的所有结点相连,用来把前边提取到的特征综合起来。由于其全相连的特性,一般全连接层的参数也是最多的。通过将图像数据展平成一维向量而忽略了每张图像的空间结构信息。

全连接层在猫狗分类任务中的作用:在猫狗分类任务中,全连接层的主要作用是将卷积层和池化层提取到的特征图转化为最终的分类结果。

特征提取:卷积层通过卷积操作提取图像中的局部特征,池化层则通过下采样减少参数数量,降低计算复杂度。这些特征图被传递到全连接层。

分类决策:全连接层将这些特征图展平(flatten)后,通过一系列的权重矩阵和偏置项,最终输出一个概率分布,表示属于每个类别的概率。通常使用softmax函数将输出转换为概率值,从而得到最终的分类结果。

全连接层在猫狗分类任务中的重要性:全连接层在猫狗分类任务中至关重要,因为它负责将低维特征映射到高维空间,并进行最终的分类决策。通过调整全连接层的结构和参数,可以显著影响模型的分类性能。

卷积神经网络两个原则

平移不变性:不管检测对象出现在图像中的哪个位置,神经网络的前面几层都应该对相同的图像区域具有相似的反应。

局部性:神经网络的前面几层应该只探索输入图像中的局部区域,而不过度在意图像中相隔较远的区域的关系。

图像卷积

图像卷积运算是一种图像处理算法。通过它可以实现很多不同的效果。

- 卷积层总结:

卷积层将输入和卷积核进行交叉相关,加上偏移后得到输出核矩阵和偏移是可学习的参数核矩阵的大小是超参数。

填充:给定输入图像(32 x 32)应用5 x 5大小的卷积核 ,第1层得到输出大小28 x 28,第7层得到输出大小4 x 4,更大的卷积核可以更快地减小输出,形状从h×n_h×n_w减少到(h−h+1)×(−+1)(n_h-k_h+1)×(n_w-k_w+1)。

填充h行和wp_h 行和p_w列,则输出为:通常取h=h−1p_h=k_h-1;=−1p_w=k_w-1,通常填充元素是0。

步幅

给定输入大小224*224,在使用5*5卷积核的情况下,需要55层将输出降低到4*4 需要大量的计算。

填充和步幅的总结

填充和步幅可以改变输出的高度和宽度,填充在输入周围添加额外的行/列,增加输出的高度和宽度,步幅是每次滑动核窗口时的行/列的步长,可以成倍的减少输出形状,填充和步幅可用于有效地调整数据的维度。

多个输入和输出通道

彩色图像可能有 RGB 三个通道转换为灰度会丢失信息

每个通道都有一个卷积核,结果是所有通道卷积结果的和 。

池化层:池化层用于降低特征图的空间维度,减少计算量并增强模型的鲁棒性。常见的池化操作包括最大池化和平均池化。最大池化通过取局部区域的最大值来保留显著特征,而平均池化则通过计算局部区域的平均值来平滑特征。

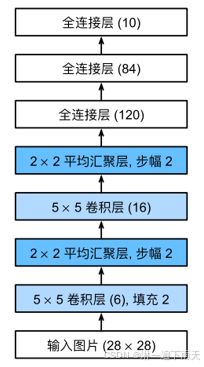

LeNet框架

LeNet(LeNet-5)由两个部分组成:卷积编码器:由两个卷积层组成; 全连接层密集块:由三个全连接层组成;每个卷积层使⽤5×5卷积核和一个sigmoid激活函数。

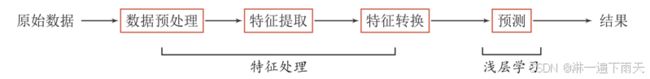

学习表征:

浅层学习:不涉及特征学习,其特征主要靠人工经验或特征转换方法来抽取。

表示学习:如果有一种算法可以自动地学习出有效的特征,并提高最终机器学习模型的性能,那么这种学习就可以叫作表示学习。

视觉分层理论

浅层卷积核提取:边缘、颜色、斑块等底层像素特征。

中层卷积核提取:条纹、纹路、形状等中层纹理特征。

高层卷积核提取:眼睛、轮胎、文字等高层语义特征。

AlexNet架构

AlexNet由⼋层组成:五个卷积层、两个全连接隐藏层和一个全连接输出层。

2. AlexNet使⽤ReLU⽽不是sigmoid作为其激活函数。

VGG网络

VGG网络通过重复使用3x3卷积核和2×2最大池化层构建了更深的卷积神经网络。

VGG-16和VGG-19是VGG网络的典型代表,分别包含16和19个卷积层。

本文总结

卷积神经网络(CNN)在图像识别领域十分出色。