伪分布式的hadoop配置

关于hadoop的发展和历史以及简介,这样的废话就不说,简而言之就一句话,开源的分布式云计算。

目前鄙人使用的是hadoop-1.0.4,下载地址:http://mirrors.cnnic.cn/apache/hadoop/common/hadoop-1.0.4/ 下载 hadoop-1.0.4.tar.gz 即可。

解压即可。

先对伪分布式的概念进行说明一下,整个环境的配置是基于linux的,目前鄙人使用的是redhat6企业版。

可以把伪分布式的Hadoop看做只有一个节点的集群,在这个集群中,这个节点既是Master,也是Slave;既是NameNode,也是DataNode;既是JobTracker,也是TaskTracker。

安装和配置Hadoop伪分布式有两个必要的条件,一个是JDK的环境,一个是linux SSH环境。其中SSH环境,最好配置为免密码登陆。(笑话:此处的SSH不是java里面的SSH框架,如果你是这么认为,我只能跟你说一句话:你很farmer。![]() )关于这两个环境的配置,这边就不一一讲解了,可以参照其他博文。

)关于这两个环境的配置,这边就不一一讲解了,可以参照其他博文。

下面开始来配置Hadoop:

1、进入conf文件夹,修改Hadoop-evn.sh,指定JDK

export JAVA_HOME=/opt/jdk1.6.0_43

2、配置HDFS的(Hadoop分布式文件系统)的地址和端口号

conf/core-site.xml:

<configuration>

<property>

<name>fs.default.name</name>

<value>hdfs://localhost:9000</value>

</property>

</configuration>

3、HDFS的默认备份方式是3,单机修改为1

conf/hdfs-site.xml

<configuration>

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

</configuration>

4、配置JobTracker的地址及端口,MapReduce的配置

conf/mapred-site.xml

<configuration>

<property>

<name>mapred.job.tracker</name>

<value>localhost:9001</value>

</property>

</configuration>

接下来就是启动Hadoop,先格式化HDFS。进入Hadoop文件夹,输入命令:bin/Hadoop namenode -format

启动Hadoop的命令:bin/start-all.sh

如果此处你没有配置SSH免密码登陆,需要你输入多次的用户密码。

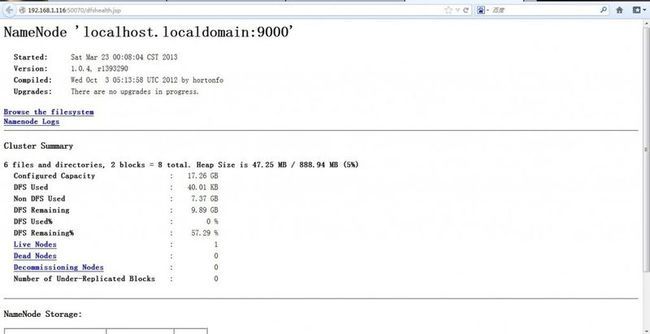

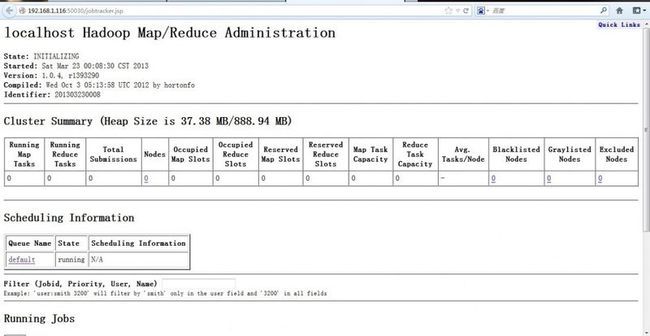

如果启动成功,你可以在浏览器下分别输入:

http://localhost:50030 为MapReduce的web页面

http://localhost:50070 为HDFS的web页面

如果都能查看,说明配置成功。