- MongoDB Oplog 窗口

喝醉酒的小白

MongoDB运维

在MongoDB中,oplog(操作日志)是一个特殊的日志系统,用于记录对数据库的所有写操作。oplog允许副本集成员(通常是从节点)应用主节点上已经执行的操作,从而保持数据的一致性。它是MongoDB副本集实现数据复制的基础。MongoDBOplog窗口oplog窗口是指在MongoDB副本集中,从节点可以用来同步数据的时间范围。这个窗口通常由以下因素决定:Oplog大小:oplog的大小是有限

- nosql数据库技术与应用知识点

皆过客,揽星河

NoSQLnosql数据库大数据数据分析数据结构非关系型数据库

Nosql知识回顾大数据处理流程数据采集(flume、爬虫、传感器)数据存储(本门课程NoSQL所处的阶段)Hdfs、MongoDB、HBase等数据清洗(入仓)Hive等数据处理、分析(Spark、Flink等)数据可视化数据挖掘、机器学习应用(Python、SparkMLlib等)大数据时代存储的挑战(三高)高并发(同一时间很多人访问)高扩展(要求随时根据需求扩展存储)高效率(要求读写速度快)

- 浅谈MapReduce

Android路上的人

Hadoop分布式计算mapreduce分布式框架hadoop

从今天开始,本人将会开始对另一项技术的学习,就是当下炙手可热的Hadoop分布式就算技术。目前国内外的诸多公司因为业务发展的需要,都纷纷用了此平台。国内的比如BAT啦,国外的在这方面走的更加的前面,就不一一列举了。但是Hadoop作为Apache的一个开源项目,在下面有非常多的子项目,比如HDFS,HBase,Hive,Pig,等等,要先彻底学习整个Hadoop,仅仅凭借一个的力量,是远远不够的。

- Hadoop

傲雪凌霜,松柏长青

后端大数据hadoop大数据分布式

ApacheHadoop是一个开源的分布式计算框架,主要用于处理海量数据集。它具有高度的可扩展性、容错性和高效的分布式存储与计算能力。Hadoop核心由四个主要模块组成,分别是HDFS(分布式文件系统)、MapReduce(分布式计算框架)、YARN(资源管理)和HadoopCommon(公共工具和库)。1.HDFS(HadoopDistributedFileSystem)HDFS是Hadoop生

- Hadoop架构

henan程序媛

hadoop大数据分布式

一、案列分析1.1案例概述现在已经进入了大数据(BigData)时代,数以万计用户的互联网服务时时刻刻都在产生大量的交互,要处理的数据量实在是太大了,以传统的数据库技术等其他手段根本无法应对数据处理的实时性、有效性的需求。HDFS顺应时代出现,在解决大数据存储和计算方面有很多的优势。1.2案列前置知识点1.什么是大数据大数据是指无法在一定时间范围内用常规软件工具进行捕捉、管理和处理的大量数据集合,

- 分享一个基于python的电子书数据采集与可视化分析 hadoop电子书数据分析与推荐系统 spark大数据毕设项目(源码、调试、LW、开题、PPT)

计算机源码社

Python项目大数据大数据pythonhadoop计算机毕业设计选题计算机毕业设计源码数据分析spark毕设

作者:计算机源码社个人简介:本人八年开发经验,擅长Java、Python、PHP、.NET、Node.js、Android、微信小程序、爬虫、大数据、机器学习等,大家有这一块的问题可以一起交流!学习资料、程序开发、技术解答、文档报告如需要源码,可以扫取文章下方二维码联系咨询Java项目微信小程序项目Android项目Python项目PHP项目ASP.NET项目Node.js项目选题推荐项目实战|p

- 5-【JavaWeb】JUnit 单元测试及JUL 日志系统

weixin_44329069

JavaWebjunit单元测试

1.使用JUnit进行单元测试JUnit是Java中非常流行的单元测试框架,MyBatis与JUnit可以很好地结合,来测试持久层代码的正确性。1.1添加JUnit依赖在使用JUnit之前,需要在pom.xml中引入JUnit依赖。junitjunit4.13.2test1.2单元测试基本结构假设我们要测试UserMapper中的getUserById方法,测试代码如下:importorg.apa

- hbase介绍

CrazyL-

云计算+大数据hbase

hbase是一个分布式的、多版本的、面向列的开源数据库hbase利用hadoophdfs作为其文件存储系统,提供高可靠性、高性能、列存储、可伸缩、实时读写、适用于非结构化数据存储的数据库系统hbase利用hadoopmapreduce来处理hbase、中的海量数据hbase利用zookeeper作为分布式系统服务特点:数据量大:一个表可以有上亿行,上百万列(列多时,插入变慢)面向列:面向列(族)的

- Flume:大规模日志收集与数据传输的利器

傲雪凌霜,松柏长青

后端大数据flume大数据

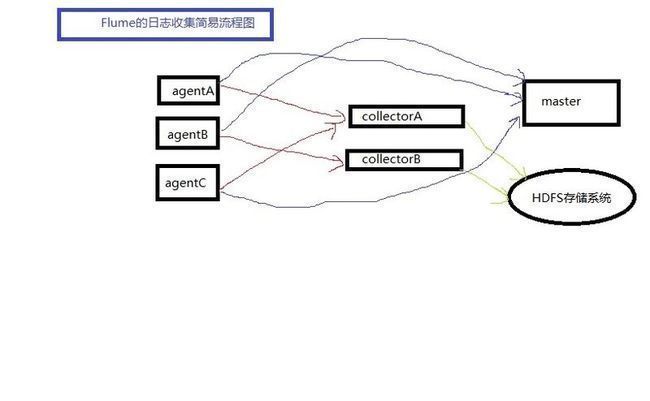

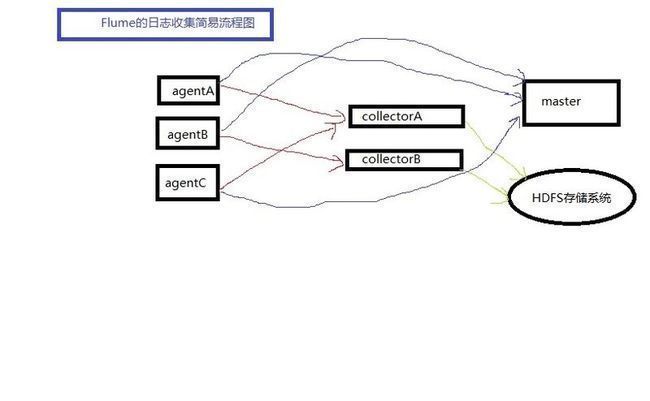

Flume:大规模日志收集与数据传输的利器在大数据时代,随着各类应用的不断增长,产生了海量的日志和数据。这些数据不仅对业务的健康监控至关重要,还可以通过深入分析,帮助企业做出更好的决策。那么,如何高效地收集、传输和存储这些海量数据,成为了一项重要的挑战。今天我们将深入探讨ApacheFlume,它是如何帮助我们应对这些挑战的。一、Flume概述ApacheFlume是一个分布式、可靠、可扩展的日志

- 大数据毕业设计hadoop+spark+hive知识图谱租房数据分析可视化大屏 租房推荐系统 58同城租房爬虫 房源推荐系统 房价预测系统 计算机毕业设计 机器学习 深度学习 人工智能

2401_84572577

程序员大数据hadoop人工智能

做了那么多年开发,自学了很多门编程语言,我很明白学习资源对于学一门新语言的重要性,这些年也收藏了不少的Python干货,对我来说这些东西确实已经用不到了,但对于准备自学Python的人来说,或许它就是一个宝藏,可以给你省去很多的时间和精力。别在网上瞎学了,我最近也做了一些资源的更新,只要你是我的粉丝,这期福利你都可拿走。我先来介绍一下这些东西怎么用,文末抱走。(1)Python所有方向的学习路线(

- Spark集群的三种模式

MelodyYN

#Sparksparkhadoopbigdata

文章目录1、Spark的由来1.1Hadoop的发展1.2MapReduce与Spark对比2、Spark内置模块3、Spark运行模式3.1Standalone模式部署配置历史服务器配置高可用运行模式3.2Yarn模式安装部署配置历史服务器运行模式4、WordCount案例1、Spark的由来定义:Hadoop主要解决,海量数据的存储和海量数据的分析计算。Spark是一种基于内存的快速、通用、可

- 月度总结 | 2022年03月 | 考研与就业的抉择 | 确定未来走大数据开发路线

「已注销」

个人总结hadoop

一、时间线梳理3月3日,寻找到同专业的就业伙伴3月5日,着手准备Java八股文,决定先走Java后端路线3月8月,申请到了校图书馆的考研专座,决定暂时放弃就业,先准备考研,买了数学和408的资料书3月9日-3月13日,因疫情原因,宿舍区暂封,这段时间在准备考研,发现内容特别多3月13日-3月19日,大部分时间在刷Hadoop、Zookeeper、Kafka的视频,同时在准备实习的项目3月20日,退

- HBase介绍

mingyu1016

数据库

概述HBase是一个分布式的、面向列的开源数据库,源于google的一篇论文《bigtable:一个结构化数据的分布式存储系统》。HBase是GoogleBigtable的开源实现,它利用HadoopHDFS作为其文件存储系统,利用HadoopMapReduce来处理HBase中的海量数据,利用Zookeeper作为协同服务。HBase的表结构HBase以表的形式存储数据。表有行和列组成。列划分为

- Java中的大数据处理框架对比分析

省赚客app开发者

java开发语言

Java中的大数据处理框架对比分析大家好,我是微赚淘客系统3.0的小编,是个冬天不穿秋裤,天冷也要风度的程序猿!今天,我们将深入探讨Java中常用的大数据处理框架,并对它们进行对比分析。大数据处理框架是现代数据驱动应用的核心,它们帮助企业处理和分析海量数据,以提取有价值的信息。本文将重点介绍ApacheHadoop、ApacheSpark、ApacheFlink和ApacheStorm这四种流行的

- Hadoop windows intelij 跑 MR WordCount

piziyang12138

一、软件环境我使用的软件版本如下:IntellijIdea2017.1Maven3.3.9Hadoop分布式环境二、创建maven工程打开Idea,file->new->Project,左侧面板选择maven工程。(如果只跑MapReduce创建java工程即可,不用勾选Creatfromarchetype,如果想创建web工程或者使用骨架可以勾选)image.png设置GroupId和Artif

- Hadoop学习第三课(HDFS架构--读、写流程)

小小程序员呀~

数据库hadoop架构bigdata

1.块概念举例1:一桶水1000ml,瓶子的规格100ml=>需要10个瓶子装完一桶水1010ml,瓶子的规格100ml=>需要11个瓶子装完一桶水1010ml,瓶子的规格200ml=>需要6个瓶子装完块的大小规格,只要是需要存储,哪怕一点点,也是要占用一个块的块大小的参数:dfs.blocksize官方默认的大小为128M官网:https://hadoop.apache.org/docs/r3.

- hadoop启动HDFS命令

m0_67401228

java搜索引擎linux后端

启动命令:/hadoop/sbin/start-dfs.sh停止命令:/hadoop/sbin/stop-dfs.sh

- springboot整合Logback

星空下夜猫子

springbootlogback后端

Logback介绍描述Logback是由log4j创始人设计的另外一种开源日志组件,性能比log4j要好。相对是一个可靠、通用、快速而又灵活的Java日志框架。Logback主要分三个模块1、logback-core:其他两个模块的基础模块2、logback-classic:它是log4j的一个改良版本,同时它完整实现了slf4j。API,可以很方便地更换成其它日志系统,如log4j或JDK14L

- 【计算机毕设-大数据方向】基于Hadoop的电商交易数据分析可视化系统的设计与实现

程序员-石头山

大数据实战案例大数据hadoop毕业设计毕设

博主介绍:✌全平台粉丝5W+,高级大厂开发程序员,博客之星、掘金/知乎/华为云/阿里云等平台优质作者。【源码获取】关注并且私信我【联系方式】最下边感兴趣的可以先收藏起来,同学门有不懂的毕设选题,项目以及论文编写等相关问题都可以和学长沟通,希望帮助更多同学解决问题前言随着电子商务行业的迅猛发展,电商平台积累了海量的数据资源,这些数据不仅包括用户的基本信息、购物记录,还包括用户的浏览行为、评价反馈等多

- 分布式离线计算—Spark—基础介绍

测试开发abbey

人工智能—大数据

原文作者:饥渴的小苹果原文地址:【Spark】Spark基础教程目录Spark特点Spark相对于Hadoop的优势Spark生态系统Spark基本概念Spark结构设计Spark各种概念之间的关系Executor的优点Spark运行基本流程Spark运行架构的特点Spark的部署模式Spark三种部署方式Hadoop和Spark的统一部署摘要:Spark是基于内存计算的大数据并行计算框架Spar

- spark常用命令

我是浣熊的微笑

spark

查看报错日志:yarnlogsapplicationIDspark2-submit--masteryarn--classcom.hik.ReadHdfstest-1.0-SNAPSHOT.jar进入$SPARK_HOME目录,输入bin/spark-submit--help可以得到该命令的使用帮助。hadoop@wyy:/app/hadoop/spark100$bin/spark-submit--

- spark启动命令

学不会又听不懂

spark大数据分布式

hadoop启动:cd/root/toolssstart-dfs.sh,只需在hadoop01上启动stop-dfs.sh日志查看:cat/root/toolss/hadoop/logs/hadoop-root-datanode-hadoop03.outzookeeper启动:cd/root/toolss/zookeeperbin/zkServer.shstart,三台都要启动bin/zkServ

- 编程常用命令总结

Yellow0523

LinuxBigData大数据

编程命令大全1.软件环境变量的配置JavaScalaSparkHadoopHive2.大数据软件常用命令Spark基本命令Spark-SQL命令Hive命令HDFS命令YARN命令Zookeeper命令kafka命令Hibench命令MySQL命令3.Linux常用命令Git命令conda命令pip命令查看Linux系统的详细信息查看Linux系统架构(X86还是ARM,两种方法都可)端口号命令L

- Hadoop常见面试题整理及解答

叶青舟

Linuxhdfs大数据hadooplinux

Hadoop常见面试题整理及解答一、基础知识篇:1.把数据仓库从传统关系型数据库转到hadoop有什么优势?答:(1)关系型数据库成本高,且存储空间有限。而Hadoop使用较为廉价的机器存储数据,且Hadoop可以将大量机器构建成一个集群,并在集群中使用HDFS文件系统统一管理数据,极大的提高了数据的存储及处理能力。(2)关系型数据库仅支持标准结构化数据格式,Hadoop不仅支持标准结构化数据格式

- 2025毕业设计指南:如何用Hadoop构建超市进货推荐系统?大数据分析助力精准采购

计算机编程指导师

Java实战集Python实战集大数据实战集课程设计hadoop数据分析springbootjava进货python

✍✍计算机编程指导师⭐⭐个人介绍:自己非常喜欢研究技术问题!专业做Java、Python、小程序、安卓、大数据、爬虫、Golang、大屏等实战项目。⛽⛽实战项目:有源码或者技术上的问题欢迎在评论区一起讨论交流!⚡⚡Java实战|SpringBoot/SSMPython实战项目|Django微信小程序/安卓实战项目大数据实战项目⚡⚡文末获取源码文章目录⚡⚡文末获取源码基于hadoop的超市进货推荐系

- Hadoop Common 之序列化机制小解

猫君之上

#ApacheHadoop

1.JavaSerializable序列化该序列化通过ObjectInputStream的readObject实现序列化,ObjectOutputStream的writeObject实现反序列化。这不过此种序列化虽然跨病态兼容性强,但是因为存储过多的信息,但是传输效率比较低,所以hadoop弃用它。(序列化信息包括这个对象的类,类签名,类的所有静态,费静态成员的值,以及他们父类都要被写入)publ

- 深入理解hadoop(一)----Common的实现----Configuration

maoxiao_jsd

深入理解----hadoop

属本人个人原创,转载请注明,希望对大家有帮助!!一,hadoop的配置管理a,hadoop通过独有的Configuration处理配置信息Configurationconf=newConfiguration();conf.addResource("core-default.xml");conf.addResource("core-site.xml");后者会覆盖前者中未final标记的相同配置项b

- Log4j日志脱敏记录一下

IAmZRH

JAVAjavalog4j

前言在项目上线环境中,需要记录程序运行时产生的各种错误信息、状态信息、调试信息、执行时间记录等日志信息。可以用于查找问题、定位数据等等操作。日志的具体实现可以有log4j和logback等,这里我们使用SLF4J作为日志系统的实现。使用SLF4J使用idea工具可以安装lombok插件,并引入maven包:org.projectlomboklombok1.18.4在需要打印日志的类上增加@Slf4

- 集成 Logrus 到 Gin:打造高效的 Go Web 日志系统

好奇的菜鸟

Gingingolang前端

在Go语言的Web开发中,Gin是一个轻量级且高性能的Web框架,而Logrus则是一个非常流行的日志库,它提供了结构化的日志记录功能。将Logrus集成到Gin框架中,可以极大地增强你的Web应用程序的日志管理能力。本文将详细介绍如何在Gin中集成Logrus,并创建一个自定义的日志记录中间件。Gin与Logrus:为什么集成?Gin框架自带的日志系统虽然简单易用,但功能相对有限。Logrus提

- hadoop 0.22.0 部署笔记

weixin_33701564

大数据java运维

为什么80%的码农都做不了架构师?>>>因为需要使用hbase,所以开始对hbase进行学习。hbase是部署在hadoop平台上的NOSql数据库,因此在部署hbase之前需要先部署hadoop。环境:redhat5、hadoop-0.22.0.tar.gz、jdk-6u13-linux-i586.zipip192.168.1.128hostname:localhost.localdomain(

- java线程的无限循环和退出

3213213333332132

java

最近想写一个游戏,然后碰到有关线程的问题,网上查了好多资料都没满足。

突然想起了前段时间看的有关线程的视频,于是信手拈来写了一个线程的代码片段。

希望帮助刚学java线程的童鞋

package thread;

import java.text.SimpleDateFormat;

import java.util.Calendar;

import java.util.Date

- tomcat 容器

BlueSkator

tomcatWebservlet

Tomcat的组成部分 1、server

A Server element represents the entire Catalina servlet container. (Singleton) 2、service

service包括多个connector以及一个engine,其职责为处理由connector获得的客户请求。

3、connector

一个connector

- php递归,静态变量,匿名函数使用

dcj3sjt126com

PHP递归函数匿名函数静态变量引用传参

<!doctype html>

<html lang="en">

<head>

<meta charset="utf-8">

<title>Current To-Do List</title>

</head>

<body>

- 属性颜色字体变化

周华华

JavaScript

function changSize(className){

var diva=byId("fot")

diva.className=className;

}

</script>

<style type="text/css">

.max{

background: #900;

color:#039;

- 将properties内容放置到map中

g21121

properties

代码比较简单:

private static Map<Object, Object> map;

private static Properties p;

static {

//读取properties文件

InputStream is = XXX.class.getClassLoader().getResourceAsStream("xxx.properti

- [简单]拼接字符串

53873039oycg

字符串

工作中遇到需要从Map里面取值拼接字符串的情况,自己写了个,不是很好,欢迎提出更优雅的写法,代码如下:

import java.util.HashMap;

import java.uti

- Struts2学习

云端月影

最近开始关注struts2的新特性,从这个版本开始,Struts开始使用convention-plugin代替codebehind-plugin来实现struts的零配置。

配置文件精简了,的确是简便了开发过程,但是,我们熟悉的配置突然disappear了,真是一下很不适应。跟着潮流走吧,看看该怎样来搞定convention-plugin。

使用Convention插件,你需要将其JAR文件放

- Java新手入门的30个基本概念二

aijuans

java新手java 入门

基本概念: 1.OOP中唯一关系的是对象的接口是什么,就像计算机的销售商她不管电源内部结构是怎样的,他只关系能否给你提供电就行了,也就是只要知道can or not而不是how and why.所有的程序是由一定的属性和行为对象组成的,不同的对象的访问通过函数调用来完成,对象间所有的交流都是通过方法调用,通过对封装对象数据,很大限度上提高复用率。 2.OOP中最重要的思想是类,类是模板是蓝图,

- jedis 简单使用

antlove

javarediscachecommandjedis

jedis.RedisOperationCollection.java

package jedis;

import org.apache.log4j.Logger;

import redis.clients.jedis.Jedis;

import java.util.List;

import java.util.Map;

import java.util.Set;

pub

- PL/SQL的函数和包体的基础

百合不是茶

PL/SQL编程函数包体显示包的具体数据包

由于明天举要上课,所以刚刚将代码敲了一遍PL/SQL的函数和包体的实现(单例模式过几天好好的总结下再发出来);以便明天能更好的学习PL/SQL的循环,今天太累了,所以早点睡觉,明天继续PL/SQL总有一天我会将你永远的记载在心里,,,

函数;

函数:PL/SQL中的函数相当于java中的方法;函数有返回值

定义函数的

--输入姓名找到该姓名的年薪

create or re

- Mockito(二)--实例篇

bijian1013

持续集成mockito单元测试

学习了基本知识后,就可以实战了,Mockito的实际使用还是比较麻烦的。因为在实际使用中,最常遇到的就是需要模拟第三方类库的行为。

比如现在有一个类FTPFileTransfer,实现了向FTP传输文件的功能。这个类中使用了a

- 精通Oracle10编程SQL(7)编写控制结构

bijian1013

oracle数据库plsql

/*

*编写控制结构

*/

--条件分支语句

--简单条件判断

DECLARE

v_sal NUMBER(6,2);

BEGIN

select sal into v_sal from emp

where lower(ename)=lower('&name');

if v_sal<2000 then

update emp set

- 【Log4j二】Log4j属性文件配置详解

bit1129

log4j

如下是一个log4j.properties的配置

log4j.rootCategory=INFO, stdout , R

log4j.appender.stdout=org.apache.log4j.ConsoleAppender

log4j.appender.stdout.layout=org.apache.log4j.PatternLayout

log4j.appe

- java集合排序笔记

白糖_

java

public class CollectionDemo implements Serializable,Comparable<CollectionDemo>{

private static final long serialVersionUID = -2958090810811192128L;

private int id;

private String nam

- java导致linux负载过高的定位方法

ronin47

定位java进程ID

可以使用top或ps -ef |grep java

![图片描述][1]

根据进程ID找到最消耗资源的java pid

比如第一步找到的进程ID为5431

执行

top -p 5431 -H

![图片描述][2]

打印java栈信息

$ jstack -l 5431 > 5431.log

在栈信息中定位具体问题

将消耗资源的Java PID转

- 给定能随机生成整数1到5的函数,写出能随机生成整数1到7的函数

bylijinnan

函数

import java.util.ArrayList;

import java.util.List;

import java.util.Random;

public class RandNFromRand5 {

/**

题目:给定能随机生成整数1到5的函数,写出能随机生成整数1到7的函数。

解法1:

f(k) = (x0-1)*5^0+(x1-

- PL/SQL Developer保存布局

Kai_Ge

近日由于项目需要,数据库从DB2迁移到ORCAL,因此数据库连接客户端选择了PL/SQL Developer。由于软件运用不熟悉,造成了很多麻烦,最主要的就是进入后,左边列表有很多选项,自己删除了一些选项卡,布局很满意了,下次进入后又恢复了以前的布局,很是苦恼。在众多PL/SQL Developer使用技巧中找到如下这段:

&n

- [未来战士计划]超能查派[剧透,慎入]

comsci

计划

非常好看,超能查派,这部电影......为我们这些热爱人工智能的工程技术人员提供一些参考意见和思想........

虽然电影里面的人物形象不是非常的可爱....但是非常的贴近现实生活....

&nbs

- Google Map API V2

dai_lm

google map

以后如果要开发包含google map的程序就更麻烦咯

http://www.cnblogs.com/mengdd/archive/2013/01/01/2841390.html

找到篇不错的文章,大家可以参考一下

http://blog.sina.com.cn/s/blog_c2839d410101jahv.html

1. 创建Android工程

由于v2的key需要G

- java数据计算层的几种解决方法2

datamachine

javasql集算器

2、SQL

SQL/SP/JDBC在这里属于一类,这是老牌的数据计算层,性能和灵活性是它的优势。但随着新情况的不断出现,单纯用SQL已经难以满足需求,比如: JAVA开发规模的扩大,数据量的剧增,复杂计算问题的涌现。虽然SQL得高分的指标不多,但都是权重最高的。

成熟度:5星。最成熟的。

- Linux下Telnet的安装与运行

dcj3sjt126com

linuxtelnet

Linux下Telnet的安装与运行 linux默认是使用SSH服务的 而不安装telnet服务 如果要使用telnet 就必须先安装相应的软件包 即使安装了软件包 默认的设置telnet 服务也是不运行的 需要手工进行设置 如果是redhat9,则在第三张光盘中找到 telnet-server-0.17-25.i386.rpm

- PHP中钩子函数的实现与认识

dcj3sjt126com

PHP

假如有这么一段程序:

function fun(){

fun1();

fun2();

}

首先程序执行完fun1()之后执行fun2()然后fun()结束。

但是,假如我们想对函数做一些变化。比如说,fun是一个解析函数,我们希望后期可以提供丰富的解析函数,而究竟用哪个函数解析,我们希望在配置文件中配置。这个时候就可以发挥钩子的力量了。

我们可以在fu

- EOS中的WorkSpace密码修改

蕃薯耀

修改WorkSpace密码

EOS中BPS的WorkSpace密码修改

>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>

蕃薯耀 201

- SpringMVC4零配置--SpringSecurity相关配置【SpringSecurityConfig】

hanqunfeng

SpringSecurity

SpringSecurity的配置相对来说有些复杂,如果是完整的bean配置,则需要配置大量的bean,所以xml配置时使用了命名空间来简化配置,同样,spring为我们提供了一个抽象类WebSecurityConfigurerAdapter和一个注解@EnableWebMvcSecurity,达到同样减少bean配置的目的,如下:

applicationContex

- ie 9 kendo ui中ajax跨域的问题

jackyrong

AJAX跨域

这两天遇到个问题,kendo ui的datagrid,根据json去读取数据,然后前端通过kendo ui的datagrid去渲染,但很奇怪的是,在ie 10,ie 11,chrome,firefox等浏览器中,同样的程序,

浏览起来是没问题的,但把应用放到公网上的一台服务器,

却发现如下情况:

1) ie 9下,不能出现任何数据,但用IE 9浏览器浏览本机的应用,却没任何问题

- 不要让别人笑你不能成为程序员

lampcy

编程程序员

在经历六个月的编程集训之后,我刚刚完成了我的第一次一对一的编码评估。但是事情并没有如我所想的那般顺利。

说实话,我感觉我的脑细胞像被轰炸过一样。

手慢慢地离开键盘,心里很压抑。不禁默默祈祷:一切都会进展顺利的,对吧?至少有些地方我的回答应该是没有遗漏的,是不是?

难道我选择编程真的是一个巨大的错误吗——我真的永远也成不了程序员吗?

我需要一点点安慰。在自我怀疑,不安全感和脆弱等等像龙卷风一

- 马皇后的贤德

nannan408

马皇后不怕朱元璋的坏脾气,并敢理直气壮地吹耳边风。众所周知,朱元璋不喜欢女人干政,他认为“后妃虽母仪天下,然不可使干政事”,因为“宠之太过,则骄恣犯分,上下失序”,因此还特地命人纂述《女诫》,以示警诫。但马皇后是个例外。

有一次,马皇后问朱元璋道:“如今天下老百姓安居乐业了吗?”朱元璋不高兴地回答:“这不是你应该问的。”马皇后振振有词地回敬道:“陛下是天下之父,

- 选择某个属性值最大的那条记录(不仅仅包含指定属性,而是想要什么属性都可以)

Rainbow702

sqlgroup by最大值max最大的那条记录

好久好久不写SQL了,技能退化严重啊!!!

直入主题:

比如我有一张表,file_info,

它有两个属性(但实际不只,我这里只是作说明用):

file_code, file_version

同一个code可能对应多个version

现在,我想针对每一个code,取得它相关的记录中,version 值 最大的那条记录,

SQL如下:

select

*

- VBScript脚本语言

tntxia

VBScript

VBScript 是基于VB的脚本语言。主要用于Asp和Excel的编程。

VB家族语言简介

Visual Basic 6.0

源于BASIC语言。

由微软公司开发的包含协助开发环境的事

- java中枚举类型的使用

xiao1zhao2

javaenum枚举1.5新特性

枚举类型是j2se在1.5引入的新的类型,通过关键字enum来定义,常用来存储一些常量.

1.定义一个简单的枚举类型

public enum Sex {

MAN,

WOMAN

}

枚举类型本质是类,编译此段代码会生成.class文件.通过Sex.MAN来访问Sex中的成员,其返回值是Sex类型.

2.常用方法

静态的values()方