V4L2编程和Camera开发相关

近期开始接触Camera相关的开发内容,在调试一款USB摄像头的时候遇到了USB插拔的一点问题和Camera的相关问题,记录下log留待分析。

[74805.415912] vmap allocation for size 2101248 failed: use vmalloc=<size> to increase size.

[74807.131133] >>>signal:-57,signal_strength:75

[74808.543453] ==13==> hub_port_init 1

[74808.547795] Plug in USB Port1

[74808.733436] usb 3-1: new high speed USB device number 2 using Mstar-ehci-1

[74809.222883] uvcvideo: Found UVC 1.00 device 5811_Car_OV9712 (0c45:6366)

[74809.238832] uvcvideo: Failed to query (133) UVC control 1 (unit 4) : -32 (exp. 2).

[74809.328259] uvcvideo: Failed to query (133) UVC control 7 (unit 4) : -32 (exp. 2).

查过资料说是UVC的万能驱动程序有问题,具体暂时不知道问题所在。这个问题的现象是USB摄像头在Camera对象已经初始化成功一次后,突然断开连接,此时Camera对象并未释放,第二次调用的时候Camera还默认是上次的调用对象,但是此时实际已经没有USB设备了。因此提示了设备没打开,然后再次连接USB设备后发现此时,原来的设备video0已经不存在了,识别出了video2和video3两个设备。

log显示I/V4L2Camera( 7588): Open: /dev/video2

I/H264Camera( 7588): Open: /dev/video2

I/V4L2Camera( 7588): Camera Parameters to set width:1280 height:720 pixelformat:875967048

E/V4L2Camera( 7588): Open: VIDIOC_TRY_FMT Failed(-1): Invalid argument

I/H264Camera( 7588): setParameters w:640 h:480 pixelformat:875967048

E/H264Camera( 7588): setParameters: VIDIOC_S_FMT Failed(-1): Device or resource busy

这个时候看到的是打开设备出现了问题,之前初始化的对象不能用,新的设备打不开,因此应用检测不到设备也就无法再启用了。

大概猜测是USB驱动的热插拔存在问题,不能及时更新设备导致的。具体准确的有待研究。

因为网上找资料研究Camera的调用流程和驱动部分,因此分享下找到的资料。

首先是最新接触到的V4L2的资料,结合代码初略的看了一部分。提前声明下此部分为转载自别人的博客内容,仅为分享总结。

一.什么是video4linux

Video4linux2(简称V4L2),是linux中关于视频设备的内核驱动。在Linux中,视频设备是设备文件,可以像访问普通文件一样对其进行读写,摄像头在/dev/video0下。

二.一般操作流程(视频设备):

1.打开设备文件。 int fd=open(”/dev/video0″,O_RDWR);

2.取得设备的capability,看看设备具有什么功能,比如是否具有视频输入,或者音频输入输出等。VIDIOC_QUERYCAP,struct v4l2_capability

3.设置视频的制式和帧格式,制式包括PAL,NTSC,帧的格式个包括宽度和高度等。

VIDIOC_S_STD,VIDIOC_S_FMT,struct v4l2_std_id,struct v4l2_format

4.向驱动申请帧缓冲,一般不超过5个。struct v4l2_requestbuffers

5.将申请到的帧缓冲映射到用户空间,这样就可以直接操作采集到的帧了,而不必去复制。mmap

6.将申请到的帧缓冲全部入队列,以便存放采集到的数据.VIDIOC_QBUF,struct v4l2_buffer

7.开始视频的采集。VIDIOC_STREAMON

8.出队列以取得已采集数据的帧缓冲,取得原始采集数据。VIDIOC_DQBUF

9.将缓冲重新入队列尾,这样可以循环采集。VIDIOC_QBUF

10.停止视频的采集。VIDIOC_STREAMOFF

11.关闭视频设备。close(fd);

三、常用的结构体(参见/usr/include/linux/videodev2.h):

struct v4l2_requestbuffers reqbufs;//向驱动申请帧缓冲的请求,里面包含申请的个数

struct v4l2_capability cap;//这个设备的功能,比如是否是视频输入设备

struct v4l2_standard std;//视频的制式,比如PAL,NTSC

struct v4l2_format fmt;//帧的格式,比如宽度,高度等

struct v4l2_buffer buf;//代表驱动中的一帧

v4l2_std_id stdid;//视频制式,例如:V4L2_STD_PAL_B

struct v4l2_queryctrl query;//查询的控制

struct v4l2_control control;//具体控制的值

下面具体说明开发流程(网上找的)

打开视频设备

在V4L2中,视频设备被看做一个文件。使用open函数打开这个设备:

//用非阻塞模式打开摄像头设备

intcameraFd;

cameraFd= open(“/dev/video0″, O_RDWR| O_NONBLOCK, 0);

//如果用阻塞模式打开摄像头设备,上述代码变为:

//cameraFd = open(”/dev/video0″, O_RDWR, 0);

关于阻塞模式和非阻塞模式

应用程序能够使用阻塞模式或非阻塞模式打开视频设备,如果使用非阻塞模式调用视频设备,即使尚未捕获到信息,驱动依旧会把缓存(DQBUFF)里的东西返回给应用程序。

设定属性及采集方式

打开视频设备后,可以设置该视频设备的属性,例如裁剪、缩放等。这一步是可选的。在Linux编程中,一般使用ioctl函数来对设备的I/O通道进行管理:

extern intioctl(int__fd, unsigned long int__request, …) __THROW;

__fd:设备的ID,例如刚才用open函数打开视频通道后返回的cameraFd;

__request:具体的命令标志符。

在进行V4L2开发中,一般会用到以下的命令标志符:

1 VIDIOC_REQBUFS:分配内存

2 VIDIOC_QUERYBUF:把VIDIOC_REQBUFS中分配的数据缓存转换成物理地址

3 VIDIOC_QUERYCAP:查询驱动功能

4 VIDIOC_ENUM_FMT:获取当前驱动支持的视频格式

5 VIDIOC_S_FMT:设置当前驱动的频捕获格式

6 VIDIOC_G_FMT:读取当前驱动的频捕获格式

7 VIDIOC_TRY_FMT:验证当前驱动的显示格式

8 VIDIOC_CROPCAP:查询驱动的修剪能力

9 VIDIOC_S_CROP:设置视频信号的边框

10 VIDIOC_G_CROP:读取视频信号的边框

11 VIDIOC_QBUF:把数据从缓存中读取出来

12 VIDIOC_DQBUF:把数据放回缓存队列

13 VIDIOC_STREAMON:开始视频显示函数

14 VIDIOC_STREAMOFF:结束视频显示函数

15 VIDIOC_QUERYSTD:检查当前视频设备支持的标准,例如PAL或NTSC。

这些IO调用,有些是必须的,有些是可选择的。

检查当前视频设备支持的标准

在亚洲,一般使用PAL(720X576)制式的摄像头,而欧洲一般使用NTSC(720X480),使用VIDIOC_QUERYSTD来检测:

v4l2_std_id std;

do{

ret= ioctl(fd, VIDIOC_QUERYSTD, &std);

} while(ret== -1 && errno== EAGAIN);

switch(std) {

caseV4L2_STD_NTSC:

//……

caseV4L2_STD_PAL:

//……

}

设置视频捕获格式

当检测完视频设备支持的标准后,还需要设定视频捕获格式:

structv4l2_format fmt;

memset( &fmt, 0, sizeof(fmt) );

fmt.type= V4L2_BUF_TYPE_VIDEO_CAPTURE;

fmt.fmt.pix.width= 720;

fmt.fmt.pix.height= 576;

fmt.fmt.pix.pixelformat= V4L2_PIX_FMT_YUYV;

fmt.fmt.pix.field= V4L2_FIELD_INTERLACED;

if(ioctl(fd, VIDIOC_S_FMT, &fmt) == -1) {

return-1;

}

v4l2_format结构体定义如下:

structv4l2_format

{

enumv4l2_buf_type type; //数据流类型,必须永远是//V4L2_BUF_TYPE_VIDEO_CAPTURE

union

{

structv4l2_pix_format pix;

structv4l2_window win;

structv4l2_vbi_format vbi;

__u8 raw_data[200];

} fmt;

};

structv4l2_pix_format

{

__u32 width; //宽,必须是16的倍数

__u32 height; //高,必须是16的倍数

__u32 pixelformat; //视频数据存储类型,例如是//YUV4:2:2还是RGB

enumv4l2_field field;

__u32 bytesperline;

__u32 sizeimage;

enumv4l2_colorspace colorspace;

__u32 priv;

};

分配内存

接下来可以为视频捕获分配内存:

structv4l2_requestbuffers req;

if(ioctl(fd, VIDIOC_REQBUFS, &req) == -1) {

return-1;

}

v4l2_requestbuffers定义如下:

structv4l2_requestbuffers

{

__u32 count; //缓存数量,也就是说在缓存队列里保持多少张照片

enumv4l2_buf_type type; //数据流类型,必须永远是V4L2_BUF_TYPE_VIDEO_CAPTURE

enumv4l2_memory memory; // V4L2_MEMORY_MMAP或 V4L2_MEMORY_USERPTR

__u32 reserved[2];

};

获取并记录缓存的物理空间

使用VIDIOC_REQBUFS,我们获取了req.count个缓存,下一步通过调用VIDIOC_QUERYBUF命令来获取这些缓存的地址,然后使用mmap函数转换成应用程序中的绝对地址,最后把这段缓存放入缓存队列:

typedef structVideoBuffer{

void*start;

size_t length;

} VideoBuffer;

VideoBuffer* buffers= calloc( req.count, sizeof(*buffers) );

structv4l2_buffer buf;

for(numBufs= 0; numBufs< req.count; numBufs++) {

memset( &buf, 0, sizeof(buf) );

buf.type= V4L2_BUF_TYPE_VIDEO_CAPTURE;

buf.memory= V4L2_MEMORY_MMAP;

buf.index= numBufs;

//读取缓存

if(ioctl(fd, VIDIOC_QUERYBUF, &buf) == -1) {

return-1;

}

buffers[numBufs].length= buf.length;

//转换成相对地址

buffers[numBufs].start= mmap(NULL, buf.length,

PROT_READ| PROT_WRITE,

MAP_SHARED,

fd, buf.m.offset);

if(buffers[numBufs].start== MAP_FAILED) {

return-1;

}

//放入缓存队列

if(ioctl(fd, VIDIOC_QBUF, &buf) == -1) {

return-1;

}

}

关于视频采集方式

操作系统一般把系统使用的内存划分成用户空间和内核空间,分别由应用程序管理和操作系统管理。应用程序可以直接访问内存的地址,而内核空间存放的是供内核访问的代码和数据,用户不能直接访问。v4l2捕获的数据,最初是存放在内核空间的,这意味着用户不能直接访问该段内存,必须通过某些手段来转换地址。

一共有三种视频采集方式:使用read、write方式;内存映射方式和用户指针模式。

read、write方式:在用户空间和内核空间不断拷贝数据,占用了大量用户内存空间,效率不高。

内存映射方式:把设备里的内存映射到应用程序中的内存控件,直接处理设备内存,这是一种有效的方式。上面的mmap函数就是使用这种方式。

用户指针模式:内存片段由应用程序自己分配。这点需要在v4l2_requestbuffers里将memory字段设置成V4L2_MEMORY_USERPTR。

处理采集数据

V4L2有一个数据缓存,存放req.count数量的缓存数据。数据缓存采用FIFO的方式,当应用程序调用缓存数据时,缓存队列将最先采集到的 视频数据缓存送出,并重新采集一张视频数据。这个过程需要用到两个ioctl命令,VIDIOC_DQBUF和VIDIOC_QBUF:

structv4l2_buffer buf;

memset(&buf,0,sizeof(buf));

buf.type=V4L2_BUF_TYPE_VIDEO_CAPTURE;

buf.memory=V4L2_MEMORY_MMAP;

buf.index=0;

//读取缓存

if(ioctl(cameraFd, VIDIOC_DQBUF, &buf) == -1)

{

return-1;

}

//…………视频处理算法

//重新放入缓存队列

if(ioctl(cameraFd, VIDIOC_QBUF, &buf) == -1) {

return-1;

}

关闭视频设备

使用close函数关闭一个视频设备

close(cameraFd)

还需要使用munmap方法。

下面是代码,加了一部分注释:

//#加了点注释

//#Rockie Cheng

#include

#include

#include

#include

#include

#include

#include

#include

#include

#include

#include

#include

#include

#include

#include

#include

#define CLEAR(x) memset (&(x), 0, sizeof (x))

struct buffer {

void * start;

size_t length;

};

static char * dev_name = "/dev/video0";//摄像头设备名

static int fd = -1;

struct buffer * buffers = NULL;

static unsigned int n_buffers = 0;

FILE *file_fd;

static unsigned long file_length;

static unsigned char *file_name;

//////////////////////////////////////////////////////

//获取一帧数据

//////////////////////////////////////////////////////

static int read_frame (void)

{

struct v4l2_buffer buf;

unsigned int i;

CLEAR (buf);

buf.type = V4L2_BUF_TYPE_VIDEO_CAPTURE;

buf.memory = V4L2_MEMORY_MMAP;

int ff = ioctl (fd, VIDIOC_DQBUF, &buf);

if(ff<0)

printf("failture\n"); //出列采集的帧缓冲

assert (buf.index < n_buffers);

printf ("buf.index dq is %d,\n",buf.index);

fwrite(buffers[buf.index].start, buffers[buf.index].length, 1, file_fd); //将其写入文件中

ff=ioctl (fd, VIDIOC_QBUF, &buf); //再将其入列

if(ff<0)

printf("failture VIDIOC_QBUF\n");

return 1;

}

int main (int argc,char ** argv)

{

struct v4l2_capability cap;

struct v4l2_format fmt;

unsigned int i;

enum v4l2_buf_type type;

file_fd = fopen("test-mmap.jpg", "w");//图片文件名

fd = open (dev_name, O_RDWR | O_NONBLOCK, 0);//打开设备

int ff=ioctl (fd, VIDIOC_QUERYCAP, &cap);//获取摄像头参数

if(ff<0)

printf("failture VIDIOC_QUERYCAP\n");

struct v4l2_fmtdesc fmt1;

int ret;

memset(&fmt1, 0, sizeof(fmt1));

fmt1.index = 0;

fmt1.type = V4L2_BUF_TYPE_VIDEO_CAPTURE;

while ((ret = ioctl(fd, VIDIOC_ENUM_FMT, &fmt1)) == 0)

{

fmt1.index++;

printf("{ pixelformat = '%c%c%c%c', description = '%s' }\n",

fmt1.pixelformat & 0xFF, (fmt1.pixelformat >> 8) & 0xFF,

(fmt1.pixelformat >> 16) & 0xFF, (fmt1.pixelformat >> 24) & 0xFF,

fmt1.description);

}

CLEAR (fmt);

fmt.type = V4L2_BUF_TYPE_VIDEO_CAPTURE;

fmt.fmt.pix.width = 640;

fmt.fmt.pix.height = 480;

fmt.fmt.pix.pixelformat = V4L2_PIX_FMT_JPEG;//V4L2_PIX_FMT_YUYV;//V4L2_PIX_FMT_YVU420;//V4L2_PIX_FMT_YUYV;

fmt.fmt.pix.field = V4L2_FIELD_INTERLACED;

ff = ioctl (fd, VIDIOC_S_FMT, &fmt); //设置图像格式

if(ff<0)

printf("failture VIDIOC_S_FMT\n");

file_length = fmt.fmt.pix.bytesperline * fmt.fmt.pix.height; //计算图片大小

struct v4l2_requestbuffers req;

CLEAR (req);

req.count = 1;

req.type = V4L2_BUF_TYPE_VIDEO_CAPTURE;

req.memory = V4L2_MEMORY_MMAP;

ioctl (fd, VIDIOC_REQBUFS, &req); //申请缓冲,count是申请的数量

if(ff<0)

printf("failture VIDIOC_REQBUFS\n");

if (req.count < 1)

printf("Insufficient buffer memory\n");

buffers = calloc (req.count, sizeof (*buffers));//内存中建立对应空间

for (n_buffers = 0; n_buffers < req.count; ++n_buffers)

{

struct v4l2_buffer buf; //驱动中的一帧

CLEAR (buf);

buf.type = V4L2_BUF_TYPE_VIDEO_CAPTURE;

buf.memory = V4L2_MEMORY_MMAP;

buf.index = n_buffers;

if (-1 == ioctl (fd, VIDIOC_QUERYBUF, &buf)) //映射用户空间

printf ("VIDIOC_QUERYBUF error\n");

buffers[n_buffers].length = buf.length;

buffers[n_buffers].start =

mmap (NULL , //通过mmap建立映射关系

buf.length,

PROT_READ | PROT_WRITE ,

MAP_SHARED ,

fd, buf.m.offset);

if (MAP_FAILED == buffers[n_buffers].start)

printf ("mmap failed\n");

}

for (i = 0; i < n_buffers; ++i)

{

struct v4l2_buffer buf;

CLEAR (buf);

buf.type = V4L2_BUF_TYPE_VIDEO_CAPTURE;

buf.memory = V4L2_MEMORY_MMAP;

buf.index = i;

if (-1 == ioctl (fd, VIDIOC_QBUF, &buf))//申请到的缓冲进入列队

printf ("VIDIOC_QBUF failed\n");

}

type = V4L2_BUF_TYPE_VIDEO_CAPTURE;

if (-1 == ioctl (fd, VIDIOC_STREAMON, &type)) //开始捕捉图像数据

printf ("VIDIOC_STREAMON failed\n");

for (;;) //这一段涉及到异步IO

{

fd_set fds;

struct timeval tv;

int r;

FD_ZERO (&fds);//将指定的文件描述符集清空

FD_SET (fd, &fds);//在文件描述符集合中增加一个新的文件描述符

tv.tv_sec = 2;

tv.tv_usec = 0;

r = select (fd + 1, &fds, NULL, NULL, &tv);//判断是否可读(即摄像头是否准备好),tv是定时

if (-1 == r) {

if (EINTR == errno)

continue;

printf ("select err\n");

}

if (0 == r) {

fprintf (stderr, "select timeout\n");

exit (EXIT_FAILURE);

}

if (read_frame ())//如果可读,执行read_frame ()函数,并跳出循环

break;

}

unmap:

for (i = 0; i < n_buffers; ++i)

if (-1 == munmap (buffers[i].start, buffers[i].length))

printf ("munmap error");

type = V4L2_BUF_TYPE_VIDEO_CAPTURE;

if (-1 == ioctl(fd, VIDIOC_STREAMOFF, &type))

printf("VIDIOC_STREAMOFF");

close (fd);

fclose (file_fd);

exit (EXIT_SUCCESS);

return 0;

}

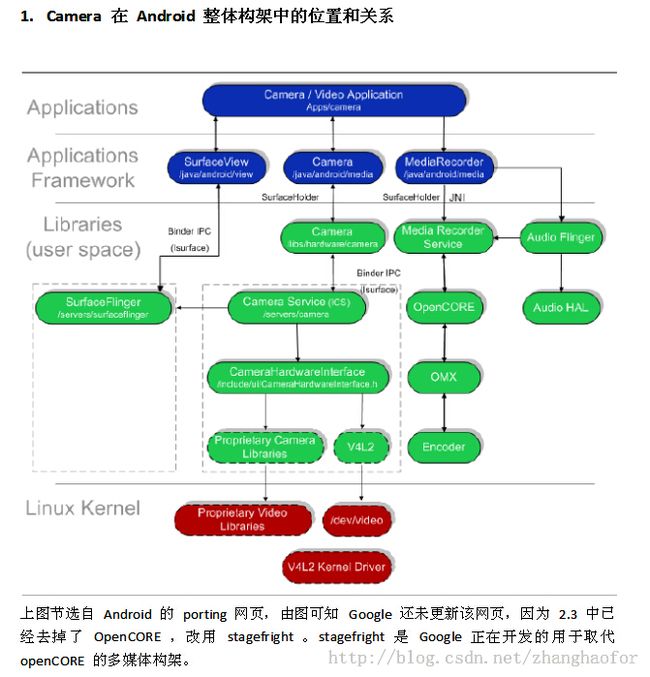

接下来分享下Camera的调用相关的应用层的资料。

先看张图

使用Camera控制拍照的几个步骤:

1、调用Camera的open()打开相机

2、调用Camera的getParameters()获取拍照参数。该方法返回一个Camera.Paremeters对象

3、调用Camera.Parameters对象方法设置拍照的参数

4、调用Camera.startPreview()方法开始预览取景,在预览取景之前需要调用Camera的setPreviewDisplay(SurfaceHolder holder)方法设置使用 哪个SurfaceView来显示取景图片。

5、调用Camera的takePicture()方法进行拍照

6、结束程序时,调用Camera的stopPreview()结束取景预览,并调用release()方法释放资源

使用Camera控制录像的相关资料,有篇Android中文翻译组的文章已经写的非常清楚了,在此就不贴出来了,稍后转帖有兴趣的可以看看。

另外在实际的调试过程中也遇到过其他的一些问题,在此都总结下,希望有经验的可以留言交流。

1.录像出来的文件会有花屏

2.录像在后台的时候会有概率自动停止录像

3.摄像头热插拔有异常

4.拍照的反应速度较长

5.录制过程系统内存紧张时会停止或者录像会出现卡顿的现象。

因为过程中出过的问题也有解决过暂时没发现再出现的,后面再记录。