从节能角度看数据中心软硬件设计(一)

从节能角度看数据中心软硬件设计(一)

-PMC公司资深顾问、前Facebook存储架构设计师、

OCP创始人之一Per Brasher于CCCC演讲实录-

此次演讲流程如下。首先讨论关注数据中心效率的原因及其提升效率的原始动力所在。第二步讨论影响效率的主要构成部件,这些部件对效率的贡献大概有多少,以及怎样对每个部件的效率进行优化和提高。第三个方面是展望如何进一步降低TCO成本,其中将涉及更先进的数据保护机制。接着会对存储的各种新模式进行一定展望,最后做一个总结。

下表总结了OCP的设计理念,其中把数据中心的每一个构成部件及其在总成本当中的权重做了一个罗列,并就针对每个部件的设计理念进行优化采取的措施及对设备投资和运维成本带来的比例影响,也做了一定的罗列。得出的结论是通过OCP的设计理念,经过加权平均在设备投资节省了23%的成本,运维方面节省了33%。

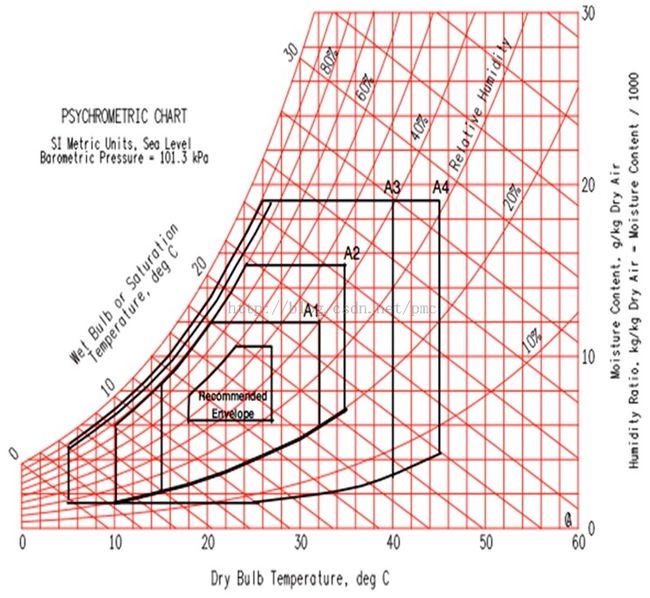

下图看上去比较复杂,展现了数据中心运作中的环境因素,主要指温度和湿度。传统的数据中心通常环境狭小、要求严格、温度、湿度均非常低。这样的环境意味着在空调散热方面需要比较大的投入,从不管是设备、还是空调制冷所消耗的能源等多方面综合考虑。现阶段,大家意识到,通过把工作条件放宽松,宽松到A2范围,就可以大大提高数据中心的能量使用效率。图中蓝线体现了OCP目前支撑的范围。通过散热和空调设计的改变,实现PUE1.07的能效。如果不熟悉PUE,简单来说,所指的是整体数据能耗除以IT设备能耗的比例,该比值越接近1越好。

这意味着什么呢?能量效率的提升直接体现在电费节省上面。每一瓦的功耗,每年大概耗费1.9美金,一兆瓦级的数据中心如果每一兆瓦把PUE从1.9下降到1.07,就意味着节省了100多万美金。对于某些能耗超过一兆瓦量级的数据中心而言,这个数字非常可观。

接下来从三方面展开来谈——从大到小。首先是数据中心机房设施(包括空调)的设计,这一方面能够带来的能源节约。第二方面是电力分布的系统,如何配电,这一方面的一些设计改进。第三方面则详细阐述机架和服务器。

空调怎么设计呢?外部空气进入机房,如果空气温度太低,会通过循环将现有数据中心的热气与之混合,再经过一些过滤器。如果气温太高,则经过固化的装置,通过水的气化带走一些热量,再把经过冷却的气体送到数据中心IT设备。经过IT设备之后,气体的温度会升高,或者将其回收再循环,或者直接输送到机房外面。

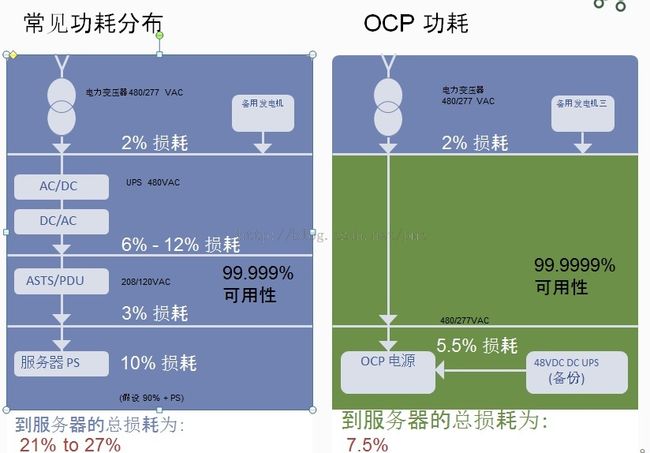

下图左边展现了传统的配电方式,通常是480伏的交流电进来,经过AC/DC转换和UPS,再转换回交流电,然后通过PEU送到机架上面,每一步转换其实都存在能量损耗。到达服务器时总损耗大概是27%左右。右图则展示出,在OCP设计中,直接把480伏配电送到机架,其中由更高效的OCP电源和48V DS做保护,总能量损耗为7.6%,其中包括了电源本身的损耗。过去的PUE评测中,一般服务器内部的电源损耗并没有考虑在内。因此,上述提升不仅在数量上非常可观,还远远超出了最早的设计效果。

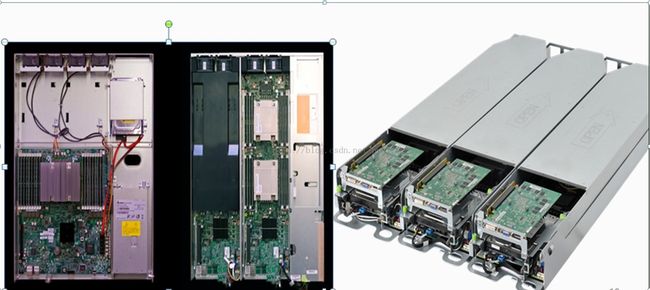

下面这三张图代表了三代OCP服务器的演进。第一代和第二代的机箱设计完全一致,第一代主板非常大,只有一块;第二代则放了两块主板;第三代改变了机箱的设计,但主板跟第二代还是一样。演进的过程中,OCP对供应链的保护意识很强,尽量复用了已有的设计,这样一来,供应商就不必针对每次规范改变而重新投入开发和测试成本。

下图中比较了传统的数据中心设计和OCP设计带来的成本影响。红色代表的是传统设计,绿色代表OCP设计。由图可见,两者相比,OCP大致可以节省33%的成本。加入的蓝色部分,则显示出采用PMC倡导的新技术,能够为OCP带来进一步的节约和改进。应该注意到的是,在存储方面,进一步的成本下降空间还是非常巨大。