文本挖掘之降维技术之特征选择

1、为什么要进行降维处理?

1.多重共线性--预测变量之间相互关联。多重共线性会导致解空间的不稳定,从而可能导致结果的不连贯。

2.高维空间本身具有稀疏性。一维正态分布有68%的值落于正负标准差之间,而在十维空间上只有0.02%。

3.过多的变量会妨碍查找规律的建立。

4.仅在变量层面上分析可能会忽略变量之间的潜在联系。例如几个预测变量可能落入仅反映数据某一方面特征的一个组内。

降维的目的:

1.减少预测变量的个数

2.确保这些变量是相互独立的

3.提供一个框架来解释结果

目前大多数使用向量空间模型对文本表示成为向量形式,而向量的属性则有可能涉及到中文中的所有词汇,其向量的维数是非常巨大的,同时考虑到一篇文章只不过包含极少数词语(比如,一篇文档只由儿百个词语组成),可知文档表示向量的稀疏性。这样高维的特征空间对文本分类的运算时间和空间复杂性是很不利的,因此在进行文本分类之前需要对文本进行特征降维,以最大程度的提高文本分类的精度,同时高效的特征降维能够节省更多的存储空间、提高分类速度。特征降维的主要方法有特征选择、特征抽取。

2、特征选择与特征提取的定义?

特征选择指的是从特征总集中挑选出一部分有用的、对分类类别有贡献的词条组成特征子集,其一般的方法是使用某种评估函数独立地对每个特征词打分,然后把特征词按照分值高低排队,取最高分的一些特征词作为文本特征子集。特征选择并没有改变原始特征空间的性质,只是从原始特征空间中选择了一部分重要的特征,组成一个新的低维空间。下面就四种比较常用的特征选择方法,包括文档频率(DF)、互信息(MI)、x方统计量(CHI)、相关系数等方法做进一步介绍。

2.1、文档频率(Doeument Frequency DF)

词条的文档频率(DF)就是指在训练样本集中出现该词条的文档数。在进行特征抽取时,将DF高于某个特定阑值的词条提取出来,低于这个阈值的词条给予滤除。

DF评估函数的理论假设是稀有词条不含有有用信息,或含有的信息太少不足以对分类产生影响,而应当被去除。然而这种假设与一般的信息抽取观念有点冲突,因为在信息抽取中,有些稀有词条(如类别特征词)却恰恰比那些中频词更能反映类别的特征而不应该被滤除,因此单独使用DF评估函数进行特征选择未免太武断了。

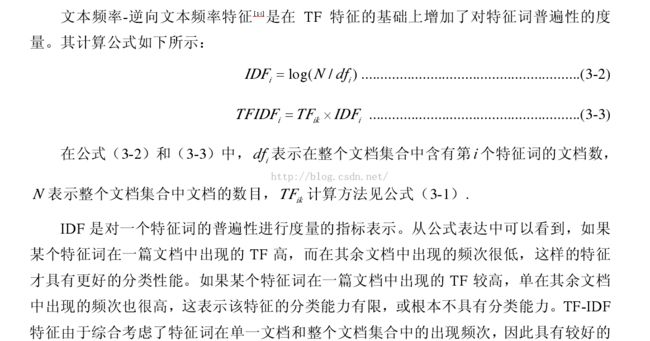

2.2 、文档频率-逆向文档频率特征

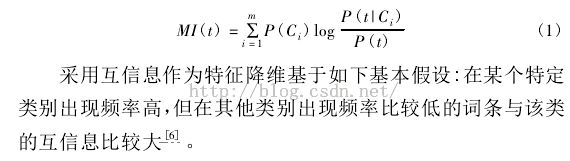

2.3、互信息(MI)

或者使用这种公式计算

MI的缺点:在文本分类中,MI 特征的不足之处在于极少出现的特征词的 MI 值要大于正常出现特征词的 MI,这一点与文本特征分类恰恰相反。因此,基于 MI 特征的文本分类算法检测性能较差。

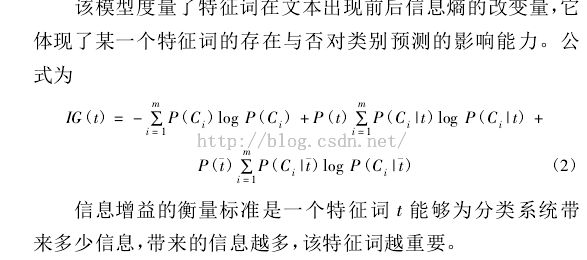

2.4、信息增益(IG)

或者用以下公式计算也可以

或者用下面的公式理解

2.5、期望交叉熵(ECE)

2.6、x^2统计法(CHI)

2.7、相关系数(CC)

2.8、文本证据权重

或者以下理解

通过查阅大量的文献,可以得出一些研究者对特征选择算法有如下的评价分类效果最好

的是文本证据权重算法,其次是信息增益、期望交叉熵、卡方,最后是互信息方法。

2.9、几率比(OR)