C++卷积神经网络实例:tiny_cnn代码详解(9)——partial_connected_layer层结构类分析(下)

在上一篇博文中我们着重分析了partial_connected_layer类的成员变量的结构,在这篇博文中我们将继续对partial_connected_layer类中的其他成员函数做一下简要介绍。

一、构造函数

由于partial_connected_layer类是继承自基类layer,因此在构造函数中同样分为两部分,即调用基类构造函数以及初始化自身成员变量:

partial_connected_layer(layer_size_t in_dim, layer_size_t out_dim, size_t weight_dim, size_t bias_dim, float_t scale_factor = 1.0) : layer<Activation> (in_dim, out_dim, weight_dim, bias_dim), weight2io_(weight_dim), out2wi_(out_dim), in2wo_(in_dim), bias2out_(bias_dim), out2bias_(out_dim), scale_factor_(scale_factor) {}

这里对于自身的成员变量的赋值采用直接复制的方式,weight2io_代表网络中映射矩阵中映射核的总个数,为(卷积核尺寸的平方*通道数*卷积核个数);out2wi_代表卷积层网络输出特征的维数,为(in_width - window_size + 1) * (in_height - window_size + 1) * out_channels;in2wo_代表卷积层输入输入的维数,为数据矩阵的行数*列数*通道数;bias2out_代表卷积层中加性偏置的总个数;out2bias_代表输出特征的维数。

这里对partial_connected_layer的基类layer做了一个宏定义,方便后面使用:

二、层属性计算参数

由于卷积层和下采样层的参数众多,为了方便用户了解各个层的参数数量以及连接规模,这里提供三个参数个数计算函数,用以返回卷积层的下采样层中的对应参数个数。首先,返回当前层的待学习参数个数(包括卷积核权值和偏置):

返回当前层与前一层的连接个数:

返回当前层的特征输出维数:

三、前向传播函数forward_propagation

由于partial_connected_layer类是卷积层和下采样层的公共基类,而卷积层和下采样层同样都需要前向传播和反向传播功能,因此作者选择在partial_connected_layer类中定义前向传播算法和反向传播算法,而不是在两个子类中分别进行定义,至于这样做的原因,在后面的博文中会进行详细说明。

这里封装的前向传播算法和前文介绍的全连接层中的前向传播算法类似,主要分为三大部分:前向传播的卷积过程、输出卷积结构、递归。

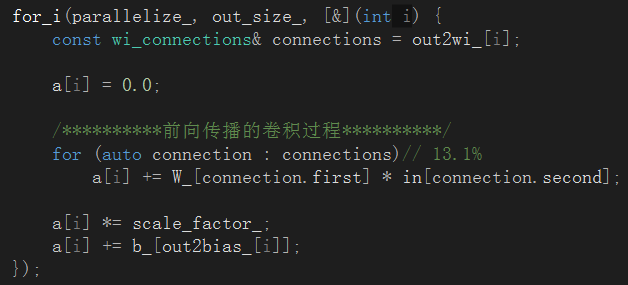

首选在卷积过程中,需要进行卷积、对应系数扩展(这里系数默认为1,因此这一步基本可以忽略)、加偏置值,而且这些操作都是以Lamda表达式的方式来实现的:

接下来需要将卷积结果传递给输出数组,这里主要需要先经过激活函数来做一步处理:

最后通过递归的方式来完成算法的传播(前向传播和反向传播都是通过递归来完成的):

至于反向传播函数back_propagation,由于其函数结构相对复杂,我们将对反向传播函数的解读放在后续介绍BP算法的博文中,这个系类博客的前三分之一的篇幅都是先分析tiny_cnn的前向传播过程,因此这里针对back_propagation()函数暂时先挖下一个大坑,等待后续的博文来填,望大家谅解。

OK,这篇博客就先介绍到这里,至此我们已经对partial_connected_layer类的大部分成员变量和功能函数(除了反向传播算法)都介绍完毕,在下一篇博文中我们将继续对更底层的基类:layer、layer_base进行简要分析,然后就开始研究卷积网络的前向传播实现方法,大家敬请期待吧。

三、注意事项

1、函数调用格式以及构造流程的问题

这里需要强调一点的是tiny_cnn在构造整个网络结构的过程中,是采用一种类似于“流”的形式来完成的构造:

这种流操作方式定义在network类中,有关这种流构造技巧的更多详细信息我会在介绍network类的过程中来专门进行详细的介绍(又是一个坑),目前已知的就是这种流操作方式在表面上是一次性完成整个网络结构的构造,这也给我们在程序调试中查看中间层的网络初始化参数带来了麻烦,看看后续怎么解决吧。