[置顶] spark、sparkR部署

1、配置java环境

tar -zxvf jdk-8u77-linux-x64.tar.gz -C /opt/java/

vi /etc/profile

export JAVA_HOME=/opt/java/jdk1.8.0_77

export JRE_HOME=${JAVA_HOME}/jre

export CLASSPATH=.:{JAVA_HOME}/lib:${JRE_HOME}/lib

export PATH=${JAVA_HOME}/bin:$PATH

source /etc/profile

2、安装R

我们希望能够使用R语言编写Spark程序,在本地安装R解释器

添加数据源(本机为ubuntu12.04选trusty)

deb http://mirror.bjtu.edu.cn/cran/bin/linux/ubuntu trusty/

sudo apt-get install r-base-core=3.1.3-1trusty

3、安装hadoop

wget http://apache.claz.org/hadoop/common/hadoop-2.6.0/hadoop-2.6.0.tar.gz

下载完成解压后修改配置文件,编辑 /etc/profile 、hadoop-env.sh文件、core-site.xml、hdfs-site.xml、mapred-site.xml、yarn-site.xml修改完成后初始化、启动

./bin/hdfs namenode -format

./sbin/start-all.sh

jps

4、安装scala

解压安装并配置环境变量,安装完成可以查看版本信息

5、安装spark

解压后设置环境变量

export SPARK_HOME=/opt/spark-1.4.1-bin-hadoop2.6

export PATH=$SPARK_HOME/bin:$PATH

在 conf 目录下复制并重命名 spark-env.sh.template 为 spark-env.sh 后添加

export JAVA_HOME=your java home export SCALA_HOME=your scala home export SPARK_MASTER_IP=TMaster export SPARK_WORKER_MEMORY=4G启动并测试:

./sbin/start-all.sh

./bin/run-example SparkPi

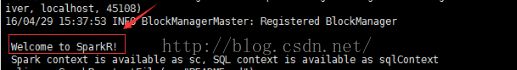

6、启动sparkR :

./bin/sparkR

7、SparkR进行行数统计

lines<-SparkR:::textFile(sc,"README.md")

count(lines)

![[置顶] spark、sparkR部署_第1张图片](http://img.e-com-net.com/image/info5/e914f18099fa4e55af3b6973638202cb.png)