Hadoop — 使用Eclipse编译运行MapReduce程序(Hadoop2.6.0)

#前期准备

1、eclipse (eclipse-java-mars-1-linux-gtk-x86_64.tar.gz)密码: 6awv

2.、eclipse-plugin (hadoop-eclipse-plugin-2.6.0.jar)密码: geq4

3、将hadoop-eclipse-plugin-2.6.0.jar 拷贝到 eclipse的plugin中

![]()

#配置hadoop-eclipse-plugin

1、选择 Window 菜单下的 Preference

在 Hadoop installation directory 下填写 hadoop 的安装目录

2、切换 Map/Reduce 工作目录,选择 Window 菜单下选择 Open Perspective -> Other

切换工作空间

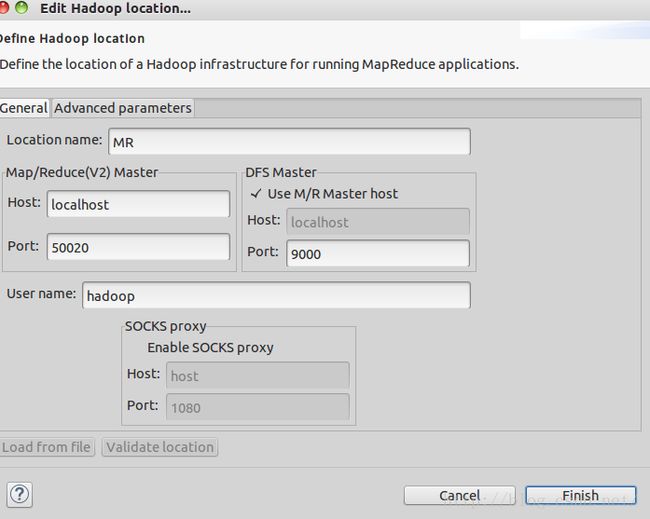

3、建立与 Hadoop 集群的连接,点击 Eclipse软件右下角的 Map/Reduce Locations 面板,在面板中单击右键,选择 New Hadoop Location。

在弹出来的 General 选项面板中进行 Master 的设置,设置要要 Hadoop 的配置一致,请读Linux(Ubuntu15.04)下安装`配置Hadoop(2.6.0),Location Name 随意填写,Map/Reduce Master 的 Host 填本机的IP(或者 localhost ),Port 默认就是 50020,DFS Master Post 为 9000。

最后的设置如下:

Advanced parameters 选项面板,这边有详细的配置,同样要与 Hadoop 的配置(/usr/local/hadoop/etc/hadoop中的配置文件)一致,如果打不开该面板,则可以不设置,本机打不开,则没有设置。(这个我猜是动态地和Hadoop配置文件同步)

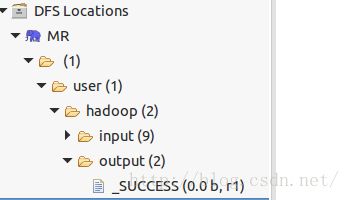

#在eclipse 中查看 HDFS 中的内容

注意:当HDFS 内容变化之后 eclipse不会同步刷新 需要自己 refresh

#在eclipse中创建MapReduce 工程(于正常创建java程序相似)

1、点击 File 菜单,选择 New -> Project、选择 Map/Reduce Project,点击 Next。

2、填写 Project name

3、创建的 WordCount 项目(代码)

需要填写两个地方:在 Package 处填写 org.apache.hadoop.examples;在 Name 处填写 WordCount

4、在左侧的 Project Explorer 就能看到刚才建立的项目

注意:如果没有复制 core-site.xml 和 hdfs-site.xml ,程序将无法运行,会提示 Input 路径不存在(实际读取的是当前目录而非 HDFS 目录)。log4j.properties 这个配置文件,如果没有,虽然不影响程序的正确运行,但程序运行时无法看到任何提示消息(只能看到出错信息)。

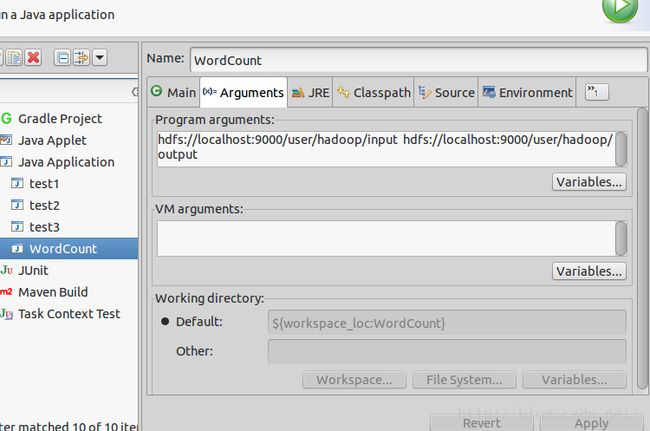

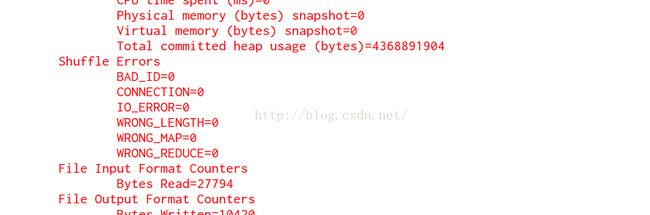

#通过 eclipse 运行 MR 程序

1、Run As -> Run Configurations,在此处可以设置运行时的相关参数

2、选择 Run As -> Run on Hadoop

#需要注意的问题

HDFS 中 文件 权限 问题 :

我是这样解决的(777 -> 权限给的很大 )说明确实 是 权限问题。

![]()