機器學習基石(Machine Learning Foundations) 机器学习基石 作业四 课后习题解答

本文出处:http://blog.csdn.net/a1015553840/article/details/51173679

其他作业解析请看汇总贴:http://blog.csdn.net/a1015553840/article/details/51085129

1.第一题

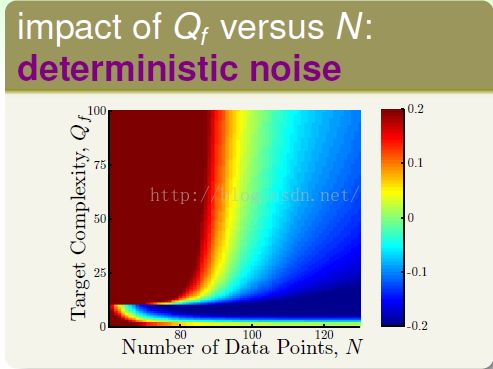

(1)题意:利用hyphothesis set H的时候有一个deterministic noise(固定噪声),如果用一个更小的hyphothesis set H',那么固定噪声是增大了还是减小了?

(2)分析:首先我们要知道什么是固定噪声

固定噪声是由于target function f 本身Qf太大造成的。若f本身的Qf太大,那么用h去拟合这种高次的目标函数是不容易的,所以固定噪声大。当我们用更小的H‘代替H来拟合f的时候,由于H’更加小,那么对f的拟合程度更加不好,所以deterministic noise会增加!

(3)答案:increasing 第二项

2.第二题

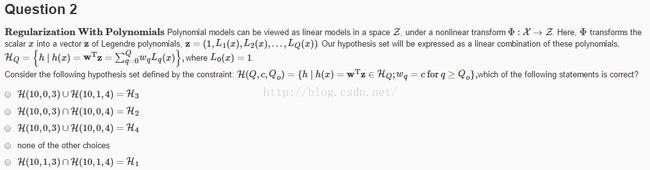

(1)题意:定义H(Q,c,Q0),求下面哪个是正确的。

(2)分析:首先,我们要把定义看懂,然后带入计算即可。

H(10,0,3)= {h(x) = [w0 w1 w2 0 0 0 0 0 0 0 0] * [ z0 z1 z2 z3 z4 z5 z6 z7 z8 z9 z10] = w0*z0 + w1*z1 + w2*z2}

H(10,0 ,4) = {h(x) = [w0 w1 w2 w3 0 0 0 0 0 0 0] * [z0 z1 z2 z3 z4 z5 z6 z7 z8 z9 z10] = w0*z0+w1*z1+w2*z2+w3*z3}

H2={h(x) = {w0*z0+w1*z1+w2*z2}

H(10,0,3) 交 H(10,0,4) = H2

(3)答案:第二项 同理可证其他项

3.第三题

(1)题意:利用decay作为regularizer,利用梯度下降的方法计算Eaug的最小值,迭代步长为ita,那么每次迭代更新公式为哪项?

(3)答案:第二项

4.第四题

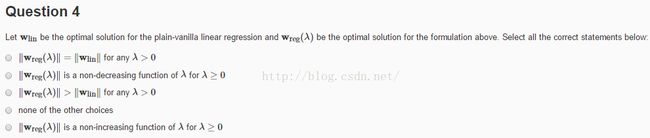

(1)题意:求Wreg(lambda)的模随lambda变化的单调性

(2)分析

利用物理意义分析(1)当w‘ * w = C没有包括win时,那么加大lambda,即减小C,那么更加不能包括win, ||Wreg|| = C减小

(2)当w' * w =C包括win时,||Wreg||=||Win||,那么加大lambda,即减小C,如果还是包括win,那么是不会变的

综上,不是单增的

(3)答案:non-increasing

5.第五题

(1)题意:利用leave one out cross validation分别计算两个Hyphothesis的错误率,利用平方错误方法计算,求他们错误一样时参数rou的值

(2)这道题博主也不会,可能是题目理解错了,希望大神解答!

6.第六题

(1)题意:这道题讲的是幸存者偏差。

(2)分析:第一次给32个人发邮件,一半说A队会赢,一半说B队会赢,肯定有一半的邮件(16封)是正确的;第一次结果出来后,对第一次正确的16个人发邮件,一半说A会赢,一半说B会赢,以此类推。那么32个人在进行5场比赛后可能有一个人5次接受的答案都是正确的。

(3)答案:第三项,第二次需要对第一次正确的16个人发邮件

7.第七题

(1)题意:按照第6题的方法,每封信需要10块,如果第六场比赛有人花1000块,问这个骗子挣了多少钱

(2)分析:共需要发32+16+8+4+2+1=63封信共630块,赚了370块

(3)答案:370

8.第八题

(1)题意:一个银行最初用一个公式a(x)颁发信用卡,然后在这些颁发信用卡里面的10000个人作为样本,分析要不要给新的用户颁发信用卡。你在看这些样本之前,你利用数学理论提出一个信用卡颁发公式,问hyphothesis set的大小。

(2)分析:不要把题目想的太复杂,因为你利用数学推导提出一个信用卡颁发公式,即hyphothesis已经确定了,所以hyphothesis set大小为1

(3)答案:1

9.第九题

(1)题意:利用Hoeffding bound计算Ein与Eout相差不超过1%的概率,当训练样本数为100000

(2)分析:

由于第八题已经知道M = 1是有限的,所以我们调用这个公式就可以了:

(3)答案:0.271

10.第十题

(1)题意:你利用银行提供的100000个样本得到了一个很好的g,他能很好拟合训练样本。但是当我们利用他作为实际用途时,发现他的泛化能力很弱,这是为什么?

(2)分析:应为我们得到的样本都是由第八题a(x)这个公式上得到的,所以我们的训练数据不是干净的,是受过a(x)污染的。即我们利用a(x) and g(x)决定了最后的机器学习算法表现。

(3)答案:a(x) AND g(x)

11.第十一题

(1)题意:在原先的N个样本上添加K个样本,那么利用这些N+K个样本计算线性回归,求参数的公式

(2)答案:第二项

12.第十二题

(1)题意:如果利用11题的方法,那么什么时候11题公式等于正则化逻辑回归的解

(2)分析:

正则化逻辑回归的求解Wreg的公式如上,要使11题的公式等于他,即满足第五项即可

(3)答案:第五项

13-20题解答请看:http://blog.csdn.net/a1015553840/article/details/51173020

本文出处:http://blog.csdn.net/a1015553840/article/details/51173679

其他作业解析请看汇总贴:http://blog.csdn.net/a1015553840/article/details/51085129