大数据入门之Hadoop生态系统(3) -- Hadoop和HDFS环境搭建

1.前置要求

Windows用户:VMware虚拟机 Centos6.4。(要求主机和虚拟机能够相互通信,具体请查看网上教程)

Linux、Mac用户:可以直接在本地搭建环境。

JDK1.8(具体的安装步骤,网上都有很多,注意我们所有的东西都是安装在虚拟机上的,注意配置到系统环境变量中)

2.Hadoop环境(伪分布式环境搭建)、HDFS环境搭建

下载

我们Hadoop使用的版本是:hadoop-2.6.0-cdh5.7.0,我们选择下载的URL:http://archive.cloudera.com/cdh5/cdh/5/hadoop-2.6.0-cdh5.7.0.tar.gz

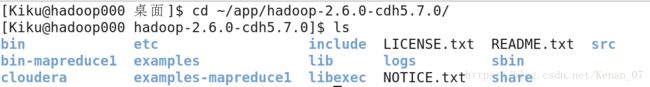

下载可能会比较慢,我习惯把下载的安装包放在虚拟机中的“~/下载/” 这个目录下面,这个目录可以自己指定。然后我们对这个安装包就行解压。用终端打开“~/下载/”目录,运行“tar -zxvf hadoop-2.6.0-cdh5.7.0.tar.gz -C ~/app”命令,我们把这个安装包解压到了“~/app/”的这个目录下(个人习惯),当然这个目录也可以随意指定。我们进入到“~/app/hadoop-2.6.0-cdh5.7.0/”中看一下目录结构。

这里有几个目录是比较重要的,bin目录下是客户端访问的一些脚本,“etc/hadoop/”这个目录里面有很多配置文件,sbin目录里面有启动集群(启动Yarn、启动hdfs)的一些命令,在“share/hadoop/mapreduce/”中有一些mapreduce的案例jar包,我们后续会用到。

然后,我们需要把Hadoop的bin目录配置到环境变量中,我这里是配置到"/etc/profile"中,打开这个文件,在最后添加"export HADOOP_HOME=~/app/hadoop-2.6.0-cdh5.7.0",“export PATH=$HADOOP_HOME/bin:$PATH",保存退出之后,运行”source /etc/profile“,使我们的配置生效,就可以啦。

修改配置文件

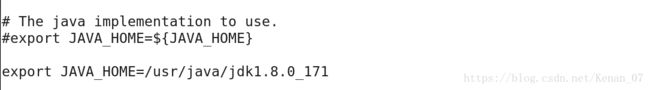

(1)进入“etc/hadoop/”目录中,打开"hadoop-env.sh"这个文件:vi hadoop-env.sh

在文件中找到“#export JAVA_HOME=${JAVA_HOME}”这句话,进行修改:export JAVA_HOME=这里写上你配置JAVA_HOME的环境变量。修改完别忘了保存。这里我的jdk的路径就是/usr/java/jdk1.8.0_171,这个自行修改。

(2)进入“etc/hadoop/”目录中(和刚才那个是同一个目录下),打开“core-site.xml”这个文件:vi core-site.xml

在

fs.defaultFS

hdfs://hadoop000:8020

然后再添加一下,hadoop文件系统依赖的基本配置(默认是在临时文件夹下,这是不行的,所以需要修改)

hadoop.tmp.dir

~/app/tmp

(3)进入“etc/hadoop/”目录中(和刚才那个是同一个目录下),打开“hdfs-site.xml”这个文件:vi hdfs-site.xml

在

dfs.replication

1

(4)进入“etc/hadoop/”目录中(和刚才那个是同一个目录下),打开“slaves”这个文件:vi slaves

一个NameNode带多个DataNode,所以这里就是配置每个DataNode的节点ip的,我们只有一个节点,所以只配置一个就行。

建议把localhost改成你虚拟机的主机名,我这里就是hadoop000,如果没有配置主机名和ip的映射的话,那么这里就不用改了。把localhost改成hadoop000(我虚拟机主机名),保存退出即可。

启动HDFS

(1)我们在启动之前,一定要执行一条命令:回到hadoop的bin目录下(即~/app/hadoop2.6.0-cdh5.7.0/bin),键入"./hdfs namenode -format",这条命令是格式化文件系统(注意:仅第一次执行即可!!!不要重复执行!!!)

(2)接下来我们启动hdfs,进入hadoop的sbin目录下,执行“./start-dfs.sh”。(如果询问是否连接,敲yes即可,没有就不要管了,可能第一次启动会有这个东西)。等待执行完成,输入"jps",查看一下进程。如果也是这四个进程就没问题了。(前面的进程id可以不一样)。

我们还可以通过浏览器验证一下,在虚拟机中打开浏览器输入网址:http://hadoop000:50070,如果可以访问,则证明启动没有问题啦。

停止HDFS

接下来我们停止hdfs,进入hadoop的sbin目录下,执行“./stop-dfs.sh”。执行“jps”,应该只有Jps进程是存活的,这样就成功地停止HDFS了。