CVPR2019目标分割论文推荐(附论文及代码链接)

点上方蓝字计算机视觉联盟获取更多干货

在右上方 ··· 设为星标 ★,与你不见不散

本文来源于联盟成员学习笔记

今天推荐几篇CVPR2019目标分割论文,附带论文及代码链接

1、论文题目

《Dual Attention Network for Scene Segmentation》

论文链接

https://arxiv.org/abs/1809.02983

代码链接

https://github.com/junfu1115/DANet

本文亮点

中科院自动化所的成果,本文提出了Dual Attention Network,通过在spatial和channel维度来捕获全局特征依赖,在Cityscapes、PASCAL Context和COCO Stuff 上都实现了最先进的结果。

主要内容

本文利用自注意机制捕获丰富的上下文依赖关系来解决场景分割任务。与以往通过多尺度特征融合捕获上下文的工作不同,我们提出了一种双关注网络(DANET),用于自适应地将局部特征与其全局依赖性集成。具体地说,我们在传统的扩展FCN基础上附加了两种注意模块,分别对空间维度和通道维度的语义依赖性进行建模。位置注意模块通过所有位置的特征加权和选择性地聚合每个位置的特征。无论距离如何,相似的特征都会相互关联。同时,信道注意模块通过在所有信道图中集成相关特征,选择性地强调相互依赖的信道图。我们总结了两个注意模块的输出,以进一步改进特征表示,这有助于更精确的分割结果。我们在三个具有挑战性的场景分割数据集(即Cityspaces、Pascal Context和Coco-Staff数据集)上实现了最先进的新分割性能。特别是,在不使用粗略数据的情况下,城市景观测试集的平均IOU得分为81.5%。

2、论文题目

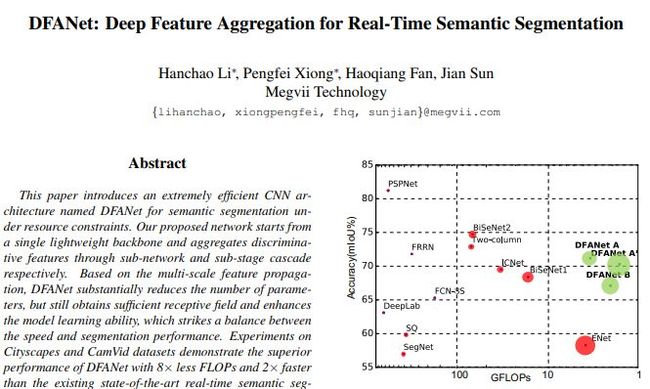

《DFANet: Deep Feature Aggregation for Real-Time Semantic Segmentation》

论文链接

https://arxiv.org/abs/1904.02216

主要内容

本文介绍了一种非常有效的CNN体系结构,称为dfanet,用于资源约束下的语义分割。我们提出的网络从一个单一的轻量主干网开始,分别通过子网和子级级联聚合识别特征。在多尺度特征传播的基础上,DFANET大大减少了参数的数量,但仍然获得了足够的接收场,提高了模型的学习能力,从而达到了速度与分割性能的平衡。对Cityspaces和CamVid数据集的实验表明,与现有的最先进的实时语义分割方法相比,具有更少的触发器和更快的DFANET优越性能,同时提供了相当的准确性。

3、论文题目

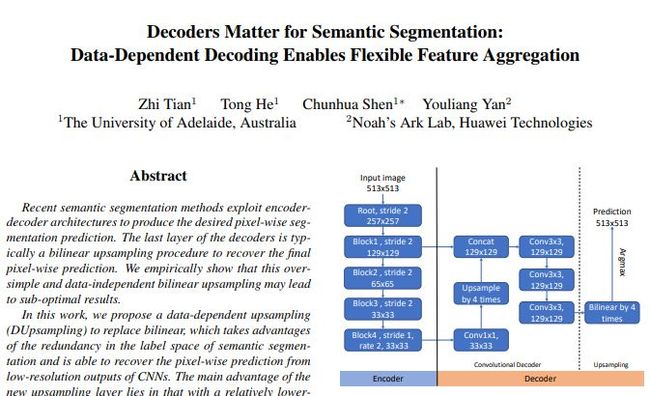

《Decoders Matter for Semantic Segmentation:Data-Dependent Decoding Enables Flexible Feature Aggregation》

论文链接

https://arxiv.org/abs/1903.02120

本文亮点

运用基于数据的上采样方法,在PASCAL VOC上mIOU达到88.1%,在 PASCAL Context上的mIOU为52.5%。

主要内容

在这项工作中,我们提出了一种基于数据的上采样(dupsampling)来取代双线性,它利用了语义分割标签空间中的冗余性,能够从CNN的低分辨率输出中恢复像素预测。新的上采样层的主要优点在于,具有相对较低的分辨率特征图,如116或132的输入尺寸,可以达到更好的分割精度,大大降低了计算复杂度。这一点可以通过以下方式实现:1)新的上采样层大大提高了重建能力;更重要的是2)基于duppasing的解码器在利用CNN编码器功能几乎任意组合方面的灵活性。实验表明,我们提出的解码器性能优于最先进的解码器,只需20%的计算量。最后,在不进行任何后处理的情况下,配备我们所提议解码器的框架在两个数据集上实现了最新的性能:Pascal VOC的88.1%MIOU;Pascal Context的52.5%MIOU。

4、论文题目

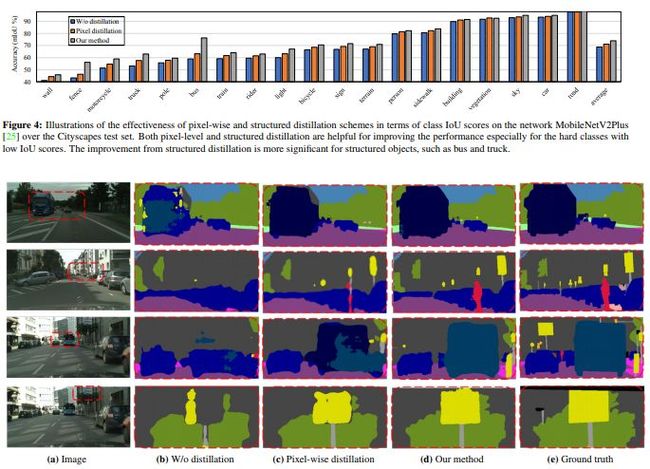

《Structured Knowledge Distillation for Semantic Segmentation》

论文链接

https://arxiv.org/abs/1903.04197

主要内容

本文研究了利用大网络训练小语义分割网络的知识蒸馏策略。我们从简单的像素蒸馏方案开始,将蒸馏方案应用于图像分类,并分别对每个像素进行知识蒸馏。我们进一步提出了从大网络到小网络的结构化知识提取,这是一个结构化的预测问题,语义分割的动机。我们研究了两种结构化的蒸馏方案:(i)提取成对相似性的成对蒸馏;(i i)使用gan提取整体知识的整体蒸馏。通过对三个场景分析数据集(Cityscapes、Camvid和ADE20K)的大量实验,证明了我们的知识蒸馏方法的有效性。

5、论文题目

《Attention-guided Unified Network for Panoptic Segmentation》

论文链接

https://arxiv.org/abs/1812.03904

主要内容

本文研究了泛光分割(panoptic segmentation),这是一个最近提出的任务,它将前景(fg)对象和背景(bg)内容在语义层面进行分割。现有的方法大多是分别处理这两个问题,但本文揭示了它们之间的内在联系,特别是fg对象提供了辅助线索来帮助bg理解。我们的方法被称为注意力引导统一网络(aunet),是一个统一的框架,同时有两个分支用于fg和bg分割。在BG分支中增加了两种注意源,即RPN和FG分割掩模,分别提供对象级和像素级注意。我们的方法被推广到不同的主干,在fg和bg分割中具有一致的精度增益,并且在ms-coco(46.5%pq)和cityscape(59.0%pq)基准中设置了新的技术状态。

6、论文题目

《Mask Scoring R-CNN》

论文链接

https://arxiv.org/abs/1903.00241

代码链接

https://github.com/zjhuang22/maskscoring_rcnn

主要内容

让一个深层网络知道它自己的预测的质量是一个有趣但重要的问题。在实例分割的任务中,大多数实例分割框架都将实例分类的置信度作为遮罩质量得分。然而,量化为实例掩码与其基本事实之间的IOU的掩码质量通常与分类分数没有很好的相关性。本文研究了这一问题,提出了一种基于网络块的R-CNN掩模评分方法,以了解预测实例掩模的质量。提出的网络块将实例特征和相应的预测掩模结合起来,对掩模IOU进行回归。在COCO AP评估过程中,掩模评分策略会校准掩模质量和掩模评分之间的偏差,并通过更准确地确定掩模预测的优先级来提高实例分割性能。通过对Coco数据集的广泛评估,口罩评分r-cnn在不同的模型中带来一致和显著的收益,并优于最先进的口罩r-cnn。我们希望我们简单有效的方法能够为改进实例分割提供一个新的方向。

END

声明:本文来源于联盟成员学习笔记

如需转载,联系后台

加群交流

欢迎加入CV联盟群获取CV和ML等领域前沿资讯

扫描添加CV联盟微信拉你进群,备注:CV联盟

热文荐读

CVPR2019北大最新成果!基于语义解析转换的无监督人图像生成

CVPR2019| 中科院VIPL实验室11篇CVPR解读:弱监督学习、视频分割、目标检测

Google CVPR 2019最新成果!NAS-FPN:可扩展特征金字塔结构用于目标检测

一文带你领略GANs核心

卡内基·梅隆大学新提出AdaScale:自适应缩放实现视频对象实时检测算法