李航第一章课后习题答案

1.1

统计学习方法的三要素是模型、策略、算法。

伯努利模型是定义在取值为0与1的随机变量上的概率分布。假设观测到伯努利模型n次独立的数据生成结果,

假定事件为A,

其中“有k次实验”的数值结果为1(这里不是概率值),这时可以用极大似然估计或贝叶斯估计来估计事件A=1的概率。

注意:

这里的n和k都是常数。

并且这k次的顺序也是固定的,所以不需要在后面计算的时候考虑组合数

统计学分为两派:经典统计学派和贝叶斯统计学派。两者的不同主要是,经典统计学派认为模型已定,参数未知,参数是固定的,只是还不知道;贝叶斯统计学派是通过观察到的现象对概率分布中的主观认定不断进行修正。

极大似然估计和贝叶斯估计的模型都是伯努利模型也就是条件概率模型;极大似然估计用的是经典统计学派的策略,贝叶斯估计用的是贝叶斯统计学派的策略;为了得到使经验风险最小的参数值,使用的算法都是对经验风险求导,使导数为0.

定义随机变量A为一次伯努利试验的结果,A的取值为{0,1},概率分布为P(A):

P ( A = 1 ) = θ P(A=1)=\theta P(A=1)=θ

P ( A = 0 ) = 1 − θ P(A=0)=1-\theta P(A=0)=1−θ

所以上面这道题的意思就是,最后可以用极大似然估计或者贝叶斯估计来估计P(A)的大小

下面分布用极大似然估计和贝叶斯估计来估计\theta的值。

极大似然估计:

L ( θ ) = ∏ i = 1 n P ( A i ) = θ k ( 1 − θ ) n − k L ( θ ) = ∏ i = 1 n P ( A i ) = θ k ( 1 − θ ) n − k L(\theta)=\prod_{i=1}^{n}P(A_i)=\theta^k(1-\theta)^{n-k}L(\theta)=\prod_{i=1}^{n}P(A_i)=\theta^k(1-\theta)^{n-k} L(θ)=i=1∏nP(Ai)=θk(1−θ)n−kL(θ)=i=1∏nP(Ai)=θk(1−θ)n−k

A i A_i Ai代表第i次随机试验。

θ = a r g max θ L ( θ ) = k n θ = a r g max θ L ( θ ) = k n \theta=arg\max \limits_\theta L(\theta)=\frac{k}{n}\theta=arg\max \limits_\theta L(\theta)=\frac{k}{n} θ=argθmaxL(θ)=nkθ=argθmaxL(θ)=nk

注意,第1.1小题的解答到这里就可以结束了。

贝叶斯估计:

P ( θ ∣ A 1 , A 2 , . . . , A n ) P(\theta|A_1,A_2,...,A_n) P(θ∣A1,A2,...,An)

= P ( A 1 , A 2 , . . . A n ∣ θ ) π ( θ ) P ( A 1 , A 2 , . . . , A n ) =\frac{P(A_1,A_2,...A_n|\theta)\pi(\theta)}{P(A_1,A_2,...,A_n)} =P(A1,A2,...,An)P(A1,A2,...An∣θ)π(θ)

根据观察到的结果修正 θ \theta θ,也就是假设 θ \theta θ是随机变量, θ \theta θ服从 β \beta β分布(这个的话我觉得其实就是原来解题者自己加进去的),有很多个可能的取值,我们要取的值时在已知观察结果的条件下使 θ \theta θ出现概率最大的值。上式分母是不变的,求分子最大就可以。

θ \theta θ

= a r g max θ P ( A 1 , A 2 , . . . A n ∣ θ ) P ( θ ) =arg\max \limits_\theta {P(A_1,A_2,...A_n|\theta)P(\theta)} =argθmaxP(A1,A2,...An∣θ)P(θ)

= a r g max θ ∏ i = 1 n P ( A i ∣ θ ) P ( θ ) = arg\max \limits_\theta {\prod_{i=1}^{n}P(A_i|\theta)P(\theta)} =argθmax∏i=1nP(Ai∣θ)P(θ)

= a r g max θ θ k ( 1 − θ ) n − k θ a − 1 ( 1 − θ ) b − 1 =arg \max \limits_\theta {\theta^k(1-\theta)^{n-k}\theta^{a-1}(1-\theta)^{b-1}} =argθmaxθk(1−θ)n−kθa−1(1−θ)b−1

= k + ( a − 1 ) n + ( a − 1 ) + ( b − 1 ) =\frac{k+(a-1)}{n+(a-1)+(b-1)} =n+(a−1)+(b−1)k+(a−1)

其中a,b是 β \beta β分布中的参数

β ( θ ; a , b ) = θ a − 1 ( 1 − θ ) b − 1 一 个 常 数 \beta(\theta;a,b)=\frac{\theta^{a-1}(1-\theta)^{b-1}}{一个常数} β(θ;a,b)=一个常数θa−1(1−θ)b−1,

选定a,b后就可以确定 θ \theta θ。

如选择a=b=2,则 θ = k + 1 n + 2 \theta=\frac{k+1}{n+2} θ=n+2k+1

(a,b怎么选最合理,这里应该是缺参数的。)

如果错误,欢迎指正。

参考:

http://blog.csdn.net/a358463121/article/details/52562940

http://blog.csdn.net/guohecang/article/details/52313046

http://www.math.zju.edu.cn/webpagenew/UploadFiles/AttachFiles/2010421221717128.pdf

https://guangchun.wordpress.com/2011/10/13/ml-bayes-map/

http://www.guokr.com/question/547339/

http://blog.csdn.net/guohecang/article/details/52313046

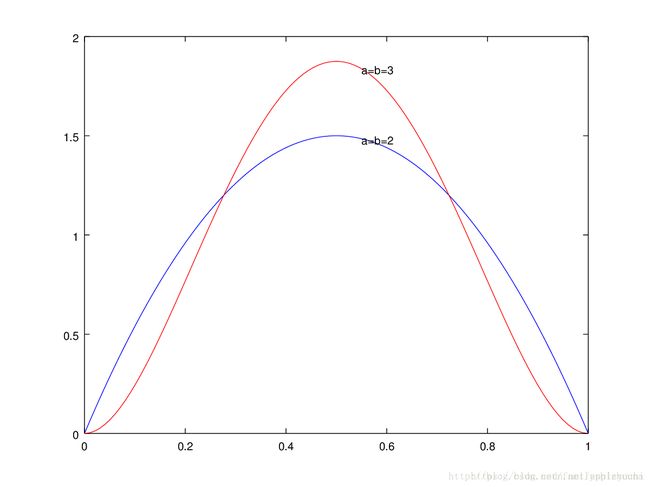

下图是 β \beta β分布:

β ( θ ; a , b ) = θ a − 1 ( 1 − θ ) b − 1 一 个 常 数 β ( θ ; a , b ) = θ a − 1 ( 1 − θ ) b − 1 一 个 常 数 \beta(\theta;a,b)=\frac{\theta^{a-1}(1-\theta)^{b-1}}{一个常数}\beta(\theta;a,b)=\frac{\theta^{a-1}(1-\theta)^{b-1}}{一个常数} β(θ;a,b)=一个常数θa−1(1−θ)b−1β(θ;a,b)=一个常数θa−1(1−θ)b−1

1.2

模型是条件概率分布: P θ ( Y ∣ X ) P θ ( Y ∣ X ) P_\theta(Y|X)P_\theta(Y|X) Pθ(Y∣X)Pθ(Y∣X),

损失函数是对数损失函数: L ( Y , P ( Y ∣ X ) ) = − l o g P ( Y ∣ X ) L ( Y , P ( Y ∣ X ) ) = − l o g P ( Y ∣ X ) L(Y,P(Y|X))=-logP(Y|X)L(Y,P(Y|X))=-logP(Y|X) L(Y,P(Y∣X))=−logP(Y∣X)L(Y,P(Y∣X))=−logP(Y∣X),

经验风险为:

R e m p ( f ) R_{emp}(f) Remp(f)

= 1 N ∑ i = 1 N L ( y i , f ( x i ) ) =\frac{1}{N}\sum_{i=1}^{N}L(y_i,f(x_i)) =N1∑i=1NL(yi,f(xi))

= 1 N ∑ i = 1 N − l o g P ( y i ∣ x i ) =\frac{1}{N}\sum_{i=1}^{N}-logP(y_i|x_i) =N1∑i=1N−logP(yi∣xi)

= − 1 N ∑ i = 1 N l o g P ( y i ∣ x i ) =-\frac{1}{N}\sum_{i=1}^{N}logP(y_i|x_i) =−N1∑i=1NlogP(yi∣xi)

最小化经验风险,也就是最大化 s u m i = 1 N l o g P ( y i ∣ x i ) ∑ i = 1 N l o g P ( y i ∣ x i ) sum_{i=1}^{N}logP(y_i|x_i)\sum_{i=1}^{N}logP(y_i|x_i) sumi=1NlogP(yi∣xi)i=1∑NlogP(yi∣xi),

也就是最大化 p r o d i = 1 N P ( y i ∣ x i ) ∏ i = 1 N P ( y i ∣ x i ) prod_{i=1}^{N}P(y_i|x_i)\prod_{i=1}^{N}P(y_i|x_i) prodi=1NP(yi∣xi)i=1∏NP(yi∣xi),

这个就是极大似然估计。

为什么极大似然估计可以被用来估计参数:

https://blog.csdn.net/appleyuchi/article/details/82928372