人工智能基础学习心得

<1>卷积层定义。(对参数w初始化且进行正则化处理)

def get_weight(shape, regularizer):

w = tf.Variable(tf.truncated_normal((shape), stddev=0.1, dtype=tf.float32))

if regularizer != None:

tf.add_to_collection('losses', tf.contrib.layers.l2_regularizer(regularizer)(w))

return w1. 函数tf.truncated_normal(shape, mean, stddev)

shape表示生成张量的维度[卷积核的高度,卷积核的宽度,图像通道数,卷积核个数],mean是均值,stddev是标准差。

这个函数产生正太分布,均值和标准差自己设定。这是一个截断的产生正太分布的函数,就是说产生正太分布的值如果与均值的差值大于两倍的标准差,那就重新生成。

2. REGULARIZER 正则化(规则化)

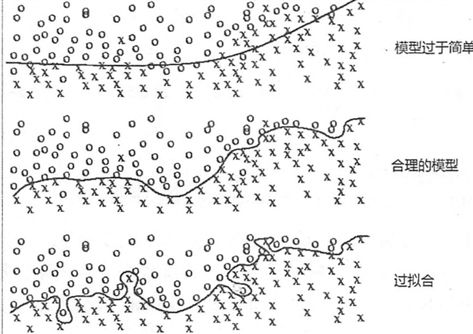

所谓过拟合,就是当一个模型过于复杂后,它可以很好的处理训练数据的每一个数据,甚至包括其中的随机噪点。而没有总结训练数据中趋势。使得在应对未知数据时错误里一下变得很大。这明显不是我们要的结果。我们想要的是在训练中,忽略噪点的干扰,总结整体趋势。在应对未知数据时也能保持训练时的正确率。

上图中第一种情况,模型过于简单,未能很好的反应数据的总体趋势。

第三种情况就属于过拟合的情况。虽然完美的反应了练习数据的状况,但是明显被噪点影响了。

第二种情况是我们想要的理想状况。为了避免过拟合,通常使用的方法就是正则化(regularizer)。

范数L1与范数L2的区别

对于线性回归模型,使用L1正则化的模型建叫做Lasso回归,使用L2正则化的模型叫做Ridge回归(岭回归)。

L1正则化和L2正则化的作用: L1正则化可以产生稀疏权值矩阵,即产生一个稀疏模型,可以用于特征选择;

L2正则化可以防止模型过拟合(overfitting)。

详细介绍见:https://blog.csdn.net/jinping_shi/article/details/52433975

<2>参数b(偏置)初始化

def get_bias(shape):

b = tf.Variable(tf.constant(0., shape=shape, dtype=tf.float32))

return b

通过常数来设置初值

<3>卷积函数

# 第一层卷积函数tf.nn.conv2d

def conv2d(x, w):

return tf.nn.conv2d(x, w, strides=[1, 1, 1, 1], padding='SAME')1. tf.nn.conv2d(input, filter, strides, padding, use_cudnn_on_gpu=None, name=None)函数

第一个参数input(输入描述):指需要做卷积的输入图像,它要求是一个Tensor,具有[batch, in_height, in_width, in_channels]这样的shape,具体含义是[训练时一个batch的图片数量, 图片高度, 图片宽度, 图像通道数],注意这是一个4维的Tensor,要求类型为float32和float64其中之一。

第二个参数filter(卷积核描述):于CNN中的卷积核,它要求是一个Tensor,具有[filter_height, filter_width, in_channels, out_channels]这样的shape,具体含义是[卷积核的高度,卷积核的宽度,图像通道数,卷积核个数],要求类型与参数input相同,有一个地方需要注意,第三维in_channels,就是参数input的第四维

第三个参数strides(核滑动步长):卷积时在图像每一维的步长,这是一个一维的向量[1,1,1,1],长度为4。

第四个参数padding:string类型的量,只能是SAME","VALID"其中之一,这个值决定了不同的卷积方式。

Valid: 用过滤器在输入的矩阵中按步长移动时候,会把最后的不足部分的列和行抛弃;

Same: 先在输入矩阵上下各加个值为0的行,在左右各加个个值为0的列,也就是用0把原先的矩阵包裹一层,然后在移动的时候如果输入矩阵的列或者行长度不够,就用0来补齐

第五个参数use_cudnn_on_gpu:bool类型,是否使用cudnn加速,默认为true

<4>池化层

def max_pool_2x2(x, kernel_size):

return tf.nn.max_pool(x, ksize=kernel_size, strides=kernel_size, padding='VALID')1. tf.nn.max_pool(value, ksize, strides, padding, name=None)函数

第一个参数value:需要池化的输入,一般池化层接在卷积层后面,所以输入通常是feature map,依然是[batch, height, width, channels]这样的shape

第二个参数ksize:池化窗口的大小,取一个四维向量,一般是[1, height, width, 1],因为我们不想在batch和channels上做池化,所以这两个维度设为了1

第三个参数strides:和卷积类似,窗口在每一个维度上滑动的步长,一般也是[1, stride,stride, 1]

第四个参数padding:和卷积类似,可以取'VALID' 或者'SAME'

2.池化层

在卷积神经网络中,卷积层之间往往会加上一个池化层。池化层可以非常有效地缩小参数矩阵的尺寸,从而减少最后全连层中的参数数量。使用池化层即可以加快计算速度也有防止过拟合的作用。在图像识别领域,有时图像太大,我们需要减少训练参数的数量,它被要求在随后的卷积层之间周期性地引进池化层。池化的唯一目的是减少图像的空间大小。池化在每一个纵深维度上独自完成,因此图像的纵深保持不变。

平均池化和最大池化的区别

当数据的位置相关性不大,那么可以用一个mean_pooling来作为一个特征提取的手段。而如果通过一个卷积核处理后的数据里面的某个信息是很有效的,譬如说其中可能出现很大的值,而这个值对结果影响很大,那么可以用max_pooling。