机器学习基石第一讲:The Learning Problem

course introduction

本课程从基础的角度出发,回答以下几个问题:

What is Machine Learning

学习与机器学习:

对技巧的解释:增进某一种的表现。

进一步对机器学习的定义:

机器学习:另一种解决思路。

机器学习的三个关键:

Components of Machine Learning

有了机器学习的流程后,机器学习还有那些细节内容?

机器学习基本构成:

机器学习算法就是在假设集中选出一个它认为最好的符合所有资料的g.

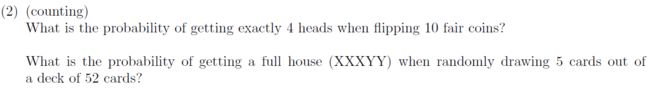

Homework #0

1.Probability and Statistics

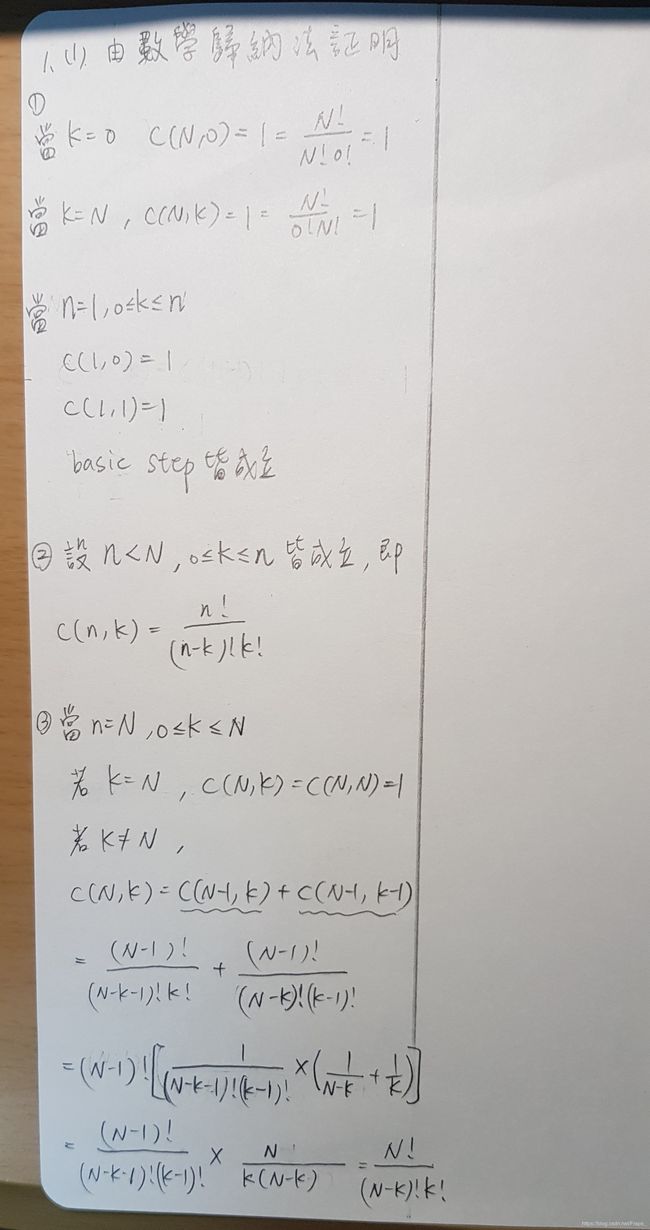

(这里给出别人的一个证明)

解答:

C ( 10 , 4 ) 2 10 ; C ( 13 , 1 ) C ( 4 , 3 ) C ( 12 , 1 ) C ( 4 , 2 ) C ( 52 , 5 ) ; \frac{C(10,4)}{2^{10}};\frac{C(13,1)C(4,3)C(12,1)C(4,2)}{C(52,5)}; 210C(10,4);C(52,5)C(13,1)C(4,3)C(12,1)C(4,2);

解答:

1 4 \frac{1}{4} 41

还需要学习这方面的知识。这里的1/8要算进去?在已知是1或-1的情况下,在选择一组后,是否集确定了?

由 ∣ X ∣ = 1 , 说 明 X 只 能 是 − 1 或 1 。 设 A 为 选 中 了 0 , 1 , . . . 7 中 的 1 , 设 B 为 选 中 了 0 , − 1 , − 2 , − 3 中 的 − 1 由|X|=1,说明X只能是-1或1。设A为选中了{0,1,...7}中的1,设B为选中了{0,-1,-2,-3}中的-1 由∣X∣=1,说明X只能是−1或1。设A为选中了0,1,...7中的1,设B为选中了0,−1,−2,−3中的−1。

设 C 为 ∣ X ∣ = 1 , 设C为|X|=1, 设C为∣X∣=1,.以下:

P ( A ) = 1 2 ⋅ 1 8 = 1 16 , P ( B ) = 1 2 ⋅ 1 4 = 1 8 P(A)=\frac{1}{2}·\frac{1}{8}=\frac{1}{16},P(B)=\frac{1}{2}·\frac{1}{4}=\frac{1}{8} P(A)=21⋅81=161,P(B)=21⋅41=81

p ( C ∣ A ) = 1 , P ( C ∣ B ) = 1 p(C|A)=1,P(C|B)=1 p(C∣A)=1,P(C∣B)=1

由 贝 叶 斯 公 式 : P ( B ∣ C ) = P ( B C ) P ( C ) = P ( B ) P ( C ∣ B ) P ( C ) 由贝叶斯公式:P(B|C)=\frac{P(BC)}{P(C)}=\frac{P(B)P(C|B)}{P(C)} 由贝叶斯公式:P(B∣C)=P(C)P(BC)=P(C)P(B)P(C∣B)

(这里没有证明完成,后面来完善)

0.3 ; 0 ; 0.7 ; 0.4 0.3;0;0.7;0.4 0.3;0;0.7;0.4

2.Linear Algebra

解答:

( 1 2 1 1 0 3 1 1 2 ) r 2 − r 1 r 3 − r 1 → ( 1 2 1 0 − 2 2 0 − 1 1 ) r 3 − r 2 → ( 1 2 1 0 − 2 2 0 0 0 ) \begin{pmatrix} 1 & 2 & 1\\ 1 & 0 & 3\\ 1 & 1 & 2 \end{pmatrix} \mathop{\mathbb{\begin{array}{clr}r_2-r_1\\r_3-r_1\\\end{array}}}\limits_{\to} \begin{pmatrix} 1 & 2 & 1\\ 0 & -2 & 2\\ 0 & -1 & 1 \end{pmatrix} \mathop{\mathbb{\begin{array}{clr}r_3-r_2\\\end{array}}}\limits_{\to} \begin{pmatrix} 1 & 2 & 1\\ 0 & -2 & 2\\ 0 & 0 & 0 \end{pmatrix} ⎝⎛111201132⎠⎞→r2−r1r3−r1⎝⎛1002−2−1121⎠⎞→r3−r2⎝⎛1002−20120⎠⎞

R = 2 R=2 R=2

解答:

A = ( 0 2 4 2 4 2 3 3 1 ) , ∣ A ∣ ≠ 0 , 设 ∣ A ∣ 各 个 元 素 的 代 数 余 子 式 为 A i j . A=\begin{pmatrix} 0 & 2 & 4\\ 2 & 4 & 2\\ 3 & 3 & 1 \end{pmatrix},|A| {\neq} 0,设|A|各个元素的代数余子式为A_{ij}. A=⎝⎛023243421⎠⎞,∣A∤=0,设∣A∣各个元素的代数余子式为Aij.

A 11 = − 2 , A 12 = 4 , A 13 = − 6 A_{11}=-2,A_{12}=4,A_{13}=-6 A11=−2,A12=4,A13=−6

A 21 = 10 , A 22 = − 12 , A 23 = 6 A_{21}=10,A_{22}=-12,A_{23}=6 A21=10,A22=−12,A23=6

A 31 = − 12 , A 32 = 8 , A 33 = − 4 A_{31}=-12,A_{32}=8,A_{33}=-4 A31=−12,A32=8,A33=−4

A ∗ = ( − 2 4 − 6 10 12 6 − 12 8 − 4 ) , 由 A − 1 = 1 ∣ A ∣ ⋅ A ∗ A^*=\begin{pmatrix} -2 & 4 & -6\\ 10 & 12 & 6\\ -12 & 8 & -4\\ \end{pmatrix},由A^{-1}=\frac{1}{|A|}·A^* A∗=⎝⎛−210−124128−66−4⎠⎞,由A−1=∣A∣1⋅A∗

A − 1 = ( 1 8 − 1 4 3 8 − 5 8 3 4 − 3 8 3 4 − 1 2 1 4 ) A^{-1}= \begin{pmatrix} \frac{1}{8} & -\frac{1}{4} & \frac{3}{8}\\ -\frac{5}{8} & \frac{3}{4} & -\frac{3}{8}\\ \frac{3}{4} & -\frac{1}{2} & \frac{1}{4}\\ \end{pmatrix} A−1=⎝⎛81−8543−4143−2183−8341⎠⎞

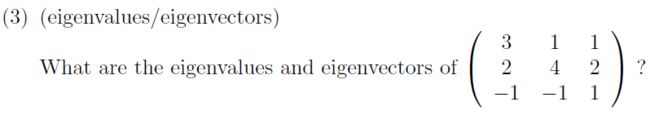

解答:

A = ( 3 1 1 2 4 2 − 1 − 1 1 ) , 设 方 程 : ( λ E − A ) x = 0 , A=\begin{pmatrix} 3 & 1 &1 \\ 2 & 4 & 2 \\ -1 & -1 & 1\\ \end{pmatrix},设方程:(\lambda E-A)x=0, A=⎝⎛32−114−1121⎠⎞,设方程:(λE−A)x=0,

( λ E − A ) = 0 , (\lambda E-A)=0, (λE−A)=0,

( λ − 3 − 1 − 1 − 2 λ − 4 − 2 1 1 λ − 1 ) = 0 , \begin{pmatrix} \lambda -3 & -1 & -1 \\ -2 & \lambda -4 & -2 \\ 1 & 1 & \lambda -1 \\ \end{pmatrix}=0, ⎝⎛λ−3−21−1λ−41−1−2λ−1⎠⎞=0,

( λ − 4 ) ( λ − 3 ) ( λ − 1 ) + λ − 4 = 0 , (\lambda -4)(\lambda -3)(\lambda -1)+\lambda -4 =0, (λ−4)(λ−3)(λ−1)+λ−4=0,

( λ − 4 ) ( λ − 2 ) 2 = 0 , (\lambda -4)(\lambda -2)^2=0, (λ−4)(λ−2)2=0,

当 λ 1 = 4 , { x 1 − x 2 − x 3 = 0 − 2 x 1 − 2 x 3 = 0 x 1 + x 2 + 3 x 3 = 0 , { x 1 = − x 3 x 2 = − 2 x 3 , p 1 = ( 1 2 − 1 ) , 所 有 关 于 λ 1 = 4 , 的 特 征 向 量 为 k 1 ⋅ p 1 ( k 1 ≠ 0 ) 当\lambda _1=4,\begin{cases} x_1-x_2-x_3=0\\ -2x_1-2x_3=0\\ x_1+x_2+3x_3=0\\ \end{cases}, \begin{cases} x_1=-x_3\\ x_2=-2x_3\\ \end{cases}, p_1=\begin{pmatrix} 1\\ 2\\ -1\\ \end{pmatrix}, 所有关于\lambda _1=4,的特征向量为k_1·p_1(k_1 \neq0) 当λ1=4,⎩⎪⎨⎪⎧x1−x2−x3=0−2x1−2x3=0x1+x2+3x3=0,{x1=−x3x2=−2x3,p1=⎝⎛12−1⎠⎞,所有关于λ1=4,的特征向量为k1⋅p1(k1̸=0)

当 λ 1 = 2 , { − x 1 − x 2 − x 3 = 0 − 2 x 1 − 2 x 2 − 2 x 3 = 0 x 1 + x 2 + x 3 = 0 , { x 1 = x 2 = x 3 , p 2 = ( 1 1 1 ) , 所 有 关 于 λ 1 = 2 , 的 特 征 向 量 为 k 2 ⋅ p 2 ( k 2 ≠ 0 ) 当\lambda _1=2,\begin{cases} -x_1-x_2-x_3=0\\ -2x_1-2x_2-2x_3=0\\ x_1+x_2+x_3=0\\ \end{cases}, \begin{cases} x_1=x_2=x_3\\ \end{cases}, p_2=\begin{pmatrix} 1\\ 1\\ 1\\ \end{pmatrix}, 所有关于\lambda _1=2,的特征向量为k_2·p_2(k_2 \neq0) 当λ1=2,⎩⎪⎨⎪⎧−x1−x2−x3=0−2x1−2x2−2x3=0x1+x2+x3=0,{x1=x2=x3,p2=⎝⎛111⎠⎞,所有关于λ1=2,的特征向量为k2⋅p2(k2̸=0)

解答:

M = U Σ V T , M=U \Sigma V^T, M=UΣVT,

所 以 U , V 是 正 交 矩 阵 , U T U = E , V T V = E , 所以U,V是正交矩阵,U^TU=E,V^TV=E, 所以U,V是正交矩阵,UTU=E,VTV=E,

M † = V Σ † U T , M^{\dagger}=V\Sigma ^{\dagger}U^T, M†=VΣ†UT,

M M † M = U Σ V T V Σ † U T U Σ V T , MM^{\dagger}M=U \Sigma V^TV\Sigma ^{\dagger}U^TU \Sigma V^T, MM†M=UΣVTVΣ†UTUΣVT,

{ U Σ V T V Σ † U T U Σ V T Σ † [ i ] [ j ] = 1 Σ † [ i ] [ j ] U T U = E V T V = E \begin{cases} U \Sigma V^TV\Sigma ^{\dagger}U^TU \Sigma V^T \\ \Sigma ^{\dagger}[i][j]=\frac{1}{\Sigma ^{\dagger}[i][j]} \\ U^TU=E \\ V^TV=E \\ \end{cases} ⎩⎪⎪⎪⎨⎪⎪⎪⎧UΣVTVΣ†UTUΣVTΣ†[i][j]=Σ†[i][j]1UTU=EVTV=E

M M † M = M MM^{\dagger}M=M MM†M=M

M − 1 = ( U Σ V T ) − 1 = V Σ − 1 U − 1 = V Σ † U T = M † M^{-1}=(U \Sigma V^T)^{-1}=V\Sigma ^{-1} U^{-1}=V\Sigma ^{\dagger}U^T=M^{\dagger} M−1=(UΣVT)−1=VΣ−1U−1=VΣ†UT=M†

1 、 u T x = ∣ ∣ x ∣ ∣ , u = x ∣ ∣ x ∣ ∣ 1、u^Tx=||x||,u=\frac{x}{||x||} 1、uTx=∣∣x∣∣,u=∣∣x∣∣x

2 、 − ∣ ∣ x ∣ ∣ , u = − x ∣ ∣ x ∣ ∣ 2、-||x||,u=-\frac{x}{||x||} 2、−∣∣x∣∣,u=−∣∣x∣∣x

3 、 0 , u ⊥ x 3、0,u\perp x 3、0,u⊥x

3.Calculus

解答:

d f ( x ) d x = − 2 1 1 + e − 2 x e − 2 x , φ g ( x , y ) φ y = 2 e 2 y + 6 x y e 3 x y 3 \frac{df(x)}{dx}=-2\frac{1}{1+e^{-2x}}e^{-2x},\frac{\varphi g(x,y)}{\varphi y}=2e^{2y}+6xye^{3xy^3} dxdf(x)=−21+e−2x1e−2x,φyφg(x,y)=2e2y+6xye3xy3

解答:

φ f ( x , y ) φ v = φ x φ v y + x φ y φ v = − s i n ( u + v ) y − x c o s ( u − v ) = − s i n ( u + v ) s i n ( u − v ) − c o s ( u + v ) c o s ( u − v ) \frac{\varphi f(x,y)}{\varphi v}=\frac{\varphi x}{\varphi v}y+x\frac{\varphi y}{\varphi v}= -sin(u+v)y-xcos(u-v)=-sin(u+v)sin(u-v)-cos(u+v)cos(u-v) φvφf(x,y)=φvφxy+xφvφy=−sin(u+v)y−xcos(u−v)=−sin(u+v)sin(u−v)−cos(u+v)cos(u−v)

![]()